OneLLM 是第一個在單個模型中集成八種不同模態(tài)的MLLM。通過統一的框架和漸進式多模態(tài)對齊pip....

強化學習(Reinforcement Learning, RL)的核心概念可簡單概括為:一個機器人(....

大型語言模型(LLM)是基于人工智能的先進模型,經過訓練,它可以密切反映人類自然交流的方式處理和生成....

最近復旦大學自然語言處理組鄭驍慶和黃萱菁團隊提出了基于表征工程(Representation Eng....

許多研究證明,學術論文表達的nativeness會影響其被接受發(fā)表的可能性[1, 2]。先前的研究也....

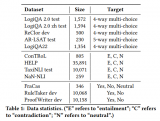

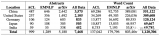

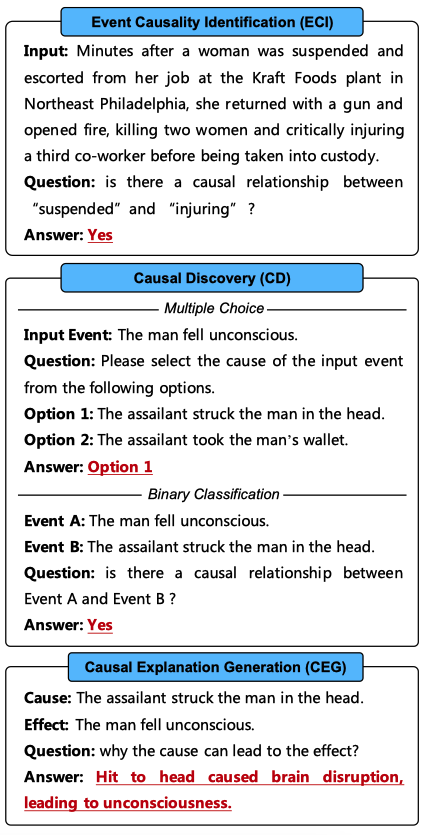

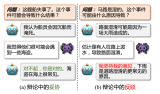

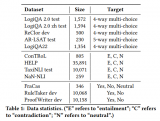

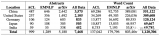

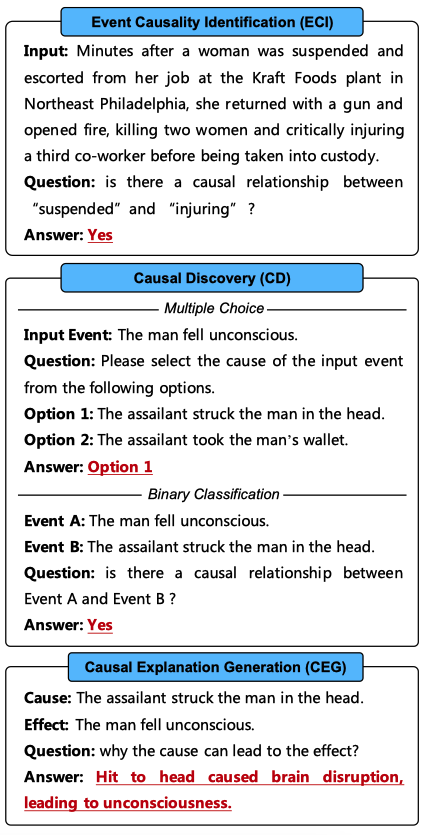

因果推理能力對于許多自然語言處理(NLP)應用至關重要。最近的因果推理系統主要基于經過微調的預訓練語....

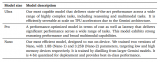

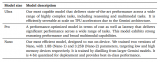

大模型時代,根據大模型縮放定律,大家通常都在追求模型的參數規(guī)模更大、訓練的數據更多,從而使得大模型涌....

前段時間Google推出Gemini多模態(tài)大模型,展示了不凡的對話能力和多模態(tài)能力,其表現究竟如何呢....

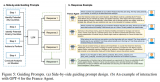

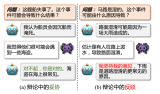

盡管基本的CoT提示策略在復雜推理任務中展示出了強大的能力,但它仍然面臨著一些問題,比如推理過程存在....

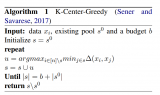

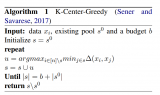

ChatGPT、Midjourney等生成式人工智能(GenAI)在文本生成、文本到圖像生成等任務中....

比如我們會經常遇到下面幾種情況:

1.數據要不要都去標注,標的比較慢咋辦?

2.我已經有一....

這個開源模型盡管尺寸不大,小到足以在一臺內存100GB以上的電腦上運行,然而在某些基準測試中卻能和G....

盡管 word2vec 是我被引用最多的論文,但我從未認為它是我最有影響力的項目。實際上,word2....

首先我們定義什么是大模型的badcase,大模型badcase是指在應用場景中,出現不符合預期的答復....

大模型或者句向量在訓練時,使用的語料都是較為通用的語料。這導致了這些模型,對于垂直領域的知識識別是有....

采用ChatGPT的企業(yè)可能會擔心API調用的巨大成本、服務中斷、數據所有權和隱私問題,以及其他不可....

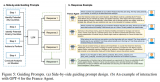

Agent 不僅將改變人們與計算機的互動方式,還將顛覆軟件行業(yè),引發(fā)自從我們從鍵入命令到點擊圖標以來....

本實驗旨在驗證LLM在模擬復雜歷史事件方面的有效性。實驗選用了OpenAI開發(fā)的GPT-4作為后端模....

經典的文字模型我們已經很熟悉了:訓練時,模型不停的預測下一個 token 并與真實語料比較,直到模型....

Zero-shot Setting:在 O-Cue 中,由于單步指令較復雜(不要要進行推理還要進行回....

具體來說,我們以多項選擇的常識推理作為示例任務,因為常識推理任務是一類可能性 (plausible)....

對于Decoder-only的模型,計算量(Flops), 模型參數量, 數據大小(token數),....

隨著ChatGPT的快速發(fā)展,基于Transformer的大型語言模型(LLM)為人工通用智能(AG....

語言不僅是人類交流的工具,更是思維和智能的基礎。

“如果一篇論文提出了某種不同的訓練方法,OpenAI內部會嗤之以鼻,認為都是我們玩剩下的。但是當新的....

在歷史的長河中,自動化是人類技術發(fā)展的主要動力,幫助人類從復雜、危險、繁瑣的勞動環(huán)境中解放出來。自早....

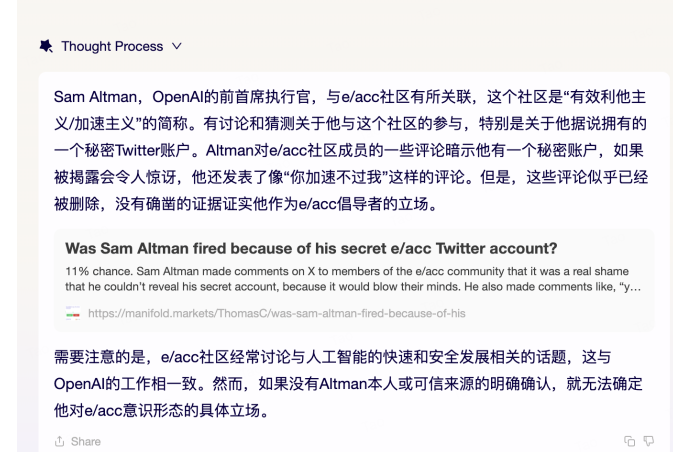

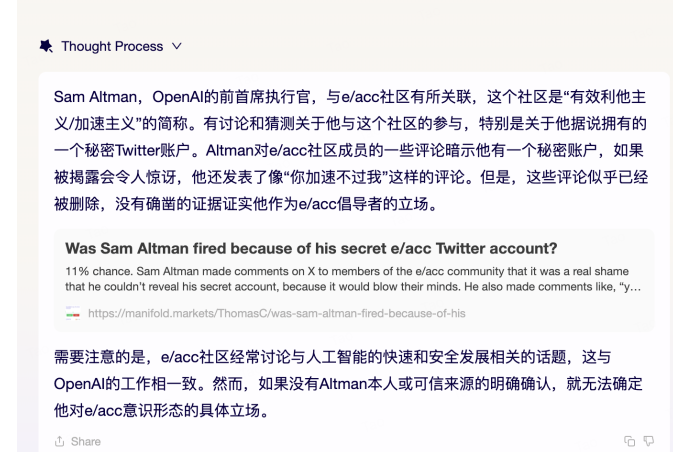

有效加速主義 和 超級“愛”對齊 的理念沖突,以及一個變量:GPT-5 是數字生命,還是工具?

本文假設不同的ICL為LLM提供了關于任務的不同知識,導致對相同數據的不同理解和預測。因此,一個直接....

目前的 VL 預訓練方法通常僅適用于視覺和語言模態(tài),而現實世界中的應用場景往往包含更多的模態(tài)信息,如....

最新研究揭示,盡管大語言模型LLMs在語言理解上表現出色,但在邏輯推理方面仍有待提高。為此,研究者們....