一種針對LLMs簡單有效的思維鏈解毒方法

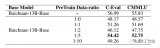

考慮到強(qiáng)化學(xué)習(xí)[10]訓(xùn)練大語言模型的困難性,我們從語言建模的角度對大語言模型進(jìn)行解毒。已有工作將解....

檢索增強(qiáng)的語言模型方法的詳細(xì)剖析

? 本篇內(nèi)容是對于ACL‘23會議上陳丹琦團(tuán)隊(duì)帶來的Tutorial所進(jìn)行的學(xué)習(xí)記錄,以此從問題設(shè)置....

基于Transformer多模態(tài)先導(dǎo)性工作

多模態(tài)(Multimodality)是指在信息處理、傳遞和表達(dá)中涉及多種不同的感知模態(tài)或信息來源。這....

大型語言模型在關(guān)鍵任務(wù)和實(shí)際應(yīng)用中的挑戰(zhàn)

大型語言模型的出現(xiàn)極大地推動了自然語言處理領(lǐng)域的進(jìn)步,但同時(shí)也存在一些局限性,比如模型可能會產(chǎn)生看似....

GPT時(shí)代醫(yī)學(xué)AI新賽道:16萬張圖片、70萬問答對的臨床問答數(shù)據(jù)集MIMIC-Diff-VQA發(fā)布

該研究同時(shí)提出了一個(gè)全新任務(wù),圖像對比 VQA (difference VQA):給定兩張圖片,回答....

關(guān)于領(lǐng)域大模型-訓(xùn)練Trick&落地的一點(diǎn)思考

現(xiàn)有大模型在預(yù)訓(xùn)練過程中都會加入書籍、論文等數(shù)據(jù),那么在領(lǐng)域預(yù)訓(xùn)練時(shí)這兩種數(shù)據(jù)其實(shí)也是必不可少的,主....

ToolLLM:促進(jìn)大型語言模型掌握16000+真實(shí)世界的APIs

盡管開源大語言模型 (LLM) 及其變體(例如 LLaMA 和 Vicuna)取得了進(jìn)步,但它們在執(zhí)....

爆火Llama 2一周請求下載超15萬,有人開源了Rust實(shí)現(xiàn)版本

隨著 Llama 2 的逐漸走紅,大家對它的二次開發(fā)開始流行起來。前幾天,OpenAI 科學(xué)家 Ka....

Focus-DETR:30%Token就能實(shí)現(xiàn)SOTA性能,效率倍增

目前 DETR 類模型已經(jīng)成為了目標(biāo)檢測的一個(gè)主流范式。但 DETR 算法模型復(fù)雜度高,推理速度低,....

大模型訓(xùn)練中RM分?jǐn)?shù)越來越高,那訓(xùn)出來LLM的效果一定好嗎?

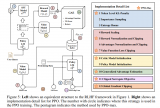

如果你動手跑幾次ppo的過程就發(fā)現(xiàn)了,大模型的強(qiáng)化學(xué)習(xí)非常難以訓(xùn)練,難以訓(xùn)練不僅僅指的是費(fèi)卡,還是指....

張俊林:大語言模型帶來的交互方式變革

在大模型出來之前,人和數(shù)據(jù)怎么發(fā)生關(guān)系?人不能直接與數(shù)據(jù)發(fā)生關(guān)系,需要通過一個(gè)中介,這個(gè)中介就是應(yīng)用....

單樣本微調(diào)給ChatGLM2注入知識

LoRA微調(diào)是一種高效的融入學(xué)習(xí)算法。類似人類把新知識融入現(xiàn)有知識體系的學(xué)習(xí)過程。學(xué)習(xí)時(shí)無需新知識特....

RoPE可能是LLM時(shí)代的Resnet

通過線性插值RoPE擴(kuò)張LLAMA context長度最早其實(shí)是在llamacpp項(xiàng)目中被人發(fā)現(xiàn),有....

最新綜述!當(dāng)大型語言模型(LLM)遇上知識圖譜:兩大技術(shù)優(yōu)勢互補(bǔ)

LLM 是黑箱模型,缺乏可解釋性,因此備受批評。LLM 通過參數(shù)隱含地表示知識。因此,我們難以解釋和....

大模型微調(diào)樣本構(gòu)造的trick

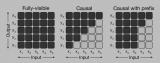

現(xiàn)在chatglm2的代碼針對這兩個(gè)問題已經(jīng)進(jìn)行了改善,可以認(rèn)為他就是典型的decoder-only....

X-RiSAWOZ: 高質(zhì)量端到端多語言任務(wù)型對話數(shù)據(jù)集

對齊:我們提出了一種混合對齊策略,以確保實(shí)體在話語和信念狀態(tài)中都能被替換為所需的翻譯。具體而言,我們....

武大+上交提出BatGPT:創(chuàng)新性采用雙向自回歸架構(gòu),可預(yù)測前后token

此外,BATGPT還采用了強(qiáng)化學(xué)習(xí)方法,從AI和人類反饋中學(xué)習(xí),以進(jìn)一步提高模型的對齊性能。這些方法....

人大發(fā)表迄今為止最大最全的大模型綜述

大語言模型目前已經(jīng)成為學(xué)界研究的熱點(diǎn)。我們統(tǒng)計(jì)了arXiv論文庫中自2018年6月以來包含關(guān)鍵詞"語....

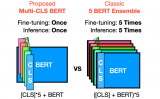

Multi-CLS BERT:傳統(tǒng)集成的有效替代方案

在 GLUE 和 SuperGLUE 數(shù)據(jù)集上進(jìn)行了實(shí)驗(yàn),證明了 Multi-CLS BERT 在提....

我們能否擴(kuò)展現(xiàn)有的預(yù)訓(xùn)練 LLM 的上下文窗口

? ? 在大家不斷升級迭代自家大模型的時(shí)候,LLM(大語言模型)對上下文窗口的處理能力,也成為一個(gè)重....

單張消費(fèi)級顯卡微調(diào)多模態(tài)大模型

把大模型的訓(xùn)練門檻打下來!我們在單張消費(fèi)級顯卡上實(shí)現(xiàn)了多模態(tài)大模型(LaVIN-7B, LaVIN-....

基于一個(gè)完整的 LLM 訓(xùn)練流程

? ? 在這篇文章中,我們將盡可能詳細(xì)地梳理一個(gè)完整的 LLM 訓(xùn)練流程。包括模型預(yù)訓(xùn)練(Pretr....

大模型如何快速構(gòu)建指令遵循數(shù)據(jù)集

一、概述 1 Motivation 構(gòu)造instruction data非常耗時(shí)耗力,常受限于質(zhì)量,....

GLoRA:一種廣義參數(shù)高效的微調(diào)方法

近年來,大規(guī)模深度神經(jīng)網(wǎng)絡(luò)的顯著成就徹底改變了人工智能領(lǐng)域,在各種任務(wù)和領(lǐng)域展示了前所未有的性能。這....