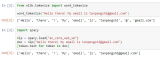

一定要「分詞」嗎?Andrej Karpathy:是時候拋棄這個歷史包袱了

首先,Karpathy 認(rèn)為,Tokenization 引入了復(fù)雜性:通過使用 tokenizati....

基于一步步蒸餾(Distilling step-by-step)機制

為優(yōu)化LLM為“小模型/少數(shù)據(jù)/好效果”,提供了一種新思路:”一步步蒸餾”(Distilling s....

上海AI lab提出VideoChat:可以與視頻對話啦

區(qū)別于現(xiàn)有多模態(tài)大模型針對視頻輸入的處理方法,即首先文本化視頻內(nèi)容再接入大模型利用大模型自然語言理解....

涌現(xiàn)能力的定義、常見的激發(fā)手段和具體的分類和任務(wù)

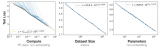

縮放定律的一個重要作用就是預(yù)測模型的性能,但是隨著規(guī)模的擴大,模型的能力在不同的任務(wù)上并不總表現(xiàn)出相....

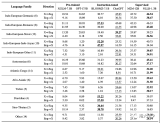

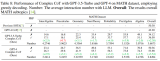

華為諾亞提出新型Prompting (PHP),GPT-4拿下最難數(shù)學(xué)推理數(shù)據(jù)集新SOTA

結(jié)果表明,GP-T-4+PHP 在多個數(shù)據(jù)集上取得了 SOTA 結(jié)果,包括 SVAMP (91.9%....

什么樣的模型更適合zero-shot?

如果經(jīng)過多任務(wù)微調(diào),編碼器-解碼器掩碼模型最好【這參數(shù)量都翻倍了,很難說不是參數(shù)量加倍導(dǎo)致的】。換個....

LlamaIndex:面向QA系統(tǒng)的全新文檔摘要索引

添加關(guān)鍵字過濾器是增強檢索結(jié)果的一種方法。但這也帶來了一系列挑戰(zhàn)。我們需要手動或通過 NLP 關(guān)鍵字....

多模態(tài)GPT:國內(nèi)發(fā)布一款可以在線使用的多模態(tài)聊天機器人!

基于開源多模態(tài)模型 OpenFlamingo,作者使用公開數(shù)據(jù)集創(chuàng)建了各種視覺指令數(shù)據(jù),包括視覺問答....

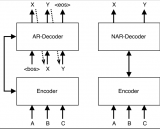

一種非自回歸的預(yù)訓(xùn)練方法

雖然GPT模型在自然語言處理領(lǐng)域中表現(xiàn)出色,但是它們?nèi)匀淮嬖谝恍﹩栴}。例如,GPT模型的自回歸設(shè)計導(dǎo)....

DropMessage:統(tǒng)一的圖神經(jīng)網(wǎng)絡(luò)隨機Dropping方法

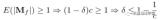

從信息論的角度來看,具有保持信息多樣性能力的隨機dropping方法比沒有這種能力的能保存更多的信息....

為什么ChatGPT模型大了就有上下文聯(lián)系能力?

神經(jīng)網(wǎng)絡(luò)在訓(xùn)練的時候,采用的隨機梯度下降算法,一定程度上等效于物種的基因突變,本質(zhì)是有一定方向的隨機....

ChatGPT的真相:強泛化的秘密以及眾多關(guān)鍵問題

通用計算機的誕生對社會生產(chǎn)力的提升意義重大。學(xué)習(xí)寫代碼比學(xué)習(xí)開發(fā)邏輯電路要簡單太多了。普通人經(jīng)過一段....

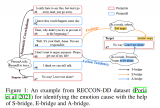

Instruct-UIE:信息抽取統(tǒng)一大模型

Instruct-UIE 統(tǒng)一了信息抽取任務(wù)訓(xùn)練方法,可以融合不同類型任務(wù)以及不同的標(biāo)注規(guī)范,統(tǒng)一進....

In-context learning介紹

隨著大規(guī)模預(yù)訓(xùn)練語言模型(LLM)能力的不斷提升,in-context learning(ICL)逐....

各種大語言模型是徹底被解封了

基礎(chǔ) LLM 基本信息表,GPT-style 表示 decoder-only 的自回歸語言模型,T5....

多語言AI的現(xiàn)狀

同樣的,使用這些低資源語言的研究人員在ML和NLP社區(qū)中的代表性同樣不足。例如,雖然我們可以觀察到隸....

后ChatGPT時代NLP的下一個方向:增強式大規(guī)模語言模型

Visual ChatGPT 是一種智能交互系統(tǒng),它將不同的視覺基礎(chǔ)模型與 ChatGPT 相結(jié)合,....

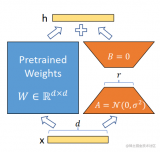

使用LoRA和Hugging Face高效訓(xùn)練大語言模型

在本文中,我們將展示如何使用 大語言模型低秩適配 (Low-Rank Adaptation of L....

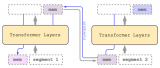

在視覺語言表示學(xué)習(xí)中建立編碼器間的橋梁

提出了一個簡單有效的視覺語言模型架構(gòu),BridgeTower,通過在頂層單模態(tài)層和每個跨模態(tài)層之間建....