作者:cola

雖然大多數(shù)現(xiàn)有的LLM提示工程只專注于如何在單個(gè)提示輸入中選擇一組更好的數(shù)據(jù)樣本(In-Context Learning或ICL),但為什么我們不能設(shè)計(jì)和利用多個(gè)提示輸入來進(jìn)一步提高LLM性能?本文提出上下文采樣(ICS),一種低資源LLM提示工程技術(shù),通過優(yōu)化多個(gè)ICL提示輸入的結(jié)構(gòu)來產(chǎn)生最有置信度的預(yù)測(cè)結(jié)果。

介紹

指令微調(diào)的LLMs,如Flan-T5、LLaMA和Mistral展示了通用的自然語(yǔ)言理解(NLI)和生成(NLG)能力。然而,解決實(shí)際任務(wù)需要廣泛的領(lǐng)域?qū)I(yè)知識(shí),這對(duì)LLM來說仍然具有挑戰(zhàn)性。研究人員提出了各種激勵(lì)策略來探索LLM的能力。一個(gè)突出的方法是少樣本上下文學(xué)習(xí)(ICL),通過向提示輸入插入一些數(shù)據(jù)示例,特別是對(duì)未見任務(wù)的能力提高了LLM的任務(wù)解釋和解決能力。最近的幾項(xiàng)工作研究了不同ICL設(shè)置的影響,包括數(shù)量、順序和組合。然而,最好的ICL策略還沒有共識(shí)。

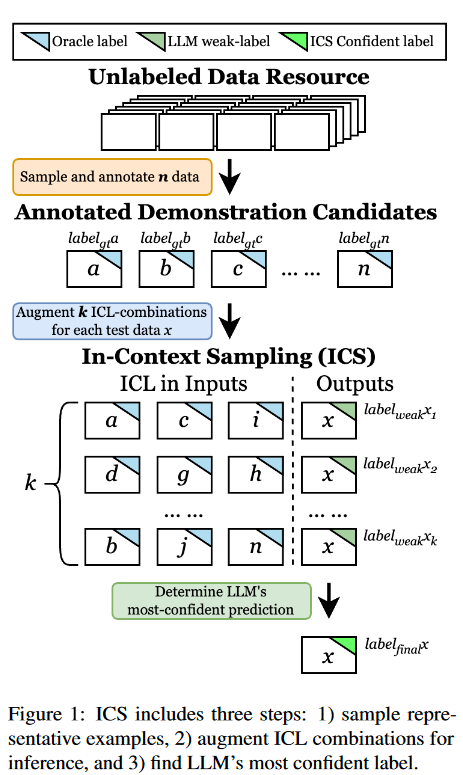

本文假設(shè)不同的ICL為L(zhǎng)LM提供了關(guān)于任務(wù)的不同知識(shí),導(dǎo)致對(duì)相同數(shù)據(jù)的不同理解和預(yù)測(cè)。因此,一個(gè)直接的研究問題出現(xiàn)了:llm能否用多個(gè)ICL提示輸入來增強(qiáng),以提供最可信的預(yù)測(cè)?為解決這個(gè)問題,本文提出上下文采樣(ICS)。ICS遵循三步流程:采樣、增強(qiáng)和驗(yàn)證,如圖1所示。

ICS策略

給定一個(gè)自然語(yǔ)言任務(wù)指令和一個(gè)數(shù)據(jù),指令微調(diào)的SOTA可以接受輸入,生成一個(gè)輸出,其中表示上下文中的注釋示例,是預(yù)測(cè)結(jié)果。

示例可以為L(zhǎng)LM提供:

直接理解任務(wù)指令(I)和預(yù)期輸出

間接指導(dǎo)如何解決任務(wù)。

本文假設(shè)不同的ICL示例集為L(zhǎng)LM提供了關(guān)于該任務(wù)的不同知識(shí)。因此,LLM可以根據(jù)不同的ICL提示輸入改變對(duì)相同數(shù)據(jù)的預(yù)測(cè),但預(yù)測(cè)的變化最終將收斂到一個(gè)最可信的預(yù)測(cè)。

ICS的框架如圖1所示。

從未標(biāo)記的數(shù)據(jù)池中采樣示例候選集并獲取注釋,

用不同的ICL組合增加標(biāo)簽,

驗(yàn)證置信度最高的標(biāo)簽作為增強(qiáng)標(biāo)簽的最終預(yù)測(cè)。

ICS方法是模型無關(guān)的且“即插即用”,可以以最小的工作量切換到不同的采樣、增強(qiáng)和驗(yàn)證算法。

示例候選集采樣

從許多未標(biāo)記的數(shù)據(jù)中采樣少量數(shù)據(jù)作為ICL示例,通常分為兩種類型:基于數(shù)據(jù)多樣性和基于模型概率。我們的策略堅(jiān)持基于集群的策略(即核心集),旨在識(shí)別代表所有未標(biāo)記數(shù)據(jù)的示例,同時(shí)最大化這些選定實(shí)例的多樣性。該策略用句子轉(zhuǎn)換器編碼計(jì)算每個(gè)數(shù)據(jù)的余弦相似度,其中embed表示句Transformer Embedding。然后,根據(jù)相似度得分對(duì)候選樣本進(jìn)行排序,并檢索個(gè)相同間隔的樣本集,以保證樣本集的多樣性。本文試圖確定樣本量和增強(qiáng)的ICL組合數(shù)量,在下面三個(gè)角度上取得平衡:

包含足夠的多樣性充分表示基礎(chǔ)數(shù)據(jù),

置信預(yù)測(cè)具有魯棒性,

最小化注釋成本。

ICL組合增強(qiáng)

如圖1所示,ICS通過為要預(yù)測(cè)的相同數(shù)據(jù)構(gòu)建不同的ICL組合來增強(qiáng)標(biāo)簽,然后獲得所有標(biāo)簽中置信度最高的標(biāo)簽。然而,如果要求LLM預(yù)測(cè)候選的每個(gè)組合,計(jì)算量可能會(huì)很大。我們認(rèn)為,ICS不需要每個(gè)ICL組合來找到模型的最可信的標(biāo)簽。類似于人類投票,少數(shù)代表代表更多的人口投票,我們計(jì)劃調(diào)查合理數(shù)量的“代表”,即及時(shí)的輸入。用一個(gè)隨機(jī)和基于數(shù)據(jù)多樣性的算法作為基準(zhǔn),用于示例增強(qiáng),并研究了策略差異的影響。兩種方法都是從候選列表中迭代采樣次,其中基于多樣性的增強(qiáng)策略使用上述策略。然后對(duì)相同的測(cè)試數(shù)據(jù)查詢LLM次,得到個(gè)弱標(biāo)簽,記為。

置信標(biāo)簽驗(yàn)證

既然我們從上述ICS步驟中獲得了一組標(biāo)簽,就可以應(yīng)用一些驗(yàn)證算法來找到置信度最高的標(biāo)簽,獲得了最可信的預(yù)測(cè)。可以想象ICL有潛力提供模型可信的無監(jiān)督標(biāo)簽,以在資源匱乏的場(chǎng)景中迭代地微調(diào)LLM,這些場(chǎng)景中專家注釋難以訪問且昂貴。

實(shí)驗(yàn)

實(shí)驗(yàn)設(shè)置

采用了兩個(gè)SOTA LLMs FLAN-T5-XL和Mistral,并在三個(gè)難度越來越大的NLI任務(wù)上進(jìn)行實(shí)驗(yàn):eSNLI、Multi-NLI和ANLI。排除了LLaMA-2的原因是初步實(shí)驗(yàn)顯示了LLaMA-2在“中性”類別上有過擬合問題。我們使用vanilla ICL作為基線。利用隨機(jī)抽樣來構(gòu)建基礎(chǔ)ICS策略的ICS提示輸入,并使用多數(shù)代表方法來找到最可信的標(biāo)簽。對(duì)每個(gè)提示輸入使用3個(gè)示例。操作ICS的兩個(gè)控制變量:采樣的代表性數(shù)據(jù)的大小,其中,以及每個(gè)待預(yù)測(cè)數(shù)據(jù)的增強(qiáng)示例組合的數(shù)量,其中,其中是ICL基線。對(duì)于真實(shí)場(chǎng)景,500個(gè)注釋是一個(gè)合理的預(yù)算。在10次試驗(yàn)中取平均值。

對(duì)LLaMA-2進(jìn)行分析

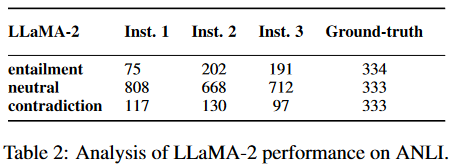

利用三種不同的自然語(yǔ)言指令,在ANLI上對(duì)LLaMA-2進(jìn)行初始推理實(shí)驗(yàn):

確定一個(gè)假設(shè)是否是蘊(yùn)涵的,中性的,矛盾的前提。

將一對(duì)前提和假設(shè)句分為三類:蘊(yùn)涵句、中性句、矛盾句。

通過蘊(yùn)涵、中性、矛盾來預(yù)測(cè)前提和假設(shè)之間的關(guān)系。

結(jié)果如表2所示,我們可以很容易地觀察到,盡管改變了指令,LLaMA-2傾向于過度預(yù)測(cè)其他兩個(gè)類別的"中性",而真實(shí)分布是跨類別的。因此,我們?cè)诠ぷ髦惺÷粤薒LaMA-2。可能有不同的原因?qū)е铝诉@個(gè)問題;例如,LLaMA-2對(duì)NLI任務(wù)或共享同一組目標(biāo)類別("蘊(yùn)含"、"中性"和"矛盾")的類似任務(wù)進(jìn)行了過擬合。

實(shí)驗(yàn)結(jié)果

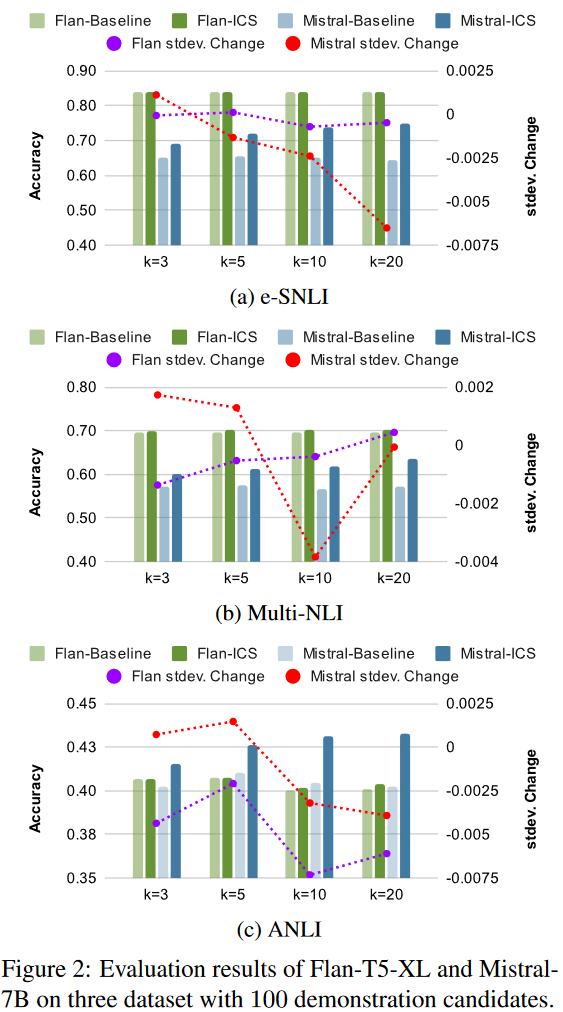

在圖2中,我們展示了時(shí),基線ICL和我們的ICS策略對(duì)每個(gè)模型和數(shù)據(jù)集的預(yù)測(cè)精度。基線和我們的策略之間的標(biāo)準(zhǔn)差變化也用右縱軸的虛線表示。以隨機(jī)采樣策略為基準(zhǔn)的ICS策略,可以不斷提高LLM在每個(gè)組合中的預(yù)測(cè)性能,證明了所提出的ICS管道的有效性。

此外,我們觀察到LLM對(duì)ICS有明顯的敏感性。具體來說,對(duì)于Flan-T5來說,ICS策略提供的精度提升遠(yuǎn)小于Mistral,這可以歸因于Flan-T5可能會(huì)過擬合我們實(shí)驗(yàn)的三個(gè)數(shù)據(jù)集或NLI任務(wù)。另一方面,Mistral證明了ICS策略對(duì)準(zhǔn)確性的顯著提升,在所有數(shù)據(jù)集上的平均提升超過5%。當(dāng)時(shí),兩個(gè)模型的標(biāo)準(zhǔn)偏差減少得最多,當(dāng)超過10時(shí),增加的提供的性能改善開始逐漸減少。對(duì)于示例候選采樣,一旦超過100,精度的提高就不顯著。樣本量超過100可以被認(rèn)為具有足夠的多樣性和代表性。

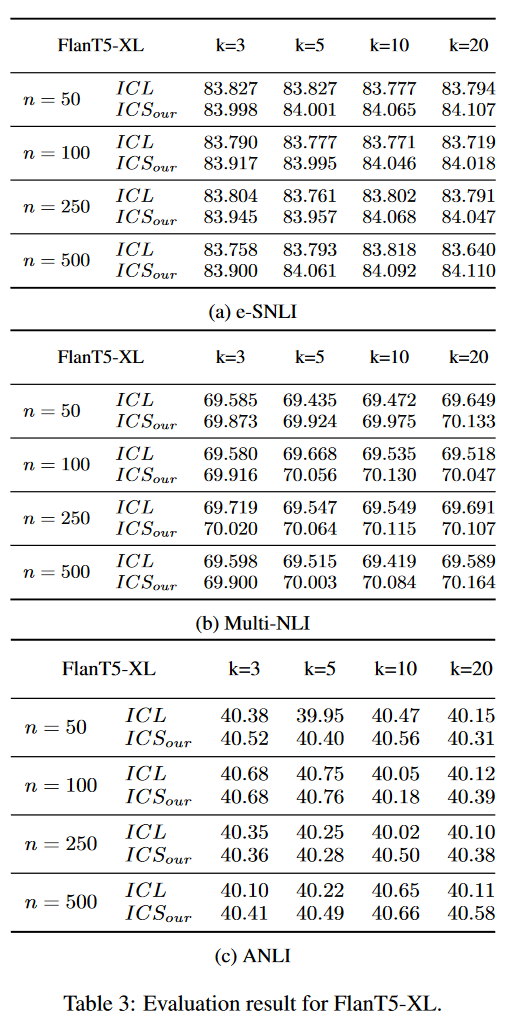

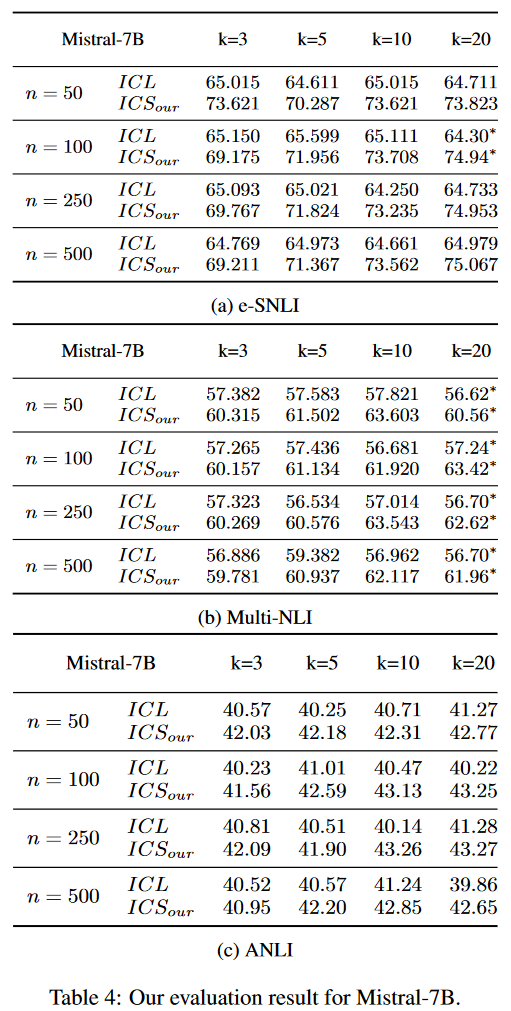

表3和表4報(bào)告了對(duì)FlanT5XL和Mistral-7b的完整評(píng)估結(jié)果。

消融實(shí)驗(yàn)

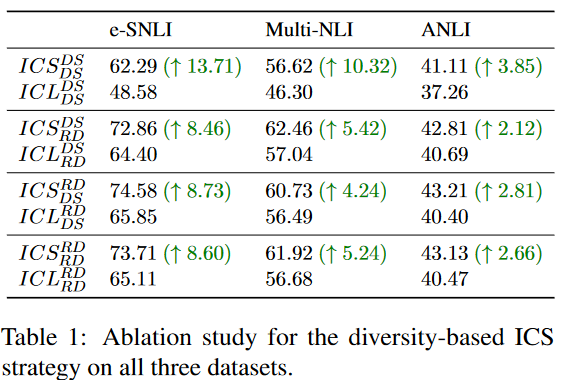

使用Mistral-7B和性能最佳的設(shè)置:和。從3個(gè)NLI數(shù)據(jù)集中隨機(jī)采樣3000和1000數(shù)據(jù)作為訓(xùn)練集和測(cè)試集。我們共進(jìn)行了4種情況下的10次試驗(yàn),記為組合策略,其中RD為隨機(jī)策略,DS為基于數(shù)據(jù)相似性的策略。實(shí)驗(yàn)結(jié)果如表1所示:

基于多樣性的示例候選采樣和組合增強(qiáng)策略可以有效提高ICL的性能。

總結(jié)

本文提出上下文采樣(ICS),一種新的基于ICL的范式,用于探測(cè)LLM的最高置信度預(yù)測(cè)。實(shí)驗(yàn)結(jié)果表明,與傳統(tǒng)的ICL方法相比,ICS方法提高了ICL的準(zhǔn)確性,降低了標(biāo)準(zhǔn)偏差。還研究了不同樣本數(shù)量和ICL組合量的影響,然后進(jìn)一步進(jìn)行消融實(shí)驗(yàn),以說明基于ICS簡(jiǎn)單但有效的數(shù)據(jù)多樣性采樣策略的有用性。

限制

本文的主要重點(diǎn)是提出并證明ICS的有效性。然而,盡管對(duì)不同的和組合進(jìn)行了廣泛的實(shí)驗(yàn),但仍有幾個(gè)潛在變量需要進(jìn)一步分析。例如,盡管我們考慮了3個(gè)不同難度的數(shù)據(jù)集,并且每個(gè)ICL組合是任意的,但3個(gè)數(shù)據(jù)集都是NLI任務(wù)。此外,只進(jìn)行了一項(xiàng)基于數(shù)據(jù)多樣性的候選采樣和組合增強(qiáng)策略的小規(guī)模消融研究。并且我們的實(shí)驗(yàn)原本打算由三個(gè)SOTA LLM組成,但由于LLaMA-2傾向于預(yù)測(cè)“中性”類別,因此不包括它。我們?nèi)杂懈鞣N其他的指令微調(diào)LLM沒有包括在這項(xiàng)工作中,如InstructGPT。

審核編輯:黃飛

-

轉(zhuǎn)換器

+關(guān)注

關(guān)注

27文章

8962瀏覽量

150788 -

Sample

+關(guān)注

關(guān)注

0文章

11瀏覽量

8893 -

自然語(yǔ)言

+關(guān)注

關(guān)注

1文章

291瀏覽量

13608 -

prompt

+關(guān)注

關(guān)注

0文章

15瀏覽量

2747 -

LLM

+關(guān)注

關(guān)注

1文章

320瀏覽量

687

原文標(biāo)題:ICL的時(shí)候,更多sample好還是更多prompt好呢?

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語(yǔ)言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

詳解 LLM 推理模型的現(xiàn)狀

無法在OVMS上運(yùn)行來自Meta的大型語(yǔ)言模型 (LLM),為什么?

傳感器仿真模型的可信度評(píng)估方案

小白學(xué)大模型:構(gòu)建LLM的關(guān)鍵步驟

基于ICL范式的LLM的最高置信度預(yù)測(cè)方案

基于ICL范式的LLM的最高置信度預(yù)測(cè)方案

評(píng)論