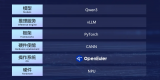

近日,阿里巴巴開源了新一代通義千問模型 Qwen3,Arm 率先成為首批成功適配該模型的計算平臺廠商。與此同時,Arm 面向人工智能 (AI) 框架開發者的開源計算內核 Arm KleidiAI 與阿里巴巴開源的輕量級深度學習框架 MNN 已深度集成。得益于此,Qwen3-0.6B、Qwen3-1.7B 及 Qwen3-4B 三款模型能夠在搭載 Arm 架構 CPU 的移動設備上無縫運行,為用戶提供卓越的端側 AI 推理能力。

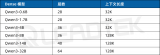

作為阿里巴巴最新開源的混合推理模型,Qwen3 在 AIME、LiveCodeBench 等權威評測集上斬獲了同尺寸開源模型 SOTA。其中,Qwen3-0.6B、Qwen3-1.7B、Qwen3-4B 等三款模型兼具低功耗和高性能等優勢,非常適合在移動端進行部署。

在 AI 模型快速迭代、日新月異的當下,開發者亟需一個具備可擴展性的通用技術底座,以便高效利用每一個新模型的優勢。作為業界性能最強、能效最高的計算平臺,Arm 為開發者提供了無縫優化其 AI 工作負載所需的卓越性能、能效、靈活性和可擴展性。Arm CPU 能滿足不斷發展的 AI 工作負載需求,是開發者的理想之選,它不僅能在模型推出時迅速實現適配與支持,還能隨著模型的演進,通過 Arm 異構計算策略與 GPU、加速器及網絡技術的共生協作,實現 AI 系統的最佳優化。在此次阿里 Qwen3 模型推出后,運行結果顯示,Qwen3-0.6B、Qwen3-1.7B 及 Qwen3-4B 三款模型在基于 Arm 架構 CPU 的移動設備上,運行和響應速度大幅提升,為終端用戶帶來了極致的 AI 推理能力。

雙方圍繞千問大模型持續緊密合作,今年三月,Arm 與阿里巴巴淘天集團在搭載基于 Arm Cortex-X925 的旗艦移動系統級芯片 (SoC) 的智能設備上,通過 KleidiAI 與 MNN 的集成,模型預填充(指 AI 模型在生成響應之前先對提示詞輸入進行處理)性能提升了 57%,以及解碼(指處理提示詞后從 AI 模型生成文本的過程)性能提升了 28%。這一性能提升,使得運行在搭載 Arm CPU 上的通義千問 Qwen2-VL-2B-Instruct,其端側多模態 AI 工作負載的性能顯著增進,帶來全新的用戶體驗!

展望未來,Arm 也將一如既往助力開發者在端側設備上提供更加復雜的多模態體驗,為新一輪智能計算浪潮奠定堅實基礎,在 AI 的不斷演進中,實現體驗的持續躍升!

-

ARM

+關注

關注

134文章

9349瀏覽量

377389 -

cpu

+關注

關注

68文章

11076瀏覽量

217007 -

阿里巴巴

+關注

關注

7文章

1638瀏覽量

48235 -

模型

+關注

關注

1文章

3517瀏覽量

50404

原文標題:Arm CPU 精準適配阿里 Qwen3 開源模型,實現卓越端側 AI 推理能力

文章出處:【微信號:Arm社區,微信公眾號:Arm社區】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

Intel OpenVINO? Day0 實現阿里通義 Qwen3 快速部署

MediaTek天璣9400率先完成阿里Qwen3模型部署

后摩智能NPU適配通義千問Qwen3系列模型

幾B都有!BM1684X一鍵適配全系列Qwen3

Arm CPU適配通義千問Qwen3系列模型

Arm CPU適配通義千問Qwen3系列模型

評論