近日,阿里巴巴正式發布新一代Qwen大語言模型系列(Qwen3與Qwen3-MoE),在模型規模與性能上實現多方面升級。openEuler社區團隊與vLLM社區通力合作,在第一時間完成Qwen3模型驗證。目前,開發者可以基于OpenAtom openEuler(簡稱“openEuler”)和vLLM在昇騰設備上完成 Qwen3 推理。

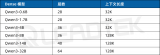

新一代Qwen大語言模型主要包含2個版本:

?Qwen3,包括Qwen3-0.6B、Qwen3-1.7B、Qwen3-4B、Qwen3-8B

?Qwen3-MoE,包括Qwen3-MoE-15B-A2B、Qwen3-30B-A3B、Qwen3-235B-A22B

早在4月中旬,vLLM發布的v0.8.4版本中已經包括對Qwen3最新結構的支持。隨即,vLLM社區的vLLM Ascend團隊同步發布了v0.8.4rc1版本,并完成了跟進和適配。在該版本中,openEuler成為上游默認支持的操作系統之一,同步發布容器鏡像。

Qwen3發布后,openEuler社區與vLLM社區通力合作,在第一時間完成Qwen3模型驗證,這意味著開發者現在就可以一鍵拉起基于openEuler的vLLM-Ascend容器鏡像在昇騰設備上實現Qwen3的推理。

快速體驗Qwen3

體驗之前,您需確認固件/驅動已正確安裝,可運行如下命令確認:

npu-smi info

您可以使用如下命令,一鍵拉起基于openEuler的vLLM-Ascend容器鏡像:

# Update DEVICE according to your device (/dev/davinci[0-7]) exportDEVICE=/dev/davinci0 # Update the openeuler-vllm-ascend image exportIMAGE=quay.io/ascend/vllm-ascend:v0.8.4rc2-openeuler docker run --rm --name openeuler-vllm-ascend --device$DEVICE --device /dev/davinci_manager --device /dev/devmm_svm --device /dev/hisi_hdc -v /usr/local/dcmi:/usr/local/dcmi -v /usr/local/bin/npu-smi:/usr/local/bin/npu-smi -v /usr/local/Ascend/driver/lib64/:/usr/local/Ascend/driver/lib64/ -v /usr/local/Ascend/driver/version.info:/usr/local/Ascend/driver/version.info -v /etc/ascend_install.info:/etc/ascend_install.info -v /root/.cache:/root/.cache -p 8000:8000 -it$IMAGEbash

進入容器環境后,使用ModelScope平臺進行下載加速:

exportVLLM_USE_MODELSCOPE=true

在線推理

您可以使用vLLM和vLLM Ascend一鍵部署在線推理服務:

vllmserve Qwen/Qwen3-8B

服務啟動后,您可以通過curl請求來進行內容生成:

curl http://localhost:8000/v1/completions -H"Content-Type: application/json" -d '{"model":"Qwen/Qwen3-8B","prompt":"The future of AI is","max_tokens":5, "temperature":0}'|python3-m json.tool

離線推理

您可以使用vLLM和vLLM Ascend進行離線推理。

以下是example.py的示例:

fromvllmimportLLM, SamplingParams prompts = [ "Hello, my name is", "The future of AI is",] # Create a sampling params object. sampling_params = SamplingParams(temperature=0.8, top_p=0.95) # Create an LLM. llm = LLM(model="Qwen/Qwen3-8B") # Generate texts from the prompts. outputs = llm.generate(prompts, sampling_params) foroutputinoutputs: prompt = output.prompt generated_text = output.outputs[0].text print(f"Prompt:{prompt!r}, Generated text:{generated_text!r}")

運行以上腳本即可使用vLLM和vLLM Ascend進行推理:

#exportVLLM_USE_MODELSCOPE=trueto speed up downloadifhuggingface is not reachable. python example.py

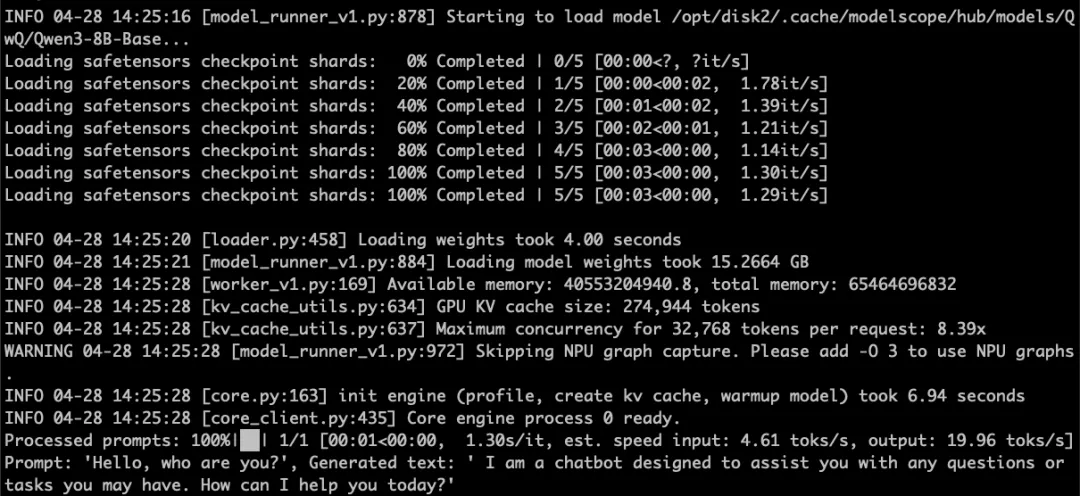

推理結果如下圖所示:

問題反饋

若您在openEuler上部署與運行Qwen3時遇到任何問題,可在openEuler官方論壇【Qwen3 on openEuler】問題收集與討論專帖下面進行反饋。

-

操作系統

+關注

關注

37文章

7082瀏覽量

124941 -

模型

+關注

關注

1文章

3486瀏覽量

49988 -

昇騰

+關注

關注

1文章

155瀏覽量

6884 -

openEuler

+關注

關注

2文章

325瀏覽量

6240

原文標題:搶先體驗!在openEuler上基于vLLM Ascend部署Qwen3

文章出處:【微信號:開放原子,微信公眾號:開放原子】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

Intel OpenVINO? Day0 實現阿里通義 Qwen3 快速部署

NVIDIA使用Qwen3系列模型的最佳實踐

使用 Canonical MAAS 部署 openEuler 測試

一次 Rancher 和 openEuler 的上云之旅

壁仞科技完成阿里巴巴通義千問Qwen3全系列模型支持

上新:小米首個推理大模型開源 馬斯克:下周推出Grok 3.5

幾B都有!BM1684X一鍵適配全系列Qwen3

中科曙光DeepAI深算智能引擎全面支持Qwen3

摩爾線程GPU率先支持Qwen3全系列模型

后摩智能NPU適配通義千問Qwen3系列模型

MediaTek天璣9400率先完成阿里Qwen3模型部署

NVIDIA RTX 5880 Ada與Qwen3系列模型實測報告

在openEuler上基于vLLM Ascend部署Qwen3

在openEuler上基于vLLM Ascend部署Qwen3

評論