以下文章來源于谷歌云服務,作者 Google Cloud

Amin Vahdat

Google Cloud ML、系統和 Cloud AI 副總裁暨總經理

在 Google Cloud Next 25 大會上,我們隆重推出第 7 代 Tensor Processing Unit (TPU) — Ironwood。這不僅是我們迄今為止性能最高、擴展性最佳的定制 AI 加速器,更是第一款專為推理而設計的 TPU。

十多年來,TPU 一直為 Google 最嚴苛的 AI 訓練與執行工作負載提供支持,并助力我們的云端客戶實現相同目標。Ironwood 是我們至今最強大、功能最全面且能效最高的 TPU,專為大規模驅動思考型(thinking)、推理型(inferential)的 AI 模型而打造。

Ironwood 的問世,代表著 AI 發展及其底層基礎架構演進的重大轉變。從為人們提供實時信息以供解讀的響應式 AI (responsive AI)模型,轉向能夠主動生成洞察和解讀的模型。這就是我們所說的「推理時代」(age of inference),在這個時代,AI agent 將主動檢索和生成數據,以協同方式提供洞察與解答,而不僅僅是提供數據。

Ironwood 的構建旨在支持生成式 AI 的下一個發展階段及其龐大的計算和通信需求。Ironwood 可以擴展到高達 9,216 顆液冷芯片(liquid cooled chips),這些芯片通過突破性的芯片間互連 (Inter-Chip Interconnect, ICI) 網絡相連。它是 Google Cloud AI Hypercomputer 架構的多項新組件之一,該架構旨在整合優化硬件與軟件層面,以應對最嚴苛的 AI 工作負載。通過 Ironwood,開發者還能利用 Google 自家的 Pathways 軟件堆棧,可靠且輕松地利用數萬個 Ironwood TPU 的組合計算能力。

以下我們將深入探討這些創新如何協同運作,以無與倫比的性能、成本和能效來處理最嚴苛的訓練與執行工作負載。

以 Ironwood 驅動推理時代

Ironwood 的設計旨在從容應對「思考模型」的復雜計算和通信需求,這類模型涵蓋了大語言模型 (LLMs)、專家混和模型 (Mixture of Experts, MoEs) 和進階推理任務。這些模型需要大規模并行處理能力和高效的內存訪問。

特別的是,Ironwood 的設計著重于在執行大量的張量運算的同時,最大限度地降低芯片上的數據移動和延遲。在前沿應用方面,思考模型的計算需求遠遠超出任何單一芯片的處理容量。我們為 Ironwood TPU 設計了低延遲、高帶寬的 ICI 網絡,以支持在整個 TPU Pod 規模下進行協調且同步的通信。

針對 Google Cloud 客戶,Ironwood 根據 AI 工作負載的需求提供兩種規模配置:256 顆芯片配置和 9,216 顆芯片配置。

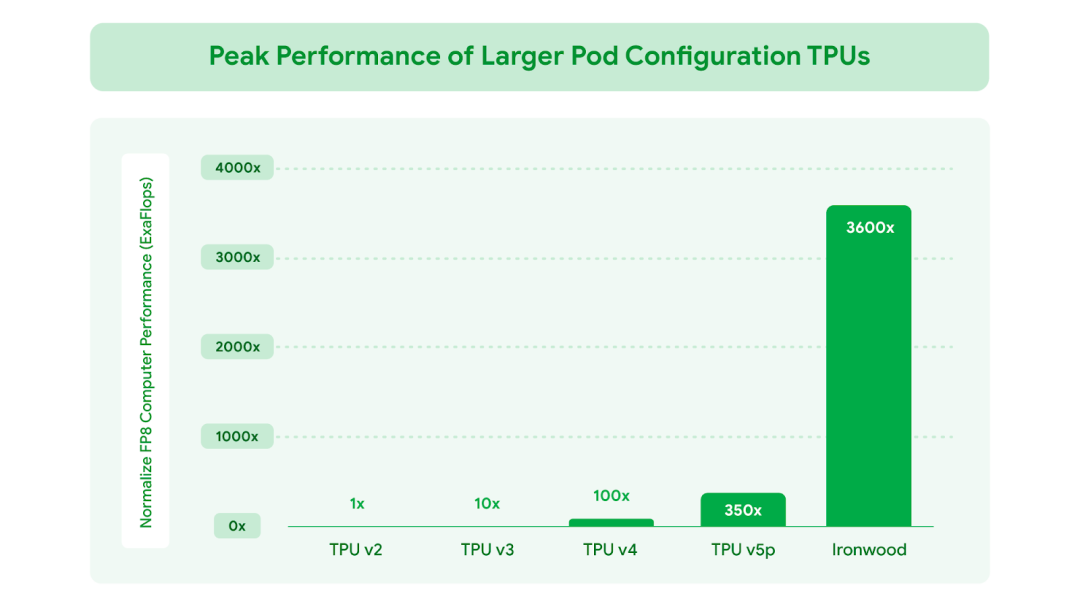

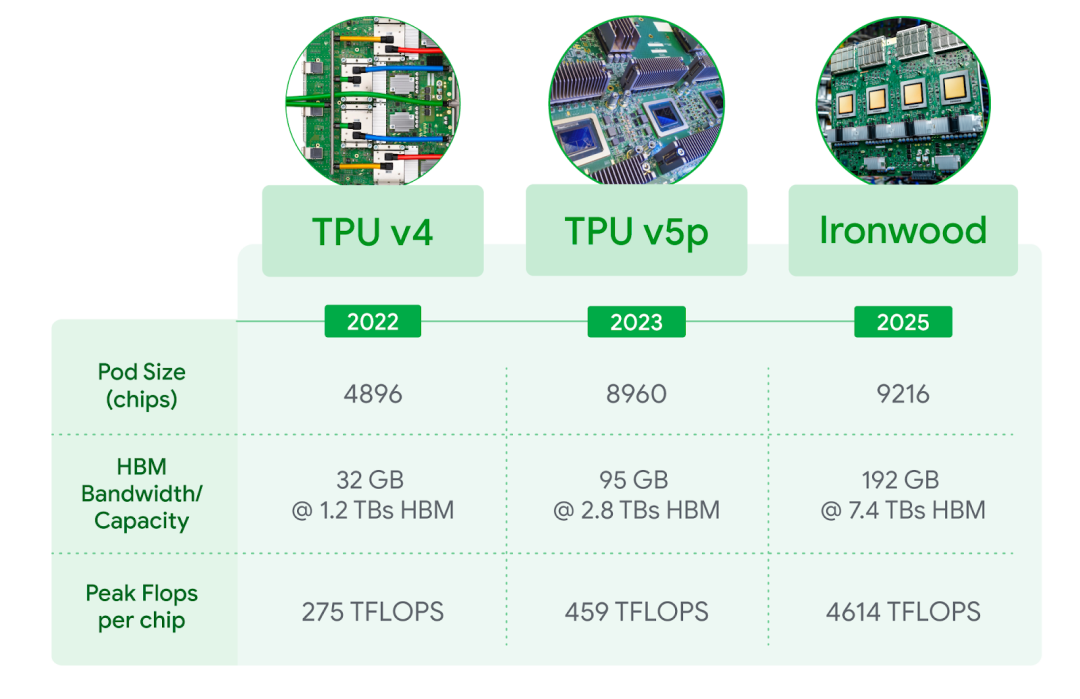

當擴展到每個 Pod 達 9,216 顆芯片時,總運算能力可達 42.5 百億億次浮點運算每秒(42.5 Exaflops),是世界上最大的超級計算機 El Capitan 的24 倍以上,后者每個 Pod 僅提供 1.7 百億億次浮點運算每秒 (1.7 Exaflops)。Ironwood 提供的大規模并行處理能力,能夠支持最嚴苛的 AI 工作負載,例如用于訓練和推理、具備思考能力的超大型密集 LLM 或 MoE 模型。每顆獨立芯片的峰值計算能力高達 4,614 萬億次浮點運算每秒(4,614 TFLOPs),代表著 AI 能力的巨大飛躍。此外,Ironwood 的內存和網絡架構確保了在如此龐大的規模下,始終能夠提供正確的數據可支持峰值性能。

Ironwood 還配備了增強版的 SparseCore,這是一種專門用于處理高級排名和推薦系統工作負載中常見的超大規模嵌入(embeddings)的加速器。Ironwood 對 SparseCore 的支持擴大,使其能加速更廣泛的工作負載,甚至跨越傳統 AI 領域,進入金融和科學等領域。

Google DeepMind 開發的機器學習運行時架構 Pathways,能在多個 TPU 芯片間實現高效的分布式計算。Google Cloud 上的 Pathways 讓使用者能輕易超越單個 Ironwood Pod 的限制,將數十萬顆 Ironwood 芯片組合在一起,以快速推進生成式 AI 計算的前沿發展。

圖一:相較于 Google 首款對外提供的 Cloud TPU v2, FP8 總峰值浮點運算性能提升幅度。

圖二:包括最新一代 Ironwood 在內的 Cloud TPU 產品 (3D 環形拓撲結構, 3D torus version) 技術規格并列比較。FP8 峰值 TFlops 在 v4 與 v5p 上為模擬值,Ironwood 則提供原生支持。

Ironwood 的主要功能

Google Cloud 是唯一一家擁有超過十年提供 AI 計算經驗的超大規模云提供商,不僅支持尖端研究,更將這些技術無縫整合到全球規模等級的服務中,每天為數十億使用者提供 Gmail、Google 搜索等服務。這些專業知識正是 Ironwood 性能的核心所在。主要功能包括:

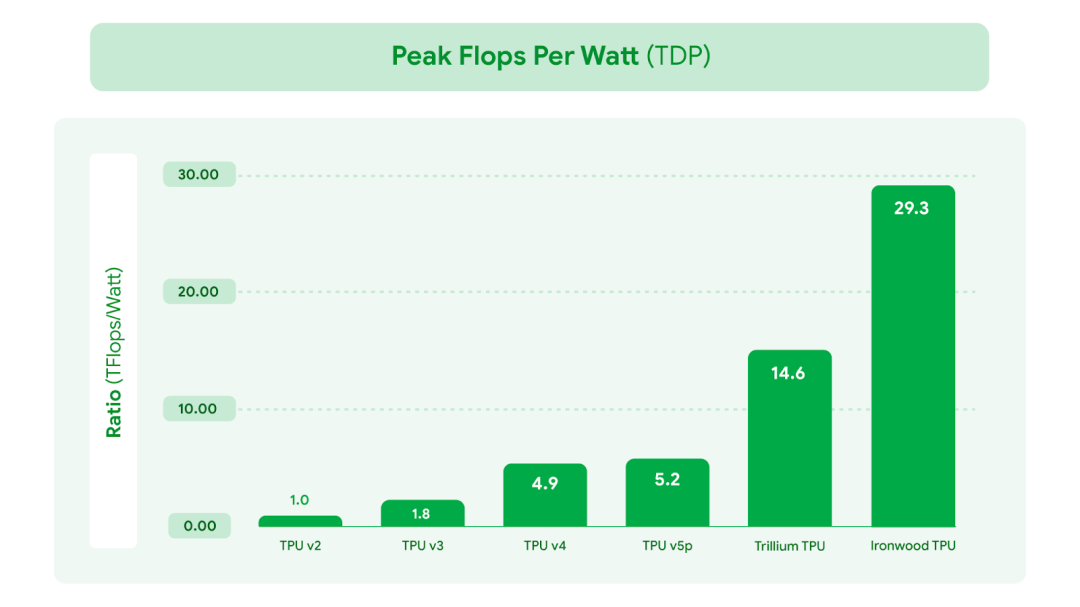

在性能大幅提升的同時也注重能效,使 AI 工作負載能夠以更符合成本效益的方式運行。Ironwood 的性能功耗比是 2024 年推出的第 6 代 TPU Trillium 的 2 倍。在當前可用電力成為 AI 發展限制因素之一的時代,我們為客戶的工作負載提供了每瓦更多的計算能力。我們先進的液冷解決方案和優化的芯片設計,即使面對持續繁重的 AI 工作負載,也能可靠地維持高達標準風冷兩倍的性能。事實上,Ironwood 的能效較我們 2018 年推出的首款 Cloud TPU 提升近 30 倍。

大幅增加高帶寬內存 (HBM) 容量。Ironwood 每顆芯片提供 192 GB 容量,是 Trillium 的 6 倍,能處理更大的模型和數據集計算,減少頻繁的數據傳輸需求,進而提升整體性能。

HBM 帶寬大幅提升,單顆芯片可達 7.2 Tbps,是 Trillium 的 4.5 倍。這種高帶寬能確保數據快速訪問,這對于現代 AI 中常見的內存密集型工作負載至關重要。

增強芯片間互連 (ICI) 帶寬。雙向傳輸已提高到 1.2 Tbps,是 Trillium 的 1.5 倍,能加速芯片間的通信,有助于提升大規模分布式訓練和推理的效率。

圖三:相較于最早的 Cloud TPU v2,Google TPU 的能效有顯著提升。此數據是以每顆芯片封裝在熱設計功耗(TDP)下所能達到的 FP8 峰值運算性能(flops per watt)進行衡量。

Ironwood 滿足了未來 AI 的需求

Ironwood 憑借其全面提升的計算能力、內存容量、芯片互連技術進展與可靠性,代表推理時代的一項獨特關鍵突破。這些突破,加上近 2 倍的能效提升,意味著我們需求最高的客戶能以最高的性能與最低的延遲來處理訓練與推理執行工作負載,同時滿足暴增的計算需求。

當前尖端 AI 模型如 Gemini 2.5 和榮獲諾貝爾獎的 AlphaFold, 如今都在 TPU 上運行。我們迫不及待地想看到我們自己的開發人員和 Google Cloud 客戶在 Ironwood 今年晚些時候推出后,會激發出哪些 AI 領域的突破。

-

Google

+關注

關注

5文章

1787瀏覽量

58673 -

加速器

+關注

關注

2文章

823瀏覽量

38915 -

AI

+關注

關注

87文章

34201瀏覽量

275364 -

TPU

+關注

關注

0文章

151瀏覽量

21079

原文標題:Ironwood:首款適用于 AI 推理時代的 Google TPU

文章出處:【微信號:Google_Developers,微信公眾號:谷歌開發者】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

小馬智行第七代Robotaxi車型搭載禾賽AT128激光雷達

谷歌新一代 TPU 芯片 Ironwood:助力大規模思考與推理的 AI 模型新引擎?

新大陸掃碼器測評:1秒識別破損碼,一維二維條碼也能高效識別

CC2564C雙模Bluetooth?控制器數據手冊

全場景紅外光柵-智能紅外入侵探測器

蘋果iPad mini開啟預購,搭載全新A17 Pro芯片

蘋果推出新一代iPad mini,售價3999元起

合科泰榮獲第七屆“藍點獎”國際影響力品牌獎

英飛凌推出低功耗CIPOS Maxi智能功率模塊(IPM)系列

英飛凌推出高性能 CIPOS? Maxi 智能功率模塊,適用于功率高達 4 千瓦的工業電機驅動器

利用SLC技術改善熱導率,增強IGBT模塊功率密度

Google推出第七代TPU芯片Ironwood

Google推出第七代TPU芯片Ironwood

評論