電子發燒友網報道(文/黃晶晶)DeepSeek-R1是幻方量化旗下深度求索(DeepSeek)公司研發的推理模型。DeepSeek-R1于2025年1月20日正式發布。該模型采用強化學習進行后訓練,旨在提升推理能力,尤其擅長數學、代碼和自然語言推理等復雜任務。

DeepSeek-R1在發布后迅速引發了廣泛關注,以高性能與低訓練成本令外界震驚。DeepSeek表示, DeepSeek-R1在數學、代碼、自然語言推理等任務上,性能比肩 OpenAI o1 正式版。

去年12月底發布的DeepSeek-V3模型,整個訓練使用2048塊英偉達H800 GPU僅花費約557.6萬美元,不到其他頂尖模型訓練成本的十分之一。H800是英偉達特供中國顯卡,相較于它的旗艦芯片H100降低了部分性能。OpenAI的GPT-4o模型訓練采用的是上萬個H100 GPU。DeepSeek-V3性能與GPT-4o相近。而DeepSeek-R1與OpenAI的o1相比,其成本僅為3%-5%。

這意味著,高性能AI模型的開發不必依賴于昂貴的算力和海量的數據,卻能達到國外頂級AI大模型的效果。DeepSeek讓大模型推理應用更加平民化、普及化,于存儲行業而言,它既能降低存儲成本,又能激發更多存儲技術的創新,拓展存儲應用,真正利好存儲行業的發展。

降低存儲成本

DeepSeek通過算法優化和模型壓縮等技術大幅降低了AI模型的訓練成本。也令一些企業看到軟件和硬件的結合,比單純地堆硬件能獲得更佳的效果。DeepSeek不僅降低了對高端GPU的需求,對于高性能計算的關鍵存儲高帶寬內存(HBM)的需求也可能放緩。這使得一些企業對AI服務器的投入或將不再著眼于更高規格的配置,從而降低了其購置成本。

不過,DeepSeek本身在大模型訓練和推理時,仍然離不開高性能存儲。從長期來看,AI應用對數據存儲容量和速率都有著更高要求。

DeepSeek大模型訓練需要處理海量的數據,像DeepSeek-V3訓練使用了大規模的語料庫,總參數達6710億,這些數據的存儲、讀取和傳輸都需要大量高性能存儲芯片來支持。在推理階段,DeepSeek-R1應用于智能客服、圖像識別、自然語言處理等眾多場景時,會產生大量的中間數據和結果數據,需要存儲芯片進行臨時或長期存儲。隨著AI應用場景的廣泛落地,存儲芯片的總需求有望增加。

促進存儲創新

DeepSeek的技術發展可能會促使存儲芯片制造商探索新的存儲架構和解決方案,以更好地滿足AI應用的需求。例如,隨著AI模型的本地部署量增加,對低功耗、高能效的存儲芯片如LPDDR以及高速內存的需求可能會增長。

近期DeepSeek運行在AMD EPYC CPU上,無需顯卡支持,而搭配高頻內存多通道內存能夠有效提升運行速度,token/秒值得到明顯提升,且功耗低、成本更低。

DeepSeek的算法可適配存內計算架構,減少數據搬運能耗。例如,優化神經網絡模型以匹配ReRAM(阻變存儲器)的模擬計算特性。還可與存儲廠商合作優化AI加速器與存儲的接口協議(如CXL),降低系統級延遲。

計算和存儲能力的提升是AI技術持續進步和廣泛應用的硬件基礎。AI訓練和推理過程中,需要頻繁地讀取和處理海量數據,高性能計算芯片要充分發揮其性能優勢,需要高性能的內存系統與之匹配。因此,HBM仍然是滿足高強度數據處理所不可或缺的內存。SK海力士、三星電子、美光三大家的HBM內存競賽也來到了HBM4階段,隨著技術研發的深入將不斷推出高帶寬HBM內存進階。

除HBM之外,AI服務器對于傳統高性能DIMM內存的容量與讀取性能要求也明顯提升,與此相應的,DDR5在RDIMM產品的滲透率大幅增長。同時,AI服務器進行大模型訓練時產生的數據相較傳統服務器的中間數據極具保存價值,因此保存次數大幅度增加。在此情形下eSSD的高速度、低能耗優勢決定其可以大面積取代HDD,全球各大云服務提供商均開始大規模采購eSSD。江波龍表示eSSD與RDIMM產品已在互聯網、運營商等領域的多個知名客戶處完成了產品驗證和批量出貨,未來公司將通過與大客戶的深度長期合作,實現企業級業務的持續高速增長。

AI推理廣泛落地,存儲需求增長

根據 IDC 數據,隨著人工智能進入大規模落地應用的關鍵時期,云端推理占算力的比例將逐步提升,“預計到 2026 年,推理占到 62.2%,訓練占 37.8%。”這一預測進一步強調了 AI 推理在未來市場競爭中的核心地位。

根據機構測算,到2028年人工智能的推理負載占比有望達到85%,考慮到云端和邊緣側巨大的推理需求,未來推理芯片的預期市場規模將是訓練芯片的4~6倍。

在邊緣計算場景下,DeepSeek-R1推理大模型應用于AIoT設備,必將對低功耗、高耐久存儲提出需求,推動NOR Flash、MRAM等細分市場增長。

兆易創新談到NOR Flash在 AI終端的應用。AIPC方面,隨著BIOS程序量代碼量的不斷增長,對NORFlash提出了更大容量的需求,即便PC總量維持不變,程序量的增長也會帶動NORFlash 容量的提升。

AI眼鏡是新的品類,期待AI眼鏡能夠發展成與TWS可比的品類,新需求對于NORFlash將會形成較明顯的拉動作用。耳機方面,目前除了行業頭部品牌對于NORFlash的容量需求比較大,大部分中低端的TWS耳機,由于功能相對簡單,所以對NORFlash的容量要求很小。未來如果AI耳機能夠升級,對NORFlash容量的拉動就會比較明顯。如果未來消費者要求耳機必須加入AI功能,那么隨著AI耳機滲透率的提升,對NOR Flash 容量的需求也會增長,即便耳機總的銷售臺數不增加,只要單機容量提升,對市場規模也是有拉動效果的。

寫在最后

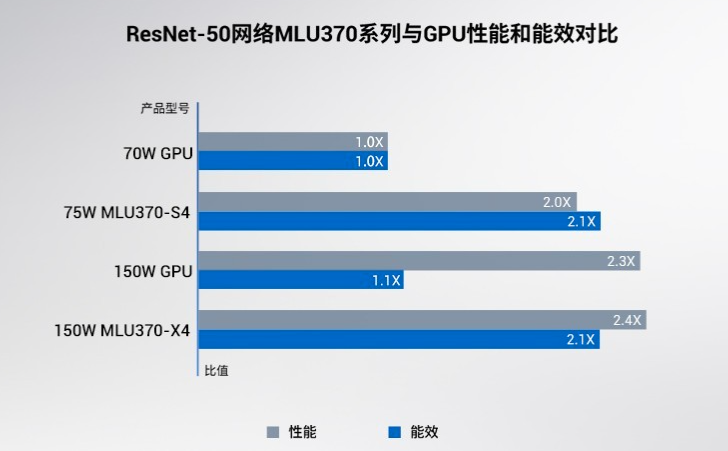

DeepSeek的算法革新降低了對最尖端算力的依賴,最近一大批國內CPU、GPU、AI芯片廠商踴躍適配DeepSeek,將有利于國產芯片在AI推理市場的競爭力提升。DeepSeek推理模型在邊緣計算設備和企業本土化的部署,也將刺激更多推理芯片需求。存儲芯片作為AI存力的組成部分,最先受益的莫過于HBM,如今DeepSeek帶來的AI推理應用大爆發,將帶動主流存儲芯片品類真正的市場機會。

-

存儲

+關注

關注

13文章

4502瀏覽量

87065 -

DeepSeek

+關注

關注

1文章

773瀏覽量

1337

發布評論請先 登錄

寒武紀“炸裂”財報!一季度營收增長40倍,積極備貨應對“爆單”?

寒武紀3000億市值與GPU廠商密集IPO,AI芯片正是當打之年

寒武紀一季度營收大漲4230% 凈利潤3.55億 扭虧為盈

Deepseek橫空出世!中美AI之間的差距逆轉了嗎?

DeepSeek大模型如何推動“AI+物流”融合創新

橫空出世!容芯致遠創新“智算整機架構”融合DeepSeek應用

研華邊緣AI平臺測試DeepSeek蒸餾版模型的最新數據

華為推出昇騰DeepSeek大模型一體機

【實測】用全志A733平板搭建一個端側Deepseek算力平臺

如何在MATLAB中使用DeepSeek模型

DeepSeek橫空出世,存儲產業的寒武紀大爆發來了

DeepSeek橫空出世,存儲產業的寒武紀大爆發來了

評論