來源:研華工業物聯網

本期導讀

隨著Deepseek大模型的橫空出世,預計對整個工業領域會產生顛覆性的影響力,尤其針對邊緣部署部分獨創動態剪枝與量化技術,DeepSeek大模型支持在邊緣設備低功耗運行(最低適配5 TOPS算力硬件),推理速度能夠提升3倍。

研華選擇了多款基于英偉達技術的邊緣AI產品,針對目前DeepSeek-R1 系列的不同蒸餾模型進行測試,下面讓我們來看下最新測試數據!

微型邊緣端推理應用

算力100 TOPS

推薦型號:

基于ARM平臺AI Box:ICAM-540 /MIC-711 / MIC-713

支持DeepSeek-R1蒸餾模型版本:

DeepSeek-R1-Distill-Qwen-1.5B

DeepSeek-R1-Distill-Qwen-7B

DeepSeek-R1-Distill-Llama-8B

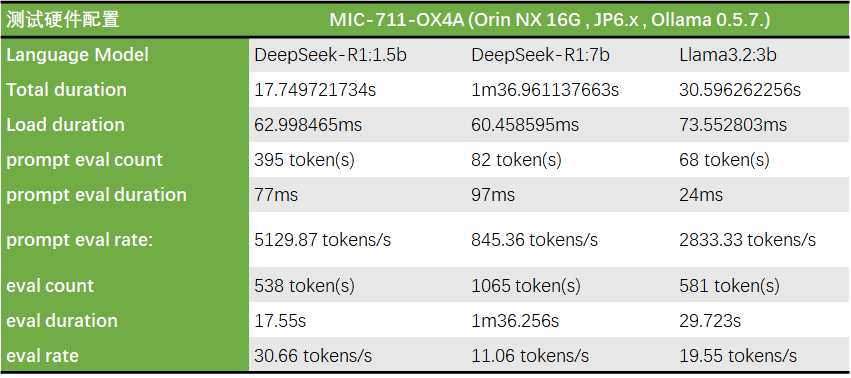

測試型號:MIC-711

*同時在MIC-711-OX4A 開啟了Super Mode來跑同樣的模型, 在整體效能上有提升了將近25%, 這也表示了 Jetson super mode在AI應用上有明顯的效能增強。

邊緣端推理應用

算力100-500 TOPS

推薦型號:

基于ARM平臺Edge AI Box:MIC-732/MIC-733/736

基于X86平臺 Edge AI Box:MIC-770V3

Edge AI 服務器 :HPC-6240/HPC-7420/SKY-602E3 (支持1-4張GPU卡)

支持DeepSeek-R1蒸餾模型版本:

DeepSeek-R1-Distill-Qwen-1.5B

DeepSeek-R1-Distill-Qwen-7B

DeepSeek-R1-Distill-Qwen-14B

DeepSeek-R1-Distill-Llama-8B

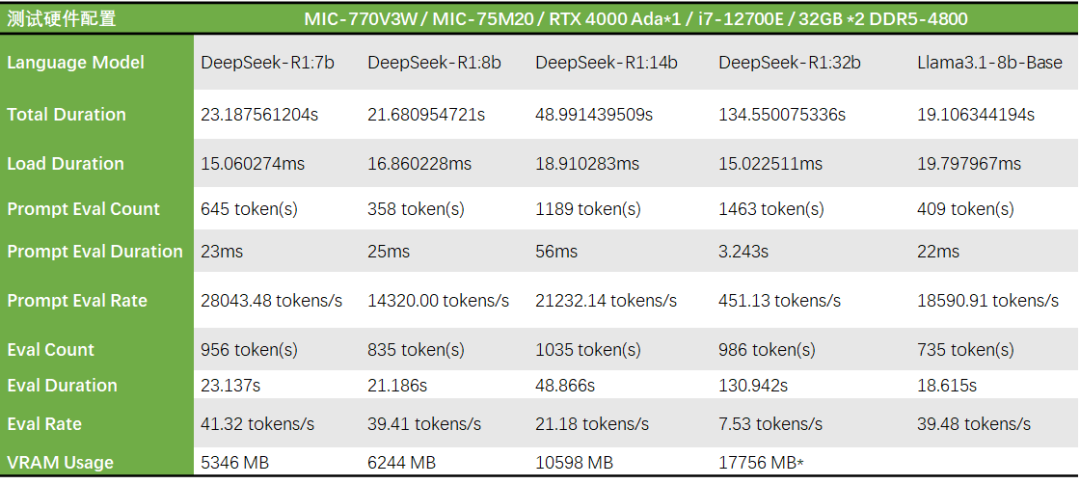

測試型號:MIC-770V3

*DeepSeek-R1:32b于此系統配置下使用約18GB VRAM,可正常運行,但相同LLM model放在較高階顯卡上測試時VRAM使用達到21GB 故猜測模型會自動調整參數降低VRAM使用量,但在效能會有其影響。

高性能邊緣AI服務器

算力500-1000+ TOPS

推薦型號:

Edge AI 服務器 :HPC-6240 /HPC-7420/SKY-602E3 (支持1-4張GPU卡)

支持DeepSeek-R1蒸餾模型版本:

DeepSeek-R1-Distill-Qwen-14B

DeepSeek-R1-Distill-Qwen-32B

DeepSeek-R1-Distill-Llama-70B

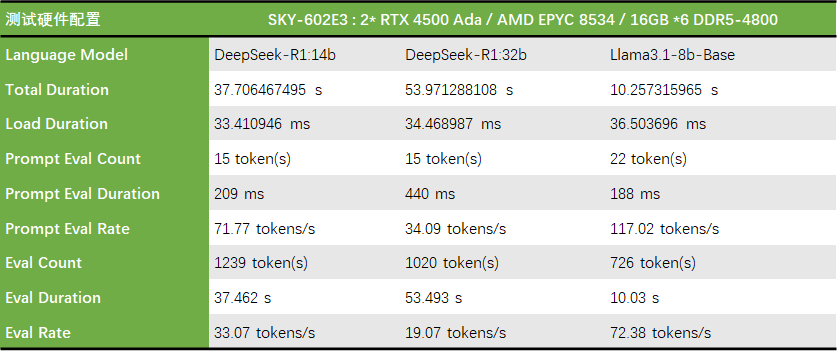

測試型號:SKY-602E3

研華全棧式邊緣AI平臺

以“邊緣原生智能”重塑工業生產力

研華打造了全棧式邊緣AI硬件矩陣,從微端到邊緣云:包括AI模塊、AI板卡、AI 加速卡、AI 嵌入式和工業平臺,AI邊緣平臺、邊緣AI服務器,乃至邊緣整機柜服務器。算力范圍從5 TOPS至2000+TOPS,用戶可根據業務場景靈活選型,實現精度與效率的最佳平衡。研華希望與伙伴攜手,以“邊緣原生智能”重塑工業生產力!

如果您對研華基于英偉達技術邊緣AI產品感興趣,可以點擊閱讀原文下載型錄資料,也可以聯系研華在地業務,咨詢產品相關資訊。

-

研華

+關注

關注

0文章

417瀏覽量

39193 -

邊緣AI

+關注

關注

0文章

146瀏覽量

5334 -

DeepSeek

+關注

關注

1文章

772瀏覽量

1324

原文標題:研華邊緣AI平臺測試DeepSeek蒸餾版模型數據大公開!

文章出處:【微信號:研華智能地球,微信公眾號:研華智能地球】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

Deepseek海思SD3403邊緣計算AI產品系統

【幸狐Omni3576邊緣計算套件試用體驗】DeepSeek 部署及測試

普渡機器人接入DeepSeek滿血版模型

研華推出GenAI Studio邊緣AI軟件平臺 助力本地端大語言模型開發,推動邊緣AI創新

寧暢推出DeepSeek大模型一體機

添越智創基于 RK3588 開發板部署測試 DeepSeek 模型全攻略

IBM在watsonx.ai平臺推出DeepSeek R1蒸餾模型

移遠通信邊緣計算模組成功運行DeepSeek模型,以領先的工程能力加速端側AI落地

【實測】用全志A733平板搭建一個端側Deepseek算力平臺

IBM企業級AI開發平臺watsonx.ai上線DeepSeek R1蒸餾模型

華為ModelEngine AI平臺全面支持DeepSeek

研華邊緣AI平臺測試DeepSeek蒸餾版模型的最新數據

研華邊緣AI平臺測試DeepSeek蒸餾版模型的最新數據

評論