在全球人工智能技術飛速發展的今天,模型的快速迭代與高效部署成為各大科技企業競相追逐的焦點。華為DCS AI全棧解決方案中的重要產品—ModelEngine AI平臺,全面支持DeepSeek大模型R1&V3和蒸餾系列模型的本地部署與優化,加速客戶AI應用快速落地。

ModelEngine作為大模型訓練、推理和應用開發的AI平臺,提供從數據預處理到模型訓練、優化及部署的一站式服務。此次ModelEngine基于昇騰AI芯片,通過推理框架優化和MoE存算協同,提供動態換入換出和全局統一緩存,實現推理高并發和低時延,用戶通過ModelEngine體驗DeepSeek更加快速高效的推理能力。

靈活部署:ModelEngine全面支持DeepSeek系列模型R1&V3 671B以及蒸餾系列模型,開發者可通過ModelEngine實現“一鍵部署”,省去硬件選型、兼容性驗證和環境配置等繁瑣步驟,大幅降低企業AI應用門檻。此外,ModelEngine通過其高度的開放性和模塊化設計,極大地縮短了DeepSeek的本地部署時間。

企業級穩定性:ModelEngine提供負載均衡、模型安全接入、多用戶配額管理等高階特性,支持大規模生產環境下的穩定運行。某證券公司引入DCS AI全棧解決方案后,運維成本降低42%。

DCS AI全棧解決方案近期將上線DeepSeek體驗環境,敬請期待。

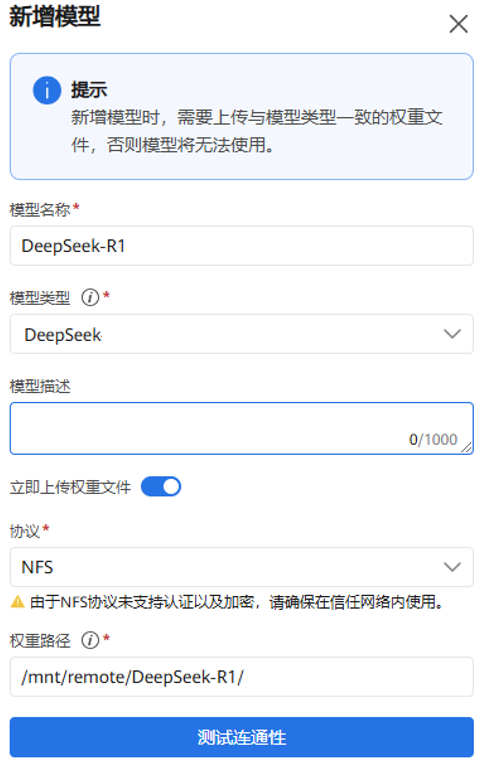

下面以DeepSeek-R1為例,基于ModelEngine 3步快速完成部署模型

1. 登錄ModelEngine模型管理頁面,上傳DeepSeek-R1 FP8權重,然后進行模型權重格式轉換,將FP8精度模型權重轉換為BF16精度模型權重;

2. 在模型服務頁面,選擇BF16精度的模型權重版本,下發推理服務,啟動任務部署;

3. ModelEngine使用MindIE推理框架啟動DeepSeek-R1推理服務后,支持OpenAI API 調用風格的推理服務接口和訪問方式;

4. ModelEngine 啟動 DeepSeek-R1 推理服務后,平臺支持 OpenAI API 調用風格的推理服務接口和訪問方式,用戶可以將該 API 集成到對話、RAG 以及 Agent 應用。

到這里,基于ModelEngine私有化本地部署的DeepSeek-R1完整版推理服務API已經就緒了,可以將推理服務API集成到對話應用、RAG或者Agent應用中,在保證數據安全的前提下,讓DeepSeek-R1媲美世界頭部頂流閉源大模型服務智能的能力,助力客戶AI業務升級。

-

華為

+關注

關注

216文章

35021瀏覽量

255028 -

大模型

+關注

關注

2文章

3020瀏覽量

3813 -

DeepSeek

+關注

關注

1文章

772瀏覽量

1321

原文標題:華為ModelEngine支持DeepSeek全系列本地部署!

文章出處:【微信號:HWS_yunfuwu,微信公眾號:華為數字中國】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

DeepSeek推動AI算力需求:800G光模塊的關鍵作用

HarmonyOS NEXT開發實戰:DevEco Studio中DeepSeek的使用

中軟國際Lumi智能體開發平臺支持DeepSeek

鴻蒙原生應用開發也可以使用DeepSeek了

添越智創基于 RK3588 開發板部署測試 DeepSeek 模型全攻略

黑芝麻智能芯片全面兼容DeepSeek模型推理

曙光云全面支持DeepSeek大模型

【實測】用全志A733平板搭建一個端側Deepseek算力平臺

端側AI元年爆發!廣和通AI模組及解決方案全面支持DeepSeek-R1蒸餾模型

華為ModelEngine AI平臺全面支持DeepSeek

華為ModelEngine AI平臺全面支持DeepSeek

評論