大模型訓練成本高?推理效率低?硬件適配難?

4月1日,百度發布飛槳框架3.0正式版!五大特性專為大模型設計。

作為大模型時代的Infra“基礎設施”,深度學習框架的重要性愈發凸顯,大模型訓練、推理等任務都離不開深度學習框架的優化與支撐。

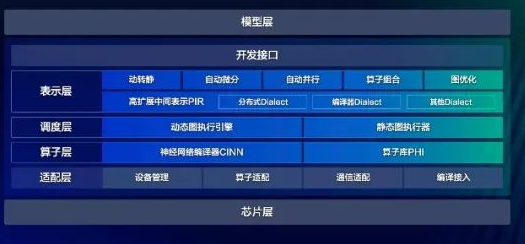

飛槳框架3.0,從設計理念上實現了從底層硬件適配到頂層開發體驗的全面進化,在訓練效率、性能、兼容性等關鍵指標上建立了新標桿。

其中,“動靜統一自動并行”、“大模型訓推一體”、“科學計算高階微分”、“神經網絡編譯器”、“異構多芯適配”這五大技術新特性,系統性解決了當前大模型研發應用面臨的分布式策略開發門檻高、訓練推理效率低、硬件適配優化難等核心痛點,并為科學智能領域前沿探索提供強大支撐。

飛槳新一代框架

◎ 飛槳提出的“動靜統一自動并行”技術,大幅降低大模型開發訓練成本,讓算法創新回歸核心價值創造;

◎ “訓推一體”設計理念打破了訓練與推理的割裂狀態,通過全方位深度優化,飛槳框架3.0能夠支持眾多開源大模型進行高性能推理,并在DeepSeek V3/R1上取得了突出的性能表現。目前,飛槳框架3.0支持文心4.5、文心X1等多款主流大模型,DeepSeek-R1滿血版單機部署吞吐提升一倍。通過技術算法創新,飛槳讓低時延、高吞吐、低算力成本的推理服務成為了現實;

◎ 在科學智能領域,飛槳框架3.0錨定科學前沿探索需要,提升微分方程求解速度。通過高階自動微分和神經網絡編譯器技術,加速微分方程求解,速度比PyTorch開啟編譯器優化后的2.6版本平均快115%。飛槳還對DeepXDE、Modulus等主流開源科學計算工具進行了廣泛適配,并成為 DeepXDE的默認推薦后端。其展現的科學智能潛力在氣象預測、生命科學、航空航天等領域具有廣泛的應用價值;

◎在運算速度上,借助創新研制的神經網絡編譯器CINN,實現性能的顯著提升,在A100平臺上RMSNorm算子進行性能測試,相較于采用Python開發接口組合實現的方式,經過編譯優化后的算子運行速度提升了4倍;使用超過60個模型進行實驗,使用CINN編譯器后超60%模型有顯著性能提升,平均提升達 27.4%;

◎ 在硬件適配方面,飛槳框架3.0推出了多芯片統一適配方案,構建“一次開發,全棧部署”的生態體系。目前已適配超過60個芯片系列,覆蓋訓練集群、自動駕駛、智能終端等場景,開發者只需編寫一份代碼,就可以讓程序在不同芯片上順暢運行,輕松實現業務的跨芯片遷移。

2016年,飛槳首次開源;

2018年,發布1.0版本,訓推一體,支持大規模分布式訓練和多端推理;

2021 年,2.0 版本發布,動靜統一,兼具靈活性與高效性;

今年,飛槳框架3.0發布,專為大模型設計,五大特性系統性解決了大模型研發應用面臨的核心痛點,同時更高效支撐科學智能。

截至2024年10月,飛槳文心生態已凝聚1808萬開發者,服務了43萬家企事業單位,創建了101萬個模型。

飛槳框架3.0正式版本已面向開發者開放,并且兼容2.0版本的開發接口,歡迎廣大開發者使用和反饋~

-

百度

+關注

關注

9文章

2326瀏覽量

91811 -

飛槳

+關注

關注

0文章

35瀏覽量

2431 -

大模型

+關注

關注

2文章

3026瀏覽量

3825

原文標題:超穩定!飛槳框架3.0正式版發布

文章出處:【微信號:baidu_2000,微信公眾號:百度】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

百度飛槳框架3.0正式版發布

百度飛槳框架3.0正式版發布

評論