程健研究員團(tuán)隊(duì)最近提出了一種基于哈希的二值網(wǎng)絡(luò)訓(xùn)練方法,揭示了保持內(nèi)積哈希和二值權(quán)重網(wǎng)絡(luò)之間的緊密關(guān)系,表明了網(wǎng)絡(luò)參數(shù)二值化本質(zhì)上可以轉(zhuǎn)化為哈希問題,在ResNet-18上,該方法比當(dāng)前最好方法的精度提高了3%。

近年來,深度卷積神經(jīng)網(wǎng)絡(luò)已經(jīng)深入了計(jì)算機(jī)視覺的各個(gè)任務(wù)中,并在圖像識別、目標(biāo)跟蹤、語義分割等領(lǐng)域中取得了重大突破。在一些場景下,當(dāng)前深度卷積網(wǎng)絡(luò)性能已經(jīng)足以部署到實(shí)際應(yīng)用中,這也鼓舞著人們將深度學(xué)習(xí)落地到更多的應(yīng)用中。

然而,深度卷積網(wǎng)絡(luò)在實(shí)際部署時(shí)面臨著參數(shù)量和時(shí)間復(fù)雜度等兩方面的問題,一方面是深度網(wǎng)絡(luò)巨大的參數(shù)量會(huì)占用大量的硬盤存儲(chǔ)和運(yùn)行內(nèi)存,這些硬件資源在一些移動(dòng)和嵌入式設(shè)備中往往是很有限的;另外一方面就是深度網(wǎng)絡(luò)的計(jì)算復(fù)雜度較高,這會(huì)使得網(wǎng)絡(luò)推理速度很慢,同時(shí)會(huì)增加移動(dòng)設(shè)備的電量消耗。

為了解決此類問題,人們提出了很多網(wǎng)絡(luò)加速和壓縮方法,其中網(wǎng)絡(luò)參數(shù)二值化是一種將網(wǎng)絡(luò)參數(shù)表示為二值參數(shù)的方法。由于二值網(wǎng)絡(luò)中參數(shù)只有+1和-1兩種值,乘法運(yùn)算就可以被加法運(yùn)算替代。由于乘法運(yùn)算比加法運(yùn)算需要更多的硬件資源和計(jì)算周期,使用加法運(yùn)算替代乘法運(yùn)算能夠?qū)崿F(xiàn)網(wǎng)絡(luò)加速的目的。

另一方面,原始網(wǎng)絡(luò)參數(shù)的存儲(chǔ)格式是32位浮點(diǎn)數(shù),二值參數(shù)網(wǎng)絡(luò)只使用1位來表示+1或者-1,達(dá)到了32倍的壓縮目的。但是將參數(shù)從32位量化到1位會(huì)導(dǎo)致較大的量化損失,當(dāng)前的二值網(wǎng)絡(luò)訓(xùn)練方法往往會(huì)導(dǎo)致較大的網(wǎng)絡(luò)精度下降,如何學(xué)習(xí)二值的網(wǎng)絡(luò)參數(shù)同時(shí)又不帶來較大的精度下降是一個(gè)問題。

圖自網(wǎng)絡(luò)

自動(dòng)化所程健研究員團(tuán)隊(duì)的胡慶浩等人最近提出了一種基于哈希的二值網(wǎng)絡(luò)訓(xùn)練方法,揭示了保持內(nèi)積哈希(Innerproduct Preserving Hashing)和二值權(quán)重網(wǎng)絡(luò)之間的緊密關(guān)系,表明了網(wǎng)絡(luò)參數(shù)二值化本質(zhì)上可以轉(zhuǎn)化為哈希問題。

給定訓(xùn)練好的全精度浮點(diǎn)32位網(wǎng)絡(luò)參數(shù) ,二值權(quán)重網(wǎng)絡(luò)(BWN)的目的是學(xué)習(xí)二值網(wǎng)絡(luò)參數(shù)

,二值權(quán)重網(wǎng)絡(luò)(BWN)的目的是學(xué)習(xí)二值網(wǎng)絡(luò)參數(shù) 并維持原始網(wǎng)絡(luò)精度。學(xué)習(xí)二值參數(shù)

并維持原始網(wǎng)絡(luò)精度。學(xué)習(xí)二值參數(shù) 的最樸素的方式就是最小化

的最樸素的方式就是最小化 與二值參數(shù)

與二值參數(shù) 之間的量化誤差,但是這種量化誤差和網(wǎng)絡(luò)精度之間存在著一定的差距,最小化量化誤差并不會(huì)直接提高網(wǎng)絡(luò)精度,因?yàn)槊恳粚拥牧炕`差會(huì)逐層積累,而且量化誤差會(huì)受到輸入數(shù)據(jù)的增幅。

之間的量化誤差,但是這種量化誤差和網(wǎng)絡(luò)精度之間存在著一定的差距,最小化量化誤差并不會(huì)直接提高網(wǎng)絡(luò)精度,因?yàn)槊恳粚拥牧炕`差會(huì)逐層積累,而且量化誤差會(huì)受到輸入數(shù)據(jù)的增幅。

一種更好的學(xué)習(xí)二值參數(shù) 的方式是最小化內(nèi)積相似性之差。假設(shè)網(wǎng)絡(luò)某一層輸入為

的方式是最小化內(nèi)積相似性之差。假設(shè)網(wǎng)絡(luò)某一層輸入為 ,

, 是原始的內(nèi)積相似性,則

是原始的內(nèi)積相似性,則 是量化之后的內(nèi)積相似性,最小化

是量化之后的內(nèi)積相似性,最小化 與

與 之間的誤差可以學(xué)習(xí)到更好的二值參數(shù)

之間的誤差可以學(xué)習(xí)到更好的二值參數(shù) 。從哈希的角度來講,

。從哈希的角度來講, 代表著數(shù)據(jù)在原始空間中的相似性或者近鄰關(guān)系,

代表著數(shù)據(jù)在原始空間中的相似性或者近鄰關(guān)系, 則代表著數(shù)據(jù)投影到漢明空間之后的內(nèi)積相似性。而哈希的作用就是將數(shù)據(jù)投影到漢明空間,且在漢明空間中保持?jǐn)?shù)據(jù)在原始空間中的近鄰關(guān)系。至此,學(xué)習(xí)二值參數(shù)

則代表著數(shù)據(jù)投影到漢明空間之后的內(nèi)積相似性。而哈希的作用就是將數(shù)據(jù)投影到漢明空間,且在漢明空間中保持?jǐn)?shù)據(jù)在原始空間中的近鄰關(guān)系。至此,學(xué)習(xí)二值參數(shù) 的問題就轉(zhuǎn)化成了一個(gè)在內(nèi)積相似性下的哈希問題,該哈希主要是將數(shù)據(jù)投影到漢明空間并保持其在原始空間中的內(nèi)積相似性。

的問題就轉(zhuǎn)化成了一個(gè)在內(nèi)積相似性下的哈希問題,該哈希主要是將數(shù)據(jù)投影到漢明空間并保持其在原始空間中的內(nèi)積相似性。

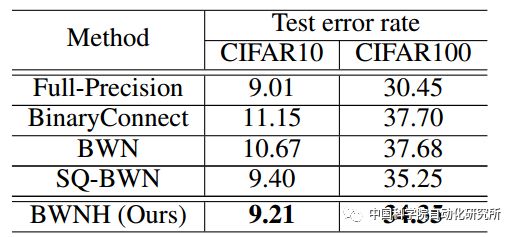

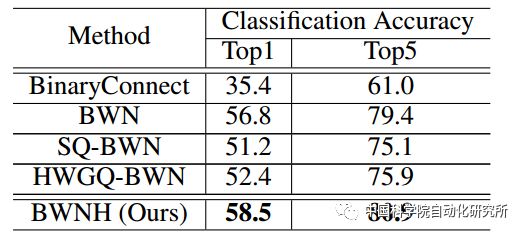

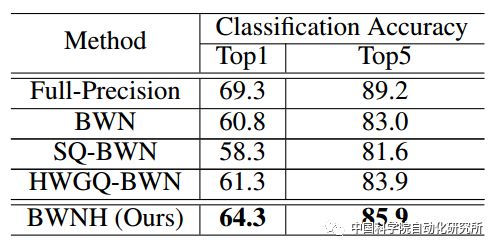

團(tuán)隊(duì)首先在VGG9小網(wǎng)絡(luò)上對方法進(jìn)行驗(yàn)證,并且在AlexNet和ResNet-18上超過當(dāng)前的二值權(quán)重網(wǎng)絡(luò)。特別的,在ResNet-18上,該方法比當(dāng)前最好方法的精度提高了3個(gè)百分點(diǎn)。獲得了較好的實(shí)驗(yàn)結(jié)果。

表1:不同方法在VGG9上的分類錯(cuò)誤率

表2:不同方法在AlexNet的分類精度

表3:不同方法在ResNet-18的分類精度

Dasgupta等人[2]在2017年11月份的《Science》上撰文揭示了果蠅嗅覺神經(jīng)回路其實(shí)是一種特殊的哈希,其哈希投影是稀疏的二值連接。對比二值權(quán)重網(wǎng)絡(luò)(BWN),我們可以發(fā)現(xiàn)二者之間有著密切的關(guān)系,首先,二者的網(wǎng)絡(luò)都是二值連接,這意味著二值權(quán)重在生物神經(jīng)回路中有存在的生物基礎(chǔ),這也為二值權(quán)重網(wǎng)絡(luò)的潛在機(jī)理提供了啟發(fā);其次,二者都是為了保持近鄰關(guān)系,并且可以描述為哈希問題,這種現(xiàn)象表明神經(jīng)網(wǎng)絡(luò)的某些連接是為了保持近鄰關(guān)系。最后,果蠅嗅覺回路中的稀疏連接和卷積層的參數(shù)共享機(jī)制有著異曲同工之處,都是對輸入的部分區(qū)域進(jìn)行連接。

相關(guān)工作已經(jīng)被AAAI2018接收[1],并將在大會(huì)上作口頭報(bào)告。

參考資料:

[1] Qinghao Hu, Peisong Wang, Jian Cheng. From Hashing to CNNs: Training Binary Weight Networks via Hashing. AAAI 2018

[2]Dasgupta S, Stevens C F, Navlakha S. A neural algorithm for a fundamental computing problem. Science, 2017, 358(6364): 793-796.

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4807瀏覽量

102772 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5554瀏覽量

122478 -

二值化

+關(guān)注

關(guān)注

0文章

13瀏覽量

4328

原文標(biāo)題:【中科院自動(dòng)化所AAAI Oral】從哈希到卷積神經(jīng)網(wǎng)絡(luò):高精度 & 低功耗

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

dc模塊電源的控制方法

求大佬分享一種基于毫米波雷達(dá)和機(jī)器視覺的前方車輛檢測方法

隱藏技術(shù): 一種基于前沿神經(jīng)網(wǎng)絡(luò)理論的新型人工智能處理器

優(yōu)化神經(jīng)網(wǎng)絡(luò)訓(xùn)練方法有哪些?

探索一種降低ViT模型訓(xùn)練成本的方法

基于粒子群優(yōu)化的條件概率神經(jīng)網(wǎng)絡(luò)的訓(xùn)練方法

微軟在ICML 2019上提出了一個(gè)全新的通用預(yù)訓(xùn)練方法MASS

新的預(yù)訓(xùn)練方法——MASS!MASS預(yù)訓(xùn)練幾大優(yōu)勢!

普渡大學(xué)的研究人員正在開發(fā)一種綜合醫(yī)療傳感平臺

研究人員發(fā)現(xiàn)一種可在水中產(chǎn)生納米氣泡的新方法

基于異構(gòu)哈希網(wǎng)絡(luò)的跨模態(tài)人臉檢索方法探究分析

一種基于異構(gòu)哈希網(wǎng)絡(luò)的跨模態(tài)人臉檢索方法

研究人員提出一種基于哈希的二值網(wǎng)絡(luò)訓(xùn)練方法 比當(dāng)前方法的精度提高了3%

研究人員提出一種基于哈希的二值網(wǎng)絡(luò)訓(xùn)練方法 比當(dāng)前方法的精度提高了3%

評論