作者:張景濤

英偉達設計的DGX H100 NVL256超級計算集群,原本計劃集成256個NVIDIA H100 GPU,但最終其在商業市場上卻難覓其蹤。這一現象引發了業界對其開發中止原因的廣泛討論。普遍觀點認為,主要障礙在于成本收益不成正比。該系統在連接GPU時大量使用光纖,導致BOM成本激增,超出了標準NVL8配置的經濟合理性范圍。

DGX H100 NVL256 SuperPOD

盡管英偉達聲稱擴展后的NVL256能夠為400B MoE訓練提供高達2倍的吞吐量。然而,大客戶經過計算分析,對英偉達的這一聲明表示懷疑。盡管最新代的NDR InfiniBand即將達到400Gbit/s的速度,而NVLink4則達到450GB/s,理論上提供了約9倍的峰值帶寬速度提升。該系統設計中使用了128個L1 NVSwitch和36個L2外部NVSwitch,形成了2:1的阻塞比,意味著每個服務器只能有一半的帶寬連接至另一服務器。英偉達依賴NVlink SHARP技術來優化網絡,以實現allToall帶寬的等效性。

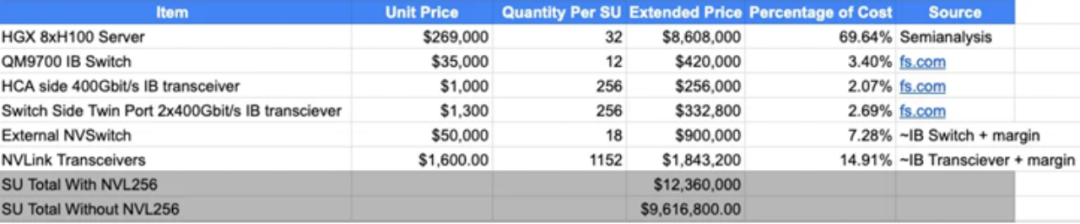

H100 NVL256 成本分析

在Hot Chips 34會議上對H100 NVL256 BoM的分析表明,擴展NVLink256使得每個超級單元(SU)的BoM成本增加了約30%。當擴展到超過2048個H100 GPU時,由于需要從兩層InfiniBand網絡拓撲轉變為三層的網絡拓撲,InfiniBand的成本百分比增加,這一比例略有降低。

圖2 NVL256成本分析

大客戶和超大規模計算公司對他們當前的工作負載進行了性能/總擁有成本(perf/TCO)分析,并得出結論:相比支付NVL256擴展NVLink的成本,額外花費30%購買更多的HGX H100服務器能獲得更好的性能/成本比。這一分析結果導致英偉達最終決定不推出DGX H100 NVL256產品。

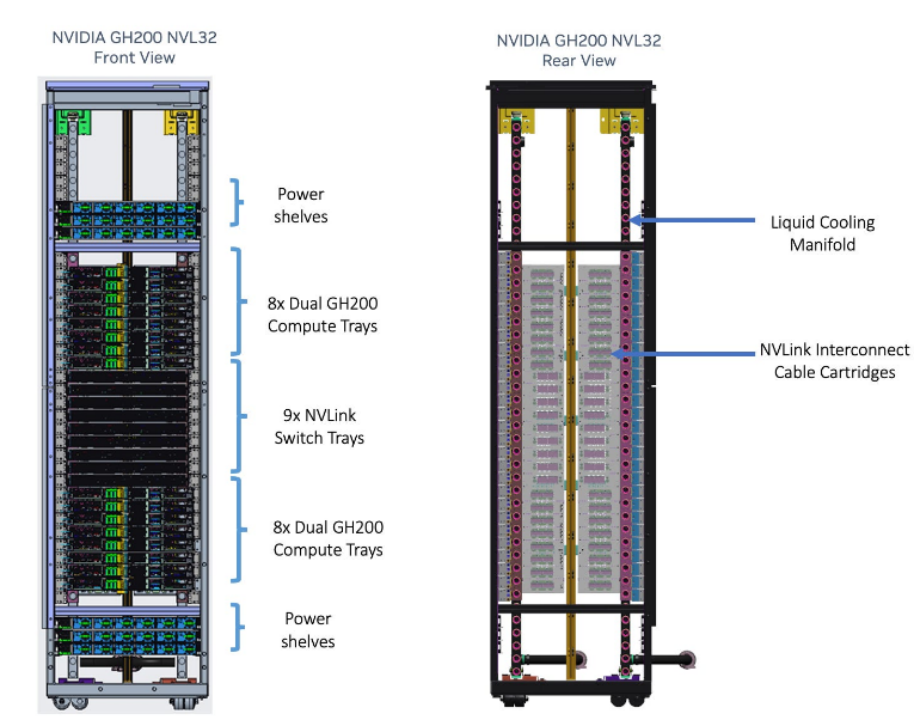

GH200 NVL32 重新設計

隨后,英偉達對NVL256進行了重新設計,將其縮減至NVL32,并采用了銅背板spine,這與他們NVL36/NVL72 Blackwell設計相似。據悉,AWS已同意為其Project Ceiba項目購買16k GH200 NVL32。據估計,這種重新設計的NVL32的成本溢價將比標準高級HGX H100 BoM高出10%。隨著工作負載的持續增長,英偉達聲稱對于GPT-3 175B和16k GH200,NVL32的速度將比16k H100快1.7倍,在500B LLM推理上快2倍。這些性能/成本比對客戶來說更具吸引力,也使得更多客戶傾向于采用英偉達的這種新設計。

圖3 GH200 NVL32

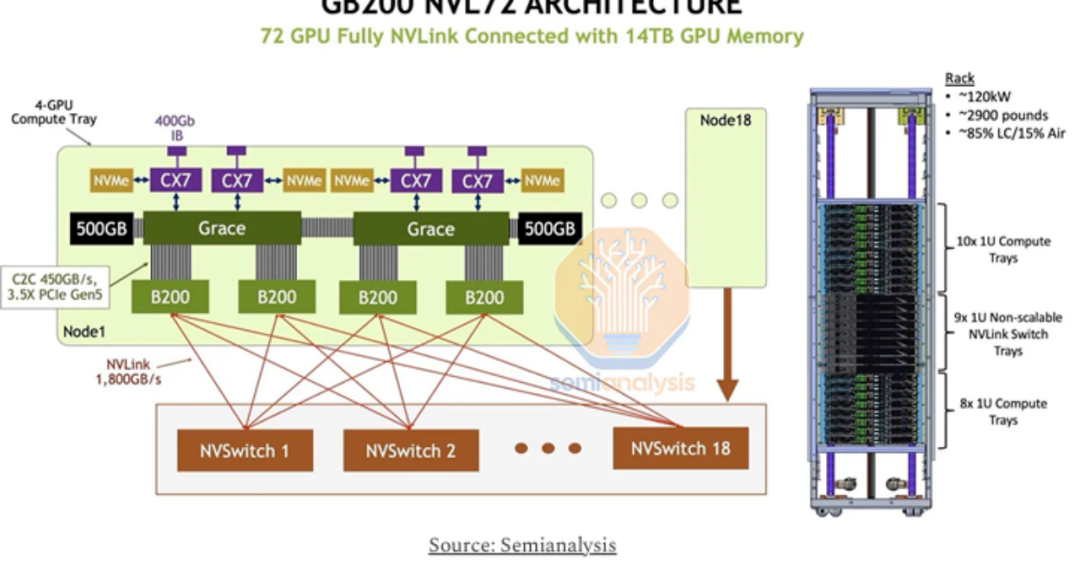

GB200 NVL72的突破

關于GB200 NVL72的預期推出,英偉達據信已經從H100 NVL256的失敗中吸取了教訓,轉而采用銅纜互連,稱為“NVLink spine”,以期解決成本問題。這種設計變更預計將降低商品成本(COG cost of goods),并為GB200 NVL72鋪平成功之路。英偉達聲稱,采用銅設計,NVL72的成本將節省約6倍,每個GB200 NVL72架可節省約20kW電力,每個GB200 NVL32架子節省約10kW。

與H100 NVL256不同,GB200 NVL72將不會在計算節點內使用任何NVLink switch,而是采用平坦軌道優化(flat rail-optimized)的網絡拓撲。對于每72個GB200 GPU,將有18個NVLink switch。由于所有連接都在同一機架內,最遠的連接只需跨越19U(0.83米),這在有源銅纜的范圍內是可行的。

圖4 GB200 NVL72架構

據Semianalysis報道,英偉達聲稱其設計可以支持在單個NVLink域內連接多達576個GB200 GPU。這可能通過增加額外的NVLink switch層來實現。預計英偉達將保持2:1的阻塞比,即在GB NVL576 SU內,將使用144個L1 NVLink switch加36個L2 NVLink switch。或者,他們也可能采取更積極的1:4阻塞比,僅使用18個L2 NVLink switch。他們將繼續使用光學OSFP收發器來擴展從機架內的L1 NVLink switch到L2 NVLink switch的連接。

圖5 GB200 NVL576架構

有傳言稱NVL36和NVL72已經占NVIDIA Blackwell交付量的20%以上。然而,對于大客戶是否會選擇成本更高的NVL576,這仍然是個問題,因為擴展到NVL576需要額外的光學器件成本。英偉達似乎已經吸取了教訓,認識到銅纜的互聯成本遠低于光纖器件。

專家觀點

其實對于到底該使用銅還是光,以及對NVL72的看法,半導體產業大神Doug O’Langhlin在其文章《The Data Center is the New Compute Unit:Nvidia's Vision for System-Level Scaling》也做了闡述:

銅纜互聯將在機架級取得統治地位,并且在用光之前要榨干銅的所有價值。

I conclude that Copper will reign supreme at the rack scale level and can push Moore’sLaw scaling further. AI networking aims to scale copper networking as hard as possible before we have to use Optics.

對于NVL72的前途,大神也相當看好,認為這是摩爾定律在機架級的體現:

It all starts with Moore’s Law. There is a profound beauty in semiconductors, as thesame problem that is happening at the chip scale is the same problem that is happening at the data center level. Moore’s Law is a fractal, and the principles that apply tonanometers apply to racks.

基于無源銅纜的nvlink域將是一個新的成功基準,并且具備更好的成本收益比。

The new Moore’s Law is about pushing the most compute into a rack. Also, looking at Nvidia’s networking moat as InfiniBand versus Ethernet is completely missing the entirepoint. I think the NVLink domain over passive copper is the new benchmark of success,and it will make a lot of sense to buy GB200 NV72 racks instead of just B200s.

業界視角

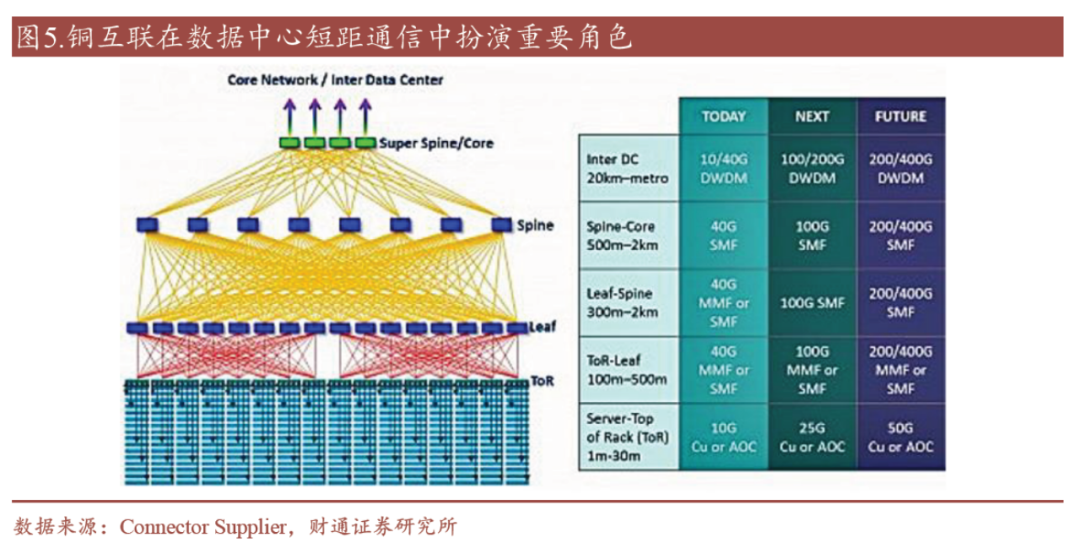

財通證券的研報《銅互聯,數據中心通信網絡重要解決方案》也給出了自己的看法。研報中指出:

短距通信場景銅互聯相對優勢還是很明顯的,銅連接產品在數據中心高速互聯中一直扮演著重要角色。在數據中心能耗攀升,以及建設成本高企的背景下,銅互聯在散熱效率、低功耗、低成本方面有著一定優勢。伴隨Serdes 速率逐步從56G、112G 向224G升級,單端口速率將基于8 通道達到1.6T,高速傳輸成本有望大幅下降,對應銅纜速率也向著224Gbps 演進。為解決高速銅纜的傳輸損耗問題,AEC、ACC通過內置信號增強芯片提升傳輸距離,銅纜模組生產工藝也在同步升級。

圖7 銅互聯在數據中心短距互聯中的重要角色

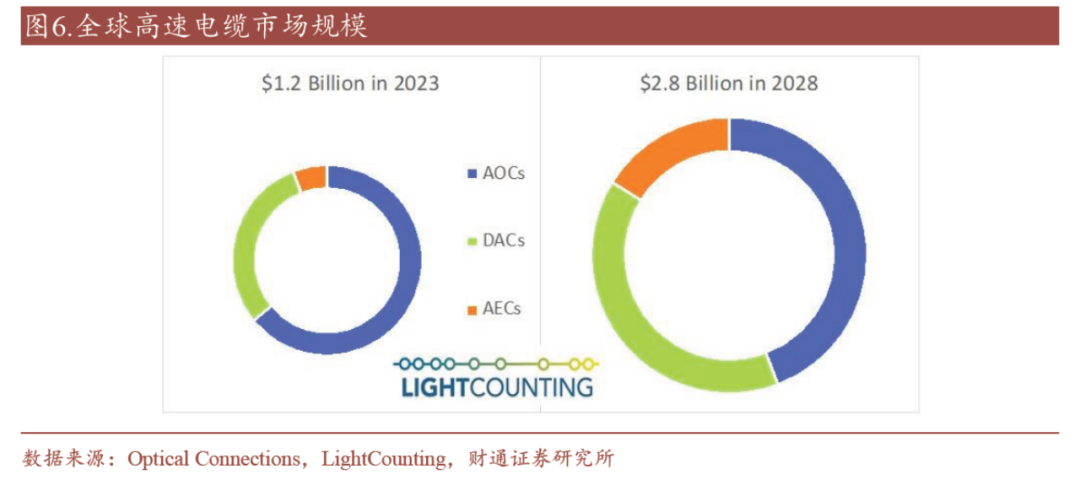

根據Light Counting,全球無源直連電纜DAC 和有源電纜AEC 的市場規模將分別以25%和45%的年復合增長率增長。

圖8 銅纜高速復合增長

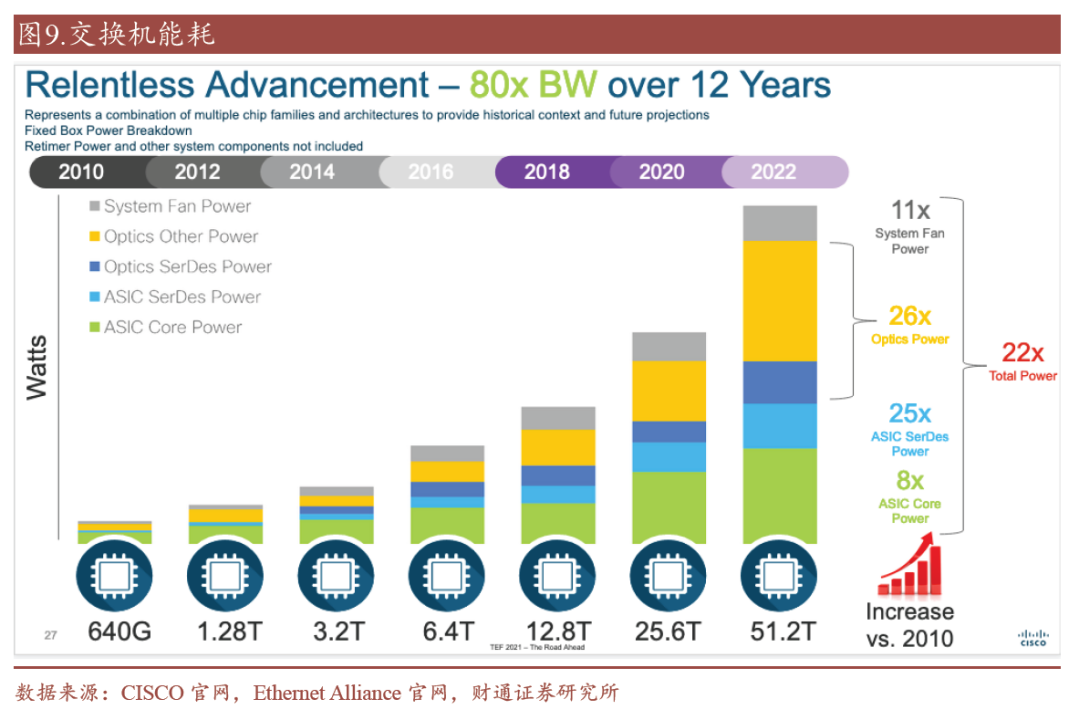

2010 年至2022 年間,交換機芯片帶寬容量從640 Gbps 增長到了51.2 Tbps,80倍的帶寬增長帶來了22 倍的系統總功耗提升,其中光學元件功率(26 倍)的功耗提升尤為明顯。

圖9 光學器件功耗占比逐步提升

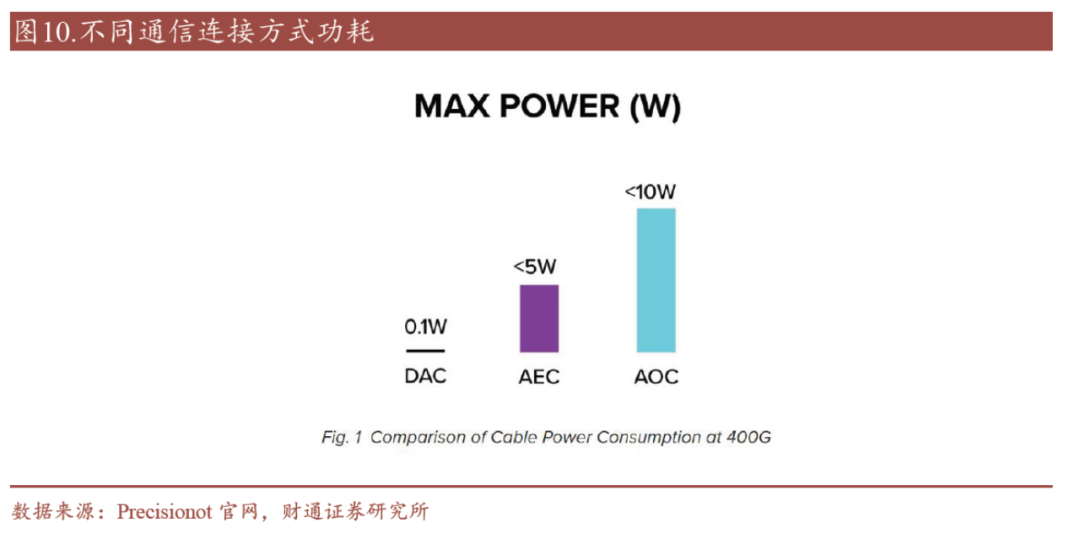

銅纜互聯由于不涉及光電轉化,因此具有低功耗特點,相比于有源光纜(AOC),目前的銅直接連接電纜(DAC)的功耗小于0.1 W,可以忽略不計,有源電纜(AEC)亦可將功耗控制在5w 以內,可在一定程度上降低算力集群整體功耗。

圖10 功耗對比

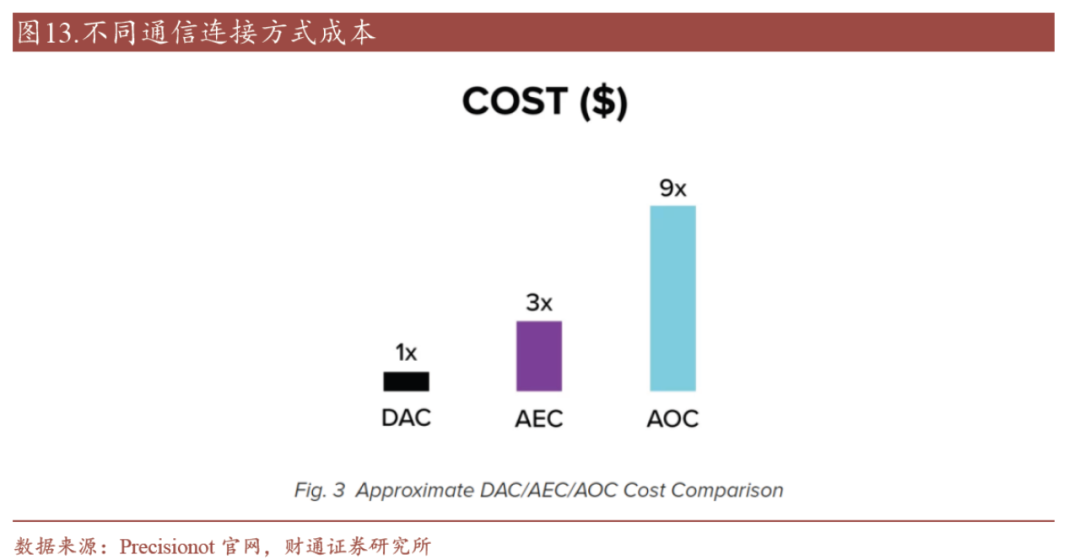

在銅纜可觸達的高速信號傳輸距離內,相比光纖連接,銅連接方案的成本較低,此外,銅纜模組在短距離內可以提供極低延遲的電信號傳輸并具有高可靠性,不會出現光纖在某些環境下可能出現的信號丟失或干擾風險。同時,銅纜的物理特性使得它更易于處理和維護,并且其具有高兼容度并不需要額外的轉換設備。

圖11 成本對比

-

gpu

+關注

關注

28文章

4910瀏覽量

130653 -

服務器

+關注

關注

13文章

9686瀏覽量

87280 -

英偉達

+關注

關注

22文章

3921瀏覽量

93109 -

智算中心

+關注

關注

0文章

88瀏覽量

1980

原文標題:揭秘智算中心的互聯技術決策

文章出處:【微信號:SDNLAB,微信公眾號:SDNLAB】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

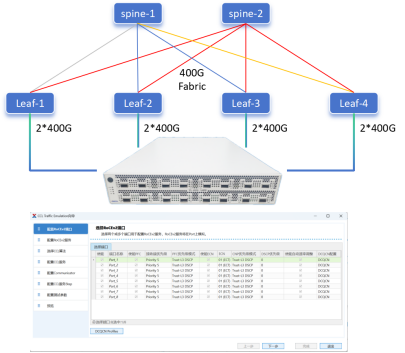

智算中心網絡架構選型原則

智算中心加速布局,上游計算、存儲、互聯都涉及哪些芯片技術

智算中心,智慧時代的“發電站”

北鯤云超算與傳統超算中心的區別

基于華為云打造的成都智算中心正式上線

天數智芯與算力互聯公司簽署算力互聯網合作框架協議

壁仞科技為中國移動呼和浩特智算中心提供強大算力

智算中心的入門指南,技術小白也能懂

智算中心的核心硬件是什么?

揭秘智算中心的互聯技術決策

揭秘智算中心的互聯技術決策

評論