近段時(shí)間以來,以ChatGPT為首的生成式AI席卷全球,技術(shù)升級(jí)帶來的生產(chǎn)力巨大提升,也正在對(duì)各個(gè)產(chǎn)業(yè)帶來革命性改變,甚至產(chǎn)業(yè)邏輯也需要被重估。

而AI浪潮背后的“賣鏟人”,英偉達(dá)一舉邁入了萬億美元市值俱樂部。

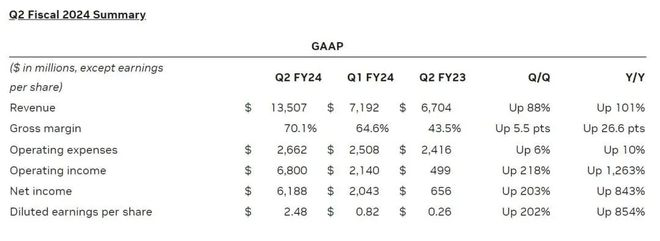

英偉達(dá)最近一個(gè)財(cái)季的業(yè)績數(shù)據(jù)同樣令人吃驚。財(cái)報(bào)數(shù)據(jù)顯示,英偉達(dá)第二財(cái)季收入為135.07億美元,創(chuàng)下紀(jì)錄新高,這使分析師給出的110.4億美元預(yù)期顯得極為保守。

英偉達(dá)2023財(cái)年Q2營收數(shù)據(jù)

整體來看,英偉達(dá)的業(yè)務(wù)規(guī)模基本達(dá)到去年同期的兩倍,這幾乎完全要?dú)w功于市場(chǎng)對(duì)其AI芯片的旺盛需求,無論是初創(chuàng)企業(yè),還是打造生成式AI服務(wù)的科技巨頭們都在瘋狂搶購這些AI芯片。

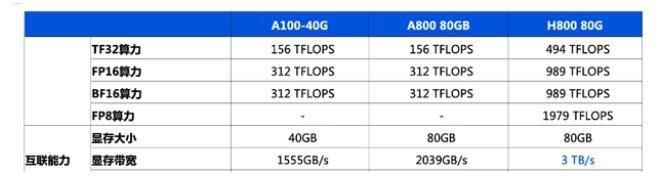

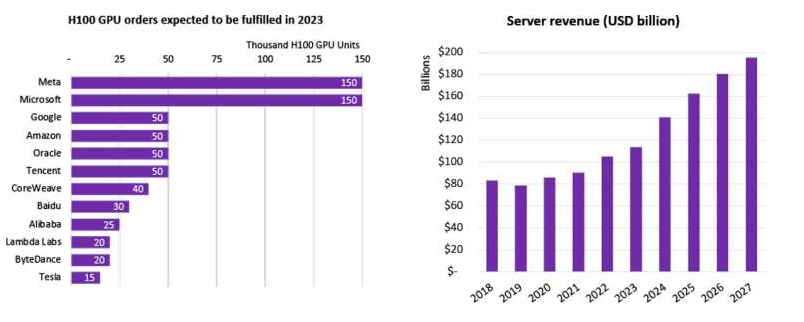

市場(chǎng)研究公司Omdia近日發(fā)布報(bào)告稱,預(yù)計(jì)英偉達(dá)二季度用于AI和高性能計(jì)算應(yīng)用的H100 GPU的出貨量超過了900噸。并且預(yù)計(jì)其在未來幾個(gè)季度的GPU銷量將大致相同,因此英偉達(dá)今年將銷售約3600?噸重的H100 GPU。

并且還不止這些,還有H800,以及上一代的A100、A800等GPU產(chǎn)品。因此,可以預(yù)計(jì),隨著英偉達(dá)從生成式AI熱潮中獲利,未來一年的出貨量將會(huì)加快。

據(jù)行業(yè)內(nèi)部消息透露,2023年英偉達(dá)H100的產(chǎn)量早已銷售一空,現(xiàn)在交錢訂購,至少要到2024年中才能拿到貨。

誰將獲得多少A100、H100 GPU,以及何時(shí)獲得,都是硅谷當(dāng)前最熱門的話題。

英偉達(dá)最大的客戶們似乎也認(rèn)可這一點(diǎn)。微軟、亞馬遜、谷歌和Meta等國際巨頭最近發(fā)布截至6月的財(cái)季的財(cái)報(bào)時(shí)都暗示,它們有強(qiáng)烈意向繼續(xù)在生成式AI能力上投入資金,盡管在其他領(lǐng)域的資本投資放緩。

AI教父Sam Altman就曾自曝,GPU已經(jīng)告急,希望用ChatGPT的用戶能少一點(diǎn)。Sam表示,受GPU限制,OpenAI已經(jīng)推遲了多項(xiàng)短期計(jì)劃。

據(jù)消息人士透露,中國的科技巨頭百度、騰訊、阿里巴巴以及字節(jié)跳動(dòng)公司今年向英偉達(dá)下達(dá)的交付訂單金額已超過10億美元,總共采購約10萬張A800和H800芯片;明年交付的AI芯片價(jià)值更是達(dá)到40億美元。

不光是科技公司在排隊(duì)購買H100,沙特阿拉伯、阿聯(lián)酋等中東國家也勢(shì)頭強(qiáng)勁,一次性就買了幾千塊H100 GPU。其中,阿聯(lián)酋阿布扎比技術(shù)創(chuàng)新研究所開發(fā)的“獵鷹40B”模型是近期開源社區(qū)中炙手可熱的商用大模型,反映阿聯(lián)酋在增強(qiáng)基礎(chǔ)算力方面不遺余力。

在一篇業(yè)內(nèi)熱轉(zhuǎn)的《Nvidia H100 GPU:供需》文章中,作者也深度剖析了當(dāng)前科技公司們對(duì)GPU的使用情況和需求。文章推測(cè),小型和大型云提供商的大規(guī)模H100集群容量即將耗盡,H100的需求趨勢(shì)至少會(huì)持續(xù)到2024年底。

正如英偉達(dá)CEO黃仁勛說:“我們目前的出貨量遠(yuǎn)遠(yuǎn)不能滿足需求。”

英偉達(dá)GPU芯片不光不愁賣,利潤率還高得嚇人。業(yè)內(nèi)專家曾表示,英偉達(dá)H100的利潤率接近1000%。消息公布后,迅速引發(fā)了芯片戰(zhàn)場(chǎng)上的熱議。

美國金融機(jī)構(gòu)Raymond James在近期的一份報(bào)告中透露,H100芯片成本僅約3320美元,但英偉達(dá)對(duì)其客戶的批量價(jià)格仍然高達(dá)2.5萬-3萬美元,高達(dá)1000%的利潤率導(dǎo)致H100幾乎成為了有史以來“最賺錢”的一款芯片。

這一點(diǎn)從季度財(cái)報(bào)中也能得到充分印證,英偉達(dá)Q2財(cái)季凈利潤高達(dá)61.8億美元,同比上升843%。據(jù)悉,英偉達(dá)最近一個(gè)財(cái)季的調(diào)整后營業(yè)利潤率達(dá)到了58%,這是至少十年來的最高水平,并且較其之前八個(gè)財(cái)季平均39%的營業(yè)利潤率有大幅躍升。

英偉達(dá)井噴式的業(yè)績?cè)鲩L和長期展望表明,AI需求并非曇花一現(xiàn)。巨大的市場(chǎng)空間,以及超乎想象的前景,吸引諸多廠商參與其中,將進(jìn)一步刺激行業(yè)競(jìng)爭(zhēng)。

在此趨勢(shì)下,AI芯片的戰(zhàn)役正愈演愈烈。

AMD、Intel、IBM等科技巨頭以及新晉企業(yè)正陸續(xù)推出新的AI芯片,試圖與英偉達(dá)AI芯片抗衡;谷歌、微軟、亞馬遜、阿里、百度等公司也紛紛布局自研芯片,以減少對(duì)外部供應(yīng)商的依賴。

AMD:GPU市場(chǎng)的“二號(hào)玩家”

當(dāng)前的AI芯片市場(chǎng)可以說是英偉達(dá)的天下,每一位挑戰(zhàn)者想要?jiǎng)訐u其根基都并非易事。AMD作為英偉達(dá)的老對(duì)手,自然不會(huì)放任其獨(dú)攬如此龐大且增速超快的市場(chǎng)。

對(duì)于這位GPU市場(chǎng)的“二號(hào)玩家”,大家都期待其能拿出撼動(dòng)英偉達(dá)“算力霸主”地位的“終極武器”。

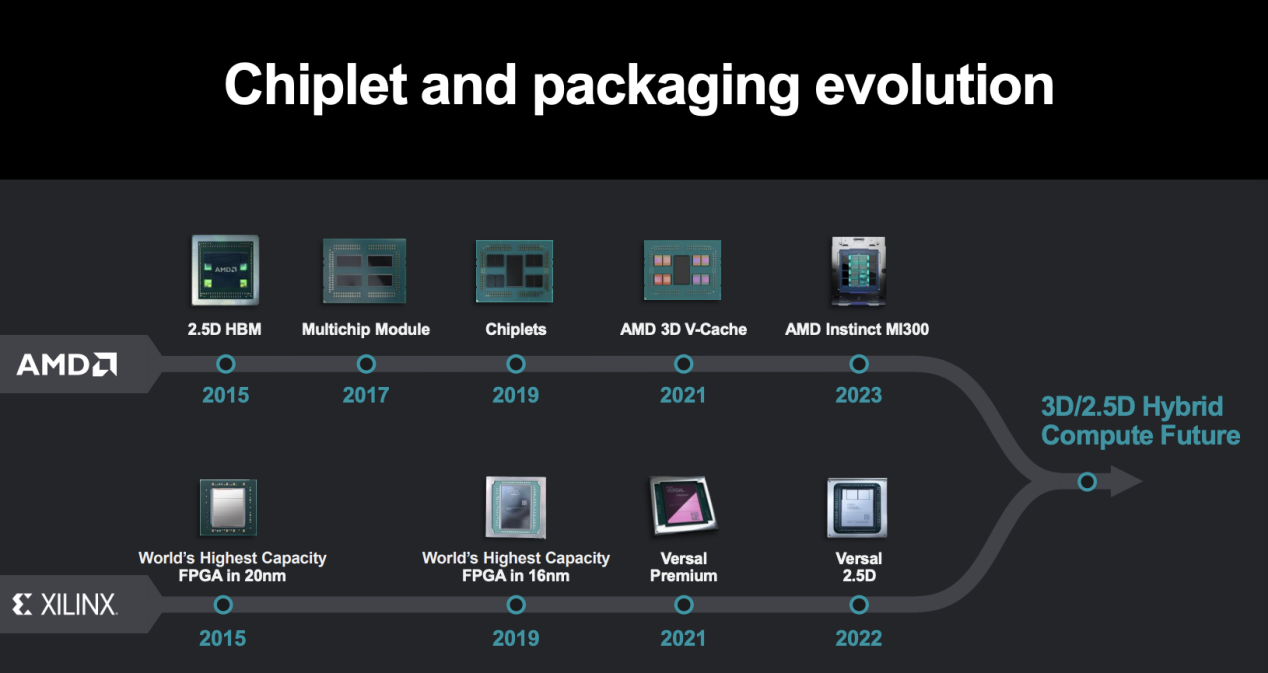

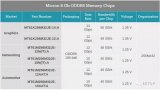

今年6月,備受業(yè)界矚目的AMD發(fā)布了Instinct MI300系列產(chǎn)品。Instinct MI300系列產(chǎn)品主要包括MI300A、MI300X兩個(gè)版本,以及集合了8個(gè)MI300X的Instinct Platform。

針對(duì)MI300A,AMD CEO蘇姿豐聲稱,這是全球首個(gè)為AI和HPC打造的APU加速卡,采用了“CPU+GPU+內(nèi)存”的一體化組合形式,擁有13個(gè)小芯片,總共包含1460億個(gè)晶體管,24個(gè)Zen 4 CPU核心,1個(gè)CDNA 3圖形引擎和128GB HBM3內(nèi)存。

Instinct MI300X是一款直接對(duì)標(biāo)英偉達(dá)H100芯片,專門面向生成式AI推出的加速器。該產(chǎn)品采用了8個(gè)GPU Chiplet加4個(gè)I/O內(nèi)存Chiplet的設(shè)計(jì),總共12個(gè)5nm Chiplet封裝在一起,使其集成的晶體管數(shù)量達(dá)到了1530億,高于英偉達(dá)H100的800億晶體管,是AMD投產(chǎn)以來最大的芯片,可以加速ChatGPT等大模型應(yīng)用。

與英偉達(dá)的H100芯片相比,AMD Instinct MI 300X的HBM密度是前者的2.4倍,帶寬則為前者的1.6倍,理論上可以運(yùn)行比H100更大的模型。

此外,AMD還發(fā)布了“AMD Instinct Platform”,集合了8個(gè)MI300X,可提供總計(jì)1.5TB的HBM3內(nèi)存。

蘇姿豐表示,隨著模型參數(shù)規(guī)模越來越大,就需要更多的GPU來運(yùn)行。而隨著AMD芯片內(nèi)存的增加,開發(fā)人員將不再需要那么多數(shù)量的GPU,能夠?yàn)橛脩艄?jié)省成本。此外,她還透露,MI300X將于今年第三季度向一些客戶提供樣品,并于第四季度量產(chǎn)。

那么,性能優(yōu)異的MI300X能否與H100一較高下呢?

有業(yè)內(nèi)專家表示,雖然本次AMD的MI300X采用了更大的192GB HBM3,但英偉達(dá)的產(chǎn)品也在迭代,等未來MI300X正式發(fā)售時(shí),英偉達(dá)可能已經(jīng)推出了參數(shù)更強(qiáng)的產(chǎn)品。而且由于AMD未公布新品價(jià)格,采用192GB HBM3的MI300X成本可能與H100相比可能不會(huì)有顯著的價(jià)格優(yōu)勢(shì)。

其次,MI300X沒有H100所擁有的用于加速Transformer大模型的引擎,這也意味著用同樣數(shù)量的MI300X將花費(fèi)更長的訓(xùn)練時(shí)間。當(dāng)前,用于AI訓(xùn)練的GPU供不應(yīng)求,價(jià)格水漲船高,MI300X的推出無疑將利于市場(chǎng)的良性競(jìng)爭(zhēng),但短期來看,AMD的MI300X可能更多是作為客戶買不到H100的“替代品”。

至頂智庫首席分析也表示,盡管從AMD本次公開的性能參數(shù)來看,MI300X在很多方面都優(yōu)于英偉達(dá)的H100,但并不是性能越高,就越多人用,這不是一個(gè)正向關(guān)系。英偉達(dá)深耕GPU領(lǐng)域多年,所擁有的市場(chǎng)認(rèn)可度和產(chǎn)品穩(wěn)定性都是AMD所不具備的。另外在軟件生態(tài)的建立和開發(fā)方面,英偉達(dá)的CUDA經(jīng)過十幾年積累已構(gòu)建其他競(jìng)爭(zhēng)對(duì)手短時(shí)間難以逾越的護(hù)城河。

雖然AMD目前也已經(jīng)擁有了一套完整的庫和工具ROCm,也能完全兼容CUDA,為AMD提供了說服客戶遷移的條件和理由,但兼容只屬權(quán)宜之計(jì),只有進(jìn)一步完善自己的生態(tài)才能形成競(jìng)爭(zhēng)優(yōu)勢(shì)。未來,ROCm需支持更多的操作系統(tǒng),在AI領(lǐng)域開拓更廣泛的框架,以此吸引更多的開發(fā)者,相較于硬件參數(shù),軟件方面的門檻和壁壘更高,AMD需要較長的時(shí)間來完善。

Cambrian-AI Research LLC首席分析師Karl Freund在《福布斯》雜志的最新報(bào)道中也指出,與英偉達(dá)的H100相比,MI300X面臨著一些挑戰(zhàn)。

一方面,英偉達(dá)H100已滿載出貨,而MI300X尚處于“襁褓之中”;其次,在AI產(chǎn)業(yè)里,英偉達(dá)具有最大的軟件生態(tài)系統(tǒng)和最多的研究人員,而AMD的軟件生態(tài)沒有那么完善。并且,AMD還未公開任何基準(zhǔn)測(cè)試,而訓(xùn)練和運(yùn)行AI大模型不僅僅取決于GPU性能,系統(tǒng)設(shè)計(jì)也尤為重要。

至于MI300X在內(nèi)存上的優(yōu)勢(shì),Karl Freund認(rèn)為,英偉達(dá)也將提供具備相同內(nèi)存規(guī)格的產(chǎn)品,因此這不會(huì)成為絕對(duì)優(yōu)勢(shì)。

綜合來看,AMD想要撼動(dòng)如日中天的英偉達(dá),并非易事。

不過,不可否認(rèn)的是,雖然短期內(nèi)英偉達(dá)的“AI王座”難以撼動(dòng),但MI300X依舊是英偉達(dá)H100的有力競(jìng)爭(zhēng)者,MI300X將成為除了英偉達(dá)H100以外的“第二選擇”。

從長遠(yuǎn)來看,對(duì)于英偉達(dá)而言,AMD也是值得警惕的競(jìng)爭(zhēng)對(duì)手。

Intel:爭(zhēng)奪AI算力市場(chǎng)寶座

眾所周知,目前GPU資源緊缺,英偉達(dá)的100系列在國內(nèi)禁售,而百模大戰(zhàn)之下算力的需求還在飆升。對(duì)于中國市場(chǎng)而言,當(dāng)前急需AI芯片“解渴”,對(duì)于英特爾而言,眼下正值算力緊缺的窗口期,也是進(jìn)攻的絕佳時(shí)機(jī)。

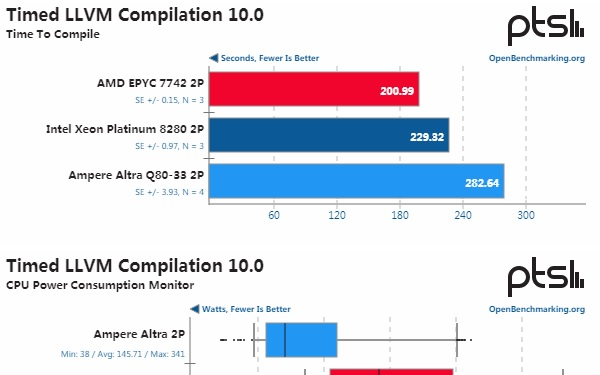

今年7月,英特爾面向中國市場(chǎng)推出了AI芯片Habana Gaudi 2,直接對(duì)標(biāo)英偉達(dá)GPU的100系列,欲爭(zhēng)奪AI算力市場(chǎng)的寶座。

在發(fā)布會(huì)現(xiàn)場(chǎng),英特爾直接將Gaudi 2和英偉達(dá)的A100進(jìn)行比較,其野心可見一斑。根據(jù)英特爾公布的數(shù)據(jù),Gaudi 2芯片是專為訓(xùn)練大語言模型而構(gòu)建,采用7nm制程,有24個(gè)張量處理器核心。從計(jì)算機(jī)視覺模型訓(xùn)練到1760億參數(shù)的BLOOMZ推理,Gaudi 2每瓦性能約A100的2倍,模型訓(xùn)練和部署的功耗降低約一半。

英特爾執(zhí)行副總裁、數(shù)據(jù)中心與人工智能事業(yè)部總經(jīng)理Sandra Rivera表示,在性能上,根據(jù)機(jī)器學(xué)習(xí)與人工智能開放產(chǎn)業(yè)聯(lián)盟ML Commons在6月底公布的AI性能基準(zhǔn)測(cè)試MLPerf Training 3.0結(jié)果顯示,Gaudi 2是除了英偉達(dá)產(chǎn)品外,唯一能把MLPerf GPT 3.0模型跑起來的芯片。

隨著大模型的日新月異,英特爾在近幾個(gè)月內(nèi)圍繞著Gaudi 2繼續(xù)進(jìn)行優(yōu)化。

據(jù)介紹,相比A100,Gaudi 2價(jià)格更有競(jìng)爭(zhēng)力,且性能更高。接下來采用FP8軟件的Gaudi 2預(yù)計(jì)能夠提供比H100更高的性價(jià)比。

事實(shí)上,去年英特爾就已經(jīng)在海外發(fā)布了Gaudi 2,此次在中國推出的是“中國特供版”。

英特爾強(qiáng)調(diào),目前在中國市場(chǎng)上,英特爾已經(jīng)和浪潮信息、新華三、超聚變等國內(nèi)主要的服務(wù)器廠商合作。Sandra Rivera表示:“中國市場(chǎng)對(duì)人工智能解決方案的需求非常強(qiáng)勁,我們正在與幾乎所有傳統(tǒng)客戶洽談。云服務(wù)提供商、通信服務(wù)提供商都是企業(yè)客戶,因此對(duì)人工智能解決方案有著強(qiáng)烈的需求。”

另一方面,在產(chǎn)品路線上,英特爾近年一直強(qiáng)調(diào)XPU,即多樣化、多組合的異構(gòu)計(jì)算。在AI相關(guān)的產(chǎn)品線上,既有集成AI加速器的CPU處理器、有GPU產(chǎn)品,以及Habana Gaudi系列代表的ASIC類型AI芯片。

大模型的火熱還在持續(xù)拉動(dòng)AI芯片的需求。

據(jù)了解,英特爾的Gaudi 2處理器自7月份推出以來銷量一直強(qiáng)勁,英特爾首席財(cái)務(wù)官David Zinsner在早些時(shí)候的一次會(huì)議上表示,已經(jīng)看到越來越多的客戶尋求其Gaudi芯片作為供應(yīng)短缺的處理器的替代品。

Gaudi是一個(gè)人工智能加速的專屬產(chǎn)品。在英特爾產(chǎn)品里,Gaudi是針對(duì)大模型工作負(fù)載中性能最佳、最優(yōu)的一個(gè)產(chǎn)品。據(jù)Sandra Rivera表示:“明年我們還會(huì)有下一代產(chǎn)品Gaudi 3發(fā)布。在2025年的時(shí)候,我們會(huì)把Gaudi的AI芯片跟GPU路線圖合二為一,推出一個(gè)更整合的GPU的產(chǎn)品。”

日前,英特爾在舊金山舉行的“Intel Innovation”盛會(huì)上透露,下一代使用5nm工藝打造的Gaudi 3將在性能方面大幅提升。其中,BF16下的性能提升了四倍、計(jì)算能力提升了2倍、網(wǎng)絡(luò)帶寬的1.5倍以及HBM容量的提升1.5倍。

展望未來,在Gaudi 3之后, 英特爾計(jì)劃推出一個(gè)代號(hào)為Falcon Shores 的繼任者。

關(guān)于Falcon Shores,英特爾沒有披露太多細(xì)節(jié)。但按照其最初規(guī)劃,英特爾會(huì)于2024 年推出Falcon Shores芯片、原計(jì)劃為“XPU”設(shè)計(jì),即集成CPU和GPU。但在上個(gè)月的財(cái)報(bào)會(huì)上,英特爾調(diào)整了Falcon Shores的計(jì)劃,并隨后將其重新定位為獨(dú)立GPU,并將于2025年發(fā)布。

整體來看,Gaudi系列作為英特爾AI的一艘旗艦,外界也拭目以待Gaudi 2在實(shí)際應(yīng)用中的性能表現(xiàn)和算力實(shí)力。從硬件迭代到軟件生態(tài),AI芯片的競(jìng)爭(zhēng)故事還將繼續(xù)。

IBM:模擬AI芯片,引領(lǐng)行業(yè)趨勢(shì)

人工智能的未來需要能源效率方面的新創(chuàng)新,從模型的設(shè)計(jì)方式到運(yùn)行模型的硬件。

IBM最近公布了一款新的模擬AI芯片,據(jù)稱其能效比當(dāng)前業(yè)界領(lǐng)先的英偉達(dá)H100高出14倍,這款新芯片旨在解決生成式人工智能的主要問題之一:高能耗。這意味著在相同的能量消耗下,它能夠完成更多的計(jì)算任務(wù)。

這對(duì)于大型模型的運(yùn)行來說尤為重要,因?yàn)檫@些大型模型通常需要更多的能量來運(yùn)行。IBM的這款新芯片有望緩解生成式AI平臺(tái)企業(yè)的壓力,并可能在未來取代英偉達(dá)成為生成式AI平臺(tái)的主導(dǎo)力量。

這是由于模擬芯片的構(gòu)建方式造成的。這些組件與數(shù)字芯片的不同之處在于,數(shù)字芯片可以操縱模擬信號(hào)并理解0和1之間的灰度。數(shù)字芯片在當(dāng)今時(shí)代應(yīng)用最廣泛,但它們只能處理不同的二進(jìn)制信號(hào),在功能、信號(hào)處理和應(yīng)用領(lǐng)域也存在差異。

IBM聲稱其14nm模擬AI芯片每個(gè)組件可以編碼3500萬個(gè)相變存儲(chǔ)設(shè)備,可以建模多達(dá)1700萬個(gè)參數(shù)。同時(shí),該芯片模仿了人腦的運(yùn)作方式,微芯片直接在內(nèi)存中執(zhí)行計(jì)算,適用于節(jié)能語音識(shí)別和轉(zhuǎn)錄。

IBM在多個(gè)實(shí)驗(yàn)中展示了使用這種芯片的優(yōu)點(diǎn),其中一個(gè)系統(tǒng)能夠以非常接近數(shù)字硬件設(shè)置的準(zhǔn)確度轉(zhuǎn)錄人們說話的音頻。此外,語音識(shí)別速度也得到了顯著提升,提高了7倍。這對(duì)于許多需要實(shí)時(shí)響應(yīng)的應(yīng)用場(chǎng)景,如語音助手和智能音箱等,將帶來更加順暢的用戶體驗(yàn)。

IBM這款模擬AI芯片的發(fā)布,標(biāo)志著模擬芯片成為人工智能領(lǐng)域的新趨勢(shì)。通過集成大量的相變存儲(chǔ)單元,該芯片能夠?qū)崿F(xiàn)更高效的計(jì)算和能效。隨著技術(shù)的不斷發(fā)展,預(yù)計(jì)未來模擬芯片有望成為人工智能領(lǐng)域的新趨勢(shì),成為推動(dòng)人工智能技術(shù)發(fā)展的核心驅(qū)動(dòng)力。

總之,IBM的新型模擬AI芯片有望為生成式AI領(lǐng)域帶來重大突破。英偉達(dá)GPU芯片是為當(dāng)今許多生成式AI平臺(tái)提供動(dòng)力的組件。如果IBM迭代該原型并為大眾市場(chǎng)做好準(zhǔn)備,它很可能有一天會(huì)取代英偉達(dá)的芯片成為當(dāng)前的中流砥柱。

SambaNova:新型AI芯片,挑戰(zhàn)英偉達(dá)

高端GPU持續(xù)缺貨之下,一家要挑戰(zhàn)英偉達(dá)的芯片初創(chuàng)公司成為行業(yè)熱議焦點(diǎn)。

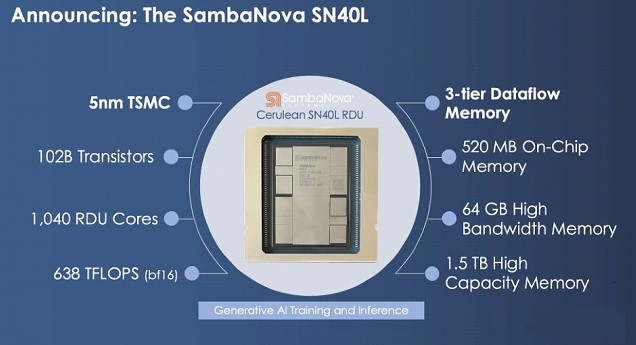

這家獨(dú)角獸企業(yè)SambaNova剛發(fā)布的新型AI芯片SN40L,該芯片由臺(tái)積電5nm工藝制造,包含1020億晶體管,峰值速度638TeraFLOPS,高達(dá)1.5T的內(nèi)存,支持25.6萬個(gè)token的序列長度。

與主要競(jìng)品相比,英偉達(dá)H100最高擁有80GB HBM3內(nèi)存,AMD MI300擁有192GB HBM3內(nèi)存。SN40L的高帶寬HBM3內(nèi)存實(shí)際比前兩者小,更多依靠大容量DRAM。

SambaNova?CEO?Rodrigo Liang表示,雖然DRAM速度更慢,但專用的軟件編譯器可以智能地分配三個(gè)內(nèi)存層之間的負(fù)載,還允許編譯器將8個(gè)芯片視為單個(gè)系統(tǒng)。

除了硬件指標(biāo),SN40L針對(duì)大模型做的優(yōu)化還有同時(shí)提供密集和稀疏計(jì)算加速。

Gartner分析師認(rèn)為,SN40L的一個(gè)可能優(yōu)勢(shì)在于多模態(tài)AI。GPU的架構(gòu)非常嚴(yán)格,面對(duì)圖像、視頻、文本等多樣數(shù)據(jù)時(shí)可能不夠靈活,而SambaNova可以調(diào)整硬件來滿足工作負(fù)載的要求。

相比其他芯片供應(yīng)商,SambaNova業(yè)務(wù)模式也比較特別,芯片不單賣,而是出售其定制技術(shù)堆棧,從芯片到服務(wù)器系統(tǒng),甚至包括部署大模型。

Rodrigo Liang指出,當(dāng)前行業(yè)標(biāo)準(zhǔn)做法下運(yùn)行萬億參數(shù)大模型需要數(shù)百枚芯片,我們的方法使總擁有成本只有標(biāo)準(zhǔn)方法的1/25。

根據(jù)Rodrigo Liang的說法,8個(gè)SN40L組成的集群總共可處理5萬億參數(shù),相當(dāng)于70個(gè)700億參數(shù)大模型。全球2000強(qiáng)的企業(yè)只需購買兩個(gè)這樣的8芯片集群,就能滿足所有大模型需求。

目前,SambaNova的芯片和系統(tǒng)已獲得不少大型客戶,包括世界排名前列的超算實(shí)驗(yàn)室,日本富岳、美國阿貢國家實(shí)驗(yàn)室、勞倫斯國家實(shí)驗(yàn)室,以及咨詢公司埃森哲等。

云服務(wù)商自研AI芯片,擺脫英偉達(dá)

當(dāng)下,英偉達(dá)還是當(dāng)之無愧的“AI算力王者”,A100、H100系列芯片占據(jù)金字塔頂尖位置,是ChatGPT這樣的大型語言模型背后的動(dòng)力來源。

然而,不管是為了降低成本,還是減少對(duì)英偉達(dá)的依賴、提高議價(jià)能力,包括谷歌、亞馬遜、微軟、特斯拉、Meta、百度、阿里等在內(nèi)的科技巨頭們也都紛紛下場(chǎng)自研AI芯片。

以微軟、谷歌、亞馬遜三巨頭為例來看,據(jù)不完全統(tǒng)計(jì),這3家公司已經(jīng)推出或計(jì)劃發(fā)布了8款服務(wù)器和AI芯片。

在這場(chǎng)AI芯片競(jìng)賽中,亞馬遜似乎占據(jù)了先機(jī),已擁有兩款A(yù)I專用芯片——訓(xùn)練芯片Trainium和推理芯片Inferentia。2023年初,專為人工智能打造的Inferentia 2發(fā)布,將計(jì)算性能提高了三倍,加速器總內(nèi)存提高了四分之一,吞吐量提高了四分之一,延遲提高了十分之一。Inf2實(shí)例最多可支持1750億個(gè)參數(shù),這使其成為大規(guī)模模型推理的有力競(jìng)爭(zhēng)者。

而早在2013年,谷歌就已秘密研發(fā)一款專注于AI機(jī)器學(xué)習(xí)算法的芯片,并將其用在內(nèi)部的云計(jì)算數(shù)據(jù)中心中,以取代英偉達(dá)的GPU。2016年5月,這款自研芯片公諸于世,即TPU。

2020年,谷歌實(shí)際上已在其數(shù)據(jù)中心部署了人工智能芯片TPU v4。不過直到今年4月4日,谷歌才首次公開了技術(shù)細(xì)節(jié):相比TPU v3,TPU v4性能提升2.1倍。基于TPU v4的超級(jí)計(jì)算機(jī)擁有4096塊芯片,整體速度提高了約10倍。谷歌稱,對(duì)于類似大小的系統(tǒng),谷歌能做到比Graphcore IPU Bow快4.3-4.5倍,比英偉達(dá)A100快1.2-1.7倍,功耗低1.3-1.9倍。

目前,谷歌已將負(fù)責(zé)AI芯片的工程團(tuán)隊(duì)轉(zhuǎn)移到了谷歌云,旨在提高谷歌云出售AI芯片給租用其服務(wù)器的公司的能力,從而與更大的競(jìng)爭(zhēng)對(duì)手微軟和亞馬遜云科技相抗衡。雖然英偉達(dá)提供的GPU算力優(yōu)勢(shì)在前,但引爆本次AI的兩位“大拿”O(jiān)penAI、Midjourney的算力系統(tǒng)采購的并非英偉達(dá)的GPU,而是用了谷歌的方案。

相比之下,微軟在更大程度上依賴于英偉達(dá)、AMD和英特爾等芯片制造商的現(xiàn)成或定制硬件。

不過,據(jù)The Information報(bào)道,微軟也正在計(jì)劃推出自己的人工智能芯片。

了解該項(xiàng)目的知情人士稱,微軟早在2019年就開始在內(nèi)部開發(fā)代號(hào)為“雅典娜”的芯片,這些芯片已經(jīng)提供給一小批微軟和OpenAI員工,他們已經(jīng)在測(cè)試這項(xiàng)技術(shù)。微軟希望這款芯片的性能比其斥資數(shù)億美元從其他供應(yīng)商側(cè)購置的芯片性能更優(yōu),這樣就可以為價(jià)值高昂的人工智能工作節(jié)省成本。

據(jù)悉,這些芯片是為訓(xùn)練大語言模型等軟件而設(shè)計(jì),同時(shí)可支持推理,能為ChatGPT背后的所有AI軟件提供動(dòng)力。另據(jù)一位知情人士透露,微軟的AI芯片規(guī)劃中囊括了雅典娜芯片的未來幾代產(chǎn)品,最初的雅典娜芯片都將基于5nm工藝生產(chǎn),可能在明年進(jìn)入大規(guī)模生產(chǎn)階段。

今年5月,微軟還發(fā)布了一系列芯片相關(guān)招聘信息,正在為AISoC(人工智能芯片及解決方案)團(tuán)隊(duì)尋找一名首席設(shè)計(jì)工程師。據(jù)稱,該團(tuán)隊(duì)正在研究“能夠以極其高效的方式執(zhí)行復(fù)雜和高性能功能的尖端人工智能設(shè)計(jì)”。換句話說,微軟某種程度上已把自己的未來寄托在人工智能開發(fā)機(jī)構(gòu)OpenAI的一系列技術(shù)上,想要制造出比現(xiàn)成的GPU和相關(guān)加速器更高效的芯片來運(yùn)行這些模型。

與此同時(shí),Meta公司披露其正在構(gòu)建首款專門用于運(yùn)行AI模型的定制芯片——MTIA芯片,使用名為RISC-V的開源芯片架構(gòu),預(yù)計(jì)于2025年問世。

另一邊,隨著美國對(duì)高性能芯片出口限制措施不斷加強(qiáng),英偉達(dá)A100、H100被限售,A800、H800嚴(yán)重缺貨,國產(chǎn)AI芯片肩負(fù)起填補(bǔ)市場(chǎng)空缺的重要使命。

目前,包括華為、阿里、百度昆侖芯、壁仞科技、寒武紀(jì)、天數(shù)智芯、瀚博半導(dǎo)體等也在GPU賽道發(fā)力,取得一定成績。不過需要重視的是,盡管國產(chǎn)GPU在價(jià)格方面有一定優(yōu)勢(shì),但在算力和生態(tài)方面,仍然與英偉達(dá)存在差距。

整體來看,當(dāng)英偉達(dá)的一些主要客戶開始自己開發(fā)AI芯片,無疑會(huì)讓英偉達(dá)面臨更為激烈的競(jìng)爭(zhēng)。

根據(jù)TrendForce集邦咨詢數(shù)據(jù)顯示,目前主要由搭載英偉達(dá) A100、H100、AMD MI300,以及大型CSP業(yè)者如Google、AWS等自主研發(fā)ASIC的AI服務(wù)器成長需求較為強(qiáng)勁,2023年AI服務(wù)器出貨量出貨量預(yù)估近120萬臺(tái),年增率近38%,AI芯片出貨量同步看漲,可望成長突破五成。

在市場(chǎng)的巨大需求下,上述一眾廠商的謀劃明顯是奔著跟英偉達(dá)搶生意而來。而面對(duì)行業(yè)“圍剿”的同時(shí),摩根士丹利分析師也給英偉達(dá)貼上了“泡沫”的標(biāo)簽。

很多人或許認(rèn)為,英偉達(dá)借力AI熱潮過得風(fēng)生水起是個(gè)新現(xiàn)象,但實(shí)際上這醞釀已久。英偉達(dá)在ChatGPT面世十年前就定下了AI戰(zhàn)略,據(jù)標(biāo)普全球市場(chǎng)財(cái)智匯編的記錄,英偉達(dá)早在2006年就開始向投資者宣傳旗下為AI開發(fā)人員所用的CUDA編程語言。

英偉達(dá)的AI戰(zhàn)略具有長期性和前瞻性,只是如今隨著AI技術(shù)的崛起,那顆在十幾年前射出的子彈,在今天擊中英偉達(dá)眉心。

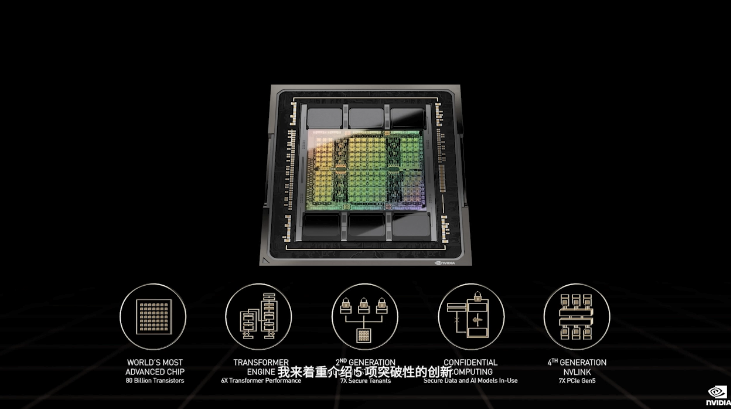

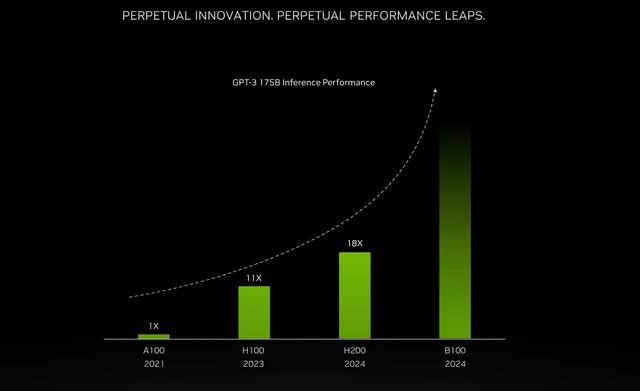

當(dāng)然,在市場(chǎng)中眾多企業(yè)的追趕下,英偉達(dá)也并沒有停下自己的腳步。今年8月,在洛杉磯的SIGGRAPH大會(huì)上,英偉達(dá)拿出了最新一代依托于搭載首款HBM3e處理器的GH200 Grace Hopper超級(jí)芯片平臺(tái),證明這股AI熱并非搖搖欲墜的空中樓閣。

與當(dāng)前一代產(chǎn)品相比,最新版本的GH200超級(jí)芯片內(nèi)存容量增加了3.5倍,帶寬增加了3倍;相比最熱門的H100芯片,其內(nèi)存增加1.7倍,傳輸頻寬增加1.5倍。

可見,除了現(xiàn)有A100、H100等熱門產(chǎn)品出貨持續(xù)維持增長以外,英偉達(dá)也在持續(xù)發(fā)布多項(xiàng)用于AI和數(shù)據(jù)中心的新產(chǎn)品,以進(jìn)一步鞏固自身在AI領(lǐng)域的話語權(quán)和統(tǒng)治力。

雖然隨著時(shí)間的推移,英偉達(dá)可能會(huì)面臨比現(xiàn)在更激烈的競(jìng)爭(zhēng)。

但從當(dāng)前進(jìn)程來看,英偉達(dá)和黃仁勛讓算力=GPU=英偉達(dá)的“理念”植入人心,而這么廣闊的市場(chǎng),竟然真的幾乎只有英偉達(dá)一家公司一家獨(dú)大,英偉達(dá)的業(yè)績一路狂飆、英偉達(dá)在芯片領(lǐng)域的統(tǒng)治力,目前尚看不到盡頭。

雖然這種狂飆不太可能永遠(yuǎn)持續(xù)下去,但英偉達(dá)給出的信號(hào)強(qiáng)烈暗示,其進(jìn)程遠(yuǎn)未結(jié)束,AI狂飆才剛開始。

編輯:黃飛

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論