在我們(指代servethehome)撰寫本文時,NVIDIA H100 80GB PCIe 在 CDW 等在線零售商處的售價為 3.2 萬美元,并且缺貨了大約六個月。可以理解的是,NVIDIA 的高端(幾乎)萬能 GPU 的價格非常高,需求也是如此。NVIDIA 為許多人工智能用戶和那些在企業中運行混合工作負載的用戶提供了一種替代方案,但這種方案并不引人注目,但這是非常好的。NVIDIA L40S 是面向圖形的 L40 的變體,它正迅速成為人工智能領域最保守的秘密。讓我們深入了解原因。

NVIDIA A100、NVIDIA L40S 和 NVIDIA H100

首先,我們首先要說的是,如果您現在想要訓練基礎模型(例如 ChatGPT),那么 NVIDIA H100 80GB SXM5 仍然是首選 GPU。一旦基礎模型經過訓練,通常可以在成本和功耗顯著降低的部件上根據特定領域的數據或推理來定制模型。

NVIDIA H100

目前,用于高端推理的 GPU 主要有三種:NVIDIA A100、NVIDIA H100 和新的 NVIDIA L40S。我們將跳過NVIDIA L4 24GB,因為它更像是低端推理卡。

NVIDIA H100 L40S A100 堆棧頂部

NVIDIA A100 和 H100 型號基于該公司各自代的旗艦 GPU。由于我們討論的是 PCIe 而不是 SXM 模塊,因此外形尺寸之間兩個最顯著的差異是 NVLink 和功耗。SXM 模塊專為更高功耗而設計(大約是 PCIe 版本的兩倍),并通過 NVLink 和多 GPU 組件中的 NVSwitch 拓撲進行互連。

NVIDIA A100 PCIe于 2020 年以 40GB 型號推出,然后在 2021 年中期,該公司將產品更新為A100 80GB PCIe 附加卡。多年后,這些卡仍然很受歡迎。

NVIDIA A100 80GB PCIe

NVIDIA H100 PCIe是專為主流服務器設計的低功耗 H100。考慮 PCIe 卡的一種方法是,在電壓/頻率曲線的不同部分運行相似數量的芯片,旨在降低性能,但功耗也低得多。

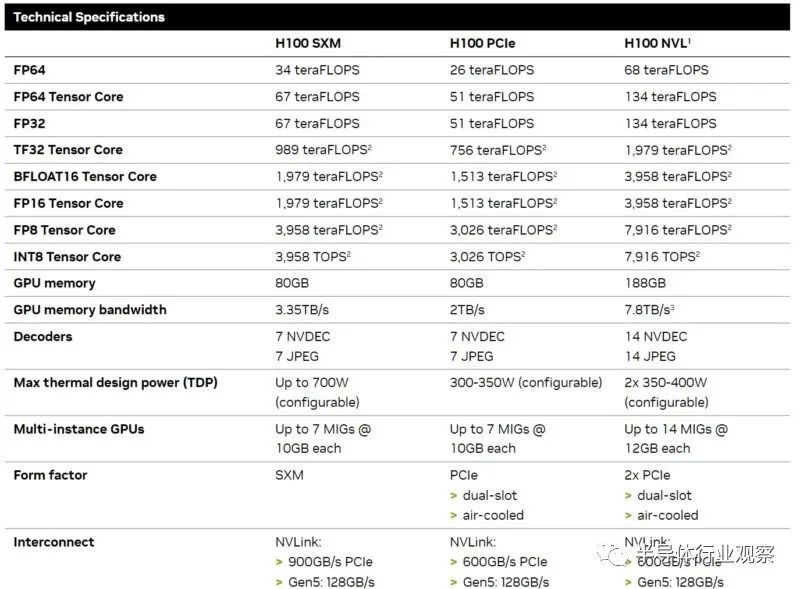

NVIDIA H100 型號和 NVLink

即使在 H100 系列內也存在一些差異。NVIDIA H100 PCIe 仍然是 H100,但在 PCIe 外形規格中,它降低了性能、功耗和一些互連(例如 NVLink 速度)。

L40S 則完全不同。NVIDIA 采用了基礎 L40(一款使用 NVIDIA 最新 Ada Lovelace 架構的數據中心可視化 GPU),并更改了調整,使其更多地針對 AI 而不是可視化進行調整。

NVIDIA L40S 是一款令人著迷的 GPU,因為它保留了 L40 的光線追蹤核心和 DisplayPort 輸出以及支持 AV1 的 NVENC / NVDEC 等功能。與此同時,NVIDIA 將更多的功率用于驅動 GPU 人工智能部分的時鐘。

NVIDIA L40S 4x DisplayPort

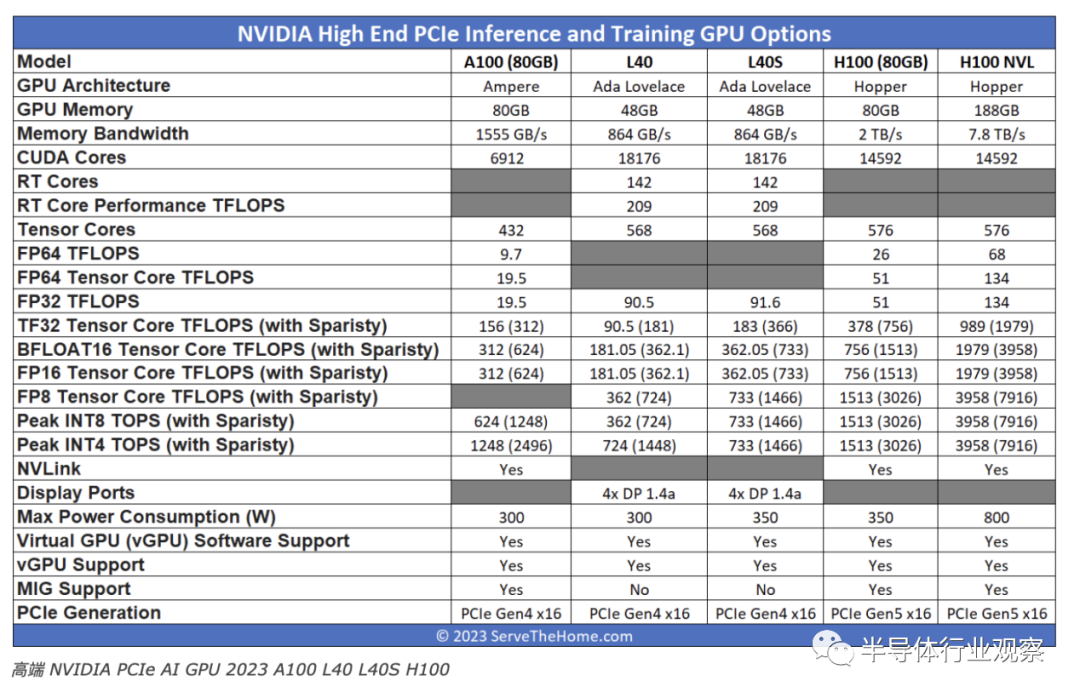

我們將其放在圖表上以便更容易可視化。NVIDIA 的規格有時甚至會根據 NVIDIA 來源單一視圖而有所不同,因此這是我們能找到的最好的規格,如果我們獲得規格更新,我們將對其進行更新。我們還包括雙卡H100 NVL,它有兩個增強型 H100,它們之間有一個 NVLink 橋,因此將其視為雙卡解決方案,而其余的都是單卡。

這里有幾點值得關注:

與 L40 相比,L40S 是一款在人工智能訓練和推理方面大幅改進的卡,但人們可以很容易地看到共同的傳統。

如果您需要絕對的內存容量、帶寬或 FP64 性能,則 L40 和 L40S 不適合。鑒于目前 AI 工作負載取代傳統 FP64 計算的相對份額,大多數人都會接受這種權衡。

L40S 的內存看起來可能比 NVIDIA A100 少得多,而且物理上確實如此,但這并不是故事的全部。NVIDIA L40S 支持NVIDIA Transformer Engine和 FP8。使用 FP8 可以極大地減小數據大小,因此,與 FP16 值相比,FP8 值可以使用更少的內存,并且需要更少的內存帶寬來移動。NVIDIA 正在推動 Transformer Engine,因為 H100 也支持它,有助于降低其 AI 部件的成本或提高其性能。

L40S 有一組更注重可視化的視頻編碼/解碼,而 H100 則專注于解碼方面。

NVIDIA H100 速度更快。它還花費更多。從某種意義上說,在我們撰寫本文時,在列出公開價格的 CDW 上,H100 的價格約為 L40S 價格的 2.6 倍。

另一個重要問題是可用性。如今,獲得 NVIDIA L40S 比排隊等待 NVIDIA H100 快得多。

秘密在于,在 AI 硬件方面取得領先的一種新的常見方法是不使用 H100 進行模型定制和推理。相反,我們又回到了我們多年前介紹過的熟悉的架構,即密集 PCIe 服務器。2017 年,當我們進行DeepLearning11 時,將 NVIDIA GeForce GTX 1080 Ti 塞進服務器中的 10 倍 NVIDIA GTX 1080 Ti 單根深度學習服務器甚至是大公司(例如世界某些地區的搜索/網絡超大規模企業)的首選架構駕駛公司。

NVIDIA 更改了其 EULA,禁止此類配置,并且使其軟件更加關注用于 AI 推理和訓練的數據中心部分,因此現在情況有所不同。

到 2023 年,考慮同樣的概念,但采用 NVIDIA L40S 技術(并且沒有服務器“humping”。)

通過購買 L40S 服務器并獲得比使用 H100 更低成本的 GPU,人們可以獲得類似的性能,而且價格可能更低。

NVIDIA L40S 與 H100 的其他考慮因素

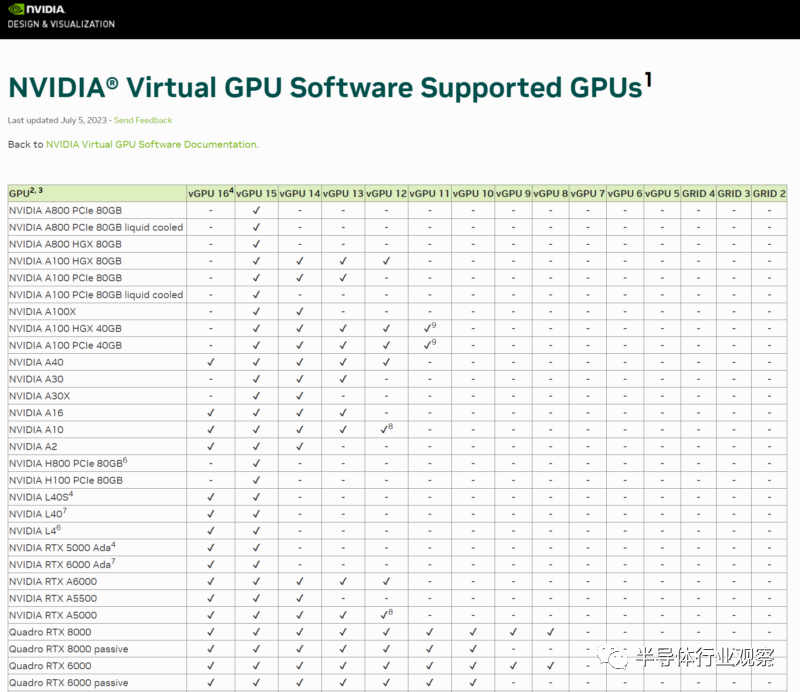

L40S 還有其他幾個方面需要考慮。一是它支持NVIDIA Virtual GPU vGPU 16.1,而 H100 仍然只支持 vGPU 15。NVIDIA 正在將其 AI 芯片從 vGPU 支持方面進行一些拆分。

對于那些想要部署一種 GPU 機器然后能夠運行不同類型的工作負載的人來說,像 L40S 這樣的東西是有意義的。鑒于其可視化根源,它還擁有支持 AV1 和 RT 內核的 NVIDIA 視頻編碼引擎。

L40S 不支持一項功能,那就是 MIG。我們之前已經研究過 MIG,但它允許將 H100 分成最多 7 個不同大小的分區。這對于在公共云中拆分 H100 GPU 非常有用,以便可以在客戶之間共享 GPU 資源。對于企業來說,這通常是一個較低興奮度的功能。

此外,部署 L40S 的功耗較低,僅為 SXM5 系統功耗的一半。這對于那些想要橫向擴展但每個機架可能沒有大量電力預算的人來說非常有吸引力。

最重要的是,L40S 的速度不如 H100,但憑借 NVIDIA 的 FP8 和 Transformer Engine 支持,對于許多人來說,它比 H100 更可用、更容易部署,而且通常價格更低。

最后的話

關于 NVIDIA H100 PCIe 與 L40S 以及為什么人們會使用任一版本,目前有很多非常糟糕的信息。希望這有助于在更大程度上澄清這一點。對我們來說,L40S 并不便宜,但它讓我們想起 6 多年前,當時人工智能領域的做法是在服務器中使用成本較低的 NVIDIA GPU,然后使用更多的 GPU。NVIDIA 再次推出該型號,使用 L40S 和官方認可的架構,支持多達數千個 GPU。

-

NVIDIA

+關注

關注

14文章

5227瀏覽量

105688 -

gpu

+關注

關注

28文章

4904瀏覽量

130591 -

PCIe

+關注

關注

16文章

1312瀏覽量

84602

原文標題:英偉達H100的最強替代者

文章出處:【微信號:WW_CGQJS,微信公眾號:傳感器技術】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

GPU 維修干貨 | 英偉達 GPU H100 常見故障有哪些?

特朗普要叫停英偉達對華特供版 英偉達H20出口限制 或損失55億美元

軟銀攜手英偉達打造日本最強AI超算

英偉達H100芯片市場降溫

亞馬遜云科技宣布Amazon EC2 P5e實例正式可用 由英偉達H200 GPU提供支持

英偉達或取消B100轉用B200A代替

英偉達帶領芯片股飆升 英偉達大漲4.76%

英偉達在AI芯片市場還能領先多久?

英偉達H20 AI芯片:中國市場新動向與業績預期

英偉達H200芯片將大規模交付

馬斯克自曝訓練Grok 3用了10萬塊NVIDIA H100

首批1024塊H100 GPU,正崴集團將建中國臺灣最大AI計算中心

今日看點丨國家大基金三期成立,注冊資本3440億;英偉達被爆降價,業內人士:H20降價很正常

英偉達H100的最強替代者

英偉達H100的最強替代者

評論