摘要:最近, 深度學習三杰獲得了計算機界最重要的圖靈獎, 它們的貢獻都集中在對深度學習的根據神經網絡的理論突破。今天我們看到的所有和人工智能有關的偉大成就, 從阿法狗到自動駕駛, 從海量人臉識別到對話機器人, 都可以歸功于人工神經網絡的迅速崛起。那么對于不了解神經網絡的同學如何入門? 神經網絡的技術為什么偉大, 又是什么讓它們這么多年才姍姍走來? 我們一一拆解開來。

一 引入

我們說人工智能經歷了若干階段, 從規則主導的計算模型到統計機器學習。傳統統計機器學習不乏極為強大的算法, 從各種高級的線性回歸,SVM到決策樹隨機森林,它們的共同特點是把人類的學習過程直接轉化為算法。 但是沿著直接模擬人類學習和思維的路線, 我們是否可以走向人工智能的終極大廈呢?

答案是否定的。 基于統計, 模擬人類思維的機器學習模型, 最典型的是決策樹, 而即使決策樹, 最多能夠提取的無非是一種數據特征之間的樹形邏輯關系。 但是顯然我們人的功能, 很多并不是基于這種非常形式化的邏輯。 比如你一看到一個人, 就記住了他的面孔。 比如你有情感, 在你憤怒和恐懼的時候擊退敵人。 比如你一不小心產生了靈感, 下了一手妙棋或者畫出一幅名畫。 這些顯然都與決策樹那種非常機械的邏輯相差甚遠。

人類的智慧根據, 是從感知, 到直覺, 到創造力的一系列很難轉化為程序的過程。 那我們如何才能真正模擬人類的智能? 我們回到人的組成人的智能本身最重要的材料。 大腦。

如果說統計機器學習的故事是一個模擬人類思維的過程, 那么神經網絡的故事就是一個信息加工和處理的故事, 我們的思維將一步步接近造物, 接近 - “信息”, 這個一切認知和智能的本源。 看它該如何流動, 才能產生人的思維。

二 神經元

生物神經元

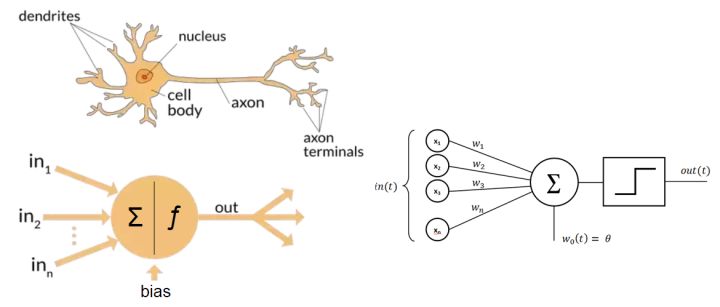

首先, 神經網絡的靈感來自生物神經網絡。 那么生物神經網絡是怎么組成的? 神經元。 神經元的基本結構是樹突, 胞體和軸突(如上圖)。這樣一個結構,就像因特網上的一臺電腦,它有一部接受器-樹突,每一個樹突的頂端是一個叫突出的結構,上面布滿各種各樣的傳感器(離子通道),接受外界物理信號,或其它“電腦”給它發來的脈沖,一部發射器,軸突,則以化學遞質的形式放出自身的信號。只不過樹突和軸突是有形的生物組織, 他們象樹枝,根須一般延伸出去,不停的探知外界的情況并調整自己。

神經元模型

我們把生物神經元進行數學抽象, 就得到人工神經元。如何抽取它的靈魂? 簡單的說, 每一個神經元扮演的角色就是一個收集+傳話者。樹突不停的收集外部的信號,大部分是其它細胞傳遞進來的信號,也有物理信號, 比如光。 然后把各種各樣的信號轉化成胞體上的電位, 如果胞體電位大于一個閾值, 它就開始向其它細胞傳遞信號。 這個過程非常像爆發。 要不是沉默, 要不就瘋狂的對外喊話。

我們說, 一個神經細胞就是一個最小的認知單元, 何為認知單元, 就是把一定的數據組成起來,對它做出一個判斷, 我們可以給它看成一個具有偏好的探測器。 聯系機器學習, 就是分類器,不停的對外界數據進行處理。為什么要做分類? 因為正確的分類, 是認知的基礎, 也是決策的基礎。 因為認識任何概念, 往往都是離散的分類問題, 比如色彩, 物體的形狀等等。因此, 神經細胞做的事情, 就像是模數轉化, 把連續的信號轉化成離散的樣子。

突觸:生物神經元對話的媒介, 信號在這里實現轉化

如果說把神經元看成這樣一個信息轉化的函數, 那么生物神經元的這副樣子,使它能夠極好的調節這個函數。 信號的收集者樹突, 可以向外界生長決定探測哪些信號, 然后通過一個叫離子通道的東西收集信號,每個樹突上這種通道的數量不一樣。 有的多一點, 有的少一點, 而且是可以調控的。 這個調控的東西, 就是對外界信號的敏感度。 這樣的結構, 可以說得到了最大的對外界信息的選擇性。

什么是外界信號? 這里我們用上次課將的一個東西替代, 特征, 如果把一切看作樹, 神經元在不停觀測外界, 每個樹突都在收集某個特征。而這個離子通道的數量, 就是線性回歸里面的那個權重。

它在干什么事情呢? 收集特征, 作為決策證據! 當某些信息積累到一定地步, 它就可以做決策了, 如果把這個功能進一步簡化, 我們就可以把這個決策過程描述成以單純的閾值函數, 要么就干, 否則就不干。 就這么簡單的。

從生物神經元到數學神經元

神經細胞與晶體管和計算機的根本區別在于可塑性。或者更準確的說具有學習能力。從機器學習的角度看, 它實現的是一個可以學習的分類器,就和我們上次課講的一樣, 具有自己調整權重的能力, 也就是調整這個w1和w2.

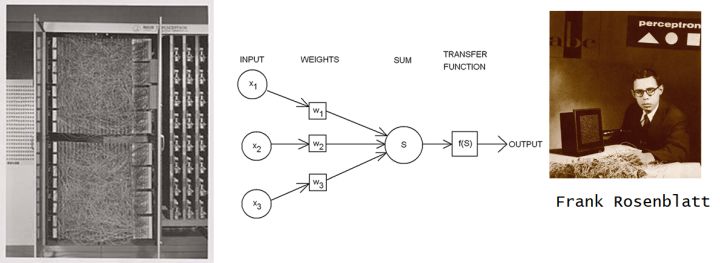

我們這個簡化出來的模型,正是所有人工神經網絡的祖母-感知機。從名字可以看出,人們設計這個模型的最初目的就是像讓它像真實的生物神經元一樣,做出感知和判斷。并且從數據中學習。

感知機算是最早的把連接主義引入機器學習的嘗試。它直接模擬Warren McCulloch 和 Walter Pitts 在1943 提出而來神經元的模型, 它的創始人 Rosenblatt 事實上制造了一臺硬件裝置的跟神經元器件裝置。

把數學神經元變成機器

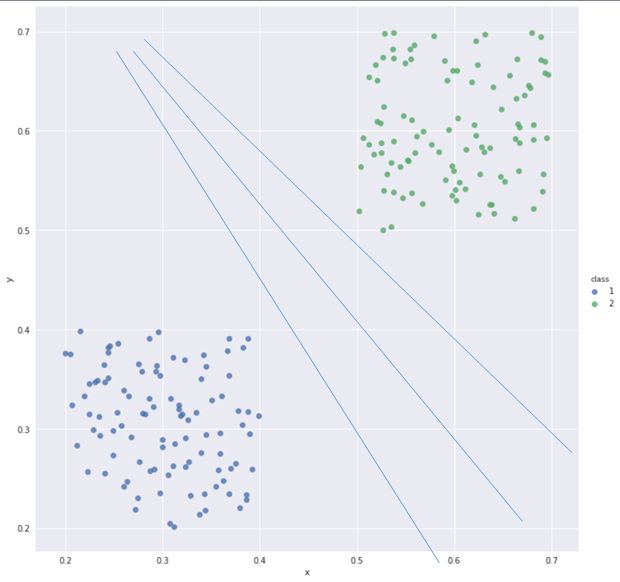

你要是想理解這個過程。最好的方法是幾何法。你仔細觀察, 這個感知機的方程, 如果只有兩個特征的時候, 描述的就是一個x1和x2坐標的平面, 中間有一條直線w1x1+w2x2=0,直線的左邊是一類, 右邊是二類 。感知機的學習過程就是調整這條分類直線的位置,我們測量錯分點到這條線的距離之和,調整線的位置, 直到兩個類的點乖乖分布到直線兩邊,我們就實現了分類過程。

一個神經元相當于一個分類器

這其實就是一個神經元的偏好。 比你讓一個神經元幫你確定是否去看電影的例子。它根據今天的溫度,一個是電影的長度來判斷, 當然一開始它不了解你, 但是它可以先幫你做做決策, 然后根據你每次給他的反饋意見它調整自己,如果你注重溫度,它就加大溫度的權重,總之找到你看重的東西, 這就是感知機訓練的方法白話版, 如果你給他肯定意見,他就不做改變, 你不滿意, 他就變一變。

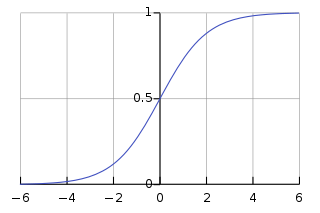

最初的感知機采用閾值函數作為神經元的決策(激活)函數。后來這個函數逐步被調整為sigmoid函數。表現上看, 這個函數把閾值函數進行了軟化, 事實上, 它使得我們不是僅僅能夠表達非黑即白的邏輯, 而是一個連續變化的概率。 而這個函數的擴展softmax則可以幫助我們實現多個分類的選擇。

sigmoid 函數

我們說, 這一類模型開始被人們寄托重大希望, 不久卻落空。原因在于, 它真是太簡單了。 在幾何上, 無論怎么變它都只是一個線性的模型。 而事實上, 這個世界卻是非線性的。

三 神經網絡降伏非線性

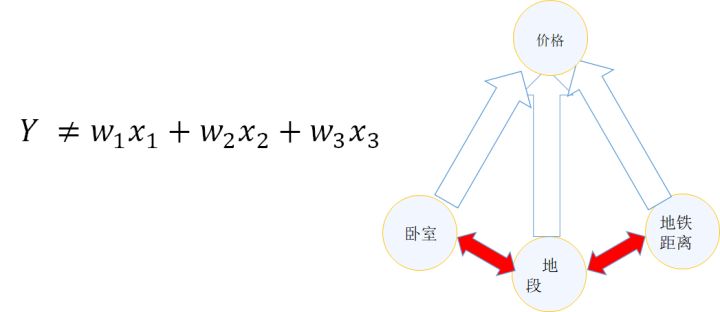

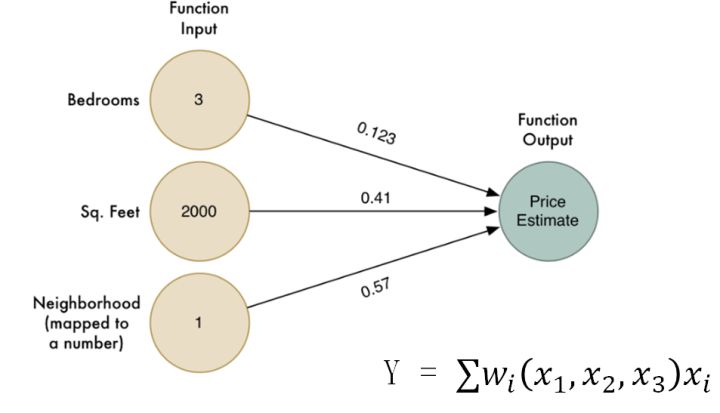

什么是非線性, 我們舉一個經典的機器學習的房價的例子,首先這是一個經典的線性問題。 我們通常用線性模型描述房價的問題。 把各個影響因子線性的累加起來。比如我們把問題簡化為臥室數量, 面積 ,地段, 最后求成交價。 我們用線性模型求解價格。 然而, 著一定不是真實的情況, 這背后的關鍵假設是,我們的臥室數量,面積, 地段都會獨立的影響房價, 這就好像說, 如果你有幾個不同的因素, 某個要素變化, 不影響其它要素最終決定房價的方式,我們具體來說, 還是房屋單價只受地段, 距離地鐵遠近,臥室數量三個要素影響,假定三者的權重是w1,w2, w3. 如果你去改變地段,那么w2,和w3必須是不變的。 就拿海淀和朝陽來說,對這兩個區, w2 和w3 是一致的。 事實上呢? 顯然這三個要素互相制約,或許海淀的人都做地鐵, 朝陽的有車的比較多, 它們對距離地鐵遠近的敏感就不同, 或者說海淀的單身漢比較多, 朝陽的成家的比較多, 朝陽的就更喜歡臥室多的大戶型。 如何表現這種特征之間的相互依賴關系呢? 一個天然的解決方法,就是:網絡模型

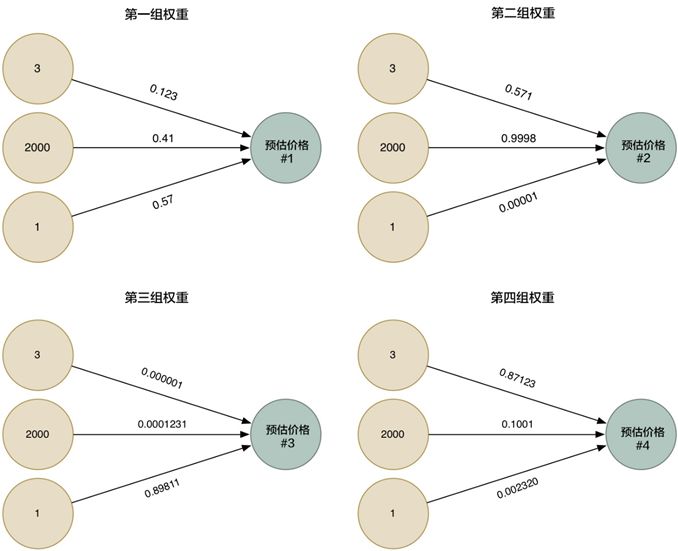

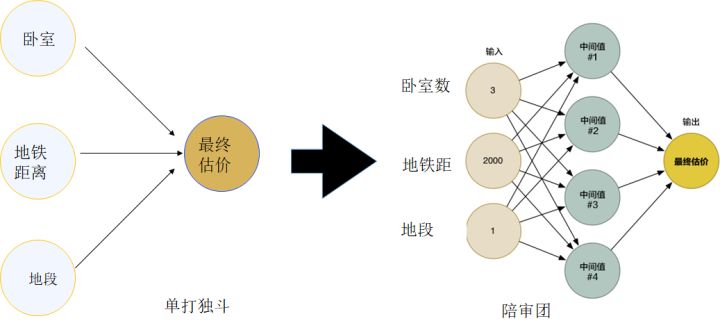

看看人類可能是怎么處理這些信息的,人對于這種復雜的信息,往往采用的是陪審團模式,我們可能有好幾個房價專家, 就自己了解的方向去提供意見, 最后我們再根據每個人的情況綜合出一個結果。雖然這個時候我們失去了簡單的線性, 但是通過對不同意見單元的歸納, 和集中的過程, 就可以模擬更復雜的問題。

再看看怎么把它變成數學處理房價問題。 首先把他表示成公式, 他其實是說的是

系數變成了和x有關的,仔細想一下,這不就是增加了一個新的層次嗎,我們需要再原始特征x1和x2的基礎上,增加一個新的處理層次,讓不同的特征區域,享受不同的權重。 就好比我們有好幾位房價評估師,每一位都是針對某種情況下房價的專家,最后有一個人, 根據專家的特長給出最終的綜合結果。這與我們的靈感是相符的。

我們把他表示成圖示方法。 首先, 每個專家都仿佛是一個小的線性模型, 它們具有唯一的一組權重, 顯示它們再所熟悉的區域的權威。

圖片改編自網絡博文Machine Learning is Fun! by Adam Geitgey

然后,我們把它們匯總起來, 得到下面這個圖, 這個圖和之前我們講解線性回歸的圖是一樣的, 但是我們增加了一個中間的層次,這就是剛剛說的陪審團, 哪些中間的位置, 事實上就是表達了特征之間復雜的互相影響。而最終我們把它們的意見綜合起來, 就是最終的結果。

你換個角度思考, 那些中間的綠色圓圈, 也就是說每個專家,不就是神經元嗎? 而那個黃色圓圈, 是最終決策的神經元。 這樣的一個組織, 而不是單個神經元, 就是神經網絡的雛形。

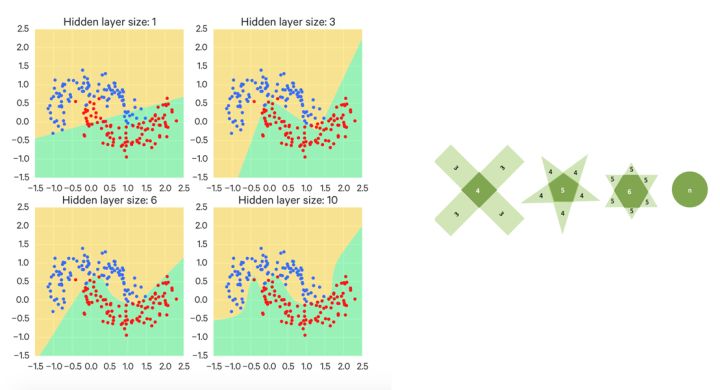

當然, 房價的問題是個回歸問題, 而這個世界的大部分機器學習問題是分類, 每個神經元也是一個小小的分類器, 所以我們把每個神經元的角色變成線性分類器,再套用剛剛陪審團的邏輯, 看看我們得到了什么:每個線性分類器, 剛剛講過都是一個小的特征檢測器, 具有自己的偏好,這個偏好剛好用一個直線表示, 左邊是yes,右邊是no, 那么多個神經元表達的是什么呢? 很多條這樣yes or no的直線! 最終的結果是什么呢? 我們得到一個被一條條直線割的四分五裂的結構, 既混亂又沒用! 這就好比每個信息收集者按照自己的偏好得到一個結論。幸好我們有一組頭頂的神經元, 它就是最終的大法官, 它把每個人劃分的方法, 做一個匯總。 大法官并不需要什么特殊的手段做匯總, 它所做到的,無非是邏輯運算, 所謂的“與”, “或”, “非”, 這個合并方法,可以得到一個非常復雜的判決結果。 你可以把大法官的工作看成是篩選, 我們要再空間里篩選出一個我們最終需要的形狀來, 這有點像是小孩子玩的折紙游戲,每一次都這一條直線, 最終會得到一個邊界非常復雜的圖形。 我們說, 這就是一個一層的神經網絡所能干的事情。 它可以做出一個復雜的選擇, 每個神經元都代表著對特征的一個組合方法,最后決策神經元把這些重組后的特征已經刻畫了不同特征之間的關系, 就可以干掉認識現實世界復雜特性-非線性的能力, 特征之間的關系很復雜, 我也可以學出來。

所謂神經網絡的近似定理, 是說一個前饋神經網絡如果具有線性輸出層和至少一層具有任何一種‘‘擠壓’’ 性質的激活函數(例如logistic sigmoid激活函數)的隱藏層,只要給予網絡足夠數量的隱藏單元,它可以以任意的精度來近似任何從一個有限維空間到另一個有限維空間的Borel 可測函數。 這是關于神經網絡最經典的理論了,簡稱萬能函數逼近器。

另外的一種理解是,神經網絡具有生成非常復雜的規則的能力, 如果你可以讓神經網絡很好的學習, 他就可以自發的去做那些與或非, 和邏輯運算,不用你自己寫程序就解決非線性問題。

四 關于神經網絡的學習

是什么阻止了神經網絡從出現之后很快的發展, 事實上是它們非常不好學習。

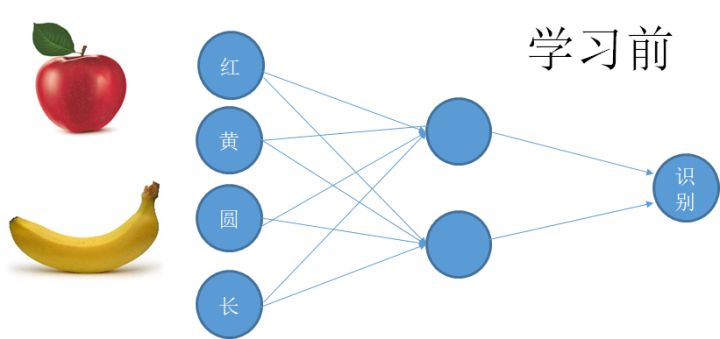

我們說神經網絡能夠成為一種機器學習的工具關鍵在于能夠學習,那么如何學習的呢? 如果說單個神經元可以學習的它的偏好, 通過調整權重來調整自己的偏好。 那么神經網絡所干的事情就是調整每個神經元和神經元之間的聯系, 通過調整這個連接, 來學習如何處理復雜的特征。

說的簡單, 這在數學上是一個非常難的問題。 我們通常要把一個機器學習問題轉化為優化問題求解。 這里, 神經網絡既然在解決非線性問題, 事實上和它有關的優化又叫做非線性優化。

先看生物神經網絡的學習, 它是通過一種叫做可塑性的性質進行調節的。 這種調控的法則十分簡單。說的是神經細胞之間的連接隨著它們的活動而變化, 這個變化的方法是, 如果有兩個上游的神經元同時給一個共同的下游神經元提供輸入, 那么這個共同的輸入將導致那個弱的神經元連接的增強, 或者說權重的增強。 這個原理導致的結果是,我們會形成對共同出現的特征的一種相關性提取。 比如一個香蕉的特征是黃色和長形, 一個猴子經常看到香蕉, 那么一個連接到黃色和長形這兩種底層特征的細胞就會越來越敏感, 形成一個對香蕉敏感的細胞,我們簡稱香蕉細胞。 也就是說我們通過底層特征的“共現” 形成了對高級特征的認知。 上述過程被總結hebbain學習的一個過程。

從本質上說, 剛剛說的過程是一種無監督學習,你接受輸入引起神經活動, 它慢慢的調整。 如果用這樣的方法訓練人工神經網絡,恐怕需要跑一個世紀。 人工神經網絡的訓練依賴的是監督學習,一種有效的結果導向的思維,如果我要它判斷香蕉和蘋果, 我就是要一邊給它看圖片, 叫它告訴我是什么 ,然后馬上告訴它對錯, 如果錯了,就是尋找那個引起錯誤的神經連接。 然而這個過程在數學上特別的難以表達, 因為一個復雜網絡的判斷, 引起錯誤的原因可能是任何中間環節 ,這就好像調節一大堆互相關聯在一起的參數,更加可怕的是, 神經網絡往往有很多層, 使得這些參數的相關性更加復雜, 如果你一個個去試探, 那個感覺就是立即瘋。

最終, 這個問題被BP算法的提出解決。 BP反向傳播算法, 是一種精確的根據最終實現的目標,然后通過比較當下輸出和最終目標的差距, 然后一級反推如何微小的改變各級連接權重以減少這種誤差的方法。 這其實就是梯度下降結合復合函數求導法則的一個更復雜的形式。 我們通常把一組剛剛到來的數據, 扎成一捆喂給神經網絡, 讓它計算出一個輸出, 這個輸出當然會錯的很離譜, 然后我們把這個結果和我們真正需求的比較得到一個誤差信號, 這個誤差信號會一級一級的改變所有的連接權重。 每一捆數據, 被稱為一個tensor, 都像一個個子彈一樣塑造著整個網絡。 對于這個方法的理解, 最好的辦法是使用一套由tensorflow提供的可視化工具。

當然這僅僅是一個神經網絡的訓練的簡短小節, 當你在神經網絡堅守的Hinton這樣的大神,事實上提出過對學習算法的無數改進細節, 才有了它今天的成功。

五 關于多層神經網絡,深有什么好處?

剛剛說的方法你可以理解一個一層的神經網絡, 那更多層的神經網絡呢?深層的神經網絡究竟有什么好處?事實上深度學習的深,就是指神經網絡之神,可見這是奧妙的門道。

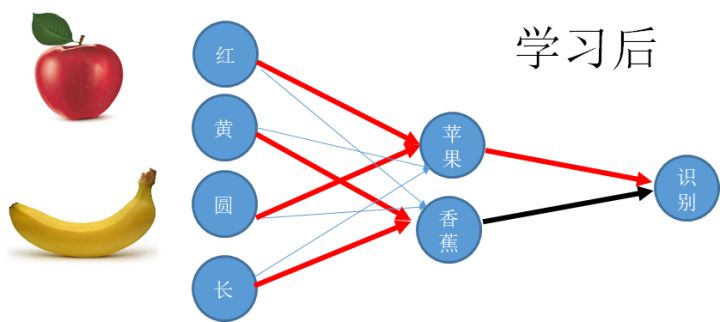

用一句化說,一層的神經網絡可以對特征做一次變換,就如同得到了一組新的特征, 這種特征的變換, 用數學家的眼光就是做了一個坐標變換, 兌換到一個新的空間。

我舉一個最小的例子讓你理解。 你記得高中學過的直角坐標系和極坐標系吧, 這兩個坐標系之間存在一個經典的坐標變換公式。 這就可以看作一個坐標變換。 我們舉一個例子看,如果要做一個分類器, 把一些居住在圓形中心的點和它的外周分離開來, 那么這個坐標變換就有奇效。

多層網絡, 就代表一個多次連續的特征變換,最后會把數據從一種性質變到另一個性質,從一個空間拉到另一個空間。最終總有一個空間, 這些數據呆著最合適。這種行為,簡稱為表征學習(representative learning)。

表征學習顧名思義,是要一種特征轉化為另外的特征,因為簡單的特征一旦發生關系就可以構成復雜的特征,剛剛那個處在領頭的大法官和司令再次變成士兵,給上層的決策者提供信息,隱層神經網絡所作的事情,我們說其實就是對特征進行重組, 然后得到一組新的特征的坐標變換, 只不過這個變換的形式是可以學習的。 我們說,越限制, 就越自由,為了更好的學習, 我們會限制神經元對信息的處理只由兩部分組成, 一個是用一定的權重組合上層的特征, 另一個是通過某個樣子的激活函數把這個總和變一變。

多層的神經網絡, 通過多次的基變換, 把特征一次次重組,得到越來越復雜的新的特征, 這就是深度神經網絡作用的機制。 某種程度上, 它把這種層級特征強加給了它要識別的事物, 但是假定事物本身也是這種按照一層層的方法搭建起來, 那么神經網絡就會取得奇效。

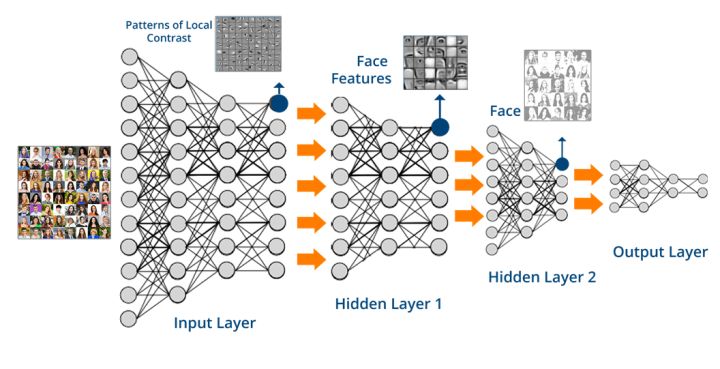

哪些事物是有這種層級結構的呢? 我們說,所有的感知信號都是, 從視覺, 到聽覺,到語言。假定你看著一個屏幕, 你真正看到的是每個像素點, 而最終你要組合成為一個可以認知的圖象。 假定你聽著的是聲音, 你最終需要分辨出一個個單詞 ,句式,直到語言。

認知科學里說,抽象使得不同的事物可以在更深的層次上被聯系起來, 的就是說, 不同層次的函數迭代,產生的新的空間(某種程度也是降維,比如圖形處理中),使得原先的距離概念被打破,具體怎樣被打破。 這正是人腦處理信息的本質。 實驗表明,越靠近感官的神經元處理的信息就具體, 比如顏色,亮度, 而經過多級處理,達到皮層之后, 我們的神經元就可以對比較抽象的實體,如人名,物體的種類敏感。

當然,這只是最形象的一個描述,關于增加深度相比增加寬度對神經網絡功能的好處,是整個深度學習問題的焦點問題之一。因此引出了幾個不同的數學觀點, 有機會給大家總結。

訓練深度神經網絡是困吶的,由于神經網絡的訓練里有大量的復雜求導運算, 我們是不是函數要寫死為止? 其實不是, 我們有一個強大的框架, 就是tensorflow,讓你的整個求導過程十分容易。你只需要寫出你的目標函數cost function,然后簡簡單單的調用tensorflow內部的optimisor就可以了。

六 神經網絡動物園

神經網絡經過這些年的進化,已經是一個大家族。 我們來看幾個具體的神經網絡

Auto-encoder 自編碼器:

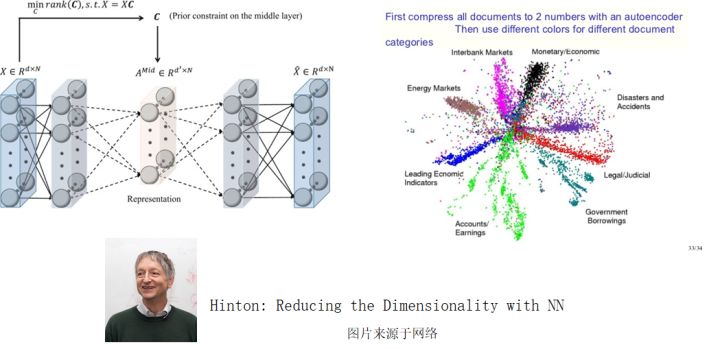

最早成功的一種深度神經網絡,自編碼器意如其名, 其實做的就是對數據進行編碼, 或者壓縮。 這種網絡通常具有的特點是輸出的長度或者說大小遠小于輸入,但是神奇的是, 這個輸出卻保留了數據種的大部分信息。 你是不是想到了上節課介紹的PCA了呢? 是的, 這就是一種降維的模型。 這個模型的實質, 也就是一個復雜, 或者說是非線性的降維操作, 比如說你把一張圖象壓成很簡單的編碼。 由于這種輸入多輸出少的性質, 自編碼器的形狀形如一個下夸上窄的漏斗, 數據從夸的一面進來, 出去的就是壓縮的精華。 自編碼器之所以在神經網絡的進化歷史里舉足輕重, 是因為它在回答一個很核心的問題, 那就是在變化的信息里那些是不變的, 這些不變的東西往往也就是最重要的東西。比如說人臉, 你把1萬張不同的人臉輸入到網絡里, 這些人類分屬于十個人, 那么按說, 很多照片無非是一個人的不同狀態,它的不變性就是這個人本身。 這個網絡能夠把數據最終一步步的集中到十個維度就夠了, 這樣, 最終可能用一個十位數的數字就可以壓縮整個數據集。 而這, 正是神經網絡, 甚至是人類理解事物的關鍵, 那就是找出紛繁變化事物里的不變性, 它對應的正是一個概念。 抓住了概念, 就抓住了從具象到抽象的過程, 抓住了知識,抓住了人認知的關鍵所在。 深度學習大師Hinton早期的核心工作,正是圍繞自編碼器。

卷積神經網絡:

卷積神經網絡就是模擬人類是視覺的一種深度神經網絡。這個網絡的特點是能夠把圖象數據,像photoshop 里的濾鏡一樣, 被過濾成某種特征圖,比如紋理圖, 這些低級的特征圖, 將再次被過濾, 得到一個新的特征圖, 這個特征圖的特點就是更抽象, 還有更多的剛剛講過的概念性的特征。 比如一個物體的形狀輪廓。 直到最后一層, 得到對某類物體概念的認知。 這就是人類視覺知識形成的過程。 也是我們下次課的重點。

含時間的神經網絡:

神經網絡不僅能夠描述靜態的各個特征之間的關系, 而且能夠描述特征(這里更好叫因子)之間在時間上的復雜相互作用關系, 一個神經網絡的做出的含時間過程, 最好的例子就是含有證據積累的決策過程。 即使是單個神經元, 也可以把不同時間的信息積累起來做個決定, 而動態的神經網絡, 就可以更好的把這些證據總體的匯集起來。

總的來說 , 幾個神經元組成的網絡, 可以像一個信息的蓄水池一樣, 通過互相喊話, 把過去的信息在自己人之間流傳起來, 從而產生類似于人的記憶的效應, 這些通過特定方法連接在一起的神經元, 就可以形成人的工作記憶或內隱記憶, 而同時, 也可以幫我們設定出處理和時間有關信號的神經網絡工具, 這就是RNN – LSTM家族, 以及其它的長時間記憶網絡。

在深度時間序列處理種扮演重要核心角色的LSTM,其創始人schmidhuber卻無緣此次圖靈獎。

-

神經網絡

+關注

關注

42文章

4810瀏覽量

102932 -

人工智能

+關注

關注

1804文章

48788瀏覽量

246969 -

機器學習

+關注

關注

66文章

8493瀏覽量

134174

原文標題:深度學習背后的基礎-神經網絡揭秘

文章出處:【微信號:AItists,微信公眾號:人工智能學家】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

詳解深度學習、神經網絡與卷積神經網絡的應用

神經網絡的技術為什么偉大, 又是什么讓它們這么多年才姍姍走來?

神經網絡的技術為什么偉大, 又是什么讓它們這么多年才姍姍走來?

評論