Google AI 與 DeepMind 合作推出深度規(guī)劃網(wǎng)絡(luò) (PlaNet),這是一個純粹基于模型的智能體,能從圖像輸入中學(xué)習(xí)世界模型,完成多項(xiàng)規(guī)劃任務(wù),數(shù)據(jù)效率平均提升50倍,強(qiáng)化學(xué)習(xí)又一突破。

通過強(qiáng)化學(xué)習(xí) (RL),對 AI 智能體如何隨著時間的推移提高決策能力的研究進(jìn)展迅速。

對于強(qiáng)化學(xué)習(xí),智能體在選擇動作 (例如,運(yùn)動命令) 時會觀察一系列感官輸入(例如,相機(jī)圖像),并且有時會因?yàn)檫_(dá)成指定目標(biāo)而獲得獎勵。

RL 的無模型方法 (Model-free) 旨在通過感官觀察直接預(yù)測良好的行為,這種方法使 DeepMind 的 DQN 能夠玩雅達(dá)利游戲,使其他智能體能夠控制機(jī)器人。

然而,這是一種黑盒方法,通常需要經(jīng)過數(shù)周的模擬交互才能通過反復(fù)試驗(yàn)來學(xué)習(xí),這限制了它在實(shí)踐中的有效性。

相反,基于模型的 RL 方法 (Model-basedRL) 試圖讓智能體了解整個世界的行為。這種方法不是直接將觀察結(jié)果映射到行動,而是允許 agent 明確地提前計(jì)劃,通過 “想象” 其長期結(jié)果來更仔細(xì)地選擇行動。

Model-based 的方法已經(jīng)取得了巨大的成功,包括 AlphaGo,它設(shè)想在已知游戲規(guī)則的虛擬棋盤上進(jìn)行一系列的移動。然而,要在未知環(huán)境中利用規(guī)劃(例如僅將像素作為輸入來控制機(jī)器人),智能體必須從經(jīng)驗(yàn)中學(xué)習(xí)規(guī)則或動態(tài)。

由于這種動態(tài)模型原則上允許更高的效率和自然的多任務(wù)學(xué)習(xí),因此創(chuàng)建足夠精確的模型以成功地進(jìn)行規(guī)劃是 RL 的長期目標(biāo)。

為了推動這項(xiàng)研究挑戰(zhàn)的進(jìn)展,Google AI 與 DeepMind 合作,提出了深度規(guī)劃網(wǎng)絡(luò) (Deep Planning Network, PlaNet),該智能體僅從圖像輸入中學(xué)習(xí)世界模型 (world model),并成功地利用它進(jìn)行規(guī)劃。

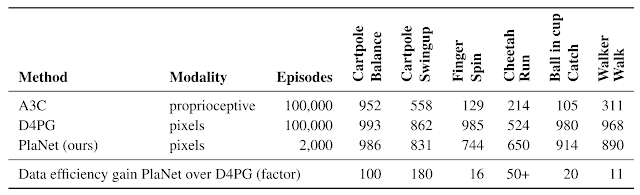

PlaNet 解決了各種基于圖像的控制任務(wù),在最終性能上可與先進(jìn)的 model-free agent 競爭,同時平均數(shù)據(jù)效率提高了 5000%。研究團(tuán)隊(duì)將發(fā)布源代碼供研究社區(qū)使用。

在 2000 次的嘗試中,PlaNet 智能體學(xué)習(xí)解決了各種連續(xù)控制任務(wù)。以前的沒有學(xué)習(xí)環(huán)境模型的智能體通常需要多 50 倍的嘗試次數(shù)才能達(dá)到類似的性能。

PlaNet 的工作原理

簡而言之,PlaNet 學(xué)習(xí)了給定圖像輸入的動態(tài)模型 (dynamics model),并有效地利用該模型進(jìn)行規(guī)劃,以收集新的經(jīng)驗(yàn)。

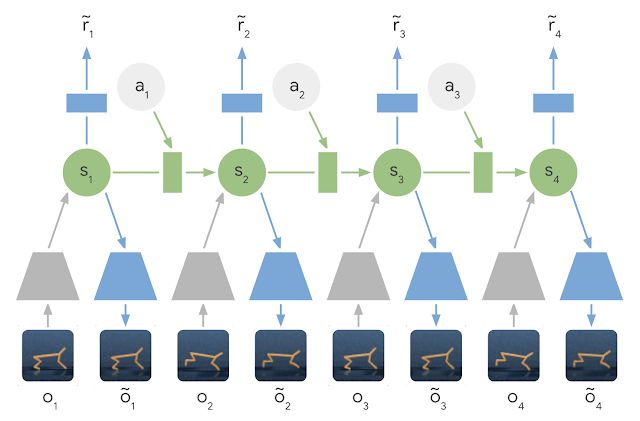

與以前的圖像規(guī)劃方法不同,我們依賴于隱藏狀態(tài)或潛在狀態(tài)的緊湊序列。這被稱為latent dynamics model:我們不是直接從一個圖像到下一個圖像地預(yù)測,而是預(yù)測未來的潛在狀態(tài)。然后從相應(yīng)的潛在狀態(tài)生成每一步的圖像和獎勵。

通過這種方式壓縮圖像,agent 可以自動學(xué)習(xí)更抽象的表示,例如對象的位置和速度,這樣就可以更容易地向前預(yù)測,而不需要沿途生成圖像。

Learned Latent Dynamics Model:在 latent dynamics 模型中,利用編碼器網(wǎng)絡(luò)(灰色梯形) 將輸入圖像的信息集成到隱藏狀態(tài)(綠色) 中。然后將隱藏狀態(tài)向前投影,以預(yù)測未來的圖像(藍(lán)色梯形) 和獎勵(藍(lán)色矩形)。

為了學(xué)習(xí)一個精確的 latent dynamics 模型,我們提出了:

循環(huán)狀態(tài)空間模型 (Recurrent State Space Model):一種具有確定性和隨機(jī)性成分的 latent dynamics 模型,允許根據(jù)魯棒規(guī)劃的需要預(yù)測各種可能的未來,同時記住多個時間步長的信息。我們的實(shí)驗(yàn)表明這兩個組件對于提高規(guī)劃性能是至關(guān)重要的。

潛在超調(diào)目標(biāo) (Latent Overshooting Objective):我們通過在潛在空間中強(qiáng)制 one-step 和 multi-step 預(yù)測之間的一致性,將 latent dynamics 模型的標(biāo)準(zhǔn)訓(xùn)練目標(biāo)推廣到訓(xùn)練多步預(yù)測。這產(chǎn)生了一個快速和有效的目標(biāo),可以改善長期預(yù)測,并與任何潛在序列模型兼容。

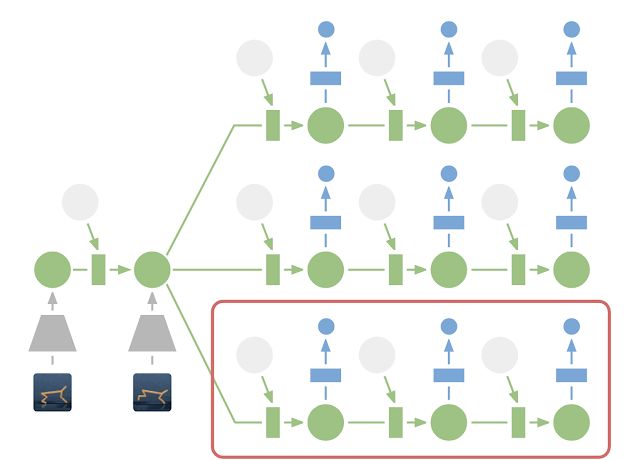

雖然預(yù)測未來的圖像允許我們教授模型,但編碼和解碼圖像 (上圖中的梯形) 需要大量的計(jì)算,這會減慢智能體的 planning 過程。然而,在緊湊的潛在狀態(tài)空間中進(jìn)行 planning 是很快的,因?yàn)槲覀冎恍枰A(yù)測未來的 rewards 來評估一個動作序列,而不是預(yù)測圖像。

例如,智能體可以想象球的位置和它到目標(biāo)的距離在特定的動作中將如何變化,而不需要可視化場景。這允許我們在每次智能體選擇一個動作時,將 10000 個想象的動作序列與一個大的 batch size 進(jìn)行比較。然后執(zhí)行找到的最佳序列的第一個動作,并在下一步重新規(guī)劃。

在潛在空間中進(jìn)行規(guī)劃:為了進(jìn)行規(guī)劃,我們將過去的圖像 (灰色梯形) 編碼為當(dāng)前的隱藏狀態(tài) (綠色)。這樣,我們可以有效地預(yù)測多個動作序列的未來獎勵。請注意,上圖中昂貴的圖像解碼器 (藍(lán)色梯形) 已經(jīng)消失了。然后,執(zhí)行找到的最佳序列的第一個操作 (紅色框)。

與我們之前關(guān)于世界模型的工作 (https://worldmodels.github.io/) 相比,PlaNet 在沒有策略網(wǎng)絡(luò)的情況下工作 —— 它純粹通過 planning 來選擇行動,因此它可以從模型當(dāng)下的改進(jìn)中獲益。有關(guān)技術(shù)細(xì)節(jié),請參閱我們的研究論文。

PlaNet vs. Model-Free 方法

我們在連續(xù)控制任務(wù)上評估了 PlaNet。智能體只被輸入圖像觀察和獎勵。我們考慮了具有各種不同挑戰(zhàn)的任務(wù):

側(cè)手翻任務(wù):帶有一個固定的攝像頭,這樣推車可以移動到視線之外。因此,智能體必須吸收并記住多個幀的信息。

手指旋轉(zhuǎn)任務(wù):需要預(yù)測兩個單獨(dú)的對象,以及它們之間的交互。

獵豹跑步任務(wù):包括難以準(zhǔn)確預(yù)測的地面接觸,要求模型預(yù)測多個可能的未來。

杯子接球任務(wù):它只在球被接住時提供一個稀疏的獎勵信號。這要求準(zhǔn)確預(yù)測很遠(yuǎn)的未來,并規(guī)劃一個精確的動作序列。

走路任務(wù):模擬機(jī)器人一開始是躺在地上,然后它必須先學(xué)會站立,再學(xué)習(xí)行走。

PlaNet 智能體接受了各種基于圖像的控制任務(wù)的訓(xùn)練。動圖顯示了當(dāng)智能體解決任務(wù)時輸入的圖像。這些任務(wù)提出了不同的挑戰(zhàn):部分可觀察性、與地面的接觸、接球的稀疏獎勵,以及控制一個具有挑戰(zhàn)性的雙足機(jī)器人。

這一研究是第一個使用學(xué)習(xí)模型進(jìn)行規(guī)劃,并在基于圖像的任務(wù)上優(yōu)于 model-free 方法的案例。

下表將PlaNet與著名的A3C 智能體和 D4PG 智能體進(jìn)行了比較,后者結(jié)合了 model-free RL 的最新進(jìn)展。這些基線數(shù)據(jù)來自 DeepMind 控制套件。PlaNet 在所有任務(wù)上都明顯優(yōu)于 A3C,最終性能接近 D4PG,同時與環(huán)境的交互平均減少了 5000%。

所有任務(wù)只需要一個智能體

此外,我們只訓(xùn)練了一個單一的 PlaNet 智能體來解決所有六個任務(wù)。

在不知道任務(wù)的情況下,智能體被隨機(jī)放置在不同的環(huán)境中,因此它需要通過觀察圖像來推斷任務(wù)。

在不改變超參數(shù)的情況下,多任務(wù)智能體實(shí)現(xiàn)了與單個智能體相同的平均性能。雖然在側(cè)手翻任務(wù)中學(xué)習(xí)速度較慢,但在需要探索的具有挑戰(zhàn)性的步行任務(wù)中,它的學(xué)習(xí)速度要快得多,最終表現(xiàn)也更好。

在多個任務(wù)上訓(xùn)練的 PlaNet 智能體。智能體觀察前 5 個幀作為上下文以推斷任務(wù)和狀態(tài),并在給定動作序列的情況下提前準(zhǔn)確地預(yù)測 50 個步驟。

結(jié)論

我們的結(jié)果展示了構(gòu)建自主 RL 智能體的學(xué)習(xí)動態(tài)模型的前景。我們鼓勵進(jìn)一步的研究,集中在學(xué)習(xí)更困難的任務(wù)的精確動態(tài)模型,如三維環(huán)境和真實(shí)的機(jī)器人任務(wù)。擴(kuò)大規(guī)模的一個可能因素是 TPU 的處理能力。我們對 model-based 強(qiáng)化學(xué)習(xí)帶來的可能性感到興奮,包括多任務(wù)學(xué)習(xí)、分層規(guī)劃和使用不確定性估計(jì)的主動探索。

-

谷歌

+關(guān)注

關(guān)注

27文章

6223瀏覽量

107511 -

強(qiáng)化學(xué)習(xí)

+關(guān)注

關(guān)注

4文章

269瀏覽量

11515 -

DeepMind

+關(guān)注

關(guān)注

0文章

131瀏覽量

11362

原文標(biāo)題:一個智能體打天下:谷歌、DeepMind重磅推出PlaNet,數(shù)據(jù)效率提升50倍

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

18個常用的強(qiáng)化學(xué)習(xí)算法整理:從基礎(chǔ)方法到高級模型的理論技術(shù)與代碼實(shí)現(xiàn)

【免費(fèi)送,全新AD25(入門+進(jìn)階)兩套 PCB Layout視頻教程 】張飛實(shí)戰(zhàn)電子x志博PCB:攜手共創(chuàng)PCB學(xué)習(xí)新征程

詳解RAD端到端強(qiáng)化學(xué)習(xí)后訓(xùn)練范式

Commvault推出CIS強(qiáng)化鏡像

谷歌加速AI部門整合:AI Studio團(tuán)隊(duì)并入DeepMind

OpenAI從谷歌DeepMind挖角三名高級工程師

螞蟻集團(tuán)收購邊塞科技,吳翼出任強(qiáng)化學(xué)習(xí)實(shí)驗(yàn)室首席科學(xué)家

如何使用 PyTorch 進(jìn)行強(qiáng)化學(xué)習(xí)

AI實(shí)火!諾貝爾又把化學(xué)獎頒給AI大模型

谷歌AlphaChip強(qiáng)化學(xué)習(xí)工具發(fā)布,聯(lián)發(fā)科天璣芯片率先采用

谷歌DeepMind被曝抄襲開源成果,論文還中了頂流會議

谷歌借助Gemini AI系統(tǒng)深化對機(jī)器人的訓(xùn)練

谷歌AI新突破:為無聲視頻智能配音

通過強(qiáng)化學(xué)習(xí)策略進(jìn)行特征選擇

谷歌、DeepMind重磅推出PlaNet 強(qiáng)化學(xué)習(xí)新突破

谷歌、DeepMind重磅推出PlaNet 強(qiáng)化學(xué)習(xí)新突破

評論