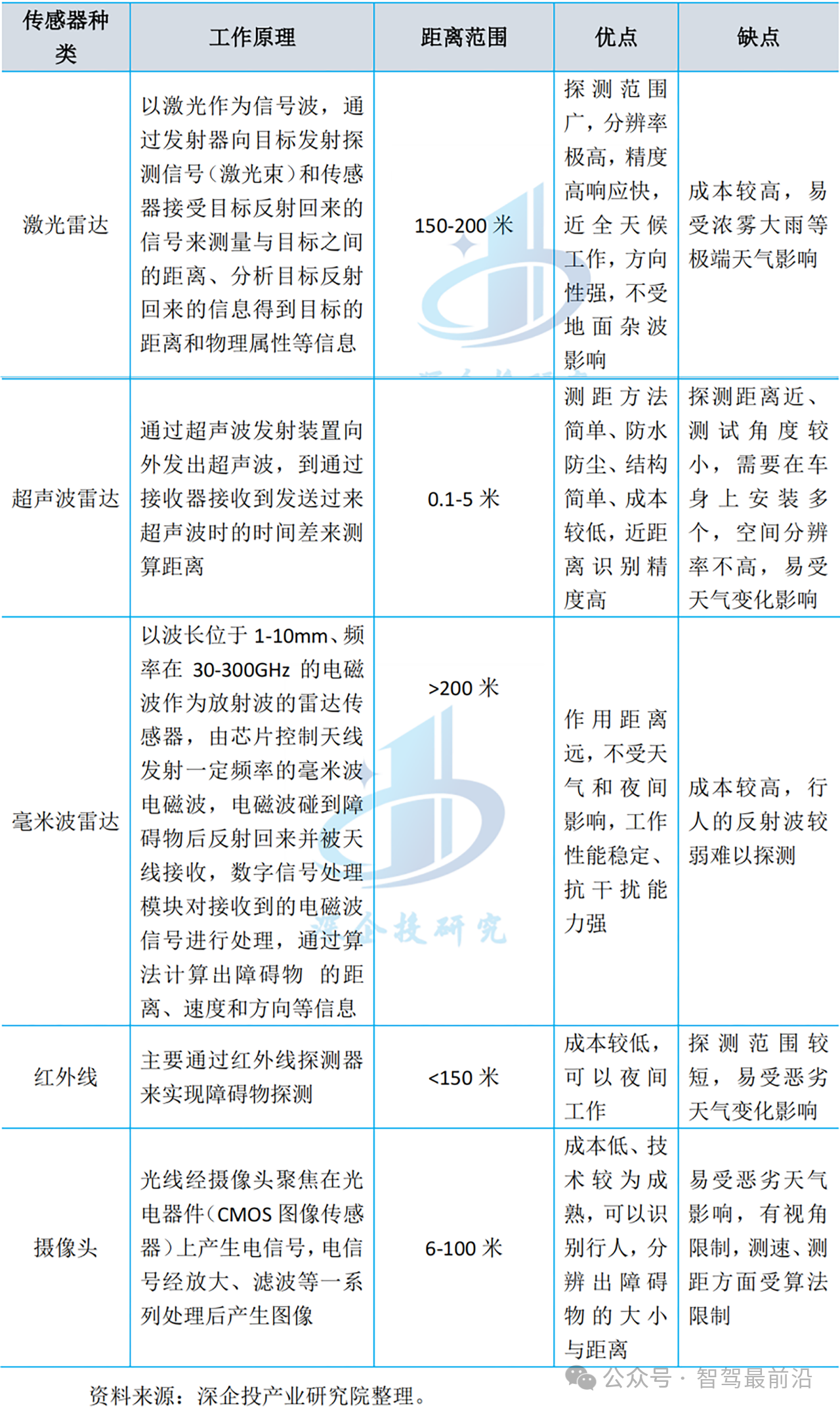

人類駕駛與自主駕駛在對交通環境的理解方式上有著明顯差別。首先,人主要通過視覺來理解交通場景,而機器感知需要融合多種異構的傳感信息才能保證行車安全。其次,一個熟練的駕駛員可以輕松適應各種動態交通環境,但現有的機器感知系統卻會經常輸出有噪聲的感知結果,而自主駕駛要求感知結果近乎100%準確。

本文提出了一種用于無人車交通環境感知的視覺主導的多傳感器融合計算框架,通過幾何和語義約束融合來自相機、激光雷達(LIDAR)及地理信息系統(GIS)的信息,為無人車提供高精度的自主定位和準確魯棒的障礙物感知,并進一步討論了已成功集成到上述框架內的魯棒的視覺算法,主要包括從訓練數據收集、傳感器數據處理、低級特征提取到障礙物識別和環境地圖創建等多個層次的視覺算法。所提出的框架里已用于自主研發的無人車,并在各種真實城區環境中進行了長達八年的實地測試,實驗結果驗證了視覺主導的多傳感融合感知框架的魯棒性和高效性。

-

傳感器

+關注

關注

2565文章

52982瀏覽量

767252 -

無人車

+關注

關注

1文章

310瀏覽量

36916

原文標題:無人車自主定位和障礙物感知的視覺主導多傳感器融合方法

文章出處:【微信號:IV_Technology,微信公眾號:智車科技】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

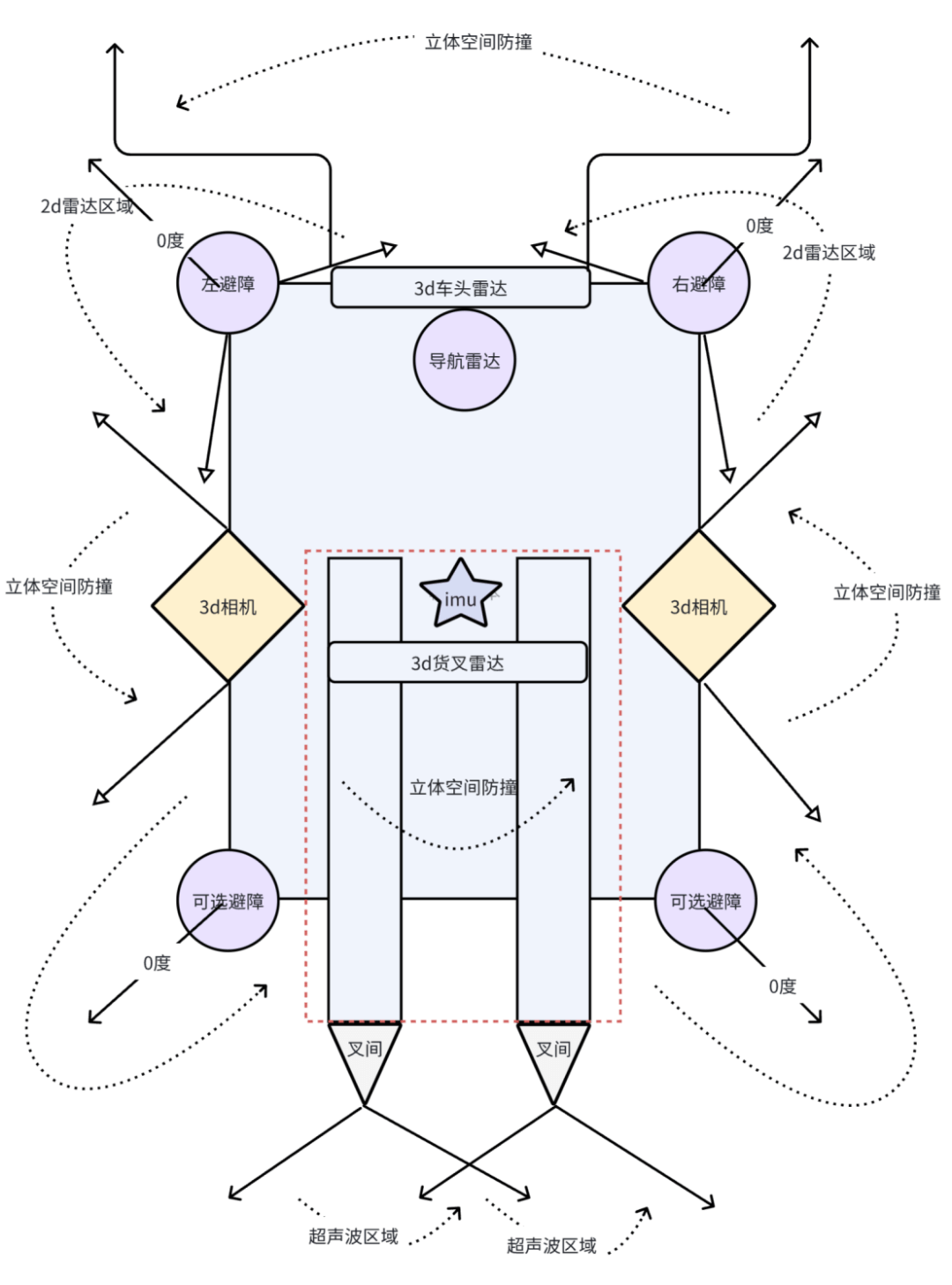

AGV機器人如何實現毫秒級避障?深度解析多傳感器融合的核心技術

【「# ROS 2智能機器人開發實踐」閱讀體驗】視覺實現的基礎算法的應用

仿生傳感器:讓機器擁有“生命感知”的神奇科技

融合視覺傳感器廠商銳思智芯完成B輪融資

從安防到元宇宙:RK3588如何重塑視覺感知邊界?

國內首顆車規級數字環境光傳感器

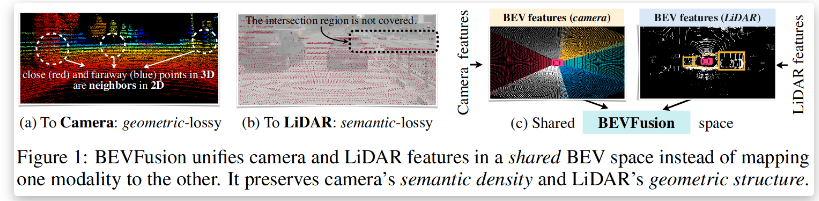

BEVFusion —面向自動駕駛的多任務多傳感器高效融合框架技術詳解

用于無人車交通環境感知的視覺主導的多傳感器融合計算框架

用于無人車交通環境感知的視覺主導的多傳感器融合計算框架

評論