BigDL是基于Apache Spark的分布式深度學(xué)習(xí)框架,借助現(xiàn)有的Spark集群來(lái)運(yùn)行深度學(xué)習(xí)計(jì)算,并簡(jiǎn)化存儲(chǔ)在Hadoop中的大數(shù)據(jù)集的數(shù)據(jù)加載。

聲明:本文內(nèi)容及配圖由入駐作者撰寫(xiě)或者入駐合作網(wǎng)站授權(quán)轉(zhuǎn)載。文章觀點(diǎn)僅代表作者本人,不代表電子發(fā)燒友網(wǎng)立場(chǎng)。文章及其配圖僅供工程師學(xué)習(xí)之用,如有內(nèi)容侵權(quán)或者其他違規(guī)問(wèn)題,請(qǐng)聯(lián)系本站處理。

舉報(bào)投訴

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4810瀏覽量

102918 -

AI

+關(guān)注

關(guān)注

88文章

34408瀏覽量

275684 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5555瀏覽量

122534

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

熱點(diǎn)推薦

神經(jīng)網(wǎng)絡(luò)教程(李亞非)

網(wǎng)絡(luò)BP算法的程序設(shè)計(jì) 多層前向網(wǎng)絡(luò)BP算法源程序 第4章 Hopfield網(wǎng)絡(luò)模型 4.1 離散型Hopfield

發(fā)表于 03-20 11:32

AI知識(shí)科普 | 從無(wú)人相信到萬(wàn)人追捧的神經(jīng)網(wǎng)絡(luò)

,不斷地進(jìn)行學(xué)習(xí)訓(xùn)練,一直到網(wǎng)絡(luò)輸出的誤差減少到可以接受的程度。 B、卷積神經(jīng)網(wǎng)絡(luò)卷積神經(jīng)網(wǎng)絡(luò)是一種前饋神經(jīng)網(wǎng)絡(luò),它的人工神經(jīng)元可以響應(yīng)一

發(fā)表于 06-05 10:11

與記憶神經(jīng)網(wǎng)絡(luò)的聯(lián)想記憶的實(shí)驗(yàn)演示_英文版

與記憶神經(jīng)網(wǎng)絡(luò)的聯(lián)想記憶的實(shí)驗(yàn)演示_英文版

發(fā)表于 09-26 16:31

?0次下載

關(guān)于如何「訓(xùn)練」神經(jīng)網(wǎng)絡(luò)的一部分經(jīng)驗(yàn)與見(jiàn)解

本文是作者關(guān)于如何「訓(xùn)練」神經(jīng)網(wǎng)絡(luò)的一部分經(jīng)驗(yàn)與見(jiàn)解,處理神經(jīng)網(wǎng)絡(luò)的基礎(chǔ)概念外,這篇文章還描述了梯度下降(GD)及其部分變體。此外,該系列文章將在在后面一

長(zhǎng)短時(shí)記憶神經(jīng)網(wǎng)絡(luò)的算法

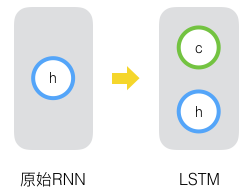

通過(guò)上一篇文章[人工智能之循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)] 介紹,我們知道,RNN是一類(lèi)功能強(qiáng)大的人工神經(jīng)網(wǎng)絡(luò)算法,RNN一個(gè)重要的優(yōu)點(diǎn)在于,其能夠在輸入和輸出序列之間的映射過(guò)程中利用上下文相關(guān)信息。但是RNN存在著梯度消失或梯度爆炸等問(wèn)題。因此,為了解決上述問(wèn)題,

發(fā)表于 06-29 14:44

?4925次閱讀

長(zhǎng)短時(shí)記憶網(wǎng)絡(luò)(LSTM)介紹

循環(huán)神經(jīng)網(wǎng)絡(luò)很難訓(xùn)練的原因?qū)е滤膶?shí)際應(yīng)用中很處理長(zhǎng)距離的依賴。本文將介紹改進(jìn)后的循環(huán)神經(jīng)網(wǎng)絡(luò):長(zhǎng)短時(shí)記憶網(wǎng)絡(luò)(Long Short Term Memory Network, LSTM

長(zhǎng)短時(shí)記憶網(wǎng)絡(luò)(LSTM)

循環(huán)神經(jīng)網(wǎng)絡(luò)很難訓(xùn)練的原因?qū)е滤膶?shí)際應(yīng)用中很處理長(zhǎng)距離的依賴。本文將介紹改進(jìn)后的循環(huán)神經(jīng)網(wǎng)絡(luò):長(zhǎng)短時(shí)記憶網(wǎng)絡(luò)(Long Short Term Memory Network, LSTM

發(fā)表于 01-27 10:05

?16次下載

基于神經(jīng)網(wǎng)絡(luò)和長(zhǎng)短期記憶網(wǎng)絡(luò)的網(wǎng)絡(luò)入侵檢測(cè)

針對(duì)網(wǎng)絡(luò)入侵檢測(cè)準(zhǔn)確率偏低而誤報(bào)率偏高的問(wèn)題,提出一種融合卷積神經(jīng)網(wǎng)絡(luò)(CNN)與雙向長(zhǎng)短期記憶( BILSTM)網(wǎng)絡(luò)的

發(fā)表于 05-19 14:44

?2次下載

循環(huán)神經(jīng)網(wǎng)絡(luò)和遞歸神經(jīng)網(wǎng)絡(luò)的區(qū)別

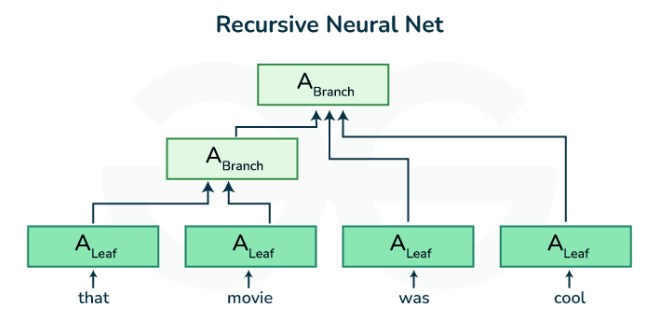

循環(huán)神經(jīng)網(wǎng)絡(luò)(Recurrent Neural Network,簡(jiǎn)稱RNN)和遞歸神經(jīng)網(wǎng)絡(luò)(Recursive Neural Network,簡(jiǎn)稱RvNN)是深度學(xué)習(xí)中兩種重要的神經(jīng)網(wǎng)絡(luò)

遞歸神經(jīng)網(wǎng)絡(luò)的結(jié)構(gòu)、特點(diǎn)、優(yōu)缺點(diǎn)及適用場(chǎng)景

遞歸神經(jīng)網(wǎng)絡(luò)(Recurrent Neural Networks,簡(jiǎn)稱RNN)是一種具有循環(huán)結(jié)構(gòu)的神經(jīng)網(wǎng)絡(luò),其核心特點(diǎn)是能夠處理序列數(shù)據(jù),并對(duì)序列中的信息進(jìn)行記憶和傳遞。RNN在自然語(yǔ)

遞歸神經(jīng)網(wǎng)絡(luò)是循環(huán)神經(jīng)網(wǎng)絡(luò)嗎

。 遞歸神經(jīng)網(wǎng)絡(luò)的概念 遞歸神經(jīng)網(wǎng)絡(luò)是一種具有短期記憶功能的神經(jīng)網(wǎng)絡(luò),它能夠處理序列數(shù)據(jù),如時(shí)間

遞歸神經(jīng)網(wǎng)絡(luò)與循環(huán)神經(jīng)網(wǎng)絡(luò)一樣嗎

遞歸神經(jīng)網(wǎng)絡(luò)(Recursive Neural Network,RvNN)和循環(huán)神經(jīng)網(wǎng)絡(luò)(Recurrent Neural Network,RNN)是兩種不同類(lèi)型的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),它們?cè)?/div>

rnn是遞歸神經(jīng)網(wǎng)絡(luò)還是循環(huán)神經(jīng)網(wǎng)絡(luò)

RNN(Recurrent Neural Network)是循環(huán)神經(jīng)網(wǎng)絡(luò),而非遞歸神經(jīng)網(wǎng)絡(luò)。循環(huán)神經(jīng)網(wǎng)絡(luò)是一種具有時(shí)間序列特性的神經(jīng)網(wǎng)絡(luò),能

遞歸神經(jīng)網(wǎng)絡(luò)的實(shí)現(xiàn)方法

遞歸神經(jīng)網(wǎng)絡(luò)(Recursive Neural Network,簡(jiǎn)稱RNN)是一種特殊類(lèi)型的神經(jīng)網(wǎng)絡(luò),其特點(diǎn)在于能夠處理具有層次或樹(shù)狀結(jié)構(gòu)的數(shù)據(jù),并通過(guò)遞歸的方式對(duì)這些數(shù)據(jù)進(jìn)行建模。與

遞歸神經(jīng)網(wǎng)絡(luò)和循環(huán)神經(jīng)網(wǎng)絡(luò)的模型結(jié)構(gòu)

遞歸神經(jīng)網(wǎng)絡(luò)是一種旨在處理分層結(jié)構(gòu)的神經(jīng)網(wǎng)絡(luò),使其特別適合涉及樹(shù)狀或嵌套數(shù)據(jù)的任務(wù)。這些網(wǎng)絡(luò)明確地模擬了層次結(jié)構(gòu)中的關(guān)系和依賴關(guān)系,例如語(yǔ)言中的句法結(jié)構(gòu)或圖像中的層次表示。它使用

第4部分:BIGDL的長(zhǎng)短記憶和遞歸神經(jīng)網(wǎng)絡(luò)

第4部分:BIGDL的長(zhǎng)短記憶和遞歸神經(jīng)網(wǎng)絡(luò)

評(píng)論