(1)性能與傳統芯片,比如CPU、GPU有很大的區別。在執行AI算法時,更快、更節能。

(2)工藝沒有區別,大家都一樣。至少目前來看,都一樣。

所謂的AI芯片,一般是指針對AI算法的ASIC(專用芯片)。

傳統的CPU、GPU都可以拿來執行AI算法,但是速度慢,性能低,無法實際商用。

比如,自動駕駛需要識別道路行人紅綠燈等狀況,但是如果是當前的CPU去算,那么估計車翻到河里了還沒發現前方是河,這是速度慢,時間就是生命。如果用GPU,的確速度要快得多,但是,功耗大,汽車的電池估計無法長時間支撐正常使用,而且,老黃家的GPU巨貴,經常單塊上萬,普通消費者也用不起,還經常缺貨。另外,GPU因為不是專門針對AI算法開發的ASIC,所以,說到底,速度還沒到極限,還有提升空間。而類似智能駕駛這樣的領域,必須快!在手機終端,可以自行人臉識別、語音識別等AI應用,這個必須功耗低,所以GPU OUT!

所以,開發ASIC就成了必然。

說說,為什么需要AI芯片。

AI算法,在圖像識別等領域,常用的是CNN卷積網絡,語音識別、自然語言處理等領域,主要是RNN,這是兩類有區別的算法。但是,他們本質上,都是矩陣或vector的乘法、加法,然后配合一些除法、指數等算法。

一個成熟的AI算法,比如YOLO-V3,就是大量的卷積、殘差網絡、全連接等類型的計算,本質是乘法和加法。對于YOLO-V3來說,如果確定了具體的輸入圖形尺寸,那么總的乘法加法計算次數是確定的。比如一萬億次。(真實的情況比這個大得多的多)

那么要快速執行一次YOLO-V3,就必須執行完一萬億次的加法乘法次數。

這個時候就來看了,比如IBM的POWER8,最先進的服務器用超標量CPU之一,4GHz,SIMD,128bit,假設是處理16bit的數據,那就是8個數,那么一個周期,最多執行8個乘加計算。一次最多執行16個操作。這還是理論上,其實是不大可能的。

那么CPU一秒鐘的巔峰計算次數=16X4Gops=64Gops。

這樣,可以算算CPU計算一次的時間了。

同樣的,換成GPU算算,也能知道執行時間。因為對GPU內部結構不熟,所以不做具體分析。

再來說說AI芯片。比如大名鼎鼎的谷歌的TPU1.

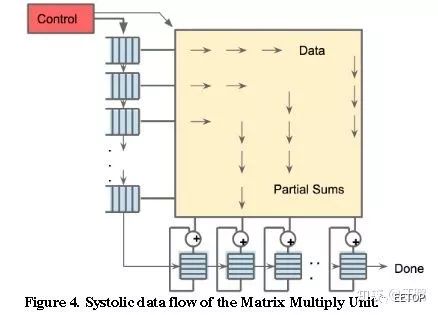

TPU1,大約700M Hz,有256X256尺寸的脈動陣列,如下圖所示。一共256X256=64K個乘加單元,每個單元一次可執行一個乘法和一個加法。那就是128K個操作。(乘法算一個,加法再算一個)

另外,除了脈動陣列,還有其他模塊,比如激活等,這些里面也有乘法、加法等。

所以,看看TPU1一秒鐘的巔峰計算次數至少是=128K X 700MHz=89600Gops=大約90Tops。

對比一下CPU與TPU1,會發現計算能力有幾個數量級的差距,這就是為啥說CPU慢。

當然,以上的數據都是完全最理想的理論值,實際情況,能夠達到5%吧。因為,芯片上的存儲不夠大,所以數據會存儲在DRAM中,從DRAM取數據很慢的,所以,乘法邏輯往往要等待。另外,AI算法有許多層網絡組成,必須一層一層的算,所以,在切換層的時候,乘法邏輯又是休息的,所以,諸多因素造成了實際的芯片并不能達到利潤的計算峰值,而且差距還極大。

可能有人要說,搞研究慢一點也能將就用。

目前來看,神經網絡的尺寸是越來越大,參數越來越多,遇到大型NN模型,訓練需要花幾周甚至一兩個月的時候,你會耐心等待么?突然斷電,一切重來?(曾經動手訓練一個寫小說的AI,然后,一次訓練(50輪)需要大約一天一夜還多,記得如果第一天早上開始訓練,需要到第二天下午才可能完成,這還是模型比較簡單,數據只有幾萬條的小模型呀。)

修改了模型,需要幾個星期才能知道對錯,確定等得起?

突然有了TPU,然后你發現,吃個午飯回來就好了,參數優化一下,繼續跑,多么爽!

計算速度快,才能迅速反復迭代,研發出更強的AI模型。速度就是金錢。

GPU的內核結構不清楚,所以就不比較了。肯定的是,GPU還是比較快的,至少比CPU快得多,所以目前大多數都用GPU,這玩意隨便一個都能價格輕松上萬,太貴,而且,功耗高,經常缺貨。不適合數據中心大量使用。

總的來說,CPU與GPU并不是AI專用芯片,為了實現其他功能,內部有大量其他邏輯,而這些邏輯對于目前的AI算法來說是完全用不上的,所以,自然造成CPU與GPU并不能達到最優的性價比。

谷歌花錢研發TPU,而且目前已經出了TPU3,用得還挺歡,都開始支持谷歌云計算服務了,貌似6點幾美元每小時吧,不記得單位了,懶得查。

可見,谷歌覺得很有必要自己研發TPU。

目前在圖像識別、語音識別、自然語言處理等領域,精度最高的算法就是基于深度學習的,傳統的機器學習的計算精度已經被超越,目前應用最廣的算法,估計非深度學習莫屬,而且,傳統機器學習的計算量與 深度學習比起來少很多,所以,我討論AI芯片時就針對計算量特別大的深度學習而言。畢竟,計算量小的算法,說實話,CPU已經很快了。而且,CPU適合執行調度復雜的算法,這一點是GPU與AI芯片都做不到的,所以他們三者只是針對不同的應用場景而已,都有各自的主場。

至于為何用了CPU做對比?

而沒有具體說GPU。是因為,我說了,我目前沒有系統查看過GPU的論文,不了解GPU的情況,故不做分析。因為積累的緣故,比較熟悉超標量CPU,所以就用熟悉的CPU做詳細比較。而且,小型的網絡,完全可以用CPU去訓練,沒啥大問題,最多慢一點。只要不是太大的網絡模型。

那些AI算法公司,比如曠世、商湯等,他們的模型很大,自然也不是一塊GPU就能搞定的。GPU的算力也是很有限的。

至于說CPU是串行,GPU是并行

沒錯,但是不全面。只說說CPU串行。這位網友估計對CPU沒有非常深入的理解。我的回答中舉的CPU是IBM的POWER8,百度一下就知道,這是超標量的服務器用CPU,目前來看,性能已經是非常頂級的了,主頻4GHZ。不知是否注意到我說了這是SIMD?這個SIMD,就代表他可以同時執行多條同樣的指令,這就是并行,而不是串行。單個數據是128bit的,如果是16bit的精度,那么一周期理論上最多可以計算八組數據的乘法或加法,或者乘加。這還不叫并行?只是并行的程度沒有GPU那么厲害而已,但是,這也是并行。

不知道為啥就不能用CPU來比較算力?

有評論很推崇GPU。說用CPU來做比較,不合適。

拜托,GPU本來是從CPU中分離出來專門處理圖像計算的,也就是說,GPU是專門處理圖像計算的。包括各種特效的顯示。這也是GPU的天生的缺陷,GPU更加針對圖像的渲染等計算算法。但是,這些算法,與深度學習的算法還是有比較大的區別,而我的回答里提到的AI芯片,比如TPU,這個是專門針對CNN等典型深度學習算法而開發的。另外,寒武紀的NPU,也是專門針對神經網絡的,與TPU類似。

谷歌的TPU,寒武紀的DianNao,這些AI芯片剛出道的時候,就是用CPU/GPU來對比的。

看看,谷歌TPU論文的摘要直接對比了TPU1與CPU/GPU的性能比較結果,見紅色框:

這就是摘要中介紹的TPU1與CPU/GPU的性能對比。

再來看看寒武紀DianNao的paper,摘要中直接就是DianNao與CPU的性能的比較,見紅色框:

回顧一下歷史

上個世紀出現神經網絡的時候,那一定是用CPU計算的。

比特幣剛出來,那也是用CPU在挖。目前已經進化成ASIC礦機了。比特大陸了解一下。

從2006年開始開啟的深度學習熱潮,CPU與GPU都能計算,發現GPU速度更快,但是貴啊,更多用的是CPU,而且,那時候GPU的CUDA可還不怎么樣,后來,隨著NN模型越來越大,GPU的優勢越來越明顯,CUDA也越來越6,目前就成了GPU的專場。

寒武紀2014年的DianNao(NPU)比CPU快,而且更加節能。ASIC的優勢很明顯啊。這也是為啥要開發ASIC的理由。

至于說很多公司的方案是可編程的,也就是大多數與FPGA配合。你說的是商湯、深鑒么?的確,他們發表的論文,就是基于FPGA的。

這些創業公司,他們更多研究的是算法,至于芯片,還不是重點,另外,他們暫時還沒有那個精力與實力。FPGA非常靈活,成本不高,可以很快實現架構設計原型,所以他們自然會選擇基于FPGA的方案。不過,最近他們都大力融資,官網也在招聘芯片設計崗位,所以,應該也在涉足ASIC研發了。

如果以FPGA為代表的可編程方案真的有巨大的商業價值,那他們何必砸錢去做ASIC?

說了這么多,我也是半路出家的,因為工作需要而學習的。按照我目前的理解,看TPU1的專利及論文,一步一步推導出內部的設計方法,理解了TPU1,大概就知道了所謂的AI處理器的大部分。然后研究研究寒武紀的一系列論文,有好幾種不同的架構用于不同的情況,有興趣可以研究一下。然后就是另外幾個獨角獸,比如商湯、深鑒科技等,他們每年都會有論文發表,沒事去看看。這些論文,大概就代表了當前最先進的AI芯片的架構設計了。當然,最先進,別人肯定不會公開,比如谷歌就不曾公開關于TPU2和TPU3的相關專利,反正我沒查到。不過,沒事,目前的文獻已經代表了最近幾年最先進的進展了。

-

芯片

+關注

關注

459文章

52205瀏覽量

436455 -

cpu

+關注

關注

68文章

11040瀏覽量

216042 -

AI

+關注

關注

87文章

34294瀏覽量

275476

原文標題:AI 芯片和傳統芯片有何區別?

文章出處:【微信號:eetop-1,微信公眾號:EETOP】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

首創開源架構,天璣AI開發套件讓端側AI模型接入得心應手

**【技術干貨】Nordic nRF54系列芯片:傳感器數據采集與AI機器學習的完美結合**

科通技術推出DeepSeek+AI芯片全場景方案

AI芯片:科技變革的核心驅動力

AI在芯片上的應用:革新設計與功能

聚焦AI芯片,角逐芯未來

SPEA創新實踐:AI芯片混合信號測試儀

恒玄科技研發AI眼鏡專用芯片

Untether發布人工智能(AI)芯片

如今火熱的AI芯片到底是什么

AI芯片的混合精度計算與靈活可擴展

后摩智能引領AI芯片革命,推出邊端大模型AI芯片M30

什么是AI芯片?為什么需要AI芯片?

什么是AI芯片?為什么需要AI芯片?

評論