無論構(gòu)建機(jī)器學(xué)習(xí)的目的是什么,客戶總是希望能知道并理解模型的來龍去脈的。此外作為數(shù)據(jù)科學(xué)家和機(jī)器學(xué)習(xí)工作者,可解釋性對(duì)于模型的驗(yàn)證和改進(jìn)有著十分積極的意義。本文將從不同的角度闡述模型的可解釋性對(duì)于機(jī)器學(xué)習(xí)的重要性,并探討模型解釋的實(shí)踐方法。

機(jī)器學(xué)習(xí)的可解釋性為何如此重要?

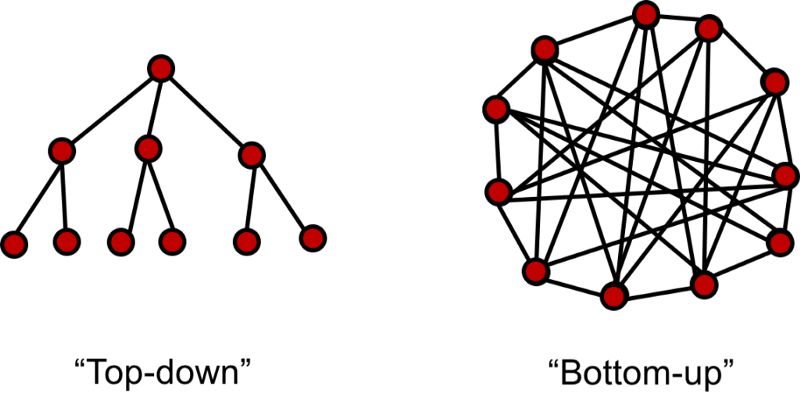

在傳統(tǒng)統(tǒng)計(jì)學(xué)中,我們通過數(shù)據(jù)構(gòu)建并驗(yàn)證假設(shè)來建立模型。通過構(gòu)建的模型我們可以得到一系列規(guī)則并應(yīng)用于業(yè)務(wù)中去。例如市場(chǎng)部門就可以通過構(gòu)建與競(jìng)爭(zhēng)者數(shù)據(jù)相關(guān)的模型來決定有效的市場(chǎng)競(jìng)爭(zhēng)策略和方法。這類方法屬于自頂向下的方法,其中可解釋性是整套方法的解釋,它銜接了規(guī)則和所產(chǎn)生的行為策略。很多時(shí)候因果關(guān)系不那么明確,一個(gè)堅(jiān)實(shí)的模型就需要為決策提供可靠的解釋,幫助人們清晰的理解。

而對(duì)于自底向上的模式,將商業(yè)模型中的一部分委派給機(jī)器學(xué)習(xí),甚至從機(jī)器學(xué)習(xí)中得到全新的商業(yè)想法。自底向上的數(shù)據(jù)科學(xué)一般與手工勞作的自動(dòng)化過程相關(guān)。例如制造業(yè)公司可將傳感器放置在設(shè)備上收集數(shù)據(jù)并預(yù)測(cè)其需要維護(hù)的時(shí)間,這就避免了運(yùn)維工程師耗時(shí)的周期性檢查和維修,他們可以高效的維護(hù)工場(chǎng)設(shè)備保持在運(yùn)行在良好的狀態(tài)。模型的可解釋可以幫助驗(yàn)證模型是否再按期望的狀態(tài)運(yùn)行,同時(shí)有利于在向自動(dòng)化轉(zhuǎn)變的過程中創(chuàng)造多的信任。

作為一名數(shù)據(jù)科學(xué)家,經(jīng)常需要對(duì)模型進(jìn)行微調(diào)以達(dá)到最優(yōu)的表現(xiàn)。數(shù)據(jù)科學(xué)一般都是在給定x和輸出y的情況下尋找誤差最小的映射模型。雖然訓(xùn)練優(yōu)秀的模型是數(shù)據(jù)科學(xué)家的核心能力,但具有更廣闊的視野也十分重要。對(duì)數(shù)據(jù)和模型的解讀對(duì)于數(shù)據(jù)科學(xué)處理流程是十分重要的,同時(shí)還能保證模型與目標(biāo)問題的匹配。盡管我們經(jīng)常會(huì)在各種前沿模型的嘗試中迷失自我,但如果能夠解釋模型的發(fā)現(xiàn)并指導(dǎo)你的工作這將會(huì)使得數(shù)據(jù)科學(xué)的處理變得更加透徹。

對(duì)于模型的深度分析是數(shù)據(jù)的科學(xué)的根本

1. 識(shí)別并減小偏差

偏差廣泛存在于數(shù)據(jù)集中,數(shù)據(jù)科學(xué)家需要識(shí)別并修正它的影響。很多時(shí)候數(shù)據(jù)集的規(guī)模可能很小不足以覆蓋所有的情況,或者在數(shù)據(jù)獲取過程中沒有考慮潛在的偏差。它的影響往往會(huì)在數(shù)據(jù)處理后護(hù)著在模型預(yù)測(cè)中變得明顯。偏差存在的形式各不相同,需要明確的是,處理偏差的手段并不單一,但在考慮模型的可解釋性的時(shí)候必須要考慮到偏差的存在。

2.幫助分析問題的前后聯(lián)系

在大多數(shù)問題中,我們收集到的數(shù)據(jù)僅僅是問題的粗略表示,并不能完全反映真實(shí)狀態(tài)下的復(fù)雜性。可解釋模型可以幫助我們理解并計(jì)量哪些因素被包含到模型中,并根據(jù)模型預(yù)測(cè)計(jì)量問題的前后聯(lián)系。

3.改善泛化性

可解釋性越強(qiáng)的模型一般都會(huì)具有更好的泛化性。可解釋性并不是模型對(duì)于每一個(gè)數(shù)據(jù)點(diǎn)的細(xì)節(jié)描述,而是結(jié)合了堅(jiān)實(shí)的模型和數(shù)據(jù)以及對(duì)于問題的理解,綜合形成對(duì)于問題更好更全面的理解。

4.倫理和法律需要

在金融和醫(yī)療等行業(yè)人們需要審視模型的決策過程,并保證模型的決策不帶有歧視和違法等行為。隨著數(shù)據(jù)隱私保護(hù)的加強(qiáng),模型的可解釋性變得更加重要。同時(shí)在一些如醫(yī)療、自動(dòng)駕駛等關(guān)鍵領(lǐng)域,一個(gè)錯(cuò)誤會(huì)產(chǎn)生十分巨大的反響,所以模型的可解釋性變得十分重要,讓人們明白系統(tǒng)是如何工作的,決策是如何形成的。

如何解釋你的模型?

在這一領(lǐng)域通常有一個(gè)規(guī)律,模型的可解釋性隨著復(fù)雜度的增加而下降,甚至更快的下降。特征重要性一般是解釋模型的起點(diǎn)。即使對(duì)于黑箱般的深度學(xué)習(xí)模型,依然有一系列技術(shù)用于解釋他們?nèi)绾喂ぷ鳌T谖恼碌淖詈笪覀冞€將討論LIME(Local Interpretable Model-Agnostic Explanations)框架來作為分析框架構(gòu)建可解釋性。

1.特征重要性

一般線性模型

一般線性模型將特征作為x輸入并與模型的權(quán)重相結(jié)合,通過函數(shù)作用后可以預(yù)測(cè)一系列廣泛的變量。其常見的應(yīng)用包括回歸(線性回歸)、分類(邏輯回歸)和泊松過程建模(泊松回歸)。其權(quán)重來自于特征訓(xùn)練后的結(jié)果,他們可以為模型提供十分簡(jiǎn)練的解釋。

例如構(gòu)建一個(gè)文本分類器的過程中,可以繪制分類的特征圖并驗(yàn)證它是否過擬合了噪聲。如果最重要的特征與你的直覺不符,這就意味著模型在噪聲上過擬合了,它在新數(shù)據(jù)上的表現(xiàn)也不會(huì)好。

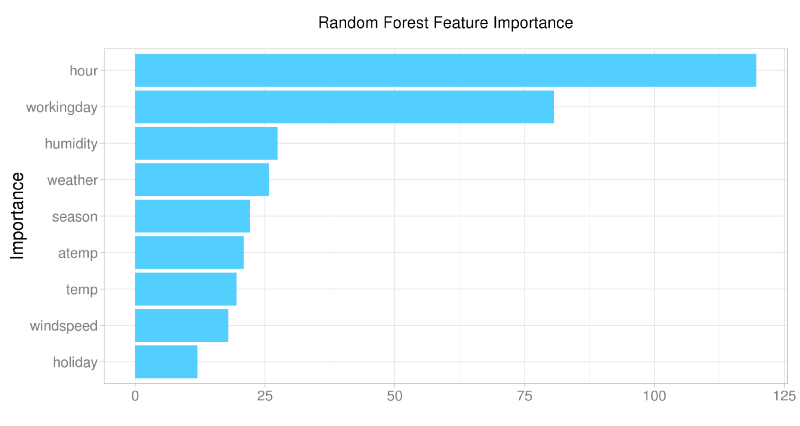

隨機(jī)森林和支持向量機(jī)

即使對(duì)于樹這一類的非線性模型依然可以特征重要性中提取信息。在隨機(jī)森林中,特征重要性是驗(yàn)證初始假設(shè)和評(píng)價(jià)模型學(xué)習(xí)效果的好方法。而在基于核方法的支持向量機(jī)中,可以將特征映射到核空間中進(jìn)行學(xué)習(xí)。

從上圖中可以看到模型從數(shù)據(jù)中學(xué)習(xí)到了什么,什么是重要的

深度學(xué)習(xí)

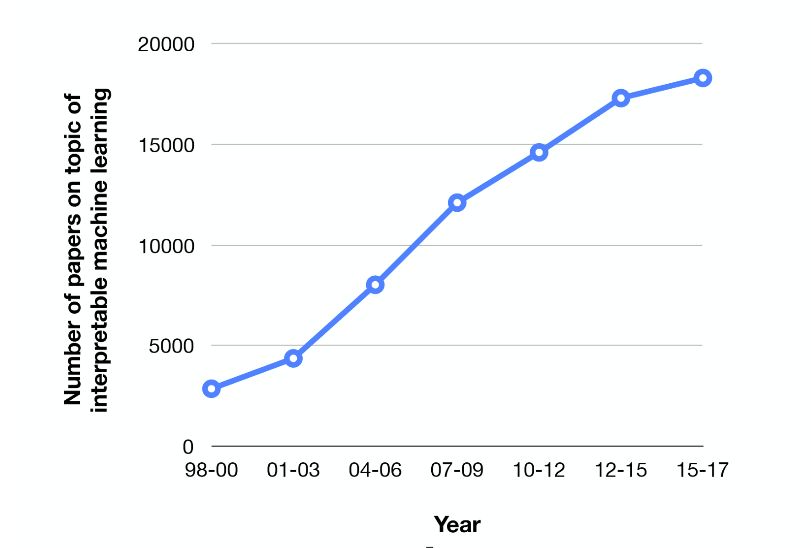

深度學(xué)習(xí)模型的表現(xiàn)十分優(yōu)異,但由于缺乏可解釋性廣受詬病。這主要是由于內(nèi)部的參數(shù)共享和復(fù)雜的特征抽取與組合。這類模型在一系列機(jī)器學(xué)習(xí)任務(wù)上達(dá)到了最先進(jìn)的水平,很多人都在致力于銜接器預(yù)測(cè)與輸入的關(guān)系,期待解釋模型的優(yōu)異表現(xiàn)。

機(jī)器學(xué)習(xí)可解釋的學(xué)術(shù)研究火熱

深度學(xué)習(xí)的不可解釋性是阻礙其發(fā)展的障礙,特別是在圖像和文本處理上,很難解釋模型到底學(xué)習(xí)到了什么。目前這一領(lǐng)域的主要研究方向集中在將輸出或者預(yù)測(cè)映射回輸入數(shù)據(jù)上。雖然在線性模型上十分簡(jiǎn)單,但在深度學(xué)習(xí)中依然是懸而未決的問題。目前主要集中在梯度和注意力機(jī)制兩方面來解決。

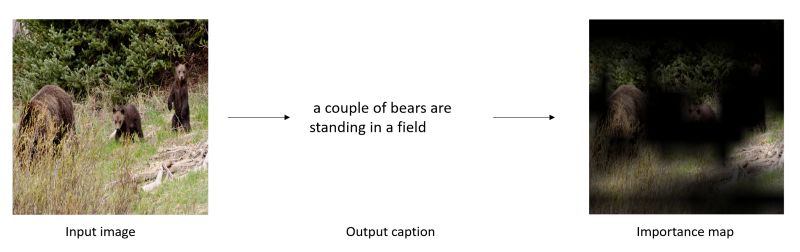

1) 基于梯度的方法中利用方向傳播梯度的概念產(chǎn)生出一幅地圖,用于描述出輸入圖中對(duì)于輸入預(yù)測(cè)重要的部分。

視覺標(biāo)注任務(wù)中在原圖顯示對(duì)于結(jié)果重要的部分

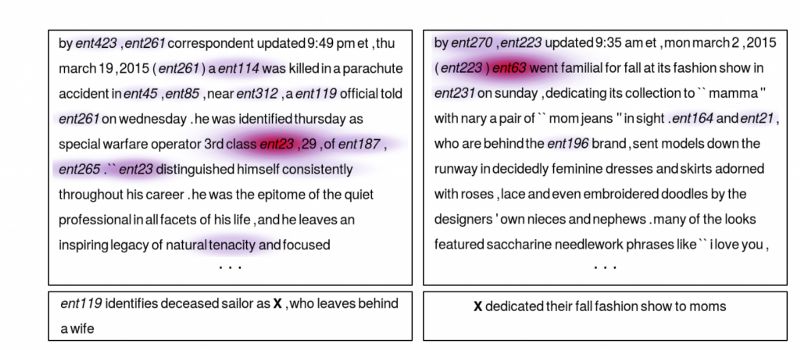

2) 基于注意力機(jī)制的方法主要用于序列數(shù)據(jù)。除了網(wǎng)絡(luò)中歸一化的權(quán)重外,注意力權(quán)重被訓(xùn)練用于"輸入門"。注意力權(quán)重可以被用于決定輸入部分多少被用于最后的網(wǎng)絡(luò)輸出。除了可解釋性,文本中的注意力機(jī)制在問答系統(tǒng)中幫助系統(tǒng)更加集中于任務(wù)本身。

顯示了文本中對(duì)于問題回答重要的部分

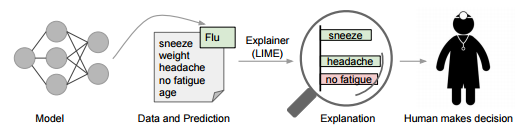

2.LIME

LIME是一個(gè)更為通用的解釋框架。

為了保持模型的獨(dú)立性,LIME修改局域的輸入將特別的測(cè)試用例輸入模型并觀察對(duì)預(yù)測(cè)造成的影響,通過一個(gè)個(gè)特定的樣例來觀察模型的可解釋性。在文本內(nèi)容分類中,這意味著某些詞被替換后觀察輸出的結(jié)果。這就可以看到哪些修改后的結(jié)果是更為重要的。從而從側(cè)面來解釋模型。

-

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8488瀏覽量

134010 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5554瀏覽量

122442

原文標(biāo)題:聊一聊機(jī)器學(xué)習(xí)的可解釋性和一個(gè)實(shí)踐方法

文章出處:【微信號(hào):thejiangmen,微信公眾號(hào):將門創(chuàng)投】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

機(jī)器學(xué)習(xí)模型可解釋性的結(jié)果分析

什么是“可解釋的”? 可解釋性AI不能解釋什么

可解釋的機(jī)器學(xué)習(xí)——打開機(jī)器學(xué)習(xí)黑匣子

導(dǎo)磁材料的影響為何如此重要

機(jī)器學(xué)習(xí)模型的“可解釋性”的概念及其重要意義

神經(jīng)網(wǎng)絡(luò)可解釋性研究的重要性日益凸顯

深度理解神經(jīng)網(wǎng)絡(luò)黑盒子:可驗(yàn)證性和可解釋性

Explainable AI旨在提高機(jī)器學(xué)習(xí)模型的可解釋性

機(jī)器學(xué)習(xí)模型可解釋性的介紹

《計(jì)算機(jī)研究與發(fā)展》—機(jī)器學(xué)習(xí)的可解釋性

機(jī)器學(xué)習(xí)模型的可解釋性算法詳解

可以提高機(jī)器學(xué)習(xí)模型的可解釋性技術(shù)

文獻(xiàn)綜述:確保人工智能可解釋性和可信度的來源記錄

機(jī)器學(xué)習(xí)的可解釋性為何如此重要?

機(jī)器學(xué)習(xí)的可解釋性為何如此重要?

評(píng)論