本文介紹目前常見(jiàn)的幾種可以提高機(jī)器學(xué)習(xí)模型的可解釋性的技術(shù),包括它們的相對(duì)優(yōu)點(diǎn)和缺點(diǎn)。我們將其分為下面幾種:

1. Partial Dependence Plot (PDP);

2. Individual Conditional Expectation (ICE)

3. Permuted Feature Importance

4. Global Surrogate

5. Local Surrogate (LIME)

6. Shapley Value (SHAP)

六大可解釋性技術(shù)

01. Partial Dependence Plot (PDP)

PDP是十幾年之前發(fā)明的,它可以顯示一個(gè)或兩個(gè)特征對(duì)機(jī)器學(xué)習(xí)模型的預(yù)測(cè)結(jié)果的邊際效應(yīng)。它可以幫助研究人員確定當(dāng)大量特征調(diào)整時(shí),模型預(yù)測(cè)會(huì)發(fā)生什么樣的變化。

上面圖中,軸表示特征的值,軸表示預(yù)測(cè)值。陰影區(qū)域中的實(shí)線顯示了平均預(yù)測(cè)如何隨著值的變化而變化。PDP能很直觀地顯示平均邊際效應(yīng),因此可能會(huì)隱藏異質(zhì)效應(yīng)。

例如,一個(gè)特征可能與一半數(shù)據(jù)的預(yù)測(cè)正相關(guān),與另一半數(shù)據(jù)負(fù)相關(guān)。那么PDP圖將只是一條水平線。

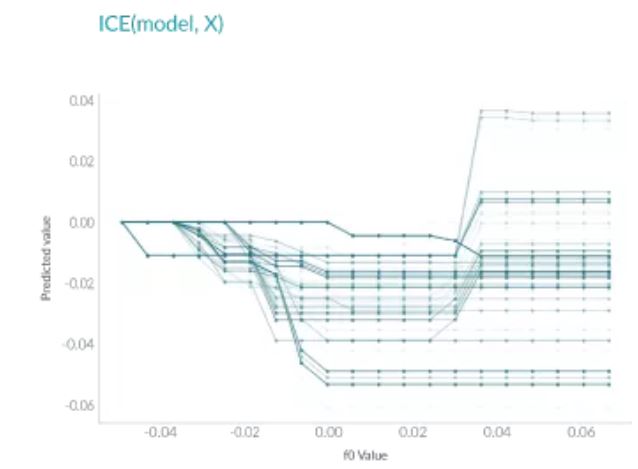

02. Individual Conditional Expectation (ICE)

ICE和PDP非常相似,但和PDP不同之處在于,PDP繪制的是平均情況,但是ICE會(huì)顯示每個(gè)實(shí)例的情況。ICE可以幫助我們解釋一個(gè)特定的特征改變時(shí),模型的預(yù)測(cè)會(huì)怎么變化。

如上圖所示,與PDP不同,ICE曲線可以揭示異質(zhì)關(guān)系。但其最大的問(wèn)題在于:它不能像PDP那樣容易看到平均效果,所以可以考慮將二者結(jié)合起來(lái)一起使用。

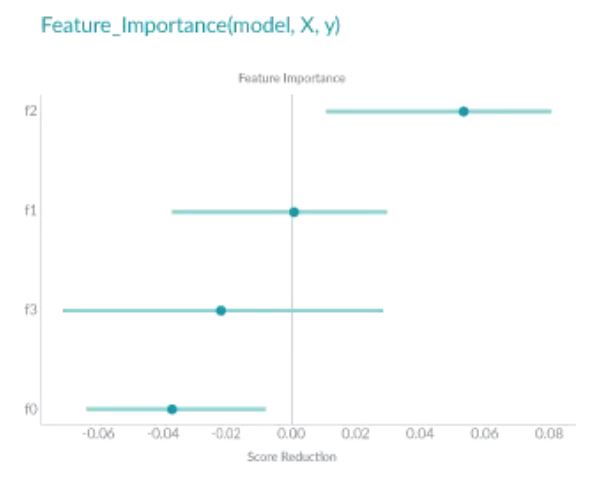

03. Permuted Feature Importance

Permuted Feature Importance的特征重要性是通過(guò)特征值打亂后模型預(yù)測(cè)誤差的變化得到的。換句話說(shuō),Permuted Feature Importance有助于定義模型中的特征對(duì)最終預(yù)測(cè)做出貢獻(xiàn)的大小。

如上圖所示,特征f2在特征的最上面,對(duì)模型的誤差影響是最大的,f1在shuffle之后對(duì)模型卻幾乎沒(méi)什么影響,生息的特征則對(duì)于模型是負(fù)面的貢獻(xiàn)。

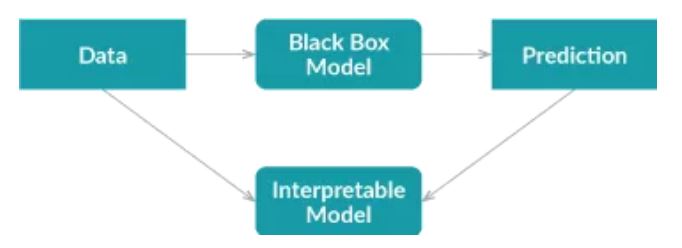

04. Global Surrogate

Global Surrogate方法采用不同的方法。它通過(guò)訓(xùn)練一個(gè)可解釋的模型來(lái)近似黑盒模型的預(yù)測(cè)。

首先,我們使用經(jīng)過(guò)訓(xùn)練的黑盒模型對(duì)數(shù)據(jù)集進(jìn)行預(yù)測(cè);

然后我們?cè)谠摂?shù)據(jù)集和預(yù)測(cè)上訓(xùn)練可解釋的模型。

訓(xùn)練好的可解釋模型可以近似原始模型,我們需要做的就是解釋該模型。

注:代理模型可以是任何可解釋的模型:線性模型、決策樹(shù)、人類定義的規(guī)則等。

使用可解釋的模型來(lái)近似黑盒模型會(huì)引入額外的誤差,但額外的誤差可以通過(guò)R平方來(lái)衡量。

由于代理模型僅根據(jù)黑盒模型的預(yù)測(cè)而不是真實(shí)結(jié)果進(jìn)行訓(xùn)練,因此全局代理模型只能解釋黑盒模型,而不能解釋數(shù)據(jù)。

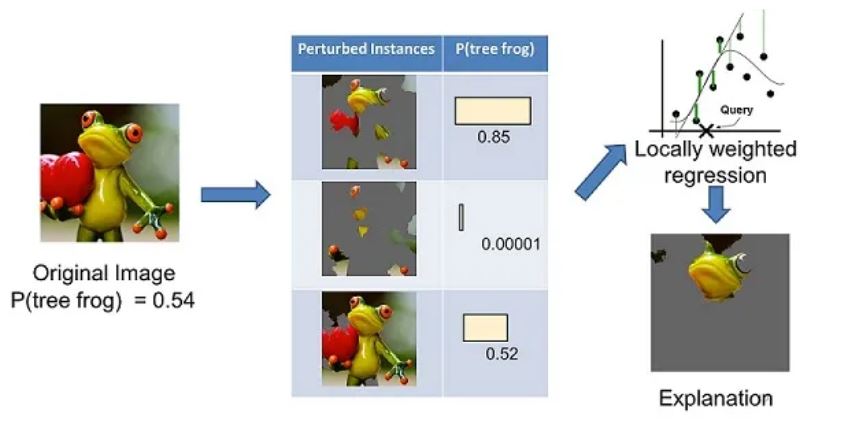

05. Local Surrogate (LIME)

LIME(Local Interpretable Model-agnostic Explanations)和global surrogate是不同的,因?yàn)樗粐L試解釋整個(gè)模型。相反,它訓(xùn)練可解釋的模型來(lái)近似單個(gè)預(yù)測(cè)。LIME試圖了解當(dāng)我們擾亂數(shù)據(jù)樣本時(shí)預(yù)測(cè)是如何變化的。

上面左邊的圖像被分成可解釋的部分。然后,LIME 通過(guò)“關(guān)閉”一些可解釋的組件(在這種情況下,使它們變灰)來(lái)生成擾動(dòng)實(shí)例的數(shù)據(jù)集。對(duì)于每個(gè)擾動(dòng)實(shí)例,可以使用經(jīng)過(guò)訓(xùn)練的模型來(lái)獲取圖像中存在樹(shù)蛙的概率,然后在該數(shù)據(jù)集上學(xué)習(xí)局部加權(quán)線性模型。最后,使用具有最高正向權(quán)重的成分來(lái)作為解釋。

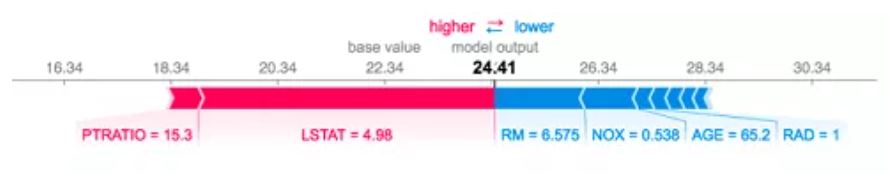

06. Shapley Value (SHAP)

Shapley Value的概念來(lái)自博弈論。我們可以通過(guò)假設(shè)實(shí)例的每個(gè)特征值是游戲中的“玩家”來(lái)解釋預(yù)測(cè)。每個(gè)玩家的貢獻(xiàn)是通過(guò)在其余玩家的所有子集中添加和刪除玩家來(lái)衡量的。一名球員的Shapley Value是其所有貢獻(xiàn)的加權(quán)總和。Shapley 值是可加的,局部準(zhǔn)確的。如果將所有特征的Shapley值加起來(lái),再加上基值,即預(yù)測(cè)平均值,您將得到準(zhǔn)確的預(yù)測(cè)值。這是許多其他方法所沒(méi)有的功能。

該圖顯示了每個(gè)特征的Shapley值,表示將模型結(jié)果從基礎(chǔ)值推到最終預(yù)測(cè)的貢獻(xiàn)。紅色表示正面貢獻(xiàn),藍(lán)色表示負(fù)面貢獻(xiàn)。

小結(jié)

機(jī)器學(xué)習(xí)模型的可解釋性是機(jī)器學(xué)習(xí)中一個(gè)非常活躍而且重要的研究領(lǐng)域。本文中我們介紹了6種常用的用于理解機(jī)器學(xué)習(xí)模型的算法。大家可以依據(jù)自己的實(shí)踐場(chǎng)景進(jìn)行使用。

參考文獻(xiàn)

https://www.twosigma.com/articles/interpretability-methods-in-machine-le...

【免責(zé)聲明】本文轉(zhuǎn)載自:Datawhale,轉(zhuǎn)載此文目的在于傳播相關(guān)技術(shù)知識(shí),版權(quán)歸原作者所有,如涉及侵權(quán),請(qǐng)聯(lián)系小編刪除(聯(lián)系郵箱:[email protected] )。

審核編輯:符乾江

-

PDP

+關(guān)注

關(guān)注

0文章

53瀏覽量

36526 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8490瀏覽量

134034

發(fā)布評(píng)論請(qǐng)先 登錄

算法進(jìn)化論:從參數(shù)剪枝到意識(shí)解碼的 AI 革命

AI大模型在汽車應(yīng)用中的推理、降本與可解釋性研究

機(jī)器學(xué)習(xí)模型市場(chǎng)前景如何

小白學(xué)解釋性AI:從機(jī)器學(xué)習(xí)到大模型

《具身智能機(jī)器人系統(tǒng)》第7-9章閱讀心得之具身智能機(jī)器人與大模型

NPU與機(jī)器學(xué)習(xí)算法的關(guān)系

一種基于因果路徑的層次圖卷積注意力網(wǎng)絡(luò)

機(jī)器學(xué)習(xí)模型的可解釋性算法詳解

機(jī)器學(xué)習(xí)模型的可解釋性算法詳解

評(píng)論