佐思汽研發布《2024-2025年AI大模型及其在汽車領域的應用研究報告》。

推理能力成為大模型性能提升的驅動引擎

2024下半年以來,國內外大模型公司紛紛推出推理模型,通過以CoT為代表的推理框架,加強大模型對復雜任務處理能力和自主決策能力。

部分大模型公司的推理模型發布情況

來源:佐思汽研《2024-2025年AI大模型及其在汽車領域的應用研究報告》

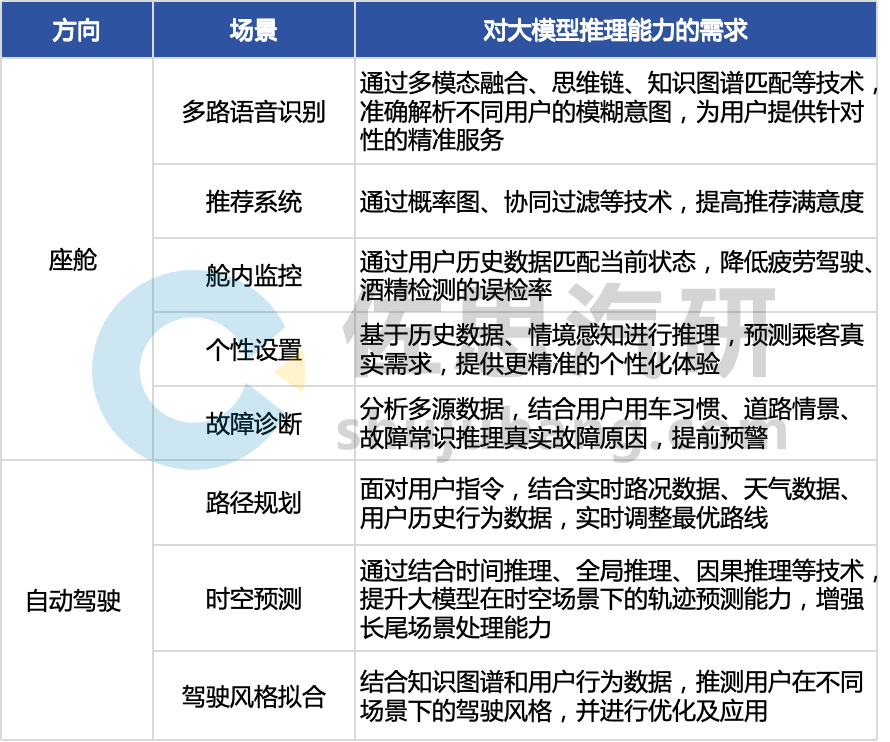

推理模型的密集上線,是為了提升大模型在復雜場景下的應對能力,同時也為Agent上線奠定基礎;具體到汽車行業,汽車大模型推理能力的提升,能夠切實解決AI應用場景下的痛點問題,如加強座艙助手對復雜語義的意圖識別和提升自動駕駛規劃決策中的時空預測場景精度。

部分汽車AI應用場景下對大模型推理能力的需求

整理:佐思汽研

2024年,上車的主流大模型推理技術仍以思維鏈CoT及其變種為主(如思維樹ToT、思維圖GoT、思維森林FoT等),在不同的場景下會融合生成模型(如擴散模型)、知識圖譜、因果推理模型、累積推理、多模態推理鏈等技術。

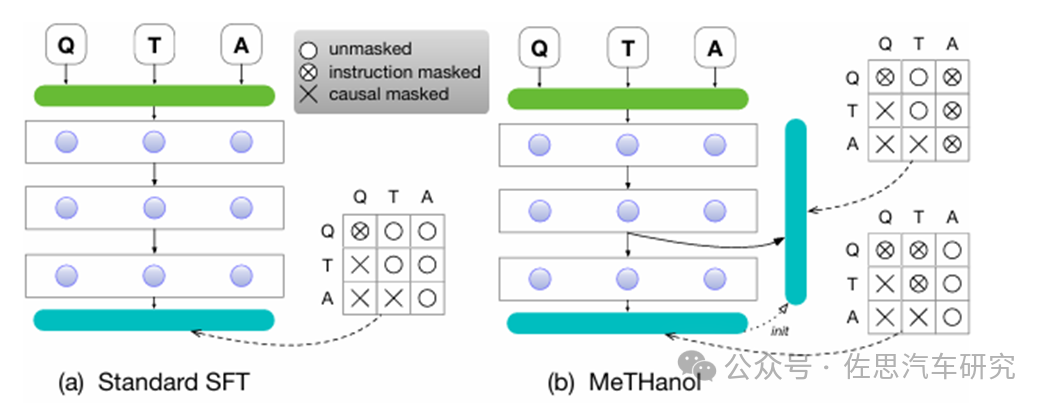

如吉利提出模塊化思維語言模型(MeTHanol),讓大語言模型合成人類思維并用于監督 LLM 的隱藏層,通過適應日常對話和個性化提示,生成類似人類的思維行為,增強大語言模型的思維和推理能力,并提升可解釋性。

MeTHanol(含中間思維層的雙層微調和兩階段推理)與標準SFT技術的對比

來源:吉利

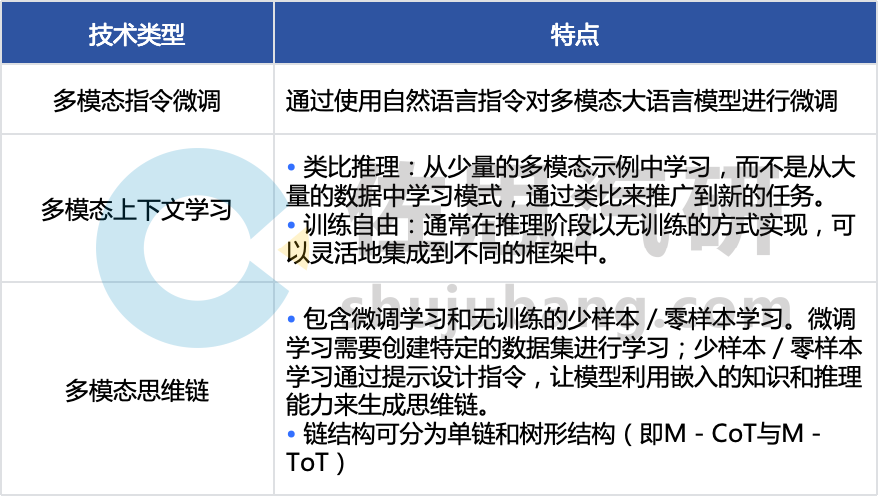

2025年,推理技術的重點會向多模態推理轉移,常用的訓練技術包括指令微調、多模態上下文學習與多模態思維鏈(M - CoT)等,多通過多模態融合對齊技術與LLM的推理技術結合而成。

部分多模態推理技術

整理:佐思汽研

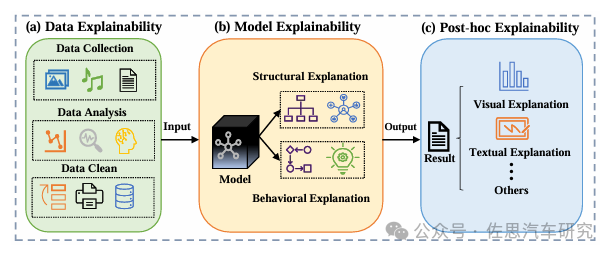

可解釋性成為AI與用戶的信任橋梁

在用戶體會到AI的“好用”之前,首先需要滿足用戶對AI的“信任”,所以,2025年,AI系統運行的可解釋性成為汽車AI用戶基數增長的關鍵一環,該痛點也可通過長思維鏈的展示來解決。

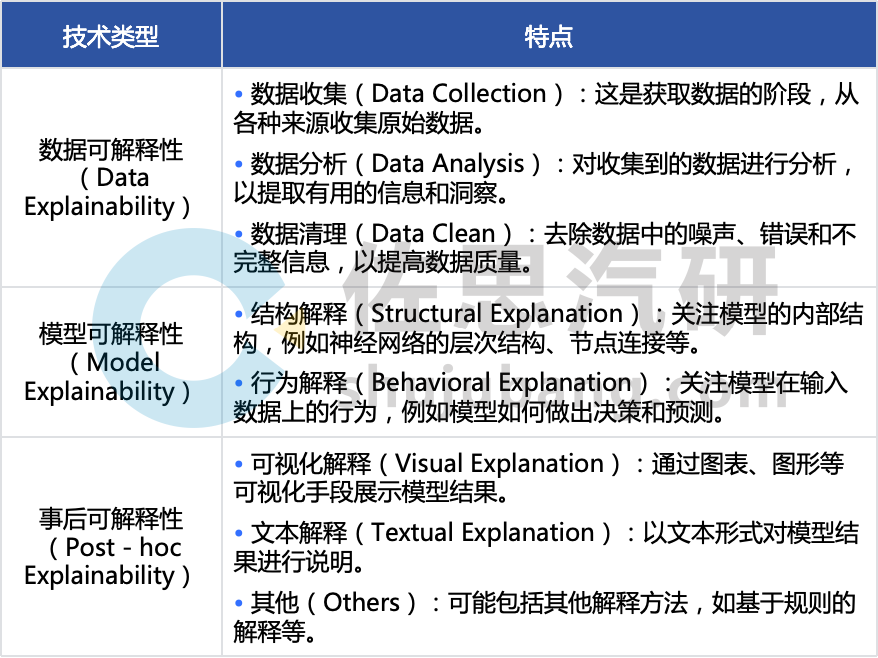

AI系統的可解釋性可通過數據可解釋性、模型可解釋性和事后可解釋性三個層面分別實現:

AI可解釋性的三個層面

來源:IEEE;整理:佐思汽研

以理想為例,理想 L3 智駕通過 “AI 推理可視化技術”,可直觀呈現端到端 + VLM 模型的思考過程,涵蓋從物理世界感知輸入到大模型完成行駛決策輸出的全流程,提升用戶對智能駕駛系統的信任。

理想L3智駕的可解釋性

來源:理想

理想的“AI推理可視化技術”中:

Attention(注意力系統)主要負責展示車輛感知到的交通和環境路況信息,能對實時視頻流中的交通參與者進行行為評估,并使用熱力圖展示評估對象。

E2E(端到端模型)用于展示行駛軌跡輸出的思考過程。模型會思考不同的行駛軌跡,展示 10 個候選輸出結果,最終采用概率最大的輸出結果作為行駛路徑。

VLM(視覺語言模型)可展示自身的感知、推理和決策過程,其工作過程使用對話形式展示。

同時,理想Agent“理想同學”也提供可視化的工作流:

“理想同學”工作流

來源:理想

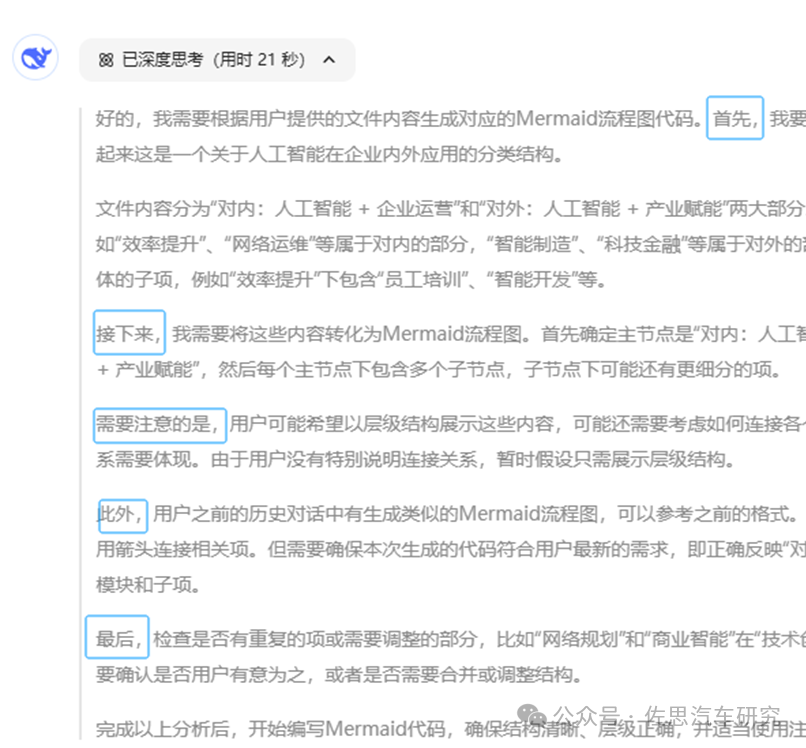

同樣通過長思維鏈進行推理流程拆解的還有各個推理模型的對話界面,以DeepSeek R1為例,在與用戶的對話中,會先通過思維鏈展示每一個節點的決策,并通過自然語言進行說明。

DeepSeek R1長思維鏈界面

來源:DeepSeek R1對話界面

此外,智譜的GLM-Zero-Preview、阿里的QwQ-32B-Preview、天工4.0 o1等大部分推理模型均支持長思維鏈推理流程展示。

DeepSeek降低大模型上車的門檻,性能提升與降本兼得

推理能力乃至綜合性能的提升,是否意味著需要付出高額成本?從DeepSeek的爆火來看,并不是。2025年初,主機廠先后接入DeepSeek,從應用詳情來看,基本上是以提升車載大模型的綜合能力為主。

2025年初,部分主機廠與DeepSeek合作情況

整理:佐思汽研

事實上,DeepSeek系列模型推出之前,各大主機廠已經按照自己的節奏有序推進旗下車載AI大模型的開發與迭代工作。以座艙助手為例,部分主機廠的方案已經初步完成構建,并已接入云端大模型供應商試運行或初步敲定供應商,其中不乏阿里云、騰訊云等云服務廠商以及智譜等大模型公司,2025年初再次接入DeepSeek,看重的包括:

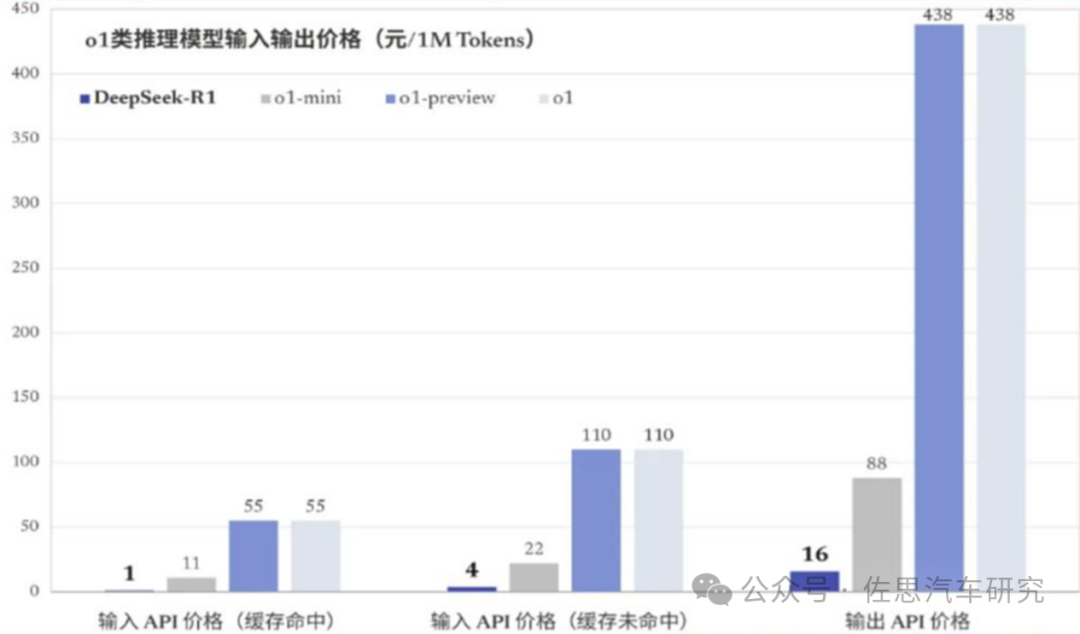

強大的推理性能表現,如推理模型R1的性能與OPEN AI 推理模型o1相當,甚至在數學邏輯方面更為突出;

更低的成本,在保證性能的同時,訓練與推理成本均保持在同行業較低水平。

DeepSeek R1與OPEN AI o1模型成本的比較

來源:公開信息

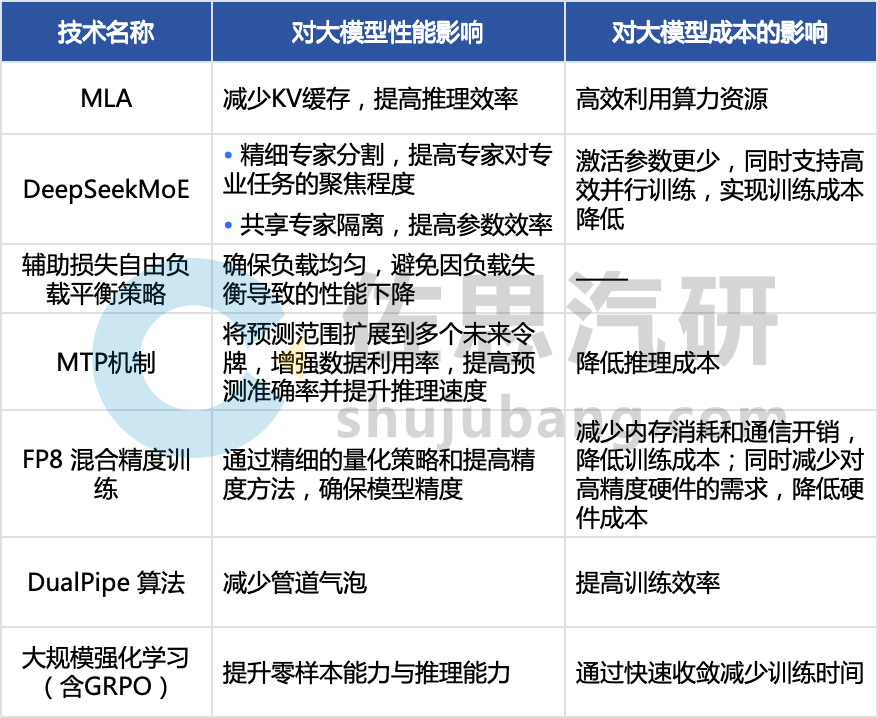

以上2點優勢均在DeepSeek的技術創新上有所體現:

DeepSeek系列的部分技術對大模型性能和成本的影響

整理:佐思汽研

通過接入DeepSeek,主機廠在部署智駕和座艙助手時,可以切實地降低大模型性能硬件采購、模型訓練與維護成本,同時保證性能不下降:

低計算開銷技術推動高階智駕、智艙平權,意味著低算力車載芯片(如邊緣計算單元)上也可實現部署高性能模型,降低對高成本GPU的依賴;再結合DualPipe算法、FP8混合精度訓練等技術,優化算力利用率,從而實現中低端車型也能部署高階座艙功能、高階智駕系統,加速智能座艙的普及。

實時性增強,在汽車行駛環境下,智駕系統需實時處理大量傳感器數據,座艙助手需要快速響應用戶指令,而車端計算資源有限。DeepSeek 計算開銷的降低使傳感器數據的處理速度更快,可更高效的利用智駕芯片算力(服務器端訓練階段,DeepSeek實現了對英偉達A100芯片90%的算力利用率),同時降低延遲(如在高通8650平臺上,芯片算力同為100TOPS時,使用DeepSeek推理響應時間從20毫秒降至9 - 10毫秒)。在智駕系統中,可確保駕駛決策及時準確,提升駕駛安全性和用戶體驗。在座艙系統中,支持座艙助手快速響應用戶語音指令,實現流暢人機交互。

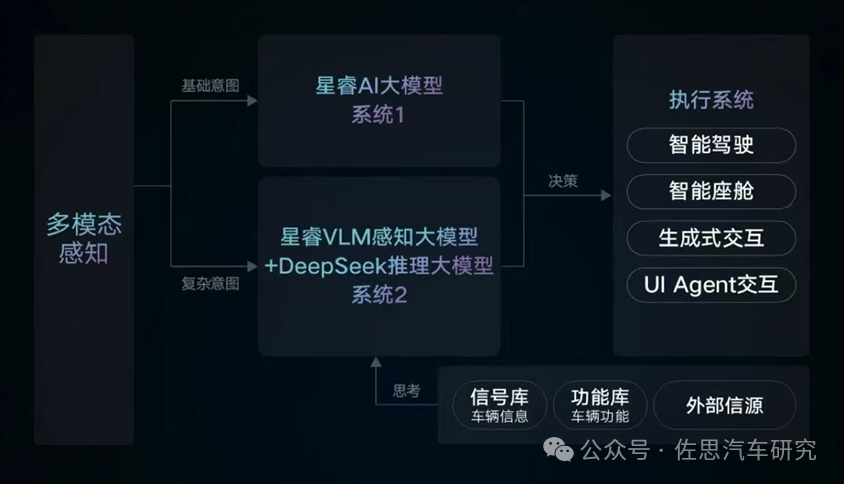

吉利星睿大模型的系統2接入DeepSeek R1

來源:吉利

-

AI

+關注

關注

87文章

34146瀏覽量

275289 -

汽車

+關注

關注

14文章

3794瀏覽量

39205 -

大模型

+關注

關注

2文章

3020瀏覽量

3806

原文標題:AI大模型及汽車應用研究:推理、降本和可解釋性

文章出處:【微信號:zuosiqiche,微信公眾號:佐思汽車研究】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

首創開源架構,天璣AI開發套件讓端側AI模型接入得心應手

為什么無法在運行時C++推理中讀取OpenVINO?模型?

了解DeepSeek-V3 和 DeepSeek-R1兩個大模型的不同定位和應用選擇

Qwen大模型助力開發低成本AI推理方案

小白學解釋性AI:從機器學習到大模型

AI模型思維鏈功能升級,提升透明度與可信度

OpenAI即將推出o3 mini推理AI模型

阿里云開源推理大模型QwQ

FPGA和ASIC在大模型推理加速中的應用

AI大模型在汽車應用中的推理、降本與可解釋性研究

AI大模型在汽車應用中的推理、降本與可解釋性研究

評論