在人工智能技術快速發展的浪潮下,現代數據中心網絡正面臨著前所未有的挑戰。GPT大模型的參數量已突破萬億級別,自動駕駛訓練需要處理PB級的場景數據,這些都使得AI計算集群規模呈指數級增長。

根據OpenAI披露的數據,GPT-4訓練使用的GPU數量已超過25,000個,這種大規模并行計算架構對網絡性能提出了嚴苛要求:網絡傳輸時延需要控制在微秒級,帶寬利用率必須達到80%以上,任何網絡抖動都會直接導致算力資源的閑置浪費。

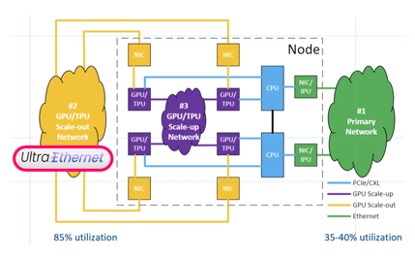

統計數據顯示,傳統以太網的平均利用率長期徘徊在35%-40%,這意味著超過60%的網絡帶寬資源處于閑置狀態。這種低效不僅造成巨額硬件投資浪費,更成為制約AI訓練效率的關鍵瓶頸。

傳統以太網的困境

網絡利用率作為衡量實際傳輸流量與理論帶寬比值的核心指標,在AI計算場景中直接決定模型訓練周期。這種效率瓶頸源于多重技術桎梏:

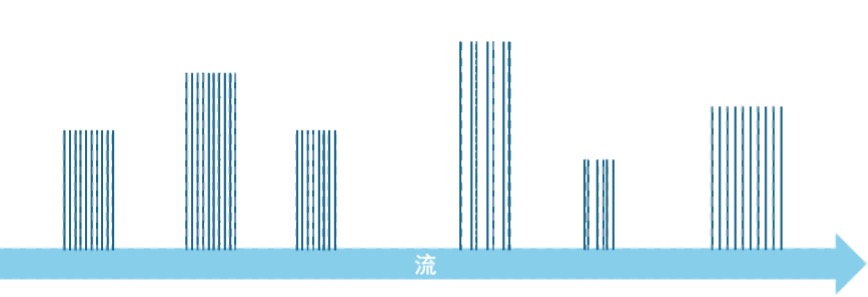

- 流量復雜度倍增:現代數據中心混合承載著AI訓練的長流(Long Flow)、推理服務的短流(Short Flow)、存儲復制的大包(Jumbo Frame)以及管理信令的小包(Mouse Flow)。這種流量形態的多樣性導致網絡必須按"峰值突發量×安全冗余"的超配模式建設,造成非峰值期大量帶寬閑置。

- 架構性阻塞難題:經典的接入-匯聚-核心三級架構存在天然的收斂比限制。以典型4:1收斂比設計為例,當接入層40G鏈路滿載時,匯聚層100G鏈路的理論利用率僅能達到80%,若考慮流量潮汐效應,實際利用率常低于50%。

- 丟包引發的鏈式反應:傳統QoS機制采用尾丟棄(Tail Drop)或WRED隨機丟棄策略應對擁塞,這種"先污染后治理"的方式觸發TCP超時重傳,導致有效帶寬被重傳數據重復占用。實測表明,1%的丟包率即可造成吞吐量下降40%。

- 流控機制鈍化:基于ECN的擁塞通知僅能傳遞1bit信息,終端設備需通過"探測-降速-恢復"的試探性調節適應帶寬變化。這種開環控制方式在應對AI訓練中的All-Reduce等集合通信時,調節延遲常超過100ms,造成帶寬利用的階段性塌陷。

- 路徑調度失衡:依賴五元組哈希的ECMP算法,在面對AI訓練中持續時間長達數小時、帶寬需求穩定的"大象流"時,極易引發路徑選擇的極化現象。某知名云廠商的故障案例顯示,40%的等價鏈路處于空載狀態時,剩余60%鏈路卻持續過載丟包。

超級以太網的技術突圍

為突破85%網絡利用率的目標,超級以太網聯盟(UEC)提出系統性解決方案:

1、專用通道隔離:利用AI流量可預測特性構建物理隔離的RoCEv2專用網絡。某頭部AI實驗室的實踐表明,通過分離訓練流量與存儲流量,網絡有效利用率提升27%,GPU空閑等待時間減少41%。

2、無阻塞拓撲:我們需要設計無阻塞的網絡結構,如CLOS、Dragonfly, Torus, MegaFly, SlimFly等。目前,CLOS是最流行的網絡結構 [3],在這個網絡結構中,總接入帶寬與總匯聚帶寬相等,并容易在縱向和橫向上擴展,在宏觀上實現了無阻塞。然而由于流量不均衡和微突發現象的存在,在局部鏈路上,擁塞仍然會存在。

3、精準擁塞控制升級:當In-Cast擁塞產生后,目前主要通過端到端的流控機制來緩解這一問題。例如,基于ECN的DCQCN/DCTCP技術通過調節源端的發送流量速率,適應網絡的可用帶寬。由于ECN攜帶的信息只有1個bit,這種調節方式不夠精確。為了解決這一問題,UEC傳輸層(UET,Ultra Ethernet Transport Layer)提出了以下改進措施:

- 加速調整過程:UET通過測量端到端延遲來調節發送速率,并根據接收方的能力通知發送方調整速率,快速達到線速。

- 基于遙測:來自網絡的擁塞信息可以通告擁塞的位置和原因,縮短擁塞信令路徑并向終端節點提供更多信息,從而實現更快的擁塞響應。

4、包噴灑:突破傳統流級調度的"包噴灑"技術,通過動態路徑選擇算法將數據包離散分布在多條路徑,從而更充分地利用網絡帶寬。由于這種方式會導致目的地接收到的報文亂序,因此需要修改傳輸協議,允許包亂序到達,并在目的地重新組裝為完整的消息。然而,重組過程帶來了額外的開銷,增加了整個流的延遲,且目的端需要等待該流的所有包傳輸完畢后才能處理整個消息,無法實現流水線操作。

實踐突破

作為UEC核心成員,星融元通過三大技術創新將網絡利用率推升至90%:

Flowlet

前面提到,基于流的ECMP容易造成負載不均衡,而包噴灑技術又帶來了額外的延遲。有沒有兩全其美的技術?flowlet應運而生。Flowlet是根據流中的“空閑”時間間隔將一個流劃分為若干片段。在一個flowlet內,數據包在時間上緊密連續;而兩個flowlet之間,存在較大的時間間隔。這一間隔遠大于同一流分片內數據包之間的時間間隔,足以使兩個流分片通過不同的網絡路徑傳輸而不發生亂序。

并行計算過程中,計算和通信是交替進行的。因而AI并行訓練和推理產生的流量是典型的flowlet。

當網絡發生擁塞時,可將flowlet調度到較空閑的鏈路上以緩解壓力。在AI訓練和推理網絡中,RDMA流通常較持久,訓練流可能持續數分鐘至數小時,推理流多為數秒至數分鐘,而flowlet則以微秒到毫秒級的短暫突發為主。這種基于flowlet的精細調度能有效優化流量分配,顯著降低網絡擁塞,從而提高網絡利用率。

基于遙測的路由

將傳統OSPF的靜態度量升級為時延、丟包、利用率等多維度動態權重。通過部署在Spine層的分布式決策單元,實現10ms級別的全網狀態同步與路徑重計算。某自動駕駛公司的實測表明,突發流量下的路徑切換延遲從秒級降至毫秒級。

基于遙測的路由(Int-based Routing)技術結合OSPF、BGP和在網遙測(INT)技術,為網絡中任意一對節點之間計算多條路徑,每個路徑的開銷是動態測量的延遲,從而能夠根據實時的網絡負載進行路由,從而充分利用每個路徑的帶寬。

WCMP

ECMP技術將包、flowlet或整個流均勻的分布到多個路徑上,忽略了不同路徑上的實際負載。為了進一步提升網絡利用率。星融元采用加權代價多路徑(Weighted Cost Multiple Path)算法,基于遙測獲取的時延等信息,在時延更低的路徑上調度更多的流量,在時延更高的路徑上調度更少的流量,從而實現所有路徑的公平利用。在理想情況下,流量經過不同路徑的總時延是相等的,可充分利用所有可用帶寬。

隨著AI大模型參數規模突破10萬億,超級以太網正從技術概念演變為算力基礎設施的關鍵支柱。通過架構革新與協議棧重構,網絡利用率突破90%已具備工程可行性。這不僅意味著數據中心OPEX的大幅降低,更將推動AI訓練效率進入新的數量級,加速通用人工智能時代的到來。

【參考文獻】

[1] Ultra Ethernet Consortium, “Ultra Ethernet Introduction” 15th October 2024.

[2] Asterfusion, “Unveiling AI Data Center Network Traffic” https://cloudswit.ch/blogs/ai-data-center-network-traffic/.

[3] Asterfusion, “What is Leaf-Spine Architecture and How to Build it?” https://cloudswit.ch/blogs/what-is-leaf-spine-architecture-and-how-to-build-it/.

-

網絡

+關注

關注

14文章

7764瀏覽量

90359 -

負載均衡

+關注

關注

0文章

118瀏覽量

12530 -

DeepSeek

+關注

關注

1文章

773瀏覽量

1328

發布評論請先 登錄

mes工廠管理系統:如何讓設備利用率提升50%?

DeepSeek推動AI算力需求:800G光模塊的關鍵作用

了解DeepSeek-V3 和 DeepSeek-R1兩個大模型的不同定位和應用選擇

DeepSeek對芯片算力的影響

華納云:什么是負載均衡?優化資源利用率的策略

交換機內存利用率過高會是什么問題

代理IP的使用率和使用時長,主要被什么影響?

如何利用traceroute命令發現網絡中的負載均衡

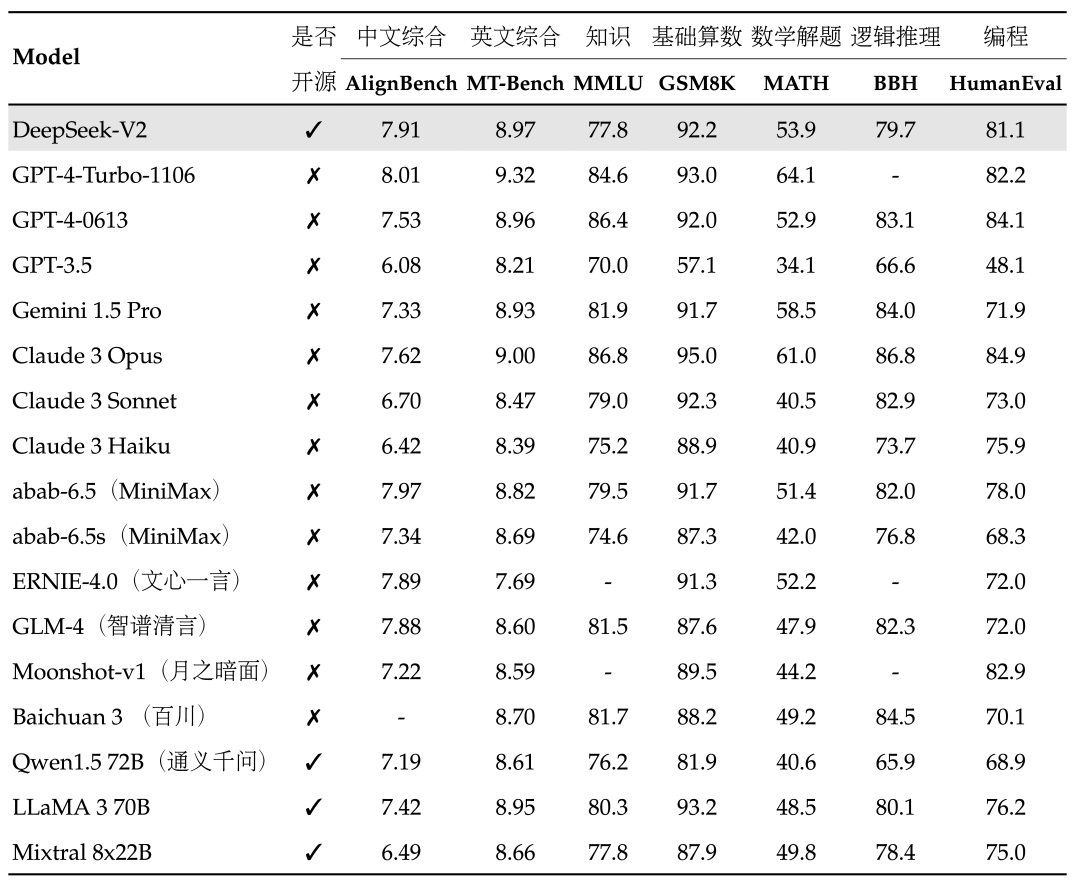

PerfXCloud順利接入MOE大模型DeepSeek-V2

DeepSeek MoE架構下的網絡負載如何優化?解鎖90%網絡利用率的關鍵策略

DeepSeek MoE架構下的網絡負載如何優化?解鎖90%網絡利用率的關鍵策略

評論