過去幾年時(shí)間里,我們有一個(gè)完整的團(tuán)隊(duì)致力于人工智能研究和實(shí)驗(yàn)。該團(tuán)隊(duì)專注于開發(fā)新的進(jìn)化計(jì)算方法(EC),包括設(shè)計(jì)人工神經(jīng)網(wǎng)絡(luò)架構(gòu)、構(gòu)建商業(yè)應(yīng)用程序,以及使用由自然進(jìn)化激發(fā)的方法來解決具有挑戰(zhàn)性的計(jì)算問題。這一領(lǐng)域的發(fā)展勢(shì)頭非常強(qiáng)勁。我們相信進(jìn)化計(jì)算很可能是人工智能技術(shù)的下一個(gè)重大課題。

EC與Deep Learning(DL)一樣都是幾十年前引入的,EC也能夠從可用的計(jì)算和大數(shù)據(jù)中得到提升。然而,它解決了一個(gè)截然不同的需求:我們都知道DL側(cè)重于建模我們已知的知識(shí),而EC則專注于創(chuàng)建新的知識(shí)。從這個(gè)意義上講,它是DL的下個(gè)步驟:DL能夠在熟悉的類別中識(shí)別對(duì)象和語音,而EC使我們能夠發(fā)現(xiàn)全新的對(duì)象和行為-最大化特定目標(biāo)的對(duì)象和行為。因此,EC使許多新的應(yīng)用成為可能:為機(jī)器人和虛擬代理設(shè)計(jì)更有效的行為,創(chuàng)造更有效和更廉價(jià)的衛(wèi)生干預(yù)措施,促進(jìn)農(nóng)業(yè)機(jī)械化發(fā)展和生物過程。

前不久,我們發(fā)布了5篇論文來報(bào)告在這一領(lǐng)域上取得了顯著的進(jìn)展,報(bào)告主要集中在三個(gè)方面:(1)DL架構(gòu)在三個(gè)標(biāo)準(zhǔn)機(jī)器學(xué)習(xí)基準(zhǔn)測(cè)試中已達(dá)到了最新技術(shù)水平。(2)開發(fā)技術(shù)用于提高實(shí)際應(yīng)用發(fā)展的性能和可靠性。(3)在非常困難的計(jì)算問題上證明了進(jìn)化問題的解決。

本文將重點(diǎn)介紹里面的第一個(gè)領(lǐng)域,即用EC優(yōu)化DL架構(gòu)。

Sentient揭示了神經(jīng)進(jìn)化的突破性研究

深度學(xué)習(xí)的大部分取決于網(wǎng)絡(luò)的規(guī)模和復(fù)雜性。隨著神經(jīng)進(jìn)化,DL體系結(jié)構(gòu)(即網(wǎng)絡(luò)拓?fù)洹⒛K和超參數(shù))可以在人類能力之外進(jìn)行優(yōu)化。我們將在本文中介紹三個(gè)示例:Omni Draw、Celeb Match和Music Maker(語言建模)。在這三個(gè)例子中,Sentient使用神經(jīng)進(jìn)化成功地超越了最先進(jìn)的DL基準(zhǔn)。

音樂制作(語言建模)

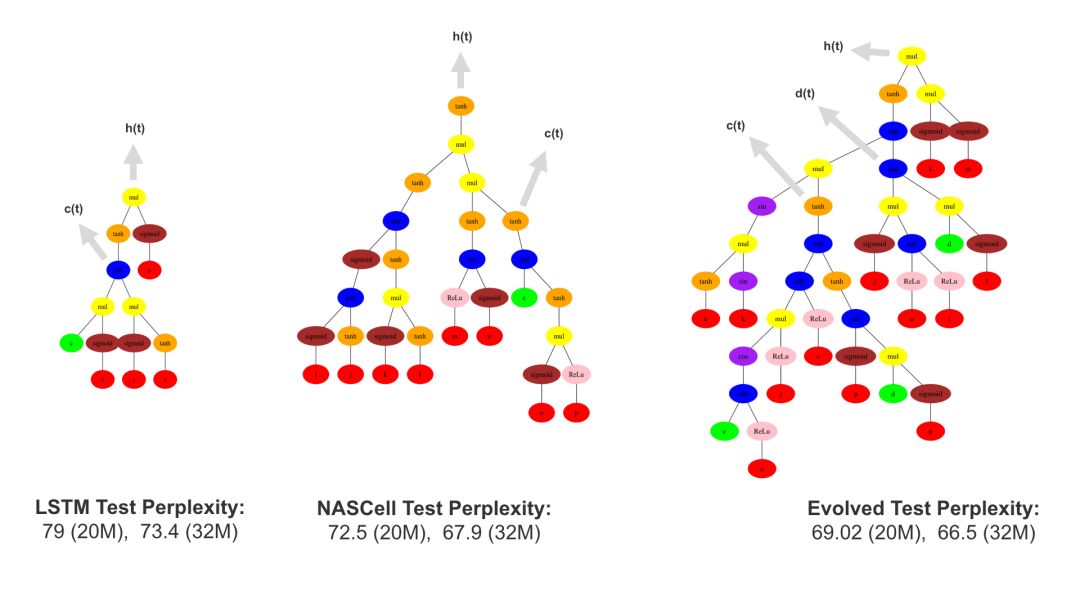

在語言建模領(lǐng)域,系統(tǒng)被訓(xùn)練用來預(yù)測(cè)“語言庫”中的下一個(gè)單詞,例如《華爾街日?qǐng)?bào)》幾年內(nèi)的大量文本集合,在網(wǎng)絡(luò)做出預(yù)測(cè)結(jié)果后,這個(gè)輸入還可以被循環(huán)輸入,從而網(wǎng)絡(luò)可以生成一個(gè)完整的單詞序列。有趣的是,同樣的技術(shù)同樣適用于音樂序列,以下為一個(gè)演示。用戶輸入一些初始音符,然后系統(tǒng)根據(jù)該起始點(diǎn)即興創(chuàng)作一首完整的旋律。通過神經(jīng)元進(jìn)化,Sentient優(yōu)化了門控周期性(長(zhǎng)期短期記憶或LSTM)節(jié)點(diǎn)(即網(wǎng)絡(luò)的“記憶”結(jié)構(gòu))的設(shè)計(jì),使模型在預(yù)測(cè)下一個(gè)音符時(shí)更加準(zhǔn)確。

在語言建模領(lǐng)域(在一個(gè)叫Penn Tree Bank的語言語料庫中預(yù)測(cè)下一個(gè)詞),基準(zhǔn)是由困惑點(diǎn)定義的,用來度量概率模型如何預(yù)測(cè)真實(shí)樣本。當(dāng)然,數(shù)字越低越好,因?yàn)槲覀兿MP驮陬A(yù)測(cè)下一個(gè)單詞時(shí)“困惑”越少越好。在這種情況下,感知器以10.8的困惑點(diǎn)擊敗了標(biāo)準(zhǔn)的LSTM結(jié)構(gòu)。值得注意的是,在過去25年內(nèi),盡管人類設(shè)計(jì)了一些LSTM變體,LSTM的性能仍然沒有得到改善。事實(shí)上,我們的神經(jīng)進(jìn)化實(shí)驗(yàn)表明,LSTM可以通過增加復(fù)雜性,即記憶細(xì)胞和更多的非線性、平行的途徑來顯著改善性能。

為什么這個(gè)突破很重要?語言是人類強(qiáng)大而復(fù)雜的智能構(gòu)造。語言建模,即預(yù)測(cè)文本中的下一個(gè)單詞,是衡量機(jī)器學(xué)習(xí)方法如何學(xué)習(xí)語言結(jié)構(gòu)的基準(zhǔn)。因此,它是構(gòu)建自然語言處理系統(tǒng)的代理,包括語音和語言接口、機(jī)器翻譯,甚至包括DNA序列和心率診斷等醫(yī)學(xué)數(shù)據(jù)。而在語言建模基準(zhǔn)測(cè)試中我們可以做得更好,可以使用相同的技術(shù)建立更好的語言處理系統(tǒng)。

Omni Draw

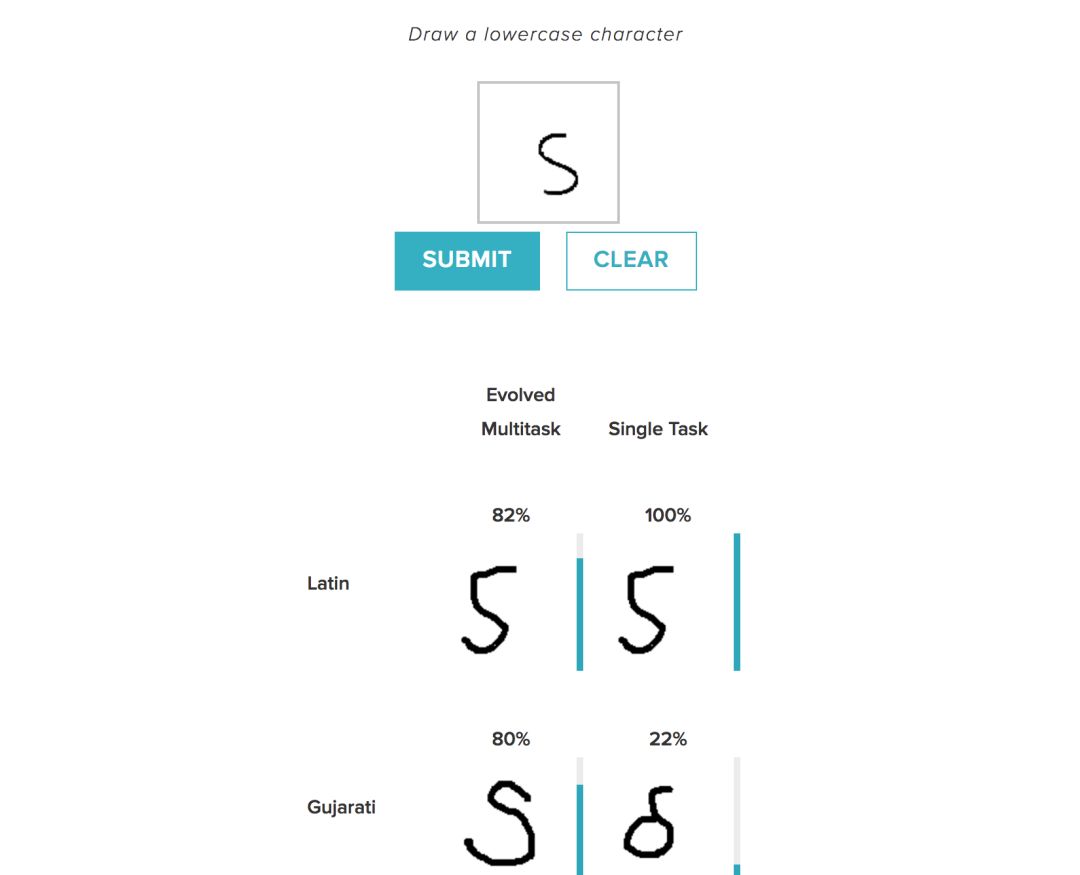

Omniglot是一種可以識(shí)別50種不同字母字符的手寫字符識(shí)別基準(zhǔn),包括像西里爾語(書面俄語)、日語和希伯來語等真實(shí)語言,以及諸如Tengwar(《指環(huán)王》中的書面語言)等人工語音。

上圖示例展示了多任務(wù)學(xué)習(xí),模型可以同時(shí)學(xué)習(xí)所有語言,并利用不同語言中字符之間的關(guān)系。例如,用戶輸入圖像,系統(tǒng)根據(jù)匹配輸出不同語言的含義,“這將是拉丁語中的X,日語中的Y以及Tengwar中的Z等等”——利用日本、Tengwar和拉丁語之間的關(guān)系找出哪些角色是最好的匹配。這與單一任務(wù)學(xué)習(xí)環(huán)境不同,單一環(huán)境下模型只對(duì)一種語言進(jìn)行訓(xùn)練,并且不能在語言數(shù)據(jù)集上建立相同的連接。

雖然Omniglot是一個(gè)數(shù)據(jù)集的例子,但每個(gè)語言的數(shù)據(jù)相對(duì)較少。例如它可能只有幾個(gè)希臘字母,但很多都是日語。它能夠利用語言之間關(guān)系的知識(shí)來尋找解決方案。為什么這個(gè)很重要?對(duì)于許多實(shí)際應(yīng)用程序來說,標(biāo)記數(shù)據(jù)的獲取是非常昂貴或危險(xiǎn)的(例如醫(yī)療應(yīng)用程序、農(nóng)業(yè)和機(jī)器人救援),因此可以利用與相似或相關(guān)數(shù)據(jù)集的關(guān)系自動(dòng)設(shè)計(jì)模型,在某種程度上可以替代丟失的數(shù)據(jù)集并提高研究能力。這也是神經(jīng)進(jìn)化能力的一個(gè)很好的證明:語言之間可以有很多的聯(lián)系方式,并且進(jìn)化發(fā)現(xiàn)了將他們的學(xué)習(xí)結(jié)合在一起的最佳方式。

Celeb Match

Celeb Match的demo同樣適用于多任務(wù)學(xué)習(xí),但它使用的是大規(guī)模數(shù)據(jù)集。該demo是基于CelebA數(shù)據(jù)集,它由約20萬張名人圖像組成,每張圖片的標(biāo)簽都由40個(gè)二進(jìn)制標(biāo)記屬性,如“男性與女性”、“有無胡子”等等。每個(gè)屬性都會(huì)產(chǎn)生一個(gè)“分類任務(wù)”,它會(huì)引導(dǎo)系統(tǒng)檢測(cè)和識(shí)別每個(gè)屬性。作為趣味附加組件,我們創(chuàng)建了一個(gè)demo來完成這項(xiàng)任務(wù):用戶可以為每個(gè)屬性設(shè)置所需的程度,并且系統(tǒng)會(huì)根據(jù)進(jìn)化的多任務(wù)學(xué)習(xí)網(wǎng)絡(luò)來確定最接近的名人。例如,如果當(dāng)前的圖片為布拉德·皮特的形象,用戶可以增加“灰色頭發(fā)”屬性,已發(fā)現(xiàn)哪個(gè)名人與他相似但是頭發(fā)不同。

在CelebA多任務(wù)人臉分類領(lǐng)域,Sentient使用了演化計(jì)算來優(yōu)化這些檢測(cè)屬性的網(wǎng)絡(luò),成功將總體三個(gè)模型的誤差從8%降到了7.94%。

這一技術(shù)使得人工智能在預(yù)測(cè)人類、地點(diǎn)和物質(zhì)世界各種屬性的能力上提升了一大步。與基于抽象,學(xué)習(xí)功能找到相似性的訓(xùn)練網(wǎng)絡(luò)不同,它使相似的語義和可解釋性也成為可能。

-

人工智能

+關(guān)注

關(guān)注

1804文章

48691瀏覽量

246429 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5554瀏覽量

122475

原文標(biāo)題:推薦!神經(jīng)進(jìn)化才是深度學(xué)習(xí)未來的發(fā)展之路!

文章出處:【微信號(hào):AItists,微信公眾號(hào):人工智能學(xué)家】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

Sentient揭示了人工智能神經(jīng)進(jìn)化的突破性研究

Sentient揭示了人工智能神經(jīng)進(jìn)化的突破性研究

評(píng)論