影視特效五花八門,在各類影片盡顯神通,讓畫面更沉浸、真實、絢麗。在如今AI當(dāng)潮的時代,通過深度學(xué)習(xí)、機器學(xué)習(xí)等方式,像人類一樣來“思考”,幫助人們在包括影視制作等行業(yè)中提速增效。ChatGPT、Midjourney以及Stable Diffusion等模型和應(yīng)用的出現(xiàn),也讓以人工智能生成內(nèi)容(AI-Generated Content, AIGC)等加速為影視制作領(lǐng)域帶來革新。

影視制作中的AI新嘗試

AIGC目前已經(jīng)在影視制作領(lǐng)域進行了多種嘗試,像智能剪輯、AI生成視頻、AI作畫等都已不是問題。除了特效制作,其實在影視制作流程中,還有一個關(guān)鍵且繁雜的步驟就是劇本拆解,把劇本中各項要素分析出來,再制作成拍攝計劃和預(yù)算表。其目的是為了明確角色定位,確保劇情連貫以及用于后期制作等。拆解的過程中有大量的數(shù)據(jù)錄入工作,因劇本的長短,需要大量的人工和時間來完成劇本的拆解。基于AI的人工智能劇本來拆解劇本,能很大程度上降低人力和時間成本,利用大語言模型的技術(shù),可以將劇本內(nèi)容自動拆解出場次,并分析出角色、對白、動作,整個過程需要幾秒到幾分鐘。

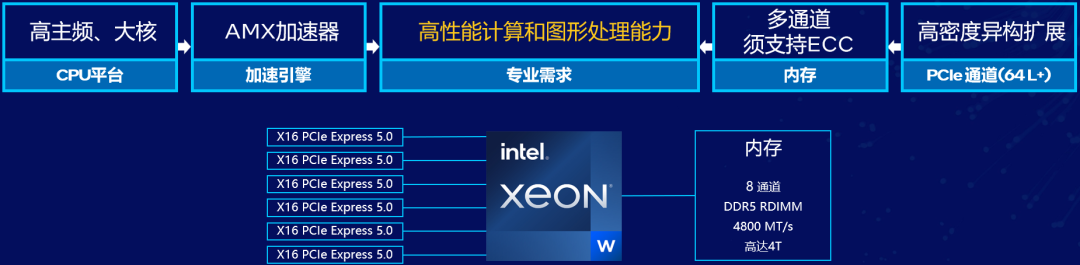

影視制作本身具有很大的移動性和靈活性,編劇和導(dǎo)演對劇本的處理上有非常強的隱私需求,私有化方案部署是一個強需求,加上劇組在拍攝過程中不停的轉(zhuǎn)場,這要求私有化部署,既要有足夠的算力制程,又可以靈活部署,跟著劇組一起移動。基于大語言模型的劇本拆解方案已經(jīng)成為主流的解決方案,部署大語言模型需要很強的異構(gòu)算力,足夠大的內(nèi)存容量,英特爾至強 W平臺剛好可以滿足該場景的需求,既能提供足夠的算力,又能擴展多個GPU,還能靈活部署,跟著劇組隨時移動。在擴展方面,英特爾 至強 W處理器有高達112通道的擴展,加上多大2T的內(nèi)存支持,還有高達60個可超頻核心,使得該平臺能擴展出非常強大的異構(gòu)算力。

AI助力,算力筑基

基于LLM模型等構(gòu)建的AIGC應(yīng)用在算力需求、數(shù)據(jù)規(guī)模上帶來更大挑戰(zhàn),尤其是LLM模型擁有的巨大參數(shù)規(guī)模需要更強的設(shè)備算力,更大的內(nèi)存帶寬等,開發(fā)者、創(chuàng)作者在設(shè)備或平臺的選擇上更具難度。

以往,這些體量龐大的網(wǎng)絡(luò)模型讓AI應(yīng)用背后的模型總是離不開云服務(wù)和數(shù)據(jù)中心這樣的部署環(huán)境,用戶需通過聯(lián)網(wǎng)接入才能開啟開發(fā)與創(chuàng)作之旅。在AIGC應(yīng)用更多下沉和落地于各行業(yè)、各領(lǐng)域的今天,其發(fā)展也需要更多開發(fā)者和創(chuàng)作者共同參與其中。這就需要AIGC的載體,以及對應(yīng)的開發(fā)/創(chuàng)作方案更為輕便、靈活和高效。英特爾不僅在AI領(lǐng)域有著全面的軟硬件產(chǎn)品體系和技術(shù)棧,也在AI應(yīng)用的行業(yè)落地和方案優(yōu)化部署上有著豐富的經(jīng)驗和實戰(zhàn)案例。

軟件能力也是AI PC體驗的關(guān)鍵,而英特爾在這方面有著獨特的優(yōu)勢地位。英特爾通過多個層面的軟件能力助力AIGC產(chǎn)業(yè)的發(fā)展。

首先是通過軟件來充分激發(fā)英特爾架構(gòu)硬件蘊含的算力,讓底層硬件性能更好地支撐上層的AIGC應(yīng)用,例如OpenVINO 工具套件全面支持英特爾異構(gòu)的硬件平臺,開發(fā)者可以靈活選用各種英特爾 CPU、GPU和NPU等計算引擎,滿足包括客戶端、邊緣計算的不同業(yè)務(wù)場景需求;同時提供包括面向低比特混合精度的量化在內(nèi)的多種軟硬件優(yōu)化策略等。

其次是通過廣泛地合作,對各類AI框架、平臺和加速庫提供面向英特爾 架構(gòu)的支撐和優(yōu)化。例如OpenVINO 工具套件廣泛支持PyTorch, TensorFlow, PaddlePaddle等主流AI框架,并與HuggingFace合作,借助Optimum Intel幫助開發(fā)者將更多HuggingFace的大語言模型進行壓縮優(yōu)化,并在英特爾的平臺上進行部署。

又如BigDL-LLM加速庫利用了低比特優(yōu)化和硬件優(yōu)化技術(shù),可以極低的時延運行和微調(diào)大語言模型,并支持各類標(biāo)準(zhǔn)PyTorch API(如HuggingFace Transformers和LangChain)和大模型工具,(如 HuggingFace PEFT、DeepSpeed、vLLM 等)。這種軟硬件協(xié)同的驅(qū)動力對AIGC應(yīng)用開發(fā)和創(chuàng)作帶來的助益是顯而易見的。以Stable Diffusion的使用為例,借助英特爾為其開發(fā)的AI框架,開發(fā)者可在開啟OpenVINO 工具套件的情況下,僅通過一行代碼的安裝,就可以加速PyTorch模型運行,并讓Automatic1111 for Stable Diffusion WebUI在英特爾銳炫 顯卡上流暢運行,從而快速生成高質(zhì)量圖片。

同時,英特爾也與眾多合作伙伴一起,通過開源社區(qū)、技術(shù)創(chuàng)新大會等形式,積極促進AIGC生態(tài)的發(fā)展、聯(lián)動與創(chuàng)新,并催化更多AIGC的應(yīng)用方案和落地實例。英特爾還在“AI PC加速計劃”中與超過200家ISV合作伙伴開展深度合作,并集合400余項AI加速功能,在2025年前為超過1億臺PC帶來AI特性。這些合作和AI加速功能顯然將進一步提升AIGC在各領(lǐng)域的產(chǎn)業(yè)落地。

AI推理和部署事半功倍的神器——OpenVINO 工具套件

在眾多加速AI落地的軟件工具中,OpenVINO 工具套件尤為突出,能夠加速AI推理及部署,且在異構(gòu)平臺上基于不同維度的AI方法,包括深度學(xué)習(xí)、基于注意力的網(wǎng)絡(luò)以及LLM等,幫助AI領(lǐng)域的開發(fā)者在計算機視覺、自動語音識別、自然語言處理以及推薦系統(tǒng)等場景中,加速相關(guān)應(yīng)用程序和解決方案的開發(fā)。OpenVINO 工具套件是一個開源工具包,通過降低延遲和提高吞吐量來加速AI推理,同時保持準(zhǔn)確性、減少模型占用空間并優(yōu)化硬件使用。它簡化了AI開發(fā)和深度學(xué)習(xí)在計算機視覺、大型語言模型(LLM)和生成式AI等領(lǐng)域的集成。OpenVINO 工具套件對大量流行AI框架(如PyTorch、TensorFlow、PaddlePaddle等)都提供了支持,同時也能借助硬件平臺(如英特爾 至強 處理器)的特性和內(nèi)置加速器增加AI應(yīng)用的功能和性能。隨著最新版本OpenVINO 工具套件2025.0(2025年2月發(fā)布)的推出,為更多GenAI覆蓋和框架集成,更廣泛的大型語言模型(LLM)支持和更多模型壓縮技術(shù),更多的便攜性和性能以在邊緣、云端或本地運行AI提供了廣泛的支持。

01面向更多GenAI覆蓋和框架集成,以最小化代碼更改

● 支持的新模型:Qwen 2.5、FLUX.1 Schnell和FLUX.1 Dev。

● Whisper模型:在CPU、內(nèi)置GPU和獨立GPU上通過GenAI API提高性能。

● 引入對torch.compile的NPU支持,使開發(fā)人員能夠使用OpenVINO后端在NPU上運行PyTorch API。啟用了來自TorchVision、Timm和TorchBench倉庫的300多個深度學(xué)習(xí)模型。

02面向更廣泛的大型語言模型(LLM)支持和更多模型壓縮技術(shù):

● GenAI API增加了Prompt Lookup功能,通過有效利用與預(yù)期用例匹配的預(yù)定義提示,改善了LLM的第二個令牌延遲。

● GenAI API現(xiàn)在提供圖像到圖像的修復(fù)功能。此功能使模型能夠通過修復(fù)指定的修改并將其與原始圖像無縫集成來生成逼真的內(nèi)容。

● 非對稱KV緩存壓縮現(xiàn)在在CPU上啟用了INT8,降低了內(nèi)存消耗并改善了第二個令牌延遲,特別是在處理需要大量內(nèi)存的長提示時。用戶應(yīng)明確指定此選項。

03面向更多的便攜性和性能,以在邊緣、云端或本地運行AI:

● 支持最新的英特爾 酷睿 Ultra 200H系列處理器(原代號為Arrow Lake-H)

● OpenVINO 后端與Triton推理服務(wù)器的集成使開發(fā)人員能夠在部署到英特爾CPU時利用Triton服務(wù)器來增強模型服務(wù)性能。

● 新的OpenVINO 后端集成允許開發(fā)人員直接在Keras 3工作流中利用OpenVINO性能優(yōu)化,以在CPU、內(nèi)置GPU、獨立GPU和NPU上實現(xiàn)更快的AI推理。此功能在最新的Keras 3.8版本中可用。

● OpenVINO模型服務(wù)器現(xiàn)在支持原生Windows服務(wù)器部署,使開發(fā)人員能夠通過消除容器開銷和簡化GPU部署來利用更好的性能。

AI出色落地,首推英特爾i+i平臺

金蛇獻瑞之際,AI大模型的開源策略點燃了整個行業(yè)應(yīng)用大爆發(fā),隨即迎來了推理元年,大語言模型的部署占據(jù)了成本的大頭,主要是用了很多GPU來協(xié)同推理,如何降低部署成本,英特爾給出了完整的解決方案,基于至強平臺搭配英特爾消費級顯卡銳炫A770或者馬上發(fā)布的BMG大顯存產(chǎn)品,大幅降低部署成本。比如2張或4張銳炫A770(16GB顯存)可推理Qwen-32B模型,推理框架是基于英特爾所支持的vllm serving來部署,拉取一個鏡像,掛著Hugging Face的開源模型即可提供OpenAI API兼容的大語言模型服務(wù)。

目前業(yè)界火熱的蒸餾模型,包括1.5B、7B、14B、32B,以及70B的開源模型,英特爾都已經(jīng)完成適配,2卡可以部署14B模型,4卡可以部署32B的模型,8卡可以部署70B模型。不同GPU密度可搭配不同的平臺,包括至強W的單路平臺和雙路的至強SP平臺,可滿足云邊數(shù)據(jù)中心,以及腰部以下客戶的真實部署需求。

-

英特爾

+關(guān)注

關(guān)注

61文章

10163瀏覽量

173851 -

AI

+關(guān)注

關(guān)注

87文章

34071瀏覽量

275192 -

影視制作

+關(guān)注

關(guān)注

0文章

8瀏覽量

2019

原文標(biāo)題:視效制作入門秘籍——加點AI,影視制作更精彩

文章出處:【微信號:英特爾中國,微信公眾號:英特爾中國】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

直擊Computex2025:英特爾重磅發(fā)布新一代GPU,圖形和AI性能躍升3.4倍

英特爾發(fā)布全新GPU,AI和工作站迎來新選擇

英特爾銳炫顯卡提高藝術(shù)靈感與生產(chǎn)力的轉(zhuǎn)化效率

英特爾?NCS2運行演示時“無法在啟動后找到啟動設(shè)備”怎么解決?

影視制作方程式:銳炫X AI的優(yōu)雅解法

英特爾揭秘影視制作軟件的法術(shù)秘籍

英特爾塑造未來出行:AI增強型軟件定義汽車

英特爾推出全新英特爾銳炫B系列顯卡

英特爾發(fā)布全新企業(yè)AI一體化方案

英特爾計劃明年AI PC出貨一億臺

英特爾聚焦AI座艙

Inflection AI攜手英特爾推出企業(yè)級AI系統(tǒng)

英特爾IT的發(fā)展現(xiàn)狀和創(chuàng)新動向

英特爾發(fā)布AI創(chuàng)作應(yīng)用AI Playground,將于今夏正式上線!

英特爾解讀影視制作中的AI新嘗試

英特爾解讀影視制作中的AI新嘗試

評論