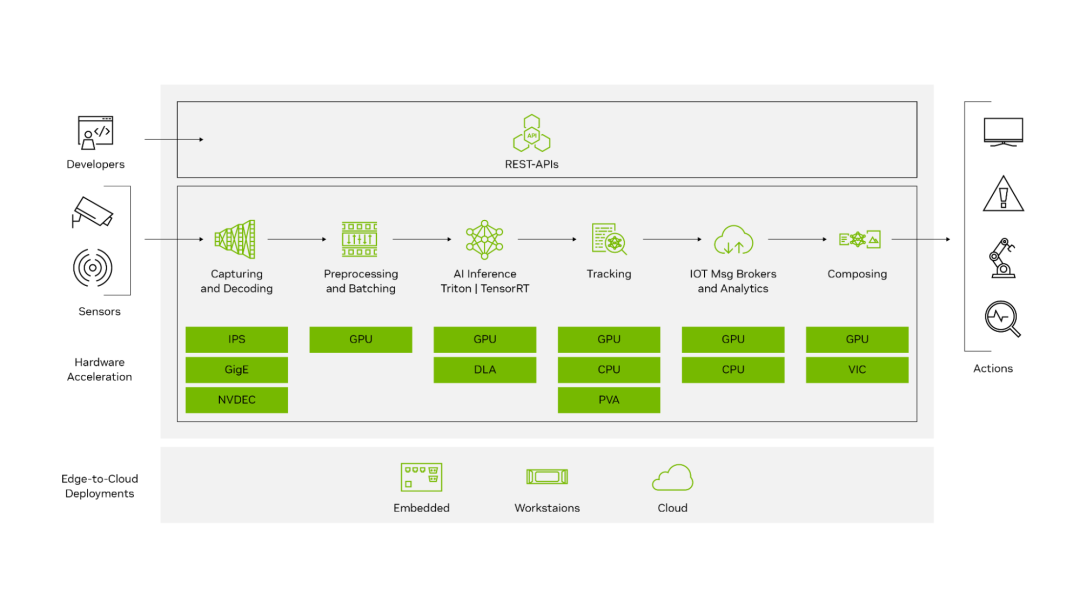

NVIDIA DeepStream 是一款功能強大的 SDK,能夠提供用于構建端到端視覺 AI 管線的 GPU 加速構建模塊。憑借 40 多個現成插件,您可以部署具備領先 AI 推理技術、對象追蹤功能,以及與常用的物聯網消息代理(如 EDIS、Kafka、MQTT 等)無縫集成的全面優化的管線。

DeepStream 提供直觀的 REST API,無論部署在遠端還是云端,都能控制您的 AI 管線。

圖 1. DeepStream SDK 工作流

最新發布的 DeepStream 7.0 是我們迄今為止最重要的版本之一,它將為您帶來生成式 AI 時代的突破性功能。該版本包含大量創新功能,可加速下一代應用開發。

版本包含以下亮點:

通過 Python API 使用新的 DeepStream 庫的全新開發途徑

利用全新 Service Maker 來簡化應用開發

增強的單視角 3D 追蹤器功能

通過 DeepStream 3D 框架支持傳感器融合模型 BEVFusion

支持適用于 Linux 的 Windows 子系統(WSL2)

利用 PipeTuner 來簡化 AI 管線的優化工作

DeepStream 庫:拓展開發者視野

在構建視覺 AI 應用時,首要任務是優化 AI 管線以獲得一流的性能。無論您是經驗豐富的專家還是剛剛入門的新手,都必須了解戰略全局。

大體上,有兩種主要方式可供選擇:

現有的開箱即用框架,如 GStreamer

在您自己的框架上加速關鍵構建塊的功能性 API

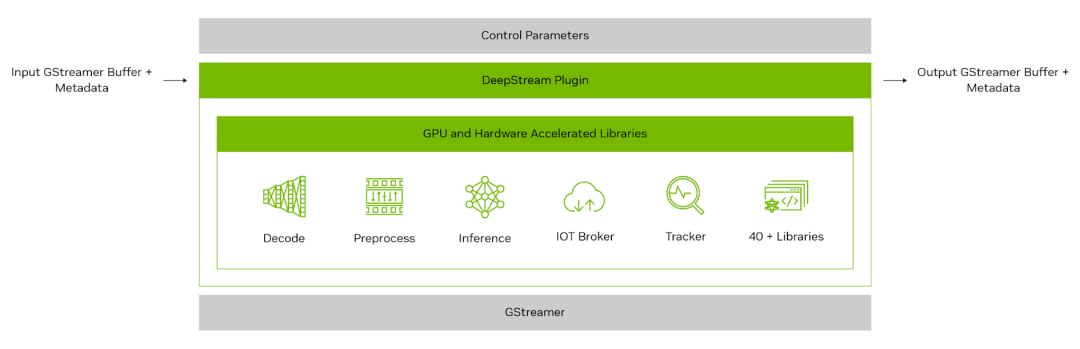

圖 2. 視覺 AI 應用工作流

圖 3 顯示了 DeepStream 插件的結構。在其核心,每個插件都將其基本功能封裝在一個庫中,這個庫可通過符合 GStreamer 插件規范且定義明確的接口進行訪問。

這種標準化方法確保了 GStreamer 生態系統內的無縫兼容和集成。DeepStream 通過在插件之間添加零內存拷貝,實現了最先進的性能。

圖 3. DeepStream 插件的高層架構

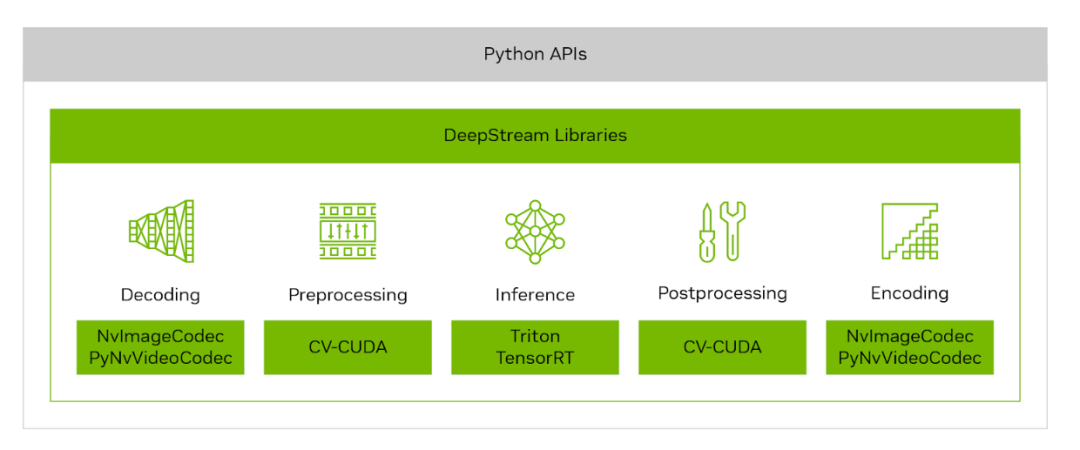

隨著 DeepStream 7.0 的推出,NVIDIA 為開發者開辟了新的途徑,讓他們可以繼續靈活地使用 GStreamer 的強大功能,或者通過直觀的 Python API 去挖掘 DeepStream 庫的強大性能。這種雙管齊下的方法不僅拓寬了 Python 開發者使用 NVIDIA 加速功能的途徑,而且還能將這些功能無縫集成到現有的 AI 框架中。

圖 4. DeepStream 庫

由 NVIDIA CV-CUDA、NvImageCodec 和 PyNvVideoCodec 支持的 DeepStream 庫提供了一系列低層級的 GPU 加速操作,可輕松地直接替代在視覺 AI 管線預處理和后處理階段中受 CPU 瓶頸限制的相應操作。

作為開源庫,它們提供了完全的透明度和必要的工具,以實現庫與庫之間和庫與熱門深度學習框架之間的零內存拷貝交互。通過 pip 安裝命令即可完成設置,這簡化了整個集成過程。

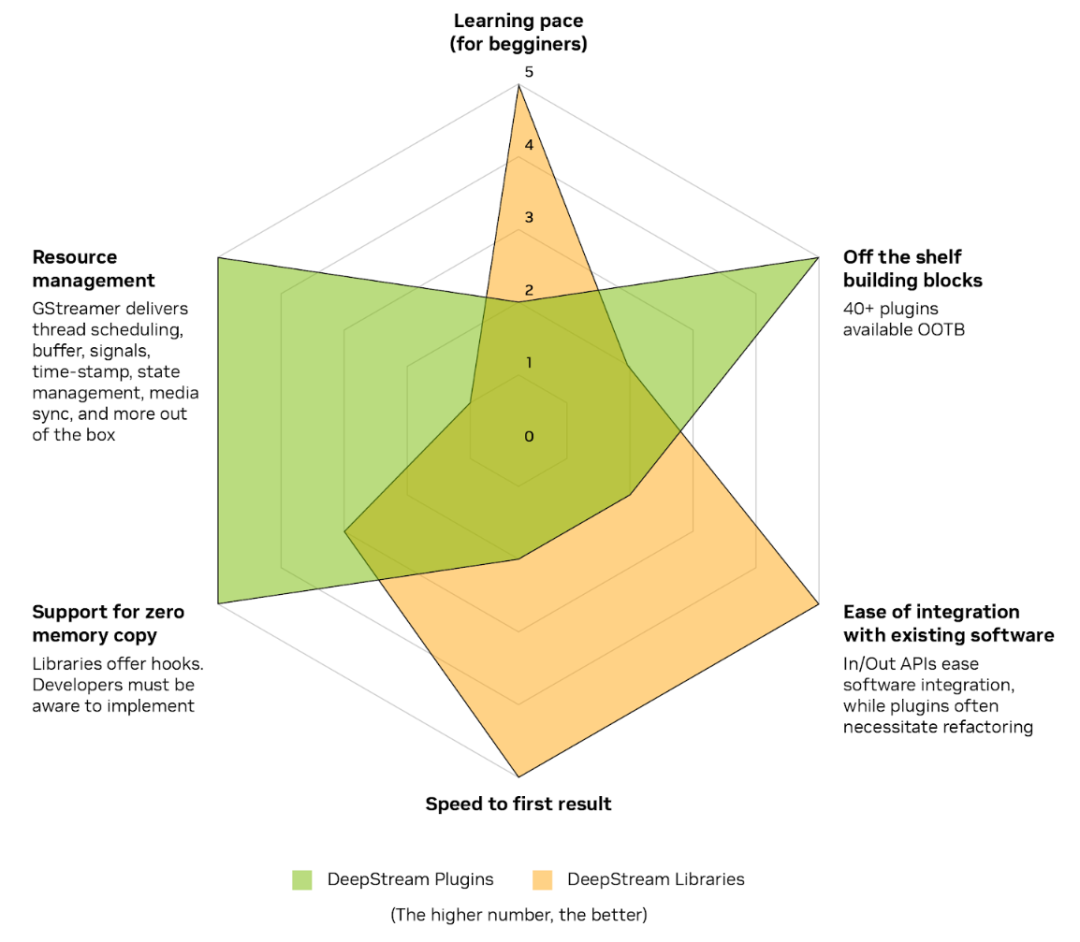

DeepStream 7.0 現在支持的兩種路徑有各自的優勢和權衡:

易于學習和集成:DeepStream 庫簡化了學習曲線,使您能夠快速集成 Python API 并見證 GPU 加速的直接優勢。一個最好的例子就是與 DeepStream 庫編解碼器的集成,只需編寫幾行代碼,就能迅速看到圖像或視頻幀加速解碼/編碼的影響。

即用型解決方案:成熟的 DeepStream 插件在與 GStreamer 框架相結合后,能夠為從零開始或沒有現有管線框架的用戶,提供一條快速上市部署的路徑。這些插件內置零內存拷貝和先進的資源管理功能,是實現高效應用開發的理想選擇。

圖 5. DeepStream 庫和插件之間的取舍

NVIDIA 計劃在未來不斷擴展 DeepStream 庫的支持范圍,并通過每次的新發布來進一步豐富開發者的體驗。

DeepStream Service Maker:

簡化應用開發

對于想要使用 GStreamer 的 DeepStream 開發者,我們還帶來了一個好消息:GStreamer 新手的學習速度將會很快。

NVIDIA 為 DeepStream 技術套件加入了一項突破性功能——DeepStream Service Maker。這項新功能通過將 GStreamer 的復雜性抽象化,大大簡化了開發流程,使每個人都能快速高效地構建面向對象的 C++ 應用。

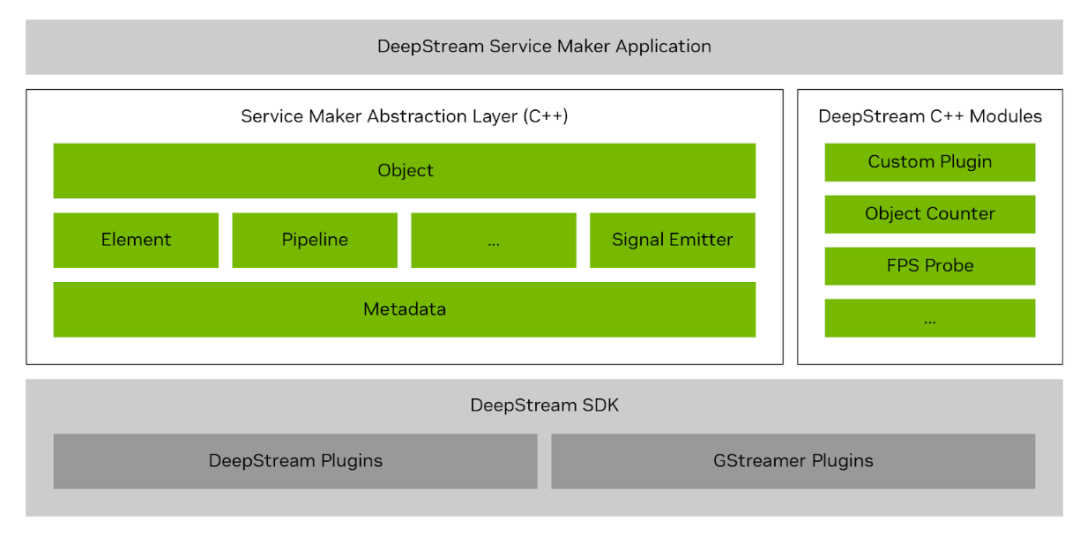

圖 6. DeepStream Service Maker 抽象層

您可以使用 DeepStream Service Maker 來快速構建管線、集成所需的插件、無縫連接這些插件以及發布應用,所有這些工作都只需幾分鐘時間。然后,您可以毫不費力地將這些應用打包到容器中,并通過 REST API 進行管理,從而打造一個大幅減少傳統編碼工作的精簡工作流。

Pipeline pipeline("deepstream-test1");

pipeline.add("filesrc", "src", "location", argv[1])

.add("h264parse", "parser")

.add("nvv4l2decoder", "decoder")

.add("nvstreammux", "mux", "batch-size", 1, "width", 1280, "height", 720)

.add("nvinfer", "infer", "config-file-path", CONFIG_FILE_PATH)

.add("nvvideoconvert", "converter")

.add("nvdsosd", "osd")

.add(sink, "sink")

.link("src", "parser", "decoder")

.link({"decoder", "mux"}, {"", "sink_%u"})

.link("mux", "infer", "converter", "osd", "sink")

.attach("infer", new BufferProbe("counter", new ObjectCounter))

.attach("infer", "sample_video_probe", "my probe", "src", "font-size", 20)

.start()

.wait();

考慮到那些不熟悉 GStreamer 的用戶,DeepStream Service Maker 讓開發過程變得更加直觀,同時它也為經驗豐富的開發者帶來了新的功能,完全支持自定義插件,如果您多年來一直投入時間創建自定義解決方案,這一點至關重要。

DeepStream Service Maker 將原來數百行的復雜編碼減少到幾行,徹底改變了處理和管理應用開發的方式,使這項工作變得前所未有的簡單和輕松。

DeepStream Service Maker 還能加速邊緣環境的應用開發,最適合用來為適用于 Jetson 的 Metropolis 微服務(MMJ)開發您自己的微服務。DeepStream Service Maker 還可作為微服務輕松部署到云端,并可通過 REST-API 進行控制。

視頻 1. 輕松構建、部署和控制視覺 AI 應用

使用 Service Maker 構建應用后,可將其輕松打包到容器中,然后通過直觀的 REST API 進行管理和動態控制,比如添加和刪除流,以及配置感興趣區域(ROI)等。

視頻 2. 使用 REST API 控制視覺 AI 應用

DeepStream Service Maker 的第一個版本支持 C++。未來的版本將支持 Python,從而擴大該工具的可訪問性和多功能性。

DeepStream 單視角 3D

NVIDIA DeepStream 最新版本對單視角 3D 追蹤(SV3DT)的追蹤器進行了重大改進。這一先進功能僅使用一個單攝像頭就能在 3D 空間內精確追蹤物體,從而在 3D 世界地平面上對物體進行精確定位。

SV3DT 的第一個版本將行人建模為地平面上的圓柱體。這種方法通過將腳部定位在圓柱體的底部來保證更加精確的定位,從而實現更加清晰、明確的運動呈現,而且定位不受遮擋程度的影響。

圖 7. DeepStream 單視角 3D 追蹤使用單攝像頭創建圓柱體和腳部位置

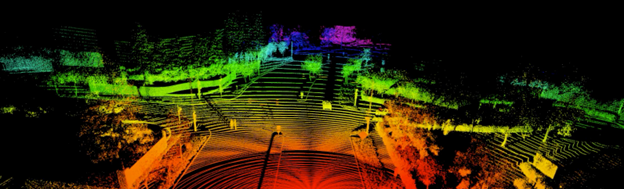

通過 DeepStream 3D 框架支持 BEVFusion

DeepStream 7.0 支持最令人興奮的傳感器融合 AI 模型之一——BEVFusion。DeepStream 7.0 增強了 DeepStream 3D(DS3D)框架,并增加了可與攝像頭輸入融合的激光雷達和雷達輸入。NVIDIA 正在致力于提供下一代環境感知解決方案。

通過以源代碼形式提供的底層庫精簡了與各種傳感器的集成,從而簡化了對不同傳感器廠商的支持。

通過與 DS3D 框架集成,BEVFusion 提供了一整套提高功能性和易用性的功能:

輕松實現可視化:在屏幕上渲染和旋轉激光雷達或 3D 數據,將激光雷達數據投影到圖像中,并從多個視角顯示 3D 邊界框。

支持消息代理: 默認與消息代理集成,以便快速高效地與其他子系統集成。

傳感器同步:強大的多傳感器數據(包括激光雷達、雷達和攝像頭)同步功能,支持文件輸入和實時流。該功能可適應不同的幀率并管理幀丟失,這對于現實世界應用的適應性來說至關重要。

對齊過濾器:根據不同傳感器的內在和外在參數進行數據對齊,實現適合各種傳感器數據對齊的精準定制。

定制 3D 數據預處理:支持激光雷達和雷達數據的定制預處理需求,提高處理精度和靈活性。

通用數據地圖管理:通過鍵值系統管理傳感器和張量數據的綜合陣列,實現數據監督和操作的精簡化。

憑借這些功能,帶有 BEVFusion 的 DeepStream 7.0 站在了 3D AI 開發的最前沿,為可從邊緣部署到云端的傳感器融合技術帶來了全新的可能性。

圖 8. 通過 BEVFusion 和 DS3D 框架實現應用的傳感器融合

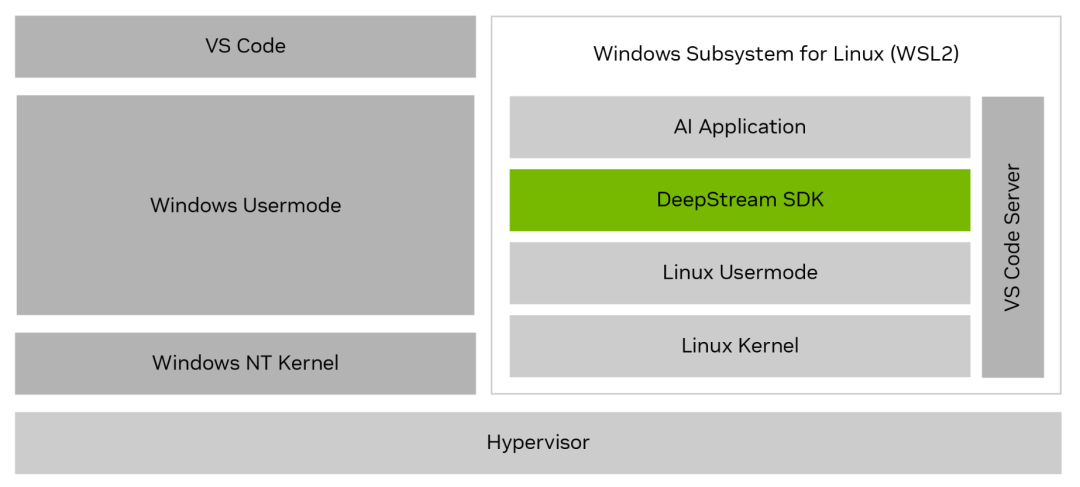

支持適用于 Linux 的Windows 子系統

現在可以使用適用于 Linux 的 Windows 子系統(WSL2)在 Windows 系統上開發 DeepStream 應用。該更新是一項重大進步,也是在以 Windows 為標準的 IT 批準系統上進行開發的客戶經常提出的一項要求。

通過在 WSL2 上集成 DeepStream,您無需遠程訪問 Linux 系統,就可以在一個系統上實現工作流的簡化。這項新功能可讓您無需進行復雜的雙系統設置就能使用 DeepStream 的強大功能,從而簡化開發流程并提高生產力。

DeepStream 對 WSL2 的支持,為直接在 Windows 上開發高級應用提供了所需的靈活性和便利性。您既能享受到與 Windows 的輕松兼容,又能同時受益于 DeepStream 的強大功能。

圖 9. WSL2 架構上的 DeepStream SDK

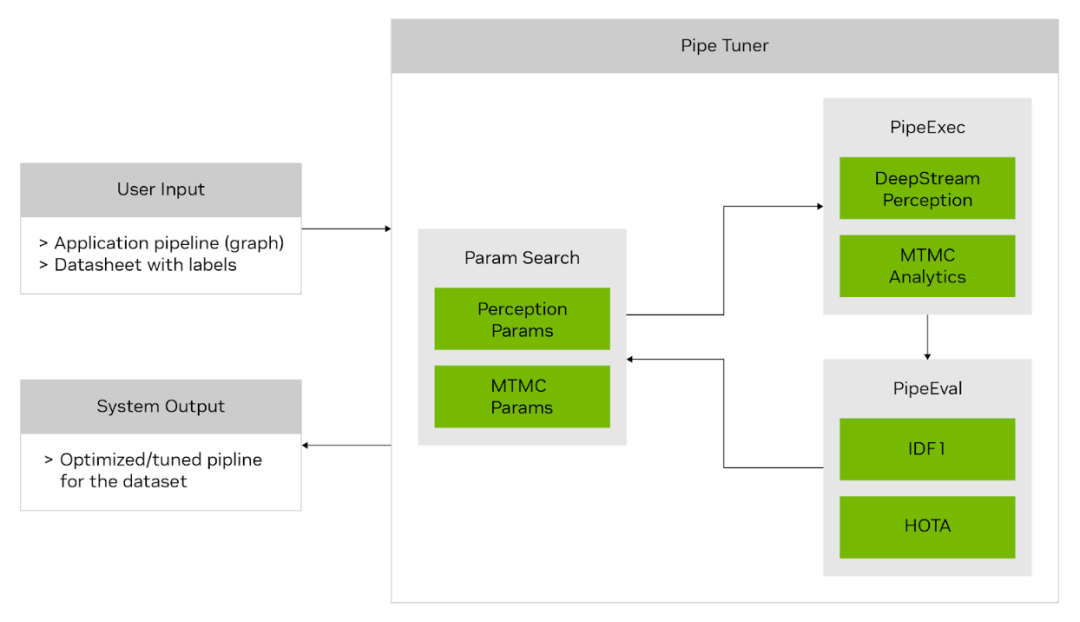

PipeTuner 1.0:簡化 AI 管線優化

PipeTuner 1.0 是一款全新的開發者工具,有望徹底改變 AI 管線的調整方式。AI 服務通常包含大量用于推理和追蹤的參數,因此尋找能夠最大程度提高特定用例準確性的最佳設置是一個復雜而關鍵的過程。

傳統的手動調整需要對每個管線模塊有深入的了解,這在廣泛、高維的參數空間中變得不切實際,即便有數據集和用于準確性分析的基準實況標簽的支持也是如此。

PipeTuner 就是為應對這些挑戰而設計的。PipeTuner 能夠高效探索參數空間并自動識別最佳參數,根據用戶提供的數據集實現最高的關鍵性能指標(KPI)。最重要的是,PipeTuner 簡化了這一流程,使用戶無需掌握管線及其參數的技術知識。

PipeTuner 1.0 目前處于開發者預覽階段。

圖 10. PipeTuner 工作流

通過集成 PipeTuner,您可以加快產品上市時間,并為每個部署地點量身定制 DeepStream 管線參數,確保在各種場景下都能實現最佳性能。讓每個人在所有用例和場景中都能獲得有效且先進的 AI 管線優化,這是朝著這一目標所邁出的重要一步。

審核編輯:劉清

-

傳感器

+關注

關注

2562文章

52552瀏覽量

763640 -

NVIDIA

+關注

關注

14文章

5238瀏覽量

105766 -

物聯網

+關注

關注

2927文章

45860瀏覽量

387893 -

MQTT

+關注

關注

5文章

669瀏覽量

23467

原文標題:NVIDIA 發布具有里程碑意義的 DeepStream 7.0,助力下一代視覺 AI 開發

文章出處:【微信號:NVIDIA-Enterprise,微信公眾號:NVIDIA英偉達企業解決方案】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

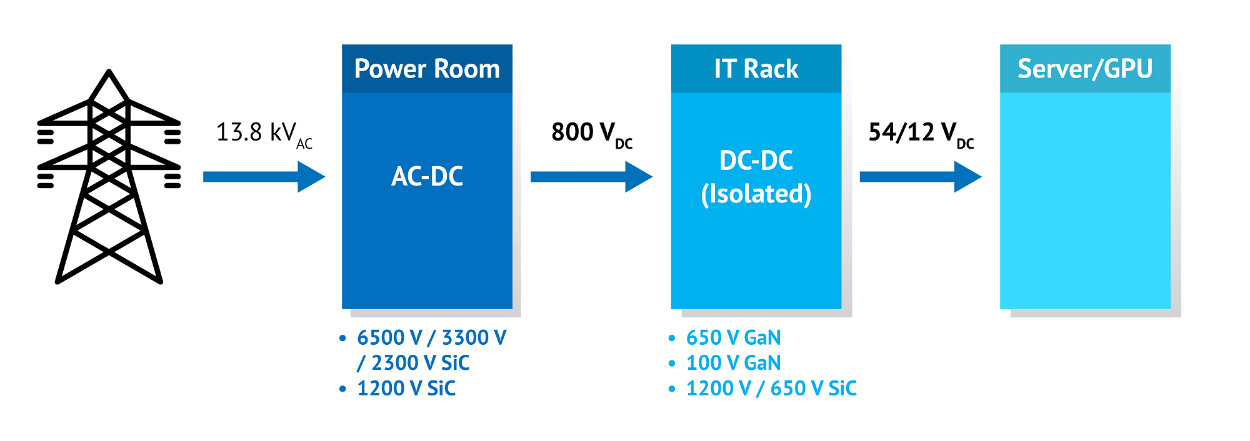

NVIDIA 采用納微半導體開發新一代數據中心電源架構 800V HVDC 方案,賦能下一代AI兆瓦級算力需求

維諦加速推進人工智能基礎設施演進,助力NVIDIA 800 VDC 電源架構發布

SEGGER發布下一代安全實時操作系統embOS-Ultra-MPU

Banana Pi 發布 BPI-AI2N & BPI-AI2N Carrier,助力 AI 計算與嵌入式開發

NVIDIA網絡安全AI平臺助力保護關鍵基礎設施

NVIDIA推出面向RTX AI PC的AI基礎模型

NVIDIA助力輕威科技開發下一代多人實時運動捕捉系統

使用全新NVIDIA AI Blueprint開發視覺AI智能體

印度制造商使用NVIDIA AI和 Omniverse創建工廠數字孿生

西門子EDA發布下一代電子系統設計平臺

NVIDIA RTX AI套件簡化AI驅動的應用開發

下一代高功能新一代AI加速器(DRP-AI3):10x在高級AI系統高級AI中更快的嵌入處理

國科微AI首席科學家邢國良:打造全系邊端AI芯片,賦能下一代自動駕駛

24芯M16插頭在下一代技術中的潛力

NVIDIA發布DeepStream 7.0,助力下一代視覺AI開發

NVIDIA發布DeepStream 7.0,助力下一代視覺AI開發

評論