根據(jù) OpenAI 官網(wǎng),AI 模型訓(xùn)練計(jì)算量自 2012 年起每 3.4 個(gè)月就增長(zhǎng)一倍。以 GPT-3 模型為例,根據(jù) lambdalabs 數(shù)據(jù),該模型參數(shù)規(guī)模達(dá) 1750 億,完整訓(xùn)練運(yùn)算量達(dá)3640PFlop/s-days(以 3640PFlop/s 速度進(jìn)行運(yùn)算,需要 3640 天)。模型完成單次訓(xùn)練約需要 355 個(gè) CPU 年并耗費(fèi) 460 萬美元(假設(shè)采用 Nvidia Tesla V100 芯片)。

高算力需求迫切,推動(dòng)AI基礎(chǔ)設(shè)施建設(shè)。高訓(xùn)練算力需要與相應(yīng)基礎(chǔ)設(shè)施匹配,根據(jù)《2022—2023中國(guó)人工智能算力發(fā)展評(píng)估報(bào)告》預(yù)計(jì),2023 年全球 AI 支出增速有望達(dá) 27.9%,而中國(guó)智能算力規(guī)模將達(dá) 427EFlop/s,同比增長(zhǎng) 59%。

AI 芯片:算力核心構(gòu)成,自主可控推動(dòng)國(guó)產(chǎn)化

人工智能芯片是 AI 算力的核心構(gòu)成。目前主流的 AI 芯片中 GPU 占據(jù)絕對(duì)百分比,根據(jù)IDC 數(shù)據(jù),2022 年 GPU 在中國(guó)人工智能芯片市場(chǎng)中占有率為 89%。根據(jù)我們測(cè)算,假設(shè)國(guó)內(nèi)每日訪問單個(gè)語言大模型的人數(shù)達(dá)到 3 億的情況下,對(duì) GPU 需求臺(tái)數(shù)為 13889 塊。

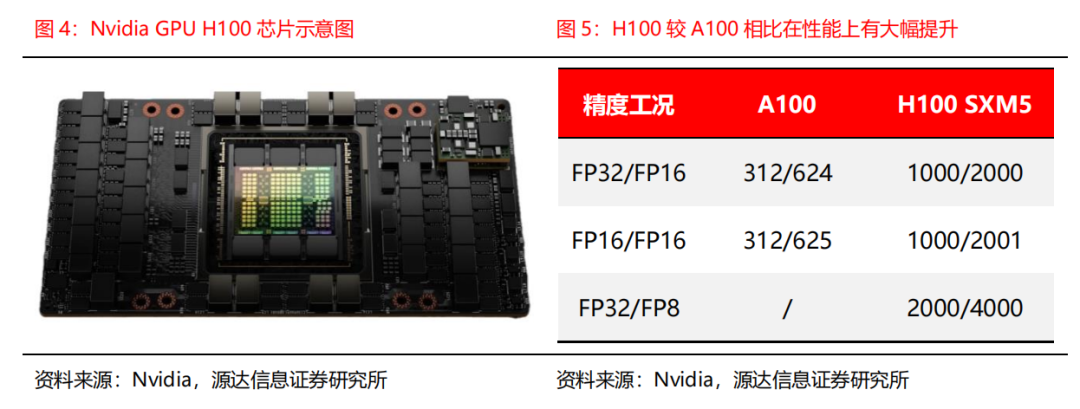

Nvidia H100 是目前最先進(jìn)的人工智能芯片。2023 年 3 月 22 日 Nvidia 推出新款人工智能芯片 GPU H100,與公司上一代產(chǎn)品 A100 相比性能得到大幅提升,在主流 AI 和 HPC模型中,采用 InfiniBand 互連技術(shù)的 H100 性能最高可達(dá) A100 的 30 倍。

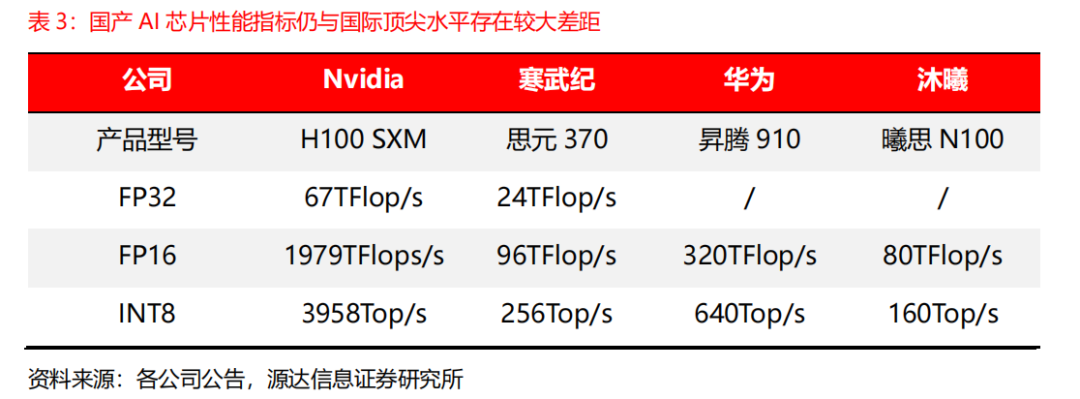

國(guó)產(chǎn)AI芯片短板明顯,下一代產(chǎn)品推進(jìn)順利。通過對(duì)國(guó)內(nèi)寒武紀(jì)、華為昇騰和沐曦等國(guó)產(chǎn)公司旗下的 AI 旗艦芯片與 Nvidia H100 SXM 的性能指標(biāo)對(duì)比,可以看到國(guó)產(chǎn) AI 芯片與 Nvidia H100 在性能上仍存在較大差距。同時(shí)國(guó)產(chǎn)芯片公司仍在加快研發(fā)推進(jìn)下一代 AI芯片產(chǎn)品,并有望在未來對(duì)標(biāo)Nvidia H100,如寒武紀(jì)在研的思元590、沐曦在研的MXC500等。

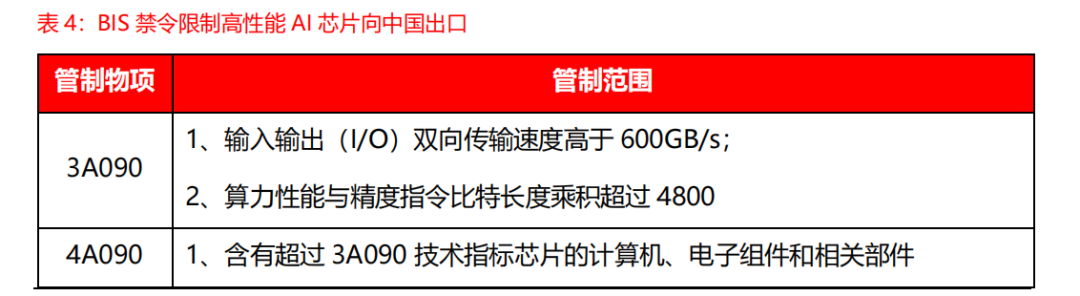

美國(guó)對(duì) AI 芯片出口管制,自主可控要求下國(guó)產(chǎn)芯片需求迫切。2022 年 10 月 7 日美國(guó)商務(wù)部工業(yè)安全局(BIS)發(fā)布《美國(guó)商務(wù)部對(duì)中華人民共和國(guó)(PRC)關(guān)于先進(jìn)計(jì)算和半導(dǎo)體實(shí)施新的出口管制制造》細(xì)則,其中管制物項(xiàng) 3A090、4A090 包含高性能 AI 芯片產(chǎn)品,而Nvidia A100 和 H100 均符合管制要求。在此背景下,Nvidia 推出性能閹割的中國(guó)特供版芯片 A800 和 H800。我們認(rèn)為在國(guó)內(nèi)自主可控大背景下,國(guó)內(nèi) AI 產(chǎn)業(yè)對(duì)國(guó)產(chǎn)芯片需求迫切,或加大對(duì)國(guó)產(chǎn)芯片公司支持力度,國(guó)產(chǎn) AI 芯片有望迎來技術(shù)進(jìn)步和市場(chǎng)機(jī)遇。

光模塊:新型網(wǎng)絡(luò)架構(gòu)對(duì)高端光模塊用量增加

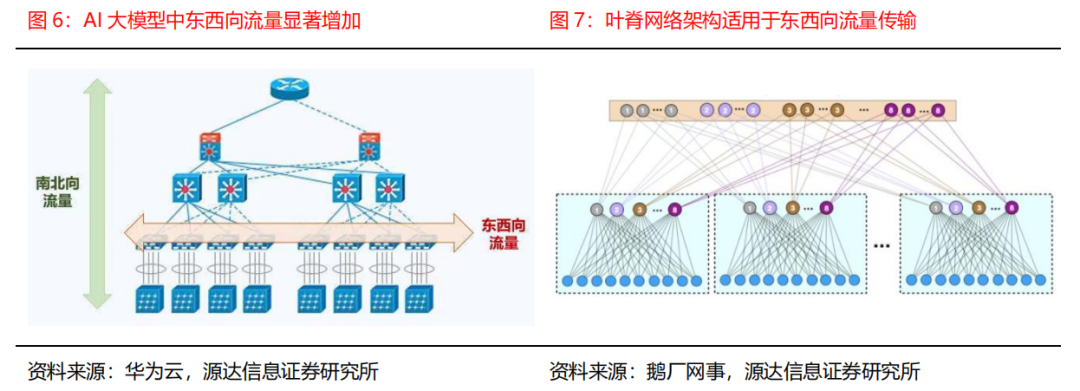

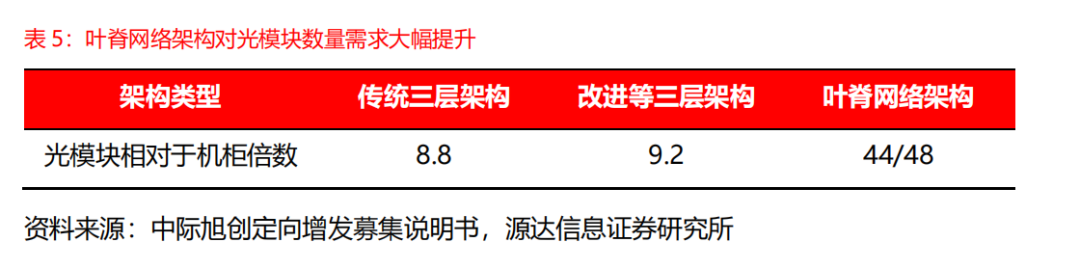

高算力需要與高效傳輸架構(gòu)相匹配。AI 大模型通常由多個(gè)服務(wù)器作為節(jié)點(diǎn),并通過高速網(wǎng)絡(luò)架構(gòu)組成集群合作完成模型訓(xùn)練。因此在模型中東西向流量(數(shù)據(jù)中心服務(wù)器間的傳輸流量)大幅增加,而模型訓(xùn)練過程中南北向流量(客戶端與服務(wù)器間的傳輸流量)較少,由于葉脊網(wǎng)絡(luò)架構(gòu)相較傳統(tǒng)三層架構(gòu)更適用于東西向流量傳輸,成為現(xiàn)代數(shù)據(jù)中心主流網(wǎng)絡(luò)架構(gòu)。

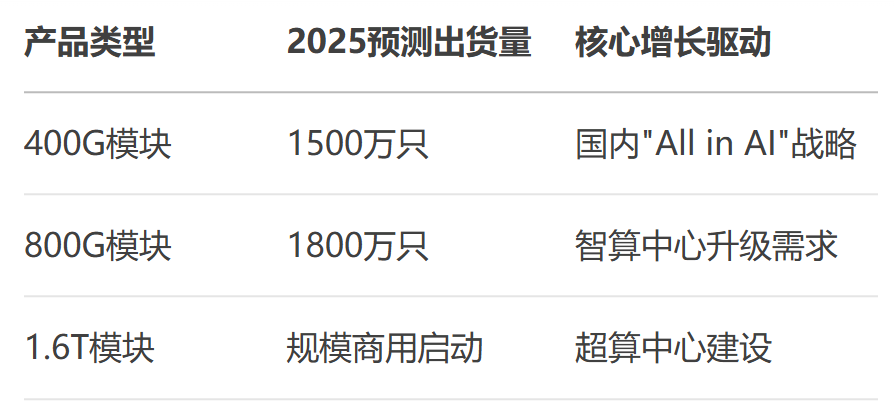

葉脊網(wǎng)絡(luò)架構(gòu)大幅增加對(duì)光模塊數(shù)量需求。由于葉脊網(wǎng)絡(luò)架構(gòu)中東西向流量大,因此服務(wù)器與交換機(jī)相連均需使用光模塊,從而大幅增加對(duì)光模塊數(shù)量需求。同時(shí) AI 大模型的高流量對(duì)帶寬提出更高要求,800G 光模塊相較 200G/400G 光模塊具有高帶寬、功耗低等優(yōu)點(diǎn),有望在 AI 大模型網(wǎng)絡(luò)架構(gòu)中滲透率提升。

以 Nvidia DGX H100 網(wǎng)絡(luò)架構(gòu)為例。該架構(gòu)適配 Nvidia H100 GPU,采用葉脊網(wǎng)絡(luò)架構(gòu),分為 1-4 個(gè) SU 單元類型(8 個(gè) GPU 組成一個(gè) H100 服務(wù)器節(jié)點(diǎn),32 個(gè)服務(wù)器節(jié)點(diǎn)組成一個(gè) SU 單元)。其中 4-SU 單元架構(gòu)由 127 個(gè)服務(wù)器節(jié)點(diǎn)組成(其中一個(gè)節(jié)點(diǎn)用于安裝 UFM 網(wǎng)絡(luò)遙測(cè)裝置),具有 1016 個(gè) H100 GPU、32 個(gè)葉交換機(jī)、16 個(gè)脊交換機(jī)。

以 Nvidia DGX H100 架構(gòu)為例測(cè)算 GPU 與光模塊的對(duì)應(yīng)數(shù)量。在 4-SU 的 Nvidia DGX H100 架構(gòu)中,每 32 臺(tái)服務(wù)器節(jié)點(diǎn)組成一個(gè) SU 單元,并與 8 臺(tái)葉交換機(jī)相連,因此服務(wù)器節(jié)點(diǎn)與葉交換機(jī)之間共有 1024 個(gè)連接(32×8×4);32 臺(tái)葉交換機(jī)需分別與 16 臺(tái)脊交換機(jī)相連,因此葉交換機(jī)與脊交換機(jī)之間共有 512 個(gè)連接(32×16);

在 Nvidia DGX H100 的目前方案中,脊-葉連接采用 800G 光模塊,需要 1024 個(gè) 800G 光模塊;葉-服務(wù)器連接中,每個(gè)服務(wù)器節(jié)點(diǎn)通過一個(gè) 800G 光模塊與兩臺(tái)葉交換機(jī)向上連接,需要 512 個(gè) 800G 光模塊(128×4),同時(shí)每臺(tái)葉交換機(jī)通過一個(gè) 400G 光模塊與一個(gè)服務(wù)器節(jié)點(diǎn)連接,需要 1024 個(gè) 400G 光模塊(128×8)。

國(guó)產(chǎn)光模塊廠商在 2022 年全球光模塊企業(yè) TOP10 排名中占據(jù) 7 席。TOP10 中國(guó)內(nèi)企業(yè)為中際旭創(chuàng)(Innolight)、華為(Huawei)、光迅科技(Accelink)、海信(Hisense)、新易盛(Eoptolink)、華工正源(HGG)、索爾思光電(已被華西股份收購)。而在高端光模塊領(lǐng)域,中際旭創(chuàng)已在 2022 年實(shí)現(xiàn) 800G 光模塊批量出貨。光芯片:光模塊核心部件,國(guó)產(chǎn)化空間開闊

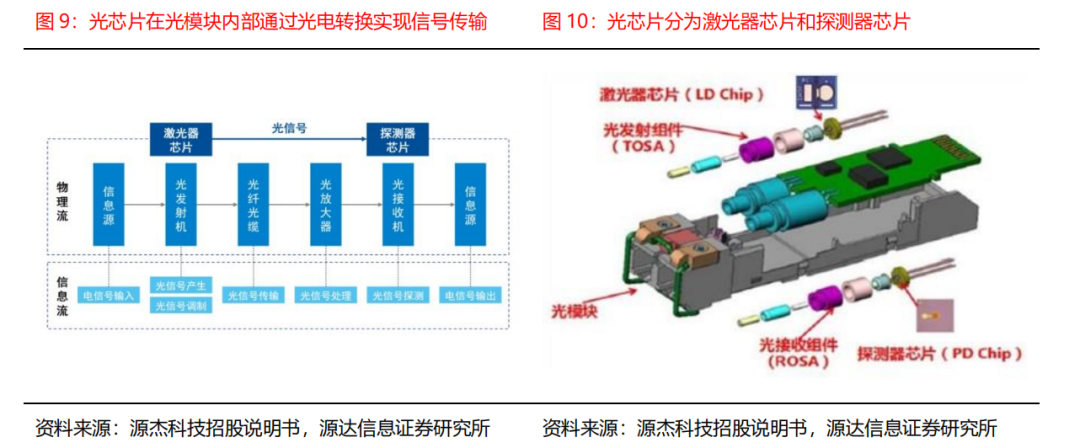

光通信是指通過電光轉(zhuǎn)換以光信號(hào)為介質(zhì)的傳輸系統(tǒng)。光通信系統(tǒng)的傳輸過程中首先發(fā)射端(TOSA)通過激光器芯片將電信號(hào)轉(zhuǎn)換為光信號(hào),經(jīng)過光纖傳輸至接收端(ROSA),接收端通過探測(cè)器芯片將光信號(hào)轉(zhuǎn)換為電信號(hào),最終實(shí)現(xiàn)信號(hào)傳輸。

光芯片是決定光通信系統(tǒng)信號(hào)傳輸效率和網(wǎng)絡(luò)可靠性的關(guān)鍵。光芯片是實(shí)現(xiàn)光電信號(hào)轉(zhuǎn)換的基礎(chǔ)元件,按照功能可以分為激光器芯片(LD)和探測(cè)器芯片(PD)。按細(xì)分型號(hào)分:激光器芯片可分為 VCSEL、FP、DFB 和 EML;探測(cè)器芯片可分為 PIN 和 APD。

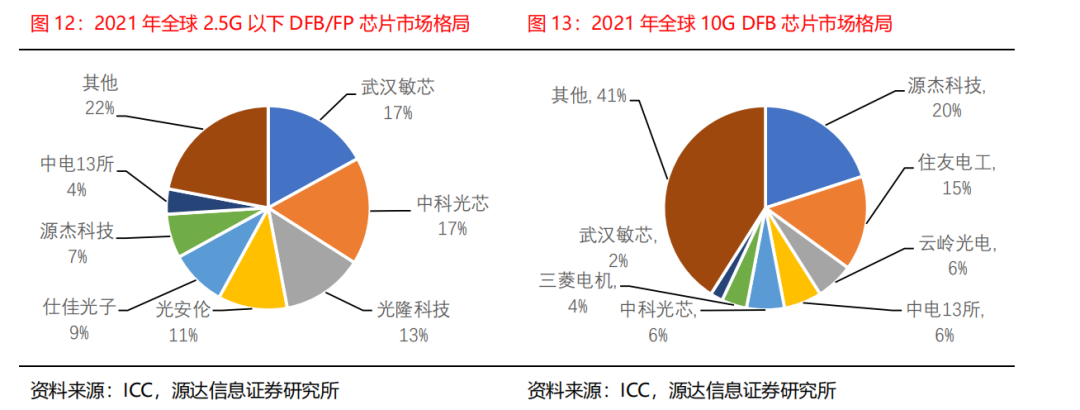

高端光芯片市場(chǎng)國(guó)產(chǎn)化率仍有待提高。目前在 10G 及以下光芯片市場(chǎng)中,源杰科技等國(guó)內(nèi)公司已占據(jù)較高市場(chǎng)份額(部分高技術(shù)難度領(lǐng)域如 10G VCSEL/EML 激光器芯片市場(chǎng)國(guó)產(chǎn)化率低于 40%),但在 25G 及以上光芯片市場(chǎng),市場(chǎng)份額仍大多由Ⅱ-Ⅳ、Lumentum 和Broadcom 等國(guó)外公司占據(jù)。伴隨國(guó)內(nèi)光模塊企業(yè)在全球市場(chǎng)中占據(jù)主導(dǎo)地位,出于保供的安全考慮,或?yàn)閲?guó)內(nèi)光芯片企業(yè)在高端領(lǐng)域發(fā)展迎來新機(jī)遇。

審核編輯:湯梓紅

-

gpu

+關(guān)注

關(guān)注

28文章

4909瀏覽量

130649 -

光模塊

+關(guān)注

關(guān)注

80文章

1380瀏覽量

60028 -

光芯片

+關(guān)注

關(guān)注

3文章

97瀏覽量

11107 -

AI芯片

+關(guān)注

關(guān)注

17文章

1968瀏覽量

35689

原文標(biāo)題:算力競(jìng)賽,開啟AI芯片、光模塊和光芯片需求

文章出處:【微信號(hào):AI_Architect,微信公眾號(hào):智能計(jì)算芯世界】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

AI算力網(wǎng)絡(luò)光模塊市場(chǎng)發(fā)展分析

DeepSeek推動(dòng)AI算力需求:800G光模塊的關(guān)鍵作用

請(qǐng)問DMD芯片在on狀態(tài)時(shí),光以何種角度入射DMD芯片,出射光可以垂直于芯片?

光模塊新紀(jì)元:大為錫膏助力AI數(shù)據(jù)中心飛躍

Arm預(yù)測(cè)2025年芯片設(shè)計(jì)發(fā)展趨勢(shì)

數(shù)據(jù)中心與AI人工智能的基礎(chǔ)設(shè)施保障:800G光模塊

如何優(yōu)化光模塊性能 光模塊的未來發(fā)展方向

光模塊技術(shù)發(fā)展趨勢(shì) 光模塊常見故障及解決方法

未來AI大模型的發(fā)展趨勢(shì)

圖像傳感器芯片的發(fā)展趨勢(shì)是什么?

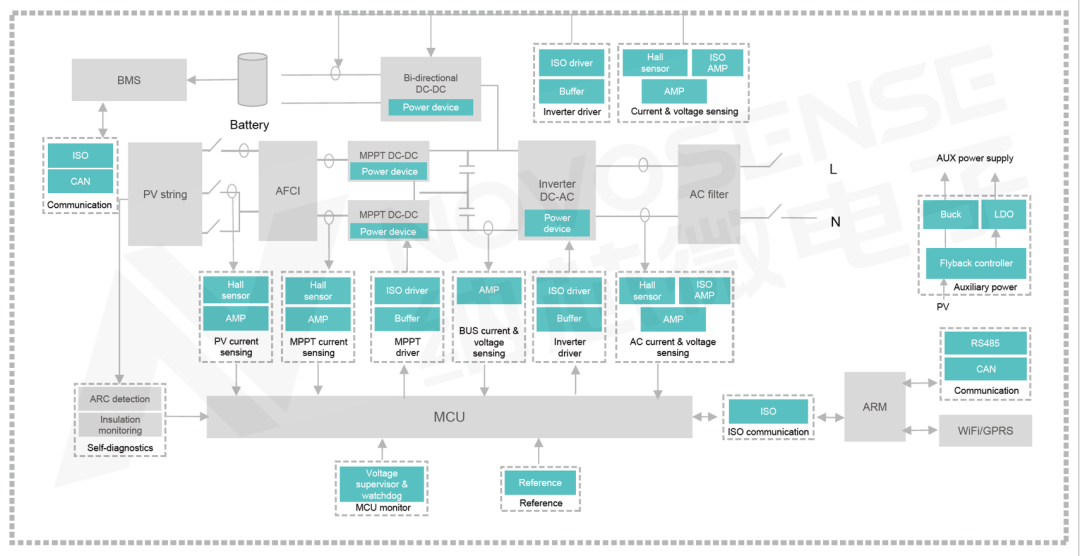

“三高一降”光伏儲(chǔ)能系統(tǒng)趨勢(shì)及其模擬芯片解決方案

光儲(chǔ)系統(tǒng)的基本運(yùn)作原理和發(fā)展趨勢(shì)

AI芯片、光模塊和光芯片的發(fā)展趨勢(shì)

AI芯片、光模塊和光芯片的發(fā)展趨勢(shì)

評(píng)論