1. OpenAI DALL·E 3來了,集成ChatGPT,生圖效果太炸了

原文:https://mp.weixin.qq.com/s/P4HwP3VwzSnndD5LSt8pXw

終于,OpenAI 的文生圖 AI 工具 DALL-E 系列迎來了最新版本 DALL?E 3,而上個版本 DALL?E 2 還是在去年 4 月推出的。

OpenAI 表示,「DALL?E 3 比以往系統更能理解細微差別和細節,讓用戶更加輕松地將自己的想法轉化為非常準確的圖像。」

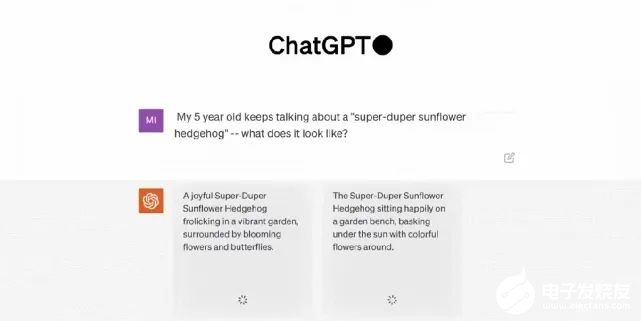

除了炸裂的生圖效果之外,此次 DALL?E 3 的最大特點是與 ChatGPT 的集成,它原生構建在 ChatGPT 之上,用 ChatGPT 來創建、拓展和優化 prompt。這樣一來,用戶無需在 prompt 上花費太多時間。具體來講,通過使用 ChatGPT,用戶不必絞盡腦汁地想出詳細的 prompt 來引導 DALL?E 3 了。當輸入一個想法時,ChatGPT 會自動為 DALL?E 3 生成量身定制的、詳細的 prompt。同時用戶也可以使用自己的 prompt。至于集成 ChatGPT 后的效果怎么樣?OpenAI CEO 山姆?奧特曼興奮地展示了 DALL?E 3 的連續性生成結果,簡直稱得上完整的「故事片」。

ChatGPT 集成并不是 DALL?E 3 唯一的新特點,它還能生成更高質量的圖像,更準確地反映提示內容。DALL?E 將文本 prompt 轉換成圖像。即使是 DALL?E 2 ,也會經常忽略特定的措辭導致出錯。但 OpenAI 的研究人員說,最新版本能更好地理解上下文,并且處理較長的 prompt 效果會更好。此外,它還能更好地處理向來困擾圖像生成模型的內容,如文本和人手。

可以看到在上圖將 prompt 中的每一個細節都表現出來了。半透明的質感、畫面底部的波濤洶涌、陽光與厚厚的云層、心臟中的宇宙景象,以及難倒很多圖像生成模型的文字展現,DALL?E 3 都順利地完成了這些任務。那么,DALL?E 3 能不能成為 Midjourney 「殺手」呢?推特用戶 @MattGarciaEth 已經將二者生成的圖片進行了很多比較。大家覺得哪個更好呢?

目前,DALL?E 3 處于研究預覽版本。OpenAI 計劃將 DALL?E 3 的發布時間錯開, 將于 10 月份首先向 ChatGPT Plus 和 ChatGPT Enterprise 用戶發布,隨后在秋季向研究實驗室及其 API 服務發布。不過,該公司沒有透露何時或者是否計劃發布免費的公開版本。

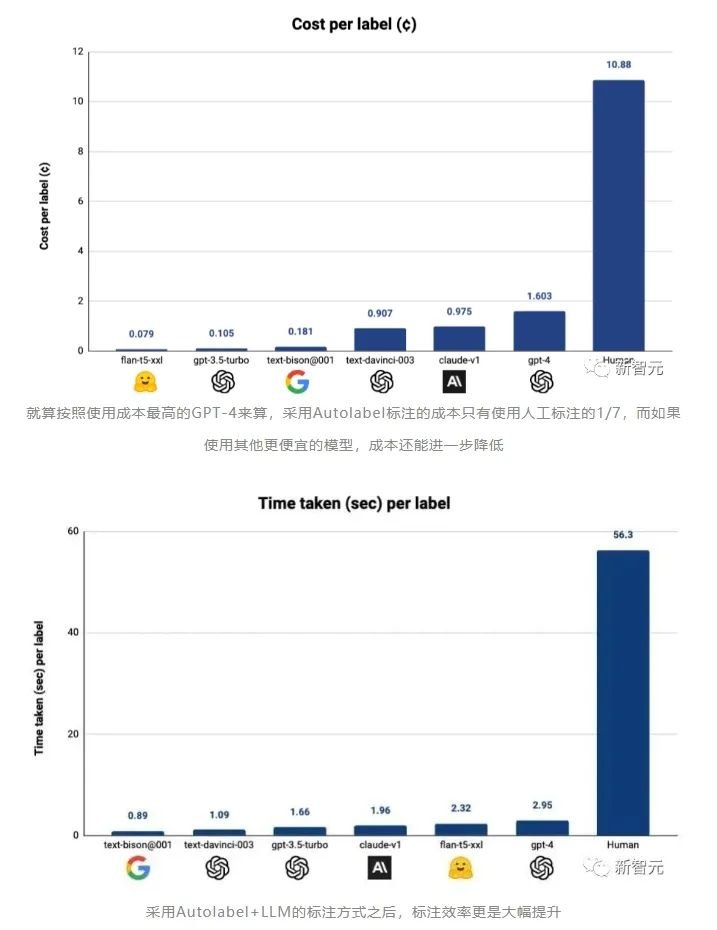

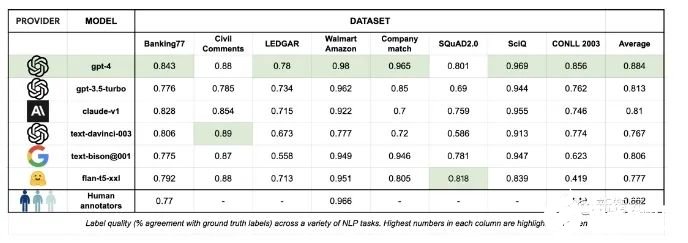

2. GPT-4終結人工標注!AI標注比人類標注效率高100倍,成本僅1/7

原文:https://mp.weixin.qq.com/s/AwXljsdH1SG0qzNeYTaprA除了GPU,還有什么是訓練一個高效的大模型必不可少且同樣難以獲取的資源?高質量的數據。OpenAI正是借助基于人類標注的數據,才一舉從眾多大模型企業中脫穎而出,讓ChatGPT成為了大模型競爭中階段性的勝利者。但同時,OpenAI也因為使用非洲廉價的人工進行數據標注,被各種媒體口誅筆伐。

而那些參與數據標注的工人們,也因為長期暴露在有毒內容中,受到了不可逆的心理創傷。

總之,對于數據標注,一定需要找到一個新的方法,才能避免大量使用人工標注帶來的包括道德風險在內的其他潛在麻煩。所以,包括谷歌,Anthropic在內的AI巨頭和大型獨角獸,都在進行數據標注自動化的探索。

3. Transformer+強化學習,谷歌DeepMind讓大模型成為機器人感知世界的大腦

原文:https://mp.weixin.qq.com/s/pp9viv9IfdiLMFXgy4h56A在開發機器人學習方法時,如果能整合大型多樣化數據集,再組合使用強大的富有表現力的模型(如 Transformer),那么就有望開發出具備泛化能力且廣泛適用的策略,從而讓機器人能學會很好地處理各種不同的任務。比如說,這些策略可讓機器人遵從自然語言指令,執行多階段行為,適應各種不同環境和目標,甚至適用于不同的機器人形態。但是,近期在機器人學習領域出現的強大模型都是使用監督學習方法訓練得到的。因此,所得策略的性能表現受限于人類演示者提供高質量演示數據的程度。這種限制的原因有二。

- 第一,我們希望機器人系統能比人類遠程操作者更加熟練,利用硬件的全部潛力來快速、流暢和可靠地完成任務。

- 第二,我們希望機器人系統能更擅長自動積累經驗,而不是完全依賴高質量的演示。

- 論文:https://q-transformer.github.io/assets/q-transformer.pdf

- 項目:https://q-transformer.github.io/

DeepMind 也進行了實驗評估 —— 既有用于嚴格比較的仿真實驗,也有用于實際驗證的大規模真實世界實驗;其中學習了大規模的基于文本的多任務策略,結果驗證了 Q-Transformer 的有效性。在真實世界實驗中,他們使用的數據集包含 3.8 萬個成功演示和 2 萬個失敗的自動收集的場景,這些數據是通過 13 臺機器人在 700 多個任務上收集的。Q-Transformer 的表現優于之前提出的用于大規模機器人強化學習的架構,以及之前提出的 Decision Transformer 等基于 Transformer 的模型。

4. Transformer的上下文學習能力是哪來的?

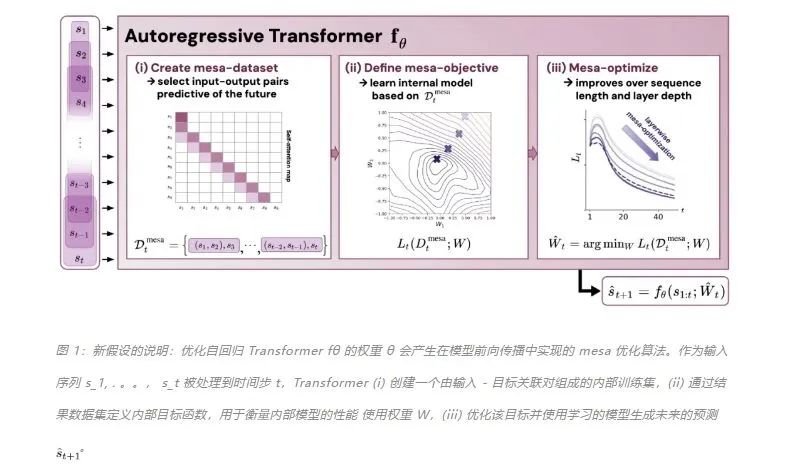

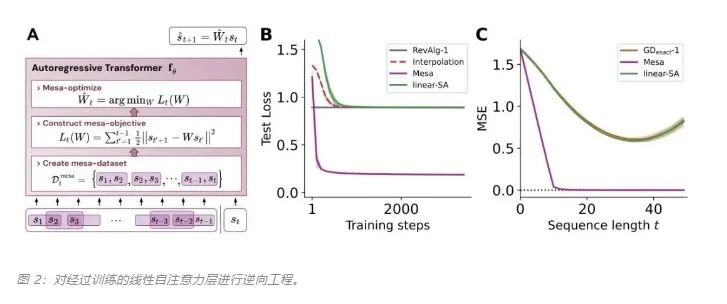

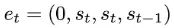

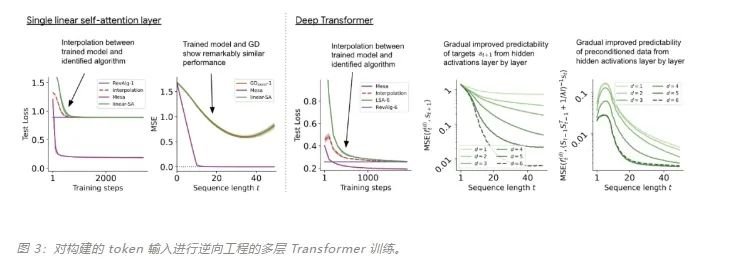

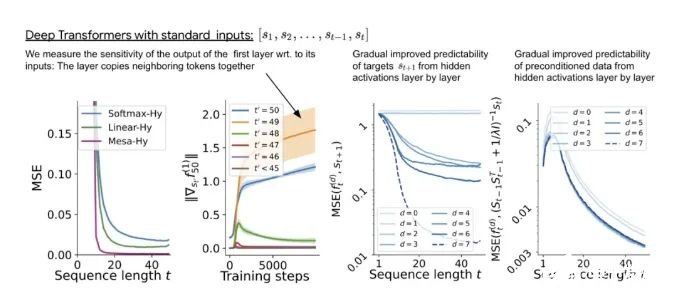

原文:https://mp.weixin.qq.com/s/7eRwSwIE-X-qfjAsOCW1WQ為什么 transformer 性能這么好?它給眾多大語言模型帶來的上下文學習 (In-Context Learning) 能力是從何而來?在人工智能領域里,transformer 已成為深度學習中的主導模型,但人們對于它卓越性能的理論基礎卻一直研究不足。最近,來自 Google AI、蘇黎世聯邦理工學院、Google DeepMind 研究人員的新研究嘗試為我們揭開謎底。在新研究中,他們對 transformer 進行了逆向工程,尋找到了一些優化方法。論文《Uncovering mesa-optimization algorithms in Transformers》:

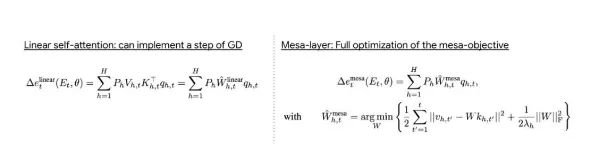

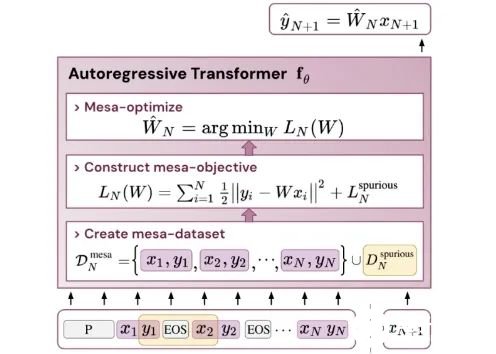

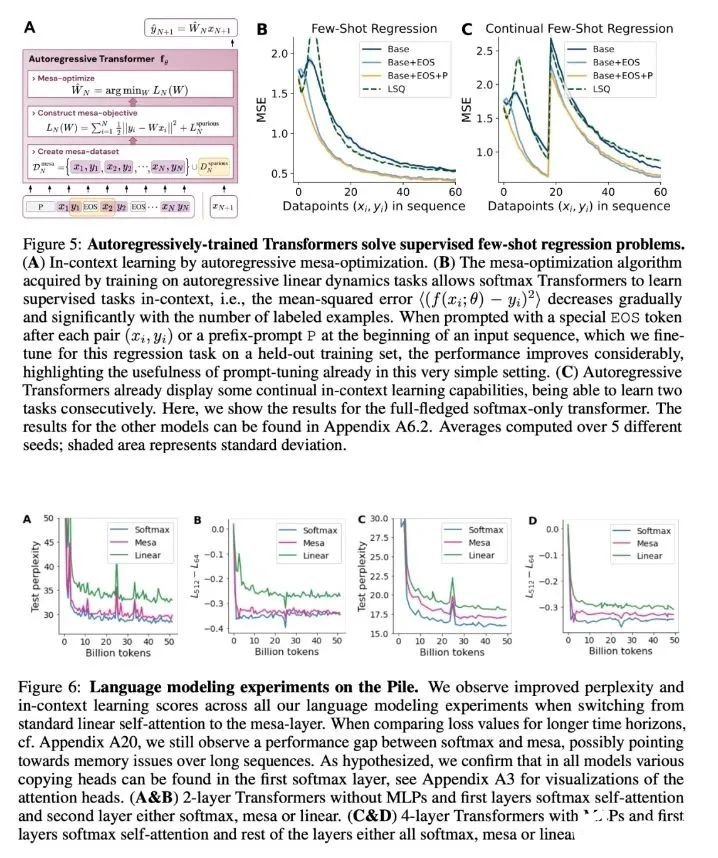

論文鏈接:https://arxiv.org/abs/2309.05858作者證明,最小化通用自回歸損失會產生在 Transformer 的前向傳遞中運行的基于輔助梯度的優化算法。這種現象最近被稱為「mesa 優化(mesa-optimization)」。此外,研究人員發現所得的 mesa 優化算法表現出上下文中的小樣本學習能力,與模型規模無關。因此,新的結果對此前大語言模型中出現的小樣本學習的原理進行了補充。研究人員認為:Transformers 的成功基于其在前向傳遞中實現 mesa 優化算法的架構偏差:(i) 定義內部學習目標,以及 (ii) 對其進行優化。

- 概括了 von Oswald 等人的理論,并展示了從理論上,Transformers 是如何通過使用基于梯度的方法優化內部構建的目標來自回歸預測序列下一個元素的。

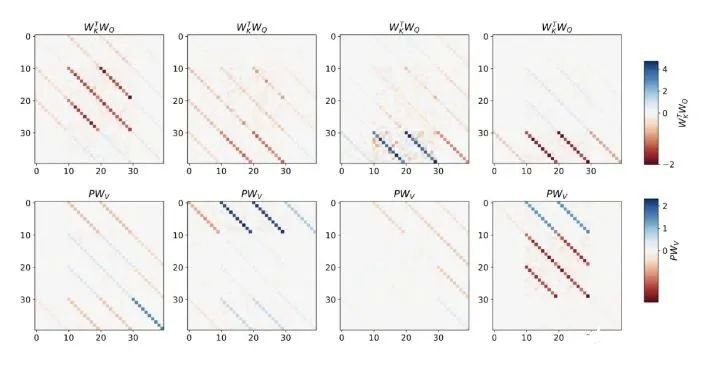

- 通過實驗對在簡單序列建模任務上訓練的 Transformer 進行了逆向工程,并發現強有力的證據表明它們的前向傳遞實現了兩步算法:(i) 早期自注意力層通過分組和復制標記構建內部訓練數據集,因此隱式地構建內部訓練數據集。定義內部目標函數,(ii) 更深層次優化這些目標以生成預測。

- 與 LLM 類似,實驗表明簡單的自回歸訓練模型也可以成為上下文學習者,而即時調整對于改善 LLM 的上下文學習至關重要,也可以提高特定環境中的表現。

- 受發現注意力層試圖隱式優化內部目標函數的啟發,作者引入了 mesa 層,這是一種新型注意力層,可以有效地解決最小二乘優化問題,而不是僅采取單個梯度步驟來實現最優。實驗證明單個 mesa 層在簡單的順序任務上優于深度線性和 softmax 自注意力 Transformer,同時提供更多的可解釋性。

- 在初步的語言建模實驗后發現,用 mesa 層替換標準的自注意力層獲得了有希望的結果,證明了該層具有強大的上下文學習能力。

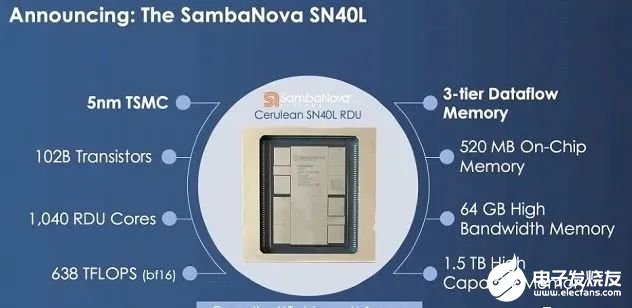

5. 1.5T內存挑戰英偉達!8枚芯片撐起3個GPT-4,華人AI芯片獨角獸估值365億

原文:https://mp.weixin.qq.com/s/GjG_OpzlAO7vGwOW7fmE-w高端GPU持續缺貨之下,一家要挑戰英偉達的芯片初創公司成為行業熱議焦點。8枚芯片跑大模型,就能支持5萬億參數(GPT-4的三倍) 。這是獨角獸企業SambaNova剛剛發布的新型AI芯片SN40L——型號中40代表是他們第四代產品,L代表專為大模型(LLM)優化:高達1.5T的內存,支持25.6萬個token的序列長度。

CEO Rodrigo Liang表示,當前行業標準做法下運行萬億參數大模型需要數百枚芯片,我們的方法使總擁有成本只有標準方法的1/25。SambaNova目前估值50億美元(約365億人民幣),累計完成了6輪總計11億美元的融資,投資方包括英特爾、軟銀、三星、GV等。他們不僅在芯片上要挑戰英偉達,業務模式上也說要比英偉達走的更遠:直接參與幫助企業訓練私有大模型。目標客戶上野心更是很大:瞄準世界上最大的2000家企業。

1.5TB內存的AI芯片最新產品SN40L,由臺積電5納米工藝制造,包含1020億晶體管,峰值速度638TeraFLOPS。與英偉達等其他AI芯片更大的不同在于新的三層Dataflow內存系統。與主要競品相比,英偉達H100最高擁有80GB HBM3內存,AMD MI300擁有192GB HBM3內存。SN40L的高帶寬HBM3內存實際比前兩者小,更多依靠大容量DRAM。Rodrigo Liang表示,雖然DRAM速度更慢,但專用的軟件編譯器可以智能地分配三個內存層之間的負載,還允許編譯器將8個芯片視為單個系統。

1.5TB內存的AI芯片最新產品SN40L,由臺積電5納米工藝制造,包含1020億晶體管,峰值速度638TeraFLOPS。與英偉達等其他AI芯片更大的不同在于新的三層Dataflow內存系統。與主要競品相比,英偉達H100最高擁有80GB HBM3內存,AMD MI300擁有192GB HBM3內存。SN40L的高帶寬HBM3內存實際比前兩者小,更多依靠大容量DRAM。Rodrigo Liang表示,雖然DRAM速度更慢,但專用的軟件編譯器可以智能地分配三個內存層之間的負載,還允許編譯器將8個芯片視為單個系統。

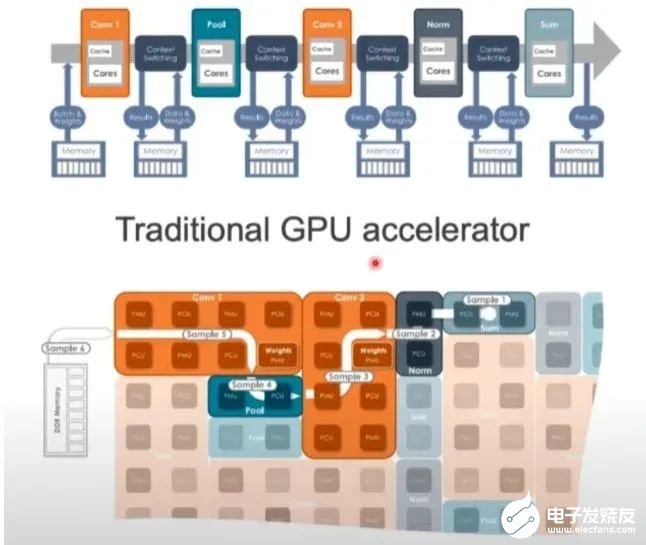

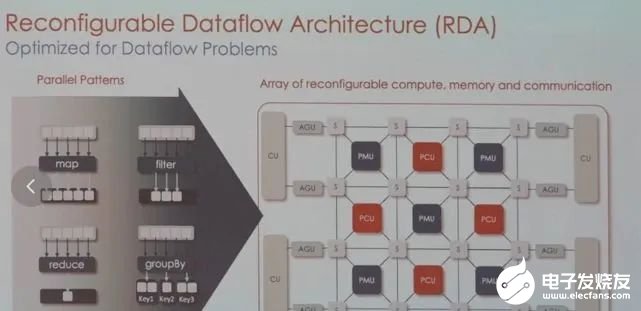

GPU的架構非常嚴格,面對圖像、視頻、文本等多樣數據時可能不夠靈活,而SambaNova可以調整硬件來滿足工作負載的要求。目前,SambaNova的芯片和系統已獲得不少大型客戶,包括世界排名前列的超算實驗室,日本富岳、美國阿貢國家實驗室、勞倫斯國家實驗室,以及咨詢公司埃森哲等。業務模式也比較特別,芯片不單賣,而是出售其定制技術堆棧,從芯片到服務器系統,甚至包括部署大模型。為此,他們與TogetherML聯合開發了BloomChat,一個1760億參數的多語言聊天大模型。BloomChat建立在BigScience組織的開源大模型Bloom之上,并在來自OpenChatKit、Dolly 2.0和OASST1的OIG上進行了微調。訓練過程中,它使用了SambaNova獨特的可重配置數據流架構,然后在SambaNova DataScale系統進行訓練。

6. 十分鐘,深入淺出理解Transformer

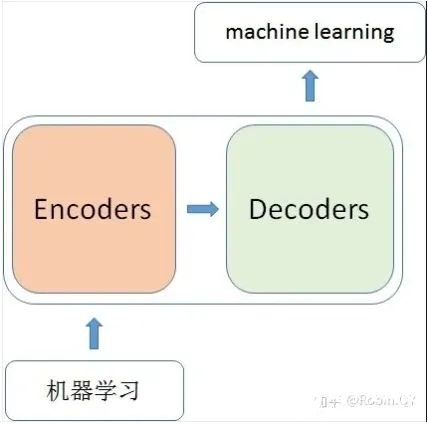

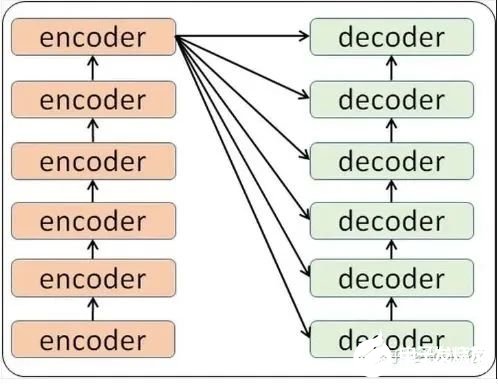

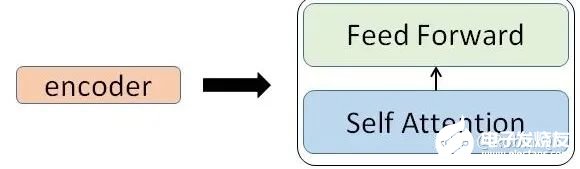

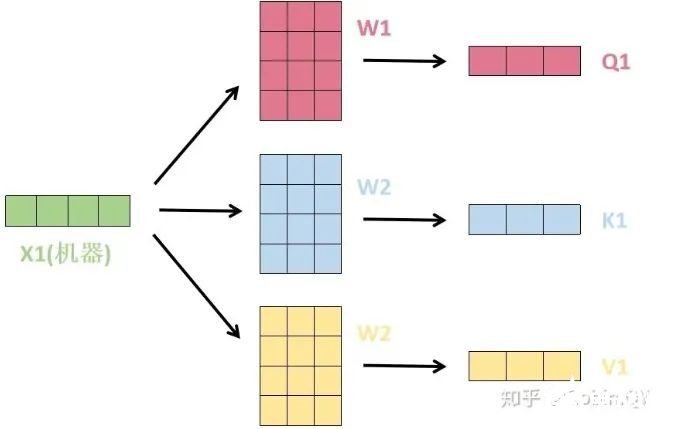

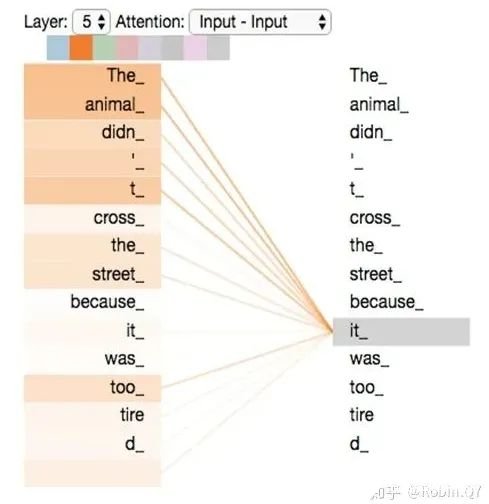

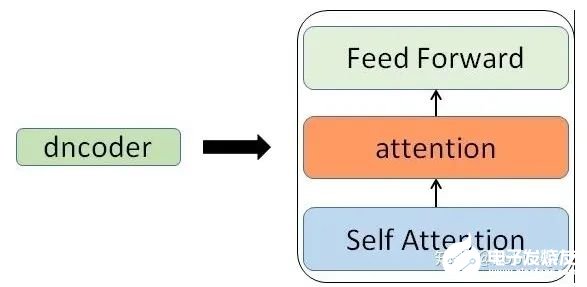

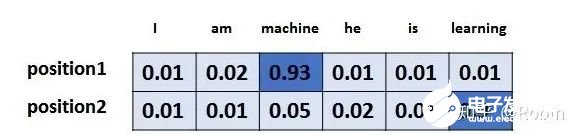

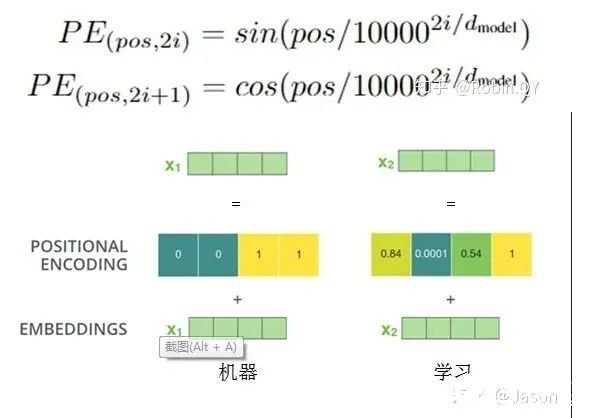

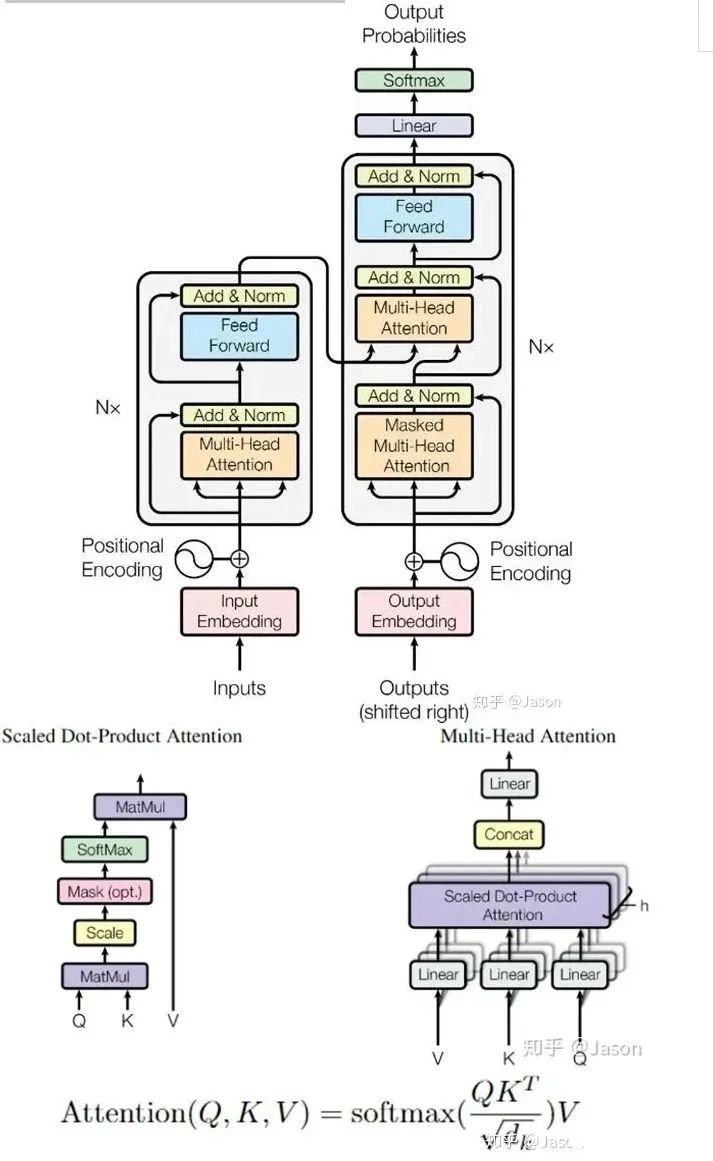

原文:https://mp.weixin.qq.com/s/xtyP6cg6vROOXe1vlPEEewTransformer是一個利用注意力機制來提高模型訓練速度的模型。關于注意力機制可以參看這篇文章(https://zhuanlan.zhihu.com/p/52119092),trasnformer可以說是完全基于自注意力機制的一個深度學習模型,因為它適用于并行化計算,和它本身模型的復雜程度導致它在精度和性能上都要高于之前流行的RNN循環神經網絡。那什么是transformer呢?你可以簡單理解為它是一個黑盒子,當我們在做文本翻譯任務是,我輸入進去一個中文,經過這個黑盒子之后,輸出來翻譯過后的英文。

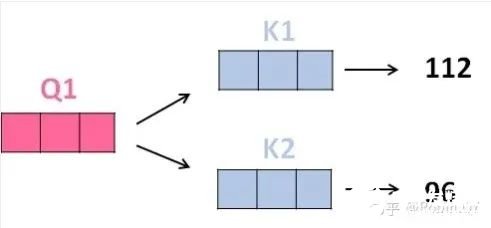

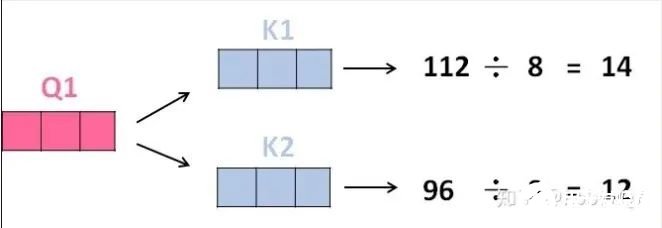

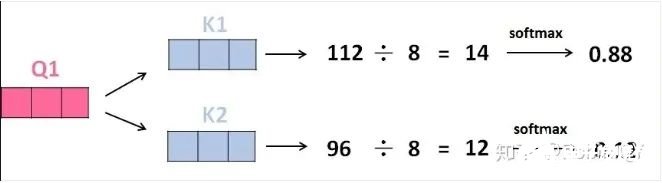

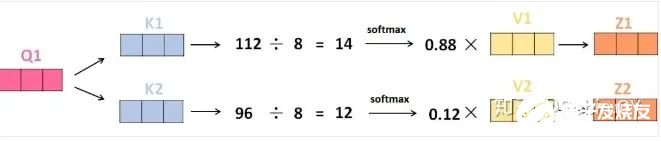

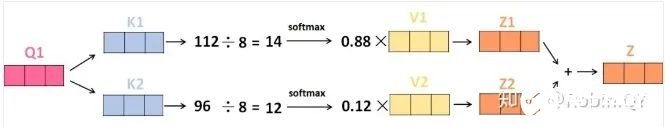

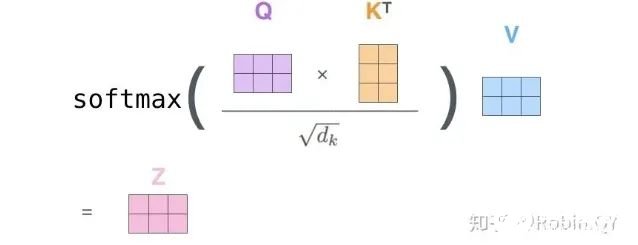

3、將得分分別除以一個特定數值8(K向量的維度的平方根,通常K向量的維度是64)這能讓梯度更加穩定,則得到結果如下:

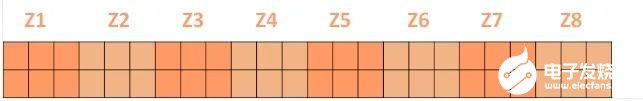

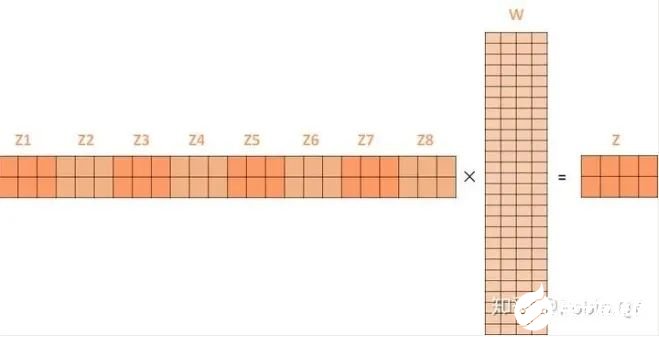

將上述的過程總結為一個公式就可以用下圖表示:

將上述的過程總結為一個公式就可以用下圖表示:

-

RT-Thread

+關注

關注

32文章

1369瀏覽量

41506

原文標題:【AI簡報20230922期】華人AI芯片挑戰英偉達,深入淺出理解Transformer

文章出處:【微信號:RTThread,微信公眾號:RTThread物聯網操作系統】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

【AI簡報20230922期】華人AI芯片挑戰英偉達,深入淺出理解Transformer

【AI簡報20230922期】華人AI芯片挑戰英偉達,深入淺出理解Transformer

評論