feather map

在cnn的每個(gè)卷積層,數(shù)據(jù)都是以三維形式存在的。可以看成許多個(gè)二維圖片疊在一起,其中每一個(gè)稱為一個(gè)feature map。

1.在輸入層,如果是灰度圖片,那就只有一個(gè)feature map;如果是彩色圖片,一般就是3個(gè)feature map(紅綠藍(lán))。

2.在其它層,層與層之間會(huì)有若干個(gè)卷積核(kernel),上一層每個(gè)feature map跟每個(gè)卷積核做卷積,都會(huì)產(chǎn)生下一層的一個(gè)feature map,有N個(gè)卷積核,下層就會(huì)產(chǎn)生N個(gè)feather map。

卷積核(filter)

每個(gè)卷積核具有長寬深三個(gè)維度;卷積核的深度與當(dāng)前圖像的深度(feather map的張數(shù))相同。卷積核的個(gè)數(shù)與下一層需要多少個(gè)feather map相同。在CNN的一個(gè)卷積層中:卷積核的長、寬都是人為指定的,長X寬也被稱為卷積核的尺寸,常用的尺寸為3X3,5X5等;例如,在原始圖像層 (輸入層),如果圖像是灰度圖像,其feather map數(shù)量為1,則卷積核的深度也就是1;如果圖像是grb圖像,其feather map數(shù)量為3,則卷積核的深度也就是3。

訓(xùn)練數(shù)據(jù)

- batchsize:批大小。在深度學(xué)習(xí)中,一般采用SGD訓(xùn)練,即每次訓(xùn)練在訓(xùn)練集中取batchsize個(gè)樣本訓(xùn)練;

- iteration:1個(gè)iteration等于使用batchsize個(gè)樣本訓(xùn)練一次;

- epoch:1個(gè)epoch等于使用訓(xùn)練集中的全部樣本訓(xùn)練一次,通俗的講epoch的值就是整個(gè)數(shù)據(jù)集被輪幾次。

例如300個(gè)樣本訓(xùn)練一次,epoch=1,batchsize = 10 ,iteration=30。

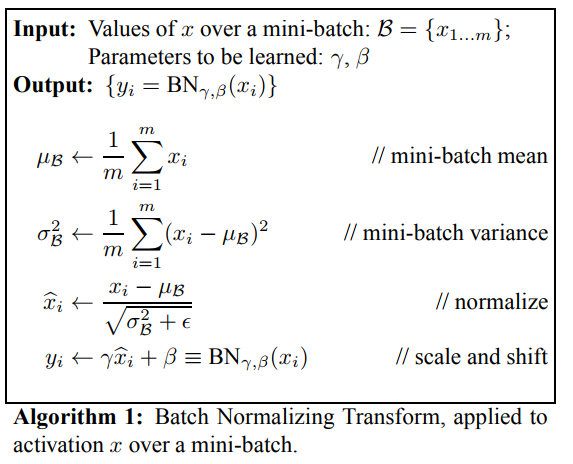

BN(Batch Normalization)層

BN層即batch-norm層,一般是深度學(xué)習(xí)中用于加速訓(xùn)練速度和一種方法,一般放置在卷積層(conv層)或者全連接層之后,將數(shù)據(jù)歸一化并加速了訓(xùn)練擬合速度。

常用位置:conv→bn→relu

如果網(wǎng)絡(luò)使用sigmod激活函數(shù),誤差在向前傳遞的時(shí)候,經(jīng)過sigmod單元,需要乘sigmod的梯度,而sigmod的梯度最大是0.25,因此越向前傳遞,誤差就越小了,這就是梯度消散,但是梯度爆炸是什么?注意誤差在經(jīng)過全連接或者卷積層時(shí),也要乘以權(quán)重w,如果w都比較大,大過sigmod造成的減小,這樣越往前誤差就越來越大,產(chǎn)生梯度爆炸。

BN層的計(jì)算圖如下面所示,x是輸入數(shù)據(jù),到xhat均值方差歸一化,后面xhat到y(tǒng)其實(shí)就是普通的一個(gè)線性變換,類似全連接但是沒有交叉。如果沒有BN層,x直接輸入后面的網(wǎng)絡(luò),訓(xùn)練過程中x分布的變換必然導(dǎo)致后面的網(wǎng)絡(luò)去調(diào)整學(xué)習(xí)以來適應(yīng)x的均值和方差,映入了BN層,xhat是一個(gè)歸一化的數(shù)據(jù),代價(jià)就是網(wǎng)絡(luò)中多了一個(gè)線性層y,但是前者帶來的性能更加大,因此加速了。

AUC(Area Under Curve)

一個(gè)正例,一個(gè)負(fù)例,預(yù)測(cè)為正的概率值比預(yù)測(cè)為負(fù)的概率值還要大的可能性。所以根據(jù)定義:我們最直觀的有兩種計(jì)算AUC的方法:

1:繪制ROC曲線,ROC曲線下面的面積就是AUC的值

2:假設(shè)總共有(m+n)個(gè)樣本,其中正樣本m個(gè),負(fù)樣本n個(gè),總共有mn個(gè)樣本對(duì),計(jì)數(shù),正樣本預(yù)測(cè)為正樣本的概率值大于負(fù)樣本預(yù)測(cè)為正樣本的概率值記為1,累加計(jì)數(shù),然后除以(mn)就是AUC的值。

AUC作為數(shù)值可以直觀的評(píng)價(jià)分類器的好壞,值越大越好。

均值平均精度MAP(Mean Average Precision)

我們使用loU和閾值判斷是否為目標(biāo)。計(jì)算模型得到的每個(gè)檢測(cè)框的loU值,用計(jì)算出的loU值與設(shè)定的loU閾值比較,就可以計(jì)算出每個(gè)圖像中每個(gè)類的正確檢測(cè)次數(shù)(A)。對(duì)于每個(gè)圖像,我們都有g(shù)round truth的數(shù)據(jù),因此也知道了該圖像中給定類別的實(shí)際目標(biāo)(B)的數(shù)量。我們也計(jì)算了正確預(yù)測(cè)的數(shù)量(A)(True possitive)。因此我們可以使用這個(gè)公式來計(jì)算該類模型的精度(A/B)

Precesion_{C}=\\frac{N(TruePositives){C}}{N(TotalObjects){C}}

即給定一張圖像的類別C的Precision=圖像正確預(yù)測(cè)的數(shù)量除以在圖像張這一類的總的目標(biāo)數(shù)量。 假如現(xiàn)在有一個(gè)給定的類,驗(yàn)證集中有100個(gè)圖像,并且我們知道每個(gè)圖像都有其中的所有類(基于ground truth)。所以我們可以得到100個(gè)精度值,計(jì)算這100個(gè)精度值的平均值,得到的就是該類的平均精度。

AveragePrecesion_{C}=\\frac{\\sum Precesion_{C}}{N(TotalImages)_{C}}

即一個(gè)C類的平均精度=在驗(yàn)證集上所有的圖像對(duì)于類C的精度值的和/有類C這個(gè)目標(biāo)的所有圖像的數(shù)量。 現(xiàn)在加入我們整個(gè)集合中有20個(gè)類,對(duì)于每個(gè)類別,我們都先計(jì)算loU,接下來計(jì)算精度,然后計(jì)算平均精度。所有我們現(xiàn)在有20個(gè)不同的平均精度值。使用這些平均精度值,我們可以輕松的判斷任何給定類別的模型的性能。

但是問題是使用20個(gè)不同的平均精度使我們難以度量整個(gè)模型,所以我們可以選用一個(gè)單一的數(shù)字來表示一個(gè)模型的表現(xiàn)(一個(gè)度量來統(tǒng)一它們),我們可以取所有類的平均精度值的平均值,即MAP(均值平均精度)。

MeanAveragePrecesion=\\frac{\\sum AveragePrecesion_{C}}{N(Classes)}

MAP=所有類別的平均精度求和除以所有類別。即數(shù)據(jù)集中所有類的平均精度的平均值。

EAO 期望平均覆蓋率

EAO提出的目的也是希望一個(gè)好的跟蹤器同時(shí)擁有好的精度A和魯棒性R,如果直接用A和R的兩個(gè)數(shù)加權(quán)和則有失公允,所以需要重新定義。

假設(shè)有N_s幀長的一個(gè)視頻,那么一個(gè)跟 蹤器在這段視頻上的覆蓋率精度(Overlay accuracy)op為每一幀op的均值,op就是bonding box與ground truth的交并比用Φ表示,即:

Φ_{N_{s}}=\\frac{1}{N_{s}}\\sum {\\atop i=1:N_{s}}Φ_{i}

那么一個(gè)理想的EAO就是把N_s從1到一個(gè)期望的極大值對(duì)應(yīng)的N_s求個(gè)平均,就是期望平均覆蓋率,恰如其名,等價(jià)于下圖的曲線下面積:

shortcut connection

ResNet結(jié)構(gòu)使用了一種連接方式,即“繞近路”的意思。

Bottleneck(瓶頸層)

其意思就是輸入輸出維度差距較大,就像一個(gè)瓶頸一樣,上窄下寬亦或上寬下窄。1x1 filters 可以起到一個(gè)改變輸出維數(shù)(channels)的作用。可以看到,右圖中 1x1 filters把維度(channels)升高了,輸入輸出維度差距較大。

感受野:

在卷積神經(jīng)網(wǎng)絡(luò)CNN中,決定某一層輸出結(jié)果中一個(gè)元素所對(duì)應(yīng)的輸入層的區(qū)域大小,被稱作感受野receptive field。用數(shù)學(xué)的語言就是感受野是CNN中的某一層輸出結(jié)果的一個(gè)元素對(duì)應(yīng)輸入層的一個(gè)映射。

學(xué)習(xí)更多編程知識(shí),請(qǐng)關(guān)注我的公眾號(hào):

-

圖像處理

+關(guān)注

關(guān)注

27文章

1325瀏覽量

57717 -

算法

+關(guān)注

關(guān)注

23文章

4699瀏覽量

94747 -

目標(biāo)跟蹤

+關(guān)注

關(guān)注

2文章

88瀏覽量

15039 -

代碼

+關(guān)注

關(guān)注

30文章

4887瀏覽量

70260 -

cnn

+關(guān)注

關(guān)注

3文章

354瀏覽量

22636 -

卷積神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

4文章

369瀏覽量

12196

發(fā)布評(píng)論請(qǐng)先 登錄

視頻跟蹤(目標(biāo)取差器)-基于DM8168實(shí)現(xiàn)的自動(dòng)視頻跟蹤

視頻跟蹤目標(biāo)跟蹤算法簡介(上海凱視力成信息科技有限...

基于OPENCV的運(yùn)動(dòng)目標(biāo)跟蹤實(shí)現(xiàn)

基于QT+OpenCv的目標(biāo)跟蹤算法實(shí)現(xiàn)

基于kalman預(yù)測(cè)和自適應(yīng)模板的目標(biāo)相關(guān)跟蹤研究

基于核相關(guān)濾波器的目標(biāo)旋轉(zhuǎn)跟蹤算法_李龍

基于KCFSE結(jié)合尺度預(yù)測(cè)的目標(biāo)跟蹤方法

基于融合的快速目標(biāo)跟蹤算法

基于無線傳感器網(wǎng)絡(luò)移動(dòng)目標(biāo)探測(cè)跟蹤

視覺目標(biāo)跟蹤相關(guān)算法、優(yōu)缺點(diǎn)及發(fā)展趨勢(shì)

分享目標(biāo)跟蹤入門篇之相關(guān)濾波

視頻目標(biāo)跟蹤分析

最常見的目標(biāo)跟蹤算法

多目標(biāo)跟蹤算法總結(jié)歸納

目標(biāo)跟蹤相關(guān)知識(shí)總結(jié)

目標(biāo)跟蹤相關(guān)知識(shí)總結(jié)

評(píng)論