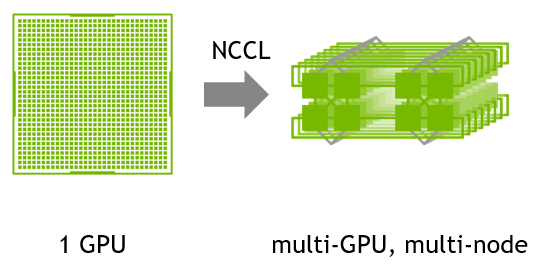

NVIDIA 集合通信庫(NCCL)可實現針對 NVIDIA GPU 和網絡進行性能優化的多 GPU 和多節點通信基元。

關于 NVIDIA 集合通信庫(NCCL)

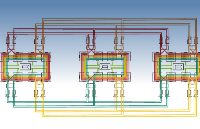

NCCL 提供了 all-gather、all-reduce、broadcast、reduce、reduce-scatter、point-to-point send 和 receive 等例程,這些例程均經過優化,可通過節點內的 PCIe 和 NVLink 高速互聯以及節點間的 NVIDIA Mellanox 網絡實現高帶寬和低延遲。

先進的深度學習框架(例如 Caffe2、Chainer、MXNet、PyTorch和 TensorFlow)已集成 NCCL,以在多 GPU 多節點的系統上加快深度學習訓練速度。

便捷性能

使用 NCCL,開發者無需針對特定機器優化其應用,因而更加便捷。NCCL 可在節點內和節點間實現多個 GPU 的快速集合。

簡化編程

NCCL 使用可從多種編程語言輕松訪問的簡單 C API,且嚴格遵循 MPI(消息傳遞接口)定義的主流集合 API。

兼容性

NCCL 幾乎可與任何多 GPU 并行模型兼容,例如:單線程、多線程(每個 GPU 使用一個線程)和多進程模型(MPI 與 GPU 上的多線程操作相結合)。

主要特性

對 AMD、Arm、PCI Gen4 和 IB HDR 上的高帶寬路徑進行自動拓撲檢測

憑借利用 SHARPV2 的網絡內 all reduce 操作,將峰值帶寬提升 2 倍

通過圖形搜索,找到更佳的高帶寬、低延遲的環和樹集合

支持多線程和多進程應用

InfiniBand verbs、libfabric、RoCE 和 IP Socket 節點間通信

使用 Infiniband 動態路由重新路由流量,緩解端口擁塞

-

NVIDIA

+關注

關注

14文章

5232瀏覽量

105714 -

gpu

+關注

關注

28文章

4906瀏覽量

130604 -

深度學習

+關注

關注

73文章

5554瀏覽量

122442

原文標題:DevZone | NVIDIA集合通信庫(NCCL)

文章出處:【微信號:NVIDIA-Enterprise,微信公眾號:NVIDIA英偉達企業解決方案】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

集合通信與AI基礎架構

案例驗證:分析NCCL-Tests運行日志優化Scale-Out網絡拓撲

NVIDIA 集合通信庫加快深度學習訓練速度

NVIDIA 集合通信庫加快深度學習訓練速度

評論