深度學習作為人工智能領域的一個重要分支,近年來在圖像識別、語音識別、自然語言處理等多個領域取得了顯著進展。其核心在于通過構建復雜的神經網絡模型,從大規模數據中自動學習并提取特征,進而實現高效準確的預測和分類。本文將深入解讀深度學習中的典型模型及其訓練過程,旨在為讀者提供一個全面而深入的理解。

一、深度學習典型模型

1. 卷積神經網絡(CNN)

卷積神經網絡是深度學習中最具代表性的模型之一,廣泛應用于圖像和視頻處理領域。CNN通過卷積層、池化層和全連接層等結構,自動從原始圖像中提取出有用的特征表示。卷積層通過卷積核與輸入圖像進行局部連接和權值共享,有效減少了網絡參數的數量并提高了特征提取的效率。池化層則通過下采樣操作進一步降低特征圖的維度,減少計算量并引入一定的平移不變性。全連接層則將提取到的特征映射到樣本的標記空間,實現分類或回歸任務。

2. 循環神經網絡(RNN)

循環神經網絡是處理序列數據的強大工具,廣泛應用于自然語言處理、語音識別等領域。與CNN不同,RNN具有記憶能力,能夠處理任意長度的輸入序列,并通過隱藏層之間的連接傳遞序列中的信息。然而,傳統的RNN存在梯度消失或梯度爆炸的問題,難以訓練長序列數據。為此,研究人員提出了長短期記憶網絡(LSTM)和門控循環單元(GRU)等變體,通過引入門控機制解決了這一問題,使得RNN能夠更有效地處理長序列數據。

3. 生成對抗網絡(GAN)

生成對抗網絡是一種特殊的深度學習模型,由生成器和判別器兩個網絡組成。生成器的目標是生成盡可能真實的樣本,以欺騙判別器;而判別器的目標則是區分生成的樣本和真實樣本。通過兩個網絡之間的對抗訓練,GAN能夠生成高質量的圖像、視頻等多媒體內容。GAN的出現為無監督學習和半監督學習提供了新的思路和方法,具有廣闊的應用前景。

二、深度學習訓練過程

深度學習的訓練過程是一個復雜而關鍵的過程,涉及數據準備、模型設計、損失函數和優化算法選擇、模型訓練、模型評估以及超參數調優等多個環節。以下是對這些環節的詳細解讀。

1. 數據準備

數據準備是深度學習訓練的第一步,也是至關重要的一步。數據的質量和數量直接影響模型的性能和泛化能力。在數據準備階段,需要進行數據收集、清洗和預處理等操作。數據標注是監督學習中的一項重要任務,需要合理設定標簽體系并確保標注過程的準確性和一致性。此外,還需要將數據集劃分為訓練集、驗證集和測試集等不同的部分,以便進行模型訓練和評估。

2. 模型設計

模型設計是深度學習訓練的核心環節之一。在選擇適當的神經網絡結構和模型架構時,需要考慮任務的具體需求和數據的特性。例如,在處理圖像識別任務時,通常會選擇CNN作為模型的基礎結構;而在處理自然語言處理任務時,則可能會選擇RNN或Transformer等模型。此外,還需要根據任務的需求進行網絡設計,如確定網絡層數、神經元數量、激活函數等參數。

3. 損失函數和優化算法選擇

損失函數是衡量模型預測結果與真實標簽之間差異的性能指標。在深度學習中,常用的損失函數包括均方誤差損失函數、交叉熵損失函數等。選擇合適的損失函數對于模型的訓練效果至關重要。優化算法則是用于更新模型參數以最小化損失函數的算法。在深度學習中,常用的優化算法包括隨機梯度下降(SGD)、Adam等。這些算法通過計算損失函數對模型參數的梯度,并沿著梯度的反方向更新參數,以逐步降低損失函數的值。

4. 模型訓練

模型訓練是深度學習訓練的核心環節。在訓練過程中,需要使用訓練數據集對模型進行迭代訓練,通過前向傳播和反向傳播算法不斷優化模型的參數。前向傳播是指將數據輸入到模型中,通過計算得到模型的預測結果;反向傳播則是根據預測結果與真實標簽之間的差異計算損失函數,并通過梯度下降算法更新模型的參數。訓練過程中可以采用批量訓練(mini-batch)或全局訓練(batch)等方式,以提高訓練效率和穩定性。

5. 模型評估

模型評估是檢驗模型性能的重要環節。在訓練過程中,需要使用驗證集或測試集對訓練好的模型進行評估,計算模型在新數據上的性能指標如準確率、召回率、F1值等。這些指標能夠反映模型的泛化能力和預測準確性。通過模型評估,可以及時發現模型存在的問題并進行調整和優化。

6. 超參數調優

超參數調優是提高模型性能的重要手段之一。在深度學習訓練中,需要調整模型的超參數如學習率、批量大小、網絡層數等,以找到最佳的超參數組合。超參數調優是深度學習中一個至關重要且常常需要細致操作的步驟。超參數是那些在模型訓練開始前就已經設置好的參數,它們不是通過訓練過程學習的,而是需要人工調整以優化模型性能。以下是一些常見的超參數調優策略和方法:

(1)網格搜索(Grid Search)

網格搜索是一種簡單的超參數調優方法,它通過窮舉搜索所有可能的超參數組合來找到最優解。這種方法雖然簡單直接,但當超參數數量較多或每個超參數的取值范圍較大時,計算量會急劇增加。例如,如果有三個超參數,每個超參數有兩個候選值,那么就需要進行2^3=8次實驗。

(2)隨機搜索(Random Search)

隨機搜索是對網格搜索的一種改進,它在每個超參數的取值范圍內隨機選擇樣本來進行實驗。這種方法比網格搜索更加靈活,因為它不是均勻地探索所有可能的組合,而是有可能在更有可能的區域進行更密集的探索。此外,隨機搜索的計算成本通常比網格搜索低,因為它不需要嘗試所有可能的組合。

(3)貝葉斯優化(Bayesian Optimization)

貝葉斯優化是一種基于概率模型的優化方法,它利用歷史實驗結果來構建一個后驗概率模型,然后根據這個模型來選擇下一個最有潛力的超參數組合進行實驗。貝葉斯優化能夠在較少的實驗次數內找到較好的超參數組合,尤其適用于那些計算成本較高的模型。然而,貝葉斯優化需要定義一個合適的概率模型,這可能需要一定的專業知識和經驗。

(4)基于規則的搜索(Rule-based Search)

除了上述自動化搜索方法外,還有一些基于規則的搜索方法。這些方法依賴于領域知識或經驗規則來指導超參數的調整。例如,對于學習率這一超參數,可以根據模型在訓練過程中的表現(如損失函數的下降速度)來動態調整其值。這種方法雖然需要一定的主觀判斷,但在某些情況下可能更加高效和有效。

在超參數調優過程中,還需要注意以下幾點:

- 分階段調優 :不要一次性嘗試調整所有超參數,而是應該分階段進行。首先調整那些對模型性能影響最大的超參數(如學習率、網絡層數等),然后再逐步調整其他超參數。

- 交叉驗證 :使用交叉驗證來評估不同超參數組合下的模型性能,以確保模型的泛化能力。

- 記錄實驗結果 :詳細記錄每次實驗的超參數設置、實驗結果和評估指標等信息,以便后續分析和比較。

7. 模型部署與應用

當模型在驗證集和測試集上表現出良好的性能后,就可以考慮將其部署到實際應用中。模型部署涉及到將訓練好的模型集成到實際系統或應用中,并確保其能夠穩定、高效地運行。以下是一些模型部署時需要注意的方面:

- 環境配置 :確保部署環境具有與訓練環境相似的配置和依賴項,以保證模型能夠正常運行。

- 模型壓縮與優化 :對模型進行壓縮和優化以減少其體積和提高運行速度,例如通過剪枝、量化等方法。

- 實時監控與反饋 :在模型部署后,需要實時監控其運行狀態和性能指標,并根據實際情況進行反饋和調整。

- 數據隱私與安全 :確保在模型部署過程中遵守相關的數據隱私和安全規定,保護用戶數據的安全和隱私。

綜上所述,深度學習模型的訓練過程是一個復雜而系統的過程,需要綜合考慮數據準備、模型設計、損失函數和優化算法選擇、模型訓練、模型評估以及超參數調優等多個方面。通過不斷優化和調整這些環節中的各個參數和策略,可以訓練出性能優異、泛化能力強的深度學習模型,并將其成功應用于實際場景中。

-

人工智能

+關注

關注

1804文章

48677瀏覽量

246337 -

深度學習

+關注

關注

73文章

5554瀏覽量

122467 -

卷積神經網絡

+關注

關注

4文章

369瀏覽量

12185

發布評論請先 登錄

Pytorch模型訓練實用PDF教程【中文】

深度學習中過擬合/欠擬合的問題及解決方案

labview調用深度學習tensorflow模型非常簡單,附上源碼和模型

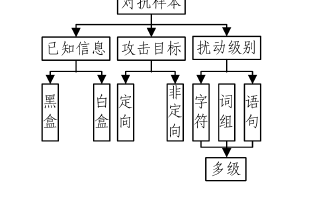

基于深度學習的自然語言處理對抗樣本模型

深度學習的典型模型和訓練過程

深度學習的典型模型和訓練過程

評論