引言

論辯挖掘任務(wù)旨在識(shí)別文本中的論辯結(jié)構(gòu),近年來(lái)受到了廣泛的關(guān)注。在信息檢索等諸多領(lǐng)域里,論辯挖掘取得了卓越的進(jìn)展。通常來(lái)說(shuō),論辯挖掘包含兩個(gè)子任務(wù):1)對(duì)于論點(diǎn)進(jìn)行分類;2)對(duì)于論點(diǎn)之間的關(guān)系進(jìn)行分類。

本次分享我們將介紹兩篇來(lái)自ACL2021和一篇來(lái)自EMNLP2021的論辯挖掘相關(guān)論文。第一篇文章提出了一種基于神經(jīng)轉(zhuǎn)移的論辯挖掘模型;第二篇文章提出了一種評(píng)估論證充分性的新方法;第三篇文章對(duì)于推文的論辯挖掘定義為一種新的文本分類任務(wù)。

文章概覽

1.基于神經(jīng)轉(zhuǎn)移的論辯挖掘模型(A Neural Transition-based Model for Argumentation Mining)

論文提出了一種針對(duì)論辯挖掘任務(wù)的新方法,該方法通過(guò)產(chǎn)生一系列的動(dòng)作來(lái)逐步構(gòu)建出一個(gè)論證圖,從而有效地避免了枚舉操作;此外,該方法還可以在不引入任何新的結(jié)構(gòu)約束條件下處理樹形(tree)或非樹形(non-tree)的結(jié)構(gòu)化論證。試驗(yàn)結(jié)果表明,該模型在兩個(gè)不同結(jié)構(gòu)的公開(kāi)數(shù)據(jù)集上達(dá)到了最優(yōu)性能。

論文地址:https://aclanthology.org/2021.acl-long.497

2.基于結(jié)論生成的論證充分性評(píng)估(Assessing the Sufficiency of Arguments through Conclusion Generation)

論文提出了一種針對(duì)論證充分性評(píng)估的新方法,即假設(shè)充分的論證所生成的結(jié)論是可以由其前提(premise)生成的。為了驗(yàn)證猜想,文章基于大規(guī)模預(yù)訓(xùn)練語(yǔ)言模型來(lái)探索充分性評(píng)估的潛力。實(shí)驗(yàn)結(jié)果表明,該方法性能達(dá)到最優(yōu),F(xiàn)1-score高達(dá)0.885。

論文地址:https://aclanthology.org/2021.argmining-1.7

3. 基于推文的論辯挖掘:計(jì)劃生育立場(chǎng)辯論的案例研究(Argument Mining on Twitter: A Case Study on the Planned Parenthood Debate)

對(duì)于推文的論辯挖掘,論文用一種新的方式定義了該問(wèn)題。由于主張?jiān)谕莆闹泻苋菀妆蛔R(shí)別出來(lái),所以文章的重點(diǎn)就在于識(shí)別出支持或反對(duì)主張的前提,即將該問(wèn)題定義為文本分類任務(wù)。論文提供了一個(gè)新的數(shù)據(jù)集,并且通過(guò)分析信息最豐富的文本,論文在推文中挖掘出了突出論點(diǎn)。

論文地址:https://aclanthology.org/2021.argmining-1.1

論文細(xì)節(jié)

1

動(dòng)機(jī)

論辯挖掘(AM)其中一個(gè)子任務(wù)的目的是從文本中自動(dòng)地識(shí)別出論點(diǎn)之間是否有關(guān)(ARI)。由于論點(diǎn)之間的語(yǔ)義關(guān)系是非常復(fù)雜的,所以論點(diǎn)之間的關(guān)系識(shí)別是論辯挖掘任務(wù)中最具有挑戰(zhàn)性的。而大多數(shù)現(xiàn)有的方法都是通過(guò)枚舉出論點(diǎn)之間所有可能的配對(duì)來(lái)確定它們之間是否有關(guān)。但是大多數(shù)論點(diǎn)之間是無(wú)關(guān)的,所以將所有的論點(diǎn)進(jìn)行配對(duì)會(huì)使得效率極低并且會(huì)造成類別不平衡的問(wèn)題。此外,對(duì)于樹型結(jié)構(gòu)來(lái)講,每一個(gè)論點(diǎn)至多有一個(gè)“出邊(outgoing)”來(lái)指向另一個(gè)論點(diǎn);對(duì)于非樹型結(jié)構(gòu)則沒(méi)有這種限制。由于論證的復(fù)雜性,到目前為止,還沒(méi)有一種通用的方法可以同時(shí)解決樹型或非樹型的論證結(jié)構(gòu)。

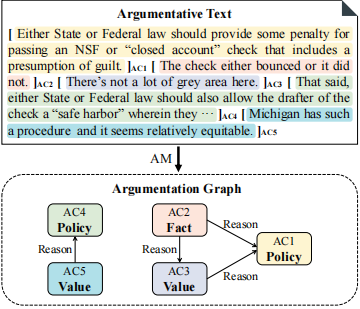

任務(wù)定義

由于論文假設(shè)AM任務(wù)的第一階段已經(jīng)完成,即已經(jīng)將論點(diǎn)句子從文本中識(shí)別出來(lái),所以論文的任務(wù)分為以下兩部分:1)對(duì)論點(diǎn)(AC)進(jìn)行分類;2)識(shí)別論點(diǎn)之間是否存在關(guān)聯(lián),從而得到一個(gè)有向論證圖,其中論證圖的節(jié)點(diǎn)表示論點(diǎn),有向邊表示論點(diǎn)之間的存在關(guān)聯(lián)。同時(shí),論文定義了包含了個(gè)單詞的段落以及包含個(gè)論點(diǎn)的集合,每一個(gè)論點(diǎn)由論點(diǎn)的開(kāi)始位置和結(jié)束位置來(lái)表示。

模型方法

轉(zhuǎn)移系統(tǒng)(Transition System)

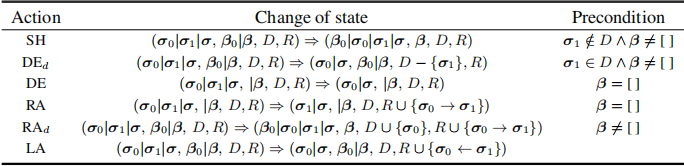

轉(zhuǎn)移系統(tǒng)包含了六種動(dòng)作(actions),不同的動(dòng)作將會(huì)以不同的方式改變解析狀態(tài)(parser state):

:當(dāng)非空并且不在之中,從彈出,然后將移到的頂部。

:當(dāng)非空并且在之中,從和刪除,保持不變。

:當(dāng)為空,從中刪除,并保持和不變。

:當(dāng)為空,從中刪除,并為到分配一條有向邊。

:當(dāng)非空,從彈出,然后將移到的頂部,并為到分配一條有向邊,并且將添加到之中。這一策略有利于挖掘出更多與有關(guān)的有向邊 。

:從中刪除,并為到分配一條有向邊。

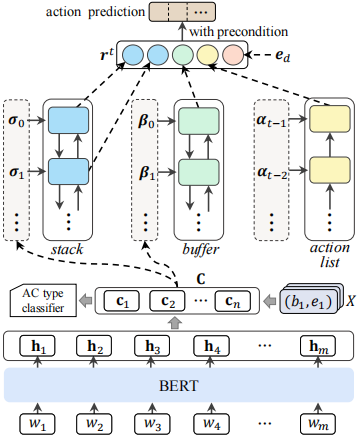

狀態(tài)表示(State Representation)

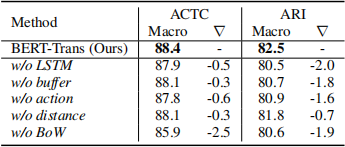

文章用BERT來(lái)獲得論點(diǎn)的表示,用LSTM來(lái)編碼、和的長(zhǎng)期依賴。

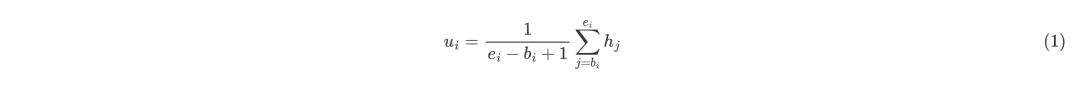

論點(diǎn)的表示將段落傳入BERT得到文本表示矩陣,其中表示第個(gè)單詞的詞向量,表示BERT最后一層的向量維度。對(duì)于論點(diǎn),文章通過(guò)平均池化操作來(lái)獲得論點(diǎn)的表示,具體來(lái)說(shuō):

其中表示第個(gè)論點(diǎn)。另外,對(duì)于論點(diǎn)的表示,文章結(jié)合了一些額外的特征:詞袋特征、位置編碼以及段落類型編碼。將其他特征歸結(jié)為,此時(shí)第個(gè)論點(diǎn)表示為和的組合:

因此,在段落中的論點(diǎn)可以表示為。

解析狀態(tài)的表示在每一時(shí)間步,文章將解析狀態(tài)表示為,表示,存儲(chǔ)處理過(guò)的論點(diǎn);表示,存儲(chǔ)未處理的論點(diǎn);表示,記錄之后需要被刪除的論點(diǎn);表示,記錄歷史動(dòng)作。為了獲得的文本表示,將它傳遞給BiLSTM:

其中,為的長(zhǎng)度,為隱藏元的數(shù)量;同理的文本表示為:

其中,為的長(zhǎng)度。對(duì)于歷史動(dòng)作信息,文中中采用單向LSTM來(lái)編碼:

其中,為的長(zhǎng)度。考慮到之間的相對(duì)距離對(duì)于確定它們之間是否有關(guān)來(lái)說(shuō)是非常好的特征,所以文章將這種相對(duì)距離嵌入為,因此,解析狀態(tài)可以表示為:

其中和表示中的第一個(gè)和第二個(gè)元素,表示中的第一個(gè)元素。

動(dòng)作預(yù)測(cè)首先通過(guò)多層感知機(jī)將降維到,之后再通過(guò)softmax預(yù)測(cè)動(dòng)作的概率。

實(shí)驗(yàn)

數(shù)據(jù)集

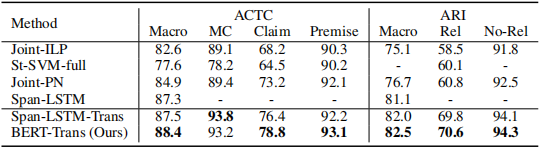

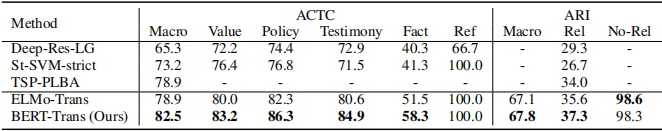

Persuasive Essays (PE)該數(shù)據(jù)集包含402篇學(xué)生議論文,1833個(gè)段落。論點(diǎn)分為三種:Major-Claim,Claim和Premise。PE數(shù)據(jù)集中每個(gè)論點(diǎn)最多只有一條“出邊”,即符合樹型結(jié)構(gòu)。

CDCP該數(shù)據(jù)集一共包含731個(gè)段落。論點(diǎn)分為五類:Reference,F(xiàn)act,Testimony,Value和Policy。該數(shù)據(jù)集每個(gè)論點(diǎn)可以有多條“出邊”,屬于非樹型結(jié)構(gòu)。

實(shí)驗(yàn)結(jié)果

實(shí)驗(yàn)結(jié)果表明,文章提出的模型在兩個(gè)數(shù)據(jù)集上的結(jié)果均為最優(yōu)。

消融實(shí)驗(yàn): 驗(yàn)證了文章提出的模型的優(yōu)越性。

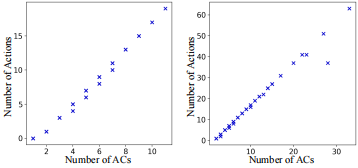

模型復(fù)雜度:之前的研究是對(duì)任意兩個(gè)論點(diǎn)進(jìn)行配對(duì),模型復(fù)雜度高達(dá),而論文提出的模型可以將時(shí)間復(fù)雜度降為。

2

動(dòng)機(jī)

在之前的研究中,總是將論證的充分性評(píng)估建模為標(biāo)準(zhǔn)的文本分類任務(wù),并且用傳統(tǒng)的卷積神經(jīng)網(wǎng)絡(luò)和特征提取的方式來(lái)處理。然而為了進(jìn)一步提高性能,研究者們?cè)噲D將文本中直接可用的信息進(jìn)行整合,但是現(xiàn)有的工作中既沒(méi)有考慮論證的前提和結(jié)論,也沒(méi)有考慮結(jié)論和前提之間的關(guān)系。由此作者提出了一種假設(shè):只有充分的論證才可能從“前提”中推斷出“結(jié)論”。由于論證質(zhì)量評(píng)估任務(wù)中幾乎沒(méi)有考慮過(guò)大規(guī)模預(yù)訓(xùn)練語(yǔ)言模型所帶來(lái)的編碼信息,所以作者提出基于預(yù)訓(xùn)練語(yǔ)言模型來(lái)探索充分性評(píng)估的潛力。

任務(wù)定義

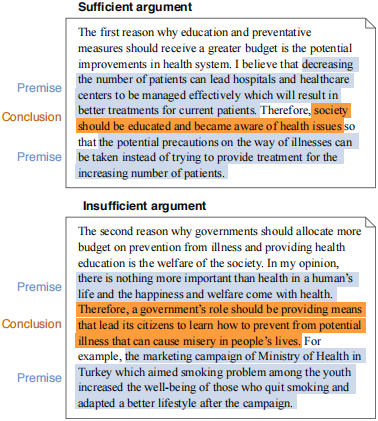

論證的充分性是指是否可以通過(guò)論證的前提來(lái)合理地推斷出結(jié)論。文章作者研究了由論證的前提自動(dòng)生成結(jié)論是否有利于論證充分性的計(jì)算評(píng)估,作者旨在通過(guò)將生成的結(jié)論與原始標(biāo)注相結(jié)合,進(jìn)而從不充分的論證中挖掘出充分的論證。

文章貢獻(xiàn)

語(yǔ)言模型可以生成與人類說(shuō)話方式類似的論證結(jié)論。

文章提出的方法可以在論證充分性評(píng)估中達(dá)到SOTA效果。

深入討論了在論證的充分性評(píng)估中結(jié)構(gòu)注釋的重要性。

模型方法

方法由兩階段來(lái)實(shí)現(xiàn):

在對(duì)原始結(jié)論進(jìn)行掩碼操作的論證中得到預(yù)訓(xùn)練語(yǔ)言模型,之后通過(guò)該模型來(lái)自動(dòng)的生成結(jié)論。

其次,通過(guò)對(duì)原始輸入論證的的8個(gè)實(shí)驗(yàn),利用生成的結(jié)論來(lái)評(píng)估論證的充分性。

通過(guò)降噪來(lái)生成結(jié)論

BART-unsupervised 不對(duì)BART進(jìn)行微調(diào),使之作為baseline。

BART-supervised 通過(guò)在學(xué)生議論文數(shù)據(jù)集中微調(diào)BART,以便調(diào)整其降噪能力,進(jìn)而生成結(jié)論。

充分性評(píng)估

通過(guò)在RoBERTa之后加入一個(gè)線性層來(lái)預(yù)測(cè)論證的前提是否可以合理地推斷出結(jié)論。

評(píng)估

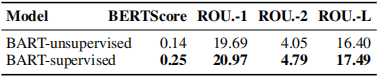

評(píng)估生成結(jié)論的質(zhì)量

自動(dòng)評(píng)估:通過(guò)對(duì)比BART-unsupervised與BART-supervised,可以發(fā)現(xiàn)微調(diào)之后的BART性能更優(yōu)。

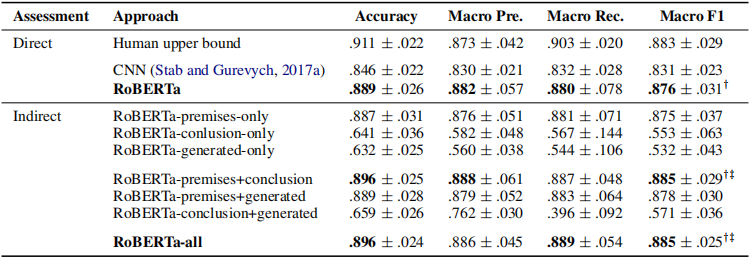

評(píng)價(jià)充分性評(píng)估

直接的充分性評(píng)估通過(guò)比較RoBERTa與CNN以及人工評(píng)估,可以發(fā)現(xiàn)經(jīng)過(guò)微調(diào)的預(yù)訓(xùn)練語(yǔ)言模型幾乎與人工評(píng)估一致。

間接的充分性評(píng)估通過(guò)對(duì)比7種不同的輸入特征可以發(fā)現(xiàn),當(dāng)綜合了全部特征或者只包含論證的前提以及原始結(jié)論時(shí),模型的性能最優(yōu)。

RoBERTa-premises-only 將原始結(jié)論進(jìn)行掩碼操作之后,再作為模型的輸入。

RoBERTa-conclusion-only 只是將原始結(jié)論作為模型的輸入。

RoBERTa-generated-only 只用生成的結(jié)論作為模型的輸入。

RoBERTa-premises+conclusion 在原始輸入中對(duì)原始結(jié)論進(jìn)行標(biāo)記之后再作為模型輸入。

RoBERTa-premises+generated 對(duì)原始的結(jié)論進(jìn)行掩碼操作并且加入生成的結(jié)論來(lái)作為模型的輸入。

RoBERTa-conclusion+generated 將原始結(jié)論以及生成的結(jié)論作為模型的輸入。

RoBERTa-all 結(jié)合所有的特征作為模型的輸入。

3

動(dòng)機(jī)

推特是一個(gè)很受歡迎的社交平臺(tái),很多網(wǎng)友會(huì)在推特上分享自己的觀點(diǎn)。這些信息對(duì)決策者、營(yíng)銷人員和社會(huì)科學(xué)家來(lái)說(shuō)是無(wú)價(jià)的。然而,在推特上挖掘論點(diǎn)的努力是有限的,主要是因?yàn)橐粭l推文通常太短,不能包含一個(gè)完整的論點(diǎn)——既有主張,也有前提。由于這個(gè)原因,現(xiàn)有的基于推特的論辯挖掘方法通常側(cè)重于識(shí)別主張(claim)或者是前提(premise),而不能同時(shí)識(shí)別出兩者。這并不是理想的,因?yàn)樽鳛橹С种鲝埖淖C據(jù)同樣是非常重要的。

任務(wù)定義

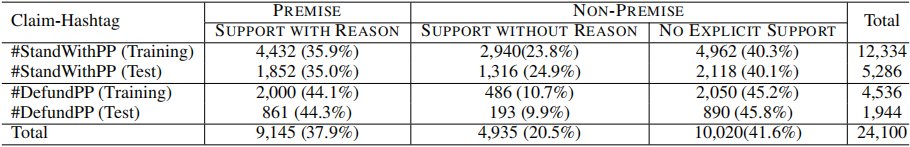

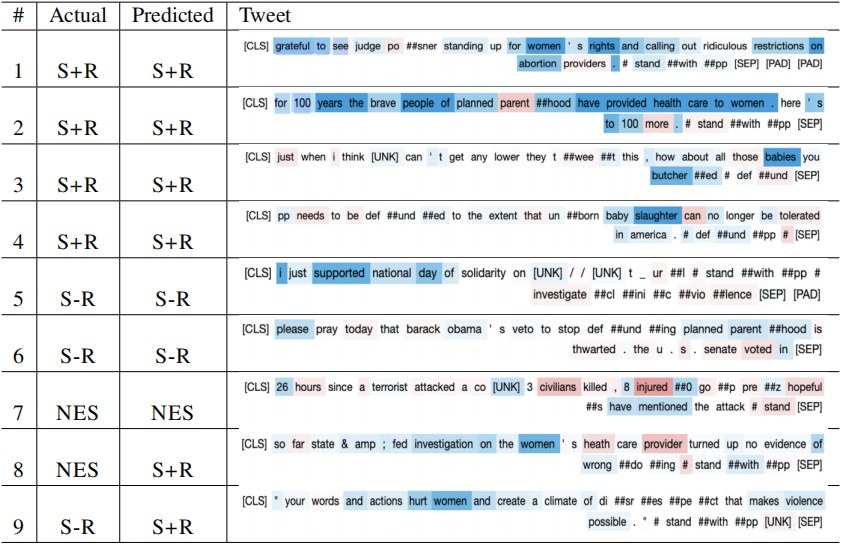

論文就是否支持計(jì)劃生育問(wèn)題,在推特了獲得了24,100條推文作為論文數(shù)據(jù)集,并且定義了“claim-hashtag”表示帶有主張的推文,“premise-tweet”表示帶有前提的推文。之所以選擇計(jì)劃生育角度,是因?yàn)殛P(guān)于計(jì)劃生育的辯論是多方面的,其中包括女權(quán),人權(quán)以及健康醫(yī)療等諸多社會(huì)話題從論辯挖掘的角度來(lái)說(shuō),帶有主張的推文可以通過(guò)簡(jiǎn)單的文本匹配來(lái)檢索到。因此,文章的主要任務(wù)就是對(duì)于給定的推文,判斷其是否為“前提”,即論文將該任務(wù)定義為文本分類任務(wù)。

文章貢獻(xiàn)

論文提出了一個(gè)新的解決問(wèn)題的方法,用來(lái)在推特上挖掘包含主張與前提的完整論點(diǎn)。

論文提供了一個(gè)由24,100條推文組成的新標(biāo)注數(shù)據(jù)集,它的數(shù)據(jù)量是之前關(guān)于推特的數(shù)據(jù)集的10到80倍。

通過(guò)分析信息最豐富的文本,論文在推文中挖掘出了支持和反對(duì)資助計(jì)劃生育的突出論點(diǎn)。

數(shù)據(jù)集

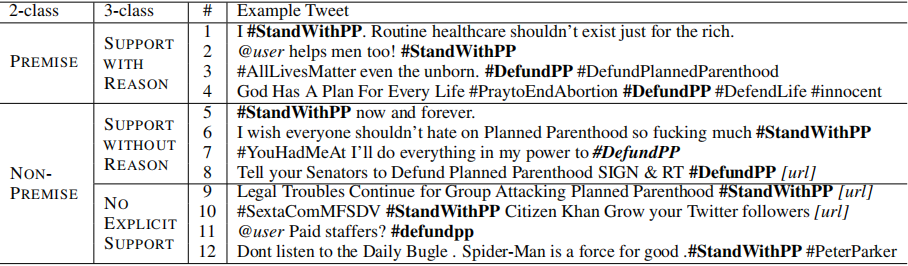

標(biāo)注人員將每一條推文分類為以下三種類別之一,從而挖掘出包含完整論點(diǎn)的推文:

SUPPORT WITH REASON:用戶支持或反對(duì)主張并且給出了原因,無(wú)論原因是否有效。

SUPPORT WITHOUT REASON:用戶僅僅支持或反對(duì)主張,但是并沒(méi)有給出原因。

NO EXPLICIT SUPPORT:用戶對(duì)主張表示中立或者立場(chǎng)不明確。

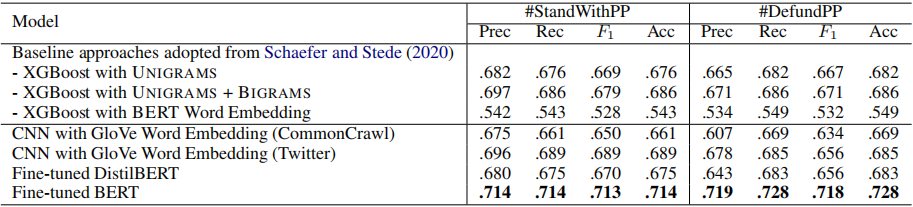

模型方法

微調(diào)BERT在BERT之后加上全連接層并且用ReLu作為激活函數(shù)。此外,文章還驗(yàn)證了DistilBERT的性能,DistilBERT是比BERT在結(jié)構(gòu)上要簡(jiǎn)單,并且在一些特殊的下游任務(wù)中,性能可以與BERT相媲美。

CNNBERT的注意力機(jī)制被證明可以有效地捕捉到文本之間的長(zhǎng)短期記憶,但是由于推文一般都是很簡(jiǎn)短的,所以單純使用CNN也是有效的,對(duì)于單詞的嵌入操作則用GloVe詞向量即可。

XGBoostXGBoost在一些文本分類任務(wù)中非常有效,論文將XGBoost的變體模型作為baseline。

實(shí)驗(yàn)結(jié)果

實(shí)驗(yàn)結(jié)果表明,微調(diào)BERT的性能最優(yōu)。

SHAP值代表對(duì)于給定特征,模型對(duì)文本分類的影響程度。通過(guò)分析微調(diào)BERT的SHAP值,可以發(fā)現(xiàn)在SUPPORT WITH REASON中,SHAP值越高,意味著該特征越有可能成為突出特征。例如,在支持計(jì)劃生育的文本中,“女權(quán)”或者“健康服務(wù)”的SHAP值排名靠前。當(dāng)這類詞出現(xiàn)時(shí),該文本最可能被分為SUPPORT WITH REASON中。

審核編輯 :李倩

-

模型

+關(guān)注

關(guān)注

1文章

3499瀏覽量

50066 -

語(yǔ)言模型

+關(guān)注

關(guān)注

0文章

560瀏覽量

10694

原文標(biāo)題:ACL&EMNLP'21 | 基于神經(jīng)轉(zhuǎn)移模型的論辯挖掘任務(wù)

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語(yǔ)言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

基于神經(jīng)轉(zhuǎn)移模型的論辯挖掘任務(wù)

基于神經(jīng)轉(zhuǎn)移模型的論辯挖掘任務(wù)

評(píng)論