多模式視覺語言模型依賴大量數據集來對圖像和文本之間的關系進行建模。一般來說,這些數據集有兩種創建方法:手動為圖像添加文字說明,或抓取網頁并提取替代文本 (alt-text)作為文字說明。雖然前一種方法更利于產生更高質量的數據,但高強度的人工注釋過程限制了可創建的數據量。另一方面,雖然自動提取方法可以產生更大的數據集,但卻需要通過啟發式算法以及仔細過濾來確保數據質量,或者擴展模型來保證強大性能。現有數據集的另一個缺點是極少涉及非英語語言。這不禁讓我們產生疑問:我們能否突破這些限制,創建包含各種內容的高質量、大規模、多語言數據集?

圖像和文本之間的關系

https://ai.googleblog.com/2014/11/a-picture-is-worth-thousand-coherent.html

確保數據質量

https://ai.googleblog.com/2018/09/conceptual-captions-new-dataset-and.html

對此,我們推出了基于維基百科的圖像文本 (WIT) 數據集。這是一個大型多模式數據集,通過從維基百科文章和 Wikimedia 圖像鏈接中提取與圖像相關的多種不同文本選擇集創建而成。在創建過程中會執行嚴格的過濾環節,以便僅保留高質量的圖像文本集。

基于維基百科的圖像文本 (WIT) 數據集

https://github.com/google-research-datasets/wit

如我們在 SIGIR 2021 上發布的“WIT:適用于多模式、多語言機器學習的基于維基百科的圖像文本數據集 (WIT: Wikipedia-based Image Text Dataset for Multimodal Multilingual Machine Learning)”中詳細說明的那樣,該過程產生一個包含 3750 萬個實體豐富的圖像文本示例精選集,其中涵蓋 1150 萬張獨特的圖像,跨越 108 種語言。大家可憑知識共享許可下載并使用 WIT 數據集。此外,我們也很高興地宣布,我們將與 Wikimedia Research 以及其他外部協作者攜手在 Kaggle 舉辦 WIT 數據集的競賽。

| 數據集 |

圖像 數量 |

文本 |

上下文 文本 |

語言數量 |

| Flickr30K | 32K | 158K | - | < 8 |

| SBU Captions | 1M | 1M | - | 1 |

| MS-COCO | 330K | 1.5M | - |

< 4;7 (僅限測試) |

| CC-3M | 3.3M | 3.3M | - | 1 |

| CC-12M | 12M | 12M | - | 1 |

| WIT | 11.5M | 37.5M | ~119M | 108 |

相比以往數據集,WIT 的語言更多,規模更大

WIT 數據集的獨特優勢包括:

1. 大規模:WIT 是公開提供的最大的圖像文本示例多模式數據集。

2.多語言:WIT 擁有 108 種語言,是其他數據集的十倍或以上。

3.上下文信息:與典型的多模式數據集(每個圖像只有一個文字說明)不同,WIT 包含許多頁面級和部分級上下文信息。

4.現實世界實體:維基百科是一個覆蓋廣泛的知識庫,其豐富的現實世界實體可以在 WIT 中得以體現。

5.具有挑戰性的測試集:在我們最近獲得 EMNLP 接受的研究中,所有最先進的模型在 WIT 上表現出的性能都明顯低于傳統評估集,例如平均召回率 (recall)下降約 30 點。

最近獲得 EMNLP 接受的研究

https://arxiv.org/abs/2109.05125

數據集的創建過程

WIT 的主要目標是在不犧牲質量和概念覆蓋面的情況下創建大型數據集。因此,我們選擇利用當今最大的在線百科全書:維基百科。

就可用信息的深度而言,我們以維基百科上的“Half Dome”(加州約塞米蒂國家公園)頁面為例如下所示,文章為圖像提供了許多有趣的文本說明和相關的上下文信息,如頁面標題、主要頁面描述以及其他上下文信息和元數據。

我們首先選擇包含圖像的維基百科頁面,然后提取各種圖像文本關聯內容和周圍的上下文。為進一步優化數據,我們執行嚴格的過濾環節來確保數據質量。過濾過程包含:

●

基于文本的過濾,以確保文字說明的可用性、長度和質量(例如通過刪除通用默認填充文本);

●

基于圖像的過濾,以確保每個圖像都具有特定的大小且擁有允許的許可;

●

基于圖像和文本實體的過濾,以確保適合研究(例如排除仇恨類言論)。

接著我們進一步對圖像文字說明集隨機抽樣,由真人進行校對評估,他們中絕大多數人都認可一個結論:98% 樣本其圖像與文字說明一致。

高度語言多樣性

WIT 擁有 108 種語言的數據,是首個大規模、多語言、多模式數據集。

| 圖像文本集數量 |

獨特語言 數量 |

圖像數量 |

獨特語言 數量 |

| > 1M | 9 | > 1M | 6 |

| 500K - 1M | 10 | 500K - 1M | 12 |

| 100K - 500K | 36 | 100K - 500K | 35 |

| 50K - 100K | 15 | 50K - 100K | 17 |

| 14K - 50K | 38 | 13K - 50K | 38 |

WIT:跨語言覆蓋統計信息

首個上下文圖像文字數據集

大多數多模式數據集僅為給定圖像提供單個文本說明(或類似文字說明的多個版本)。WIT 是首個提供上下文信息的數據集, 可以幫助研究人員就上下文對圖像文字說明以及圖像選擇的影響進行建模。

具體而言,可能有助于研究的 WIT 關鍵文本字段包括:

●

文本說明:WIT 提供三種不同的圖像文字說明,包括(可能受上下文影響的)“參考描述”、(可能不受上下文影響的)“屬性描述”,以及“替代文本描述”。

●

上下文信息:包括頁面標題、頁面描述、網址和有關維基百科部分的局部上下文(包括部分標題和文本)。

如下所示,WIT 在以下不同字段具有廣泛的覆蓋。

|

WIT 圖像 文字字段 |

訓練 | Val | 測試 | 合計/獨特 |

| 行/元組 | 37.1M | 261.8K | 210.7K | 37.6M |

| 獨特的圖像 | 11.4M | 58K | 57K | 11.5M |

| 參考描述 | 16.9M | 150K | 104K | 17.2M/16.7M |

| 屬性描述 | 34.8M | 193K | 200K | 35.2M/10.9M |

| 替代文本 | 5.3M | 29K | 29K | 5.4M/5.3M |

| 上下文文本 | - | - | - | 119.8M |

WIT 的關鍵字段兼有文本說明和上下文信息

高質量訓練集與

具有挑戰性的評估基準

維基百科廣泛覆蓋各種概念,這意味著 WIT 評估集作為評估基準非常具有挑戰性,即使對于最先進的模型而言也是如此。在圖像文本檢索方面,我們發現傳統數據集的平均召回分數 (mean recall scores)為 80 秒,而對于 WIT 測試集而言,資源豐富的語言為 40 秒,資源不足的語言為 30 秒。我們希望這可以轉而幫助研究人員構建更強大、更穩健的模型。

WIT 數據集與 Wikimedia 和

Kaggle 攜手開展競賽

此外,非常高興地宣布,我們將攜手 Wikimedia Research 以及一些外部協作者共同組織 WIT 測試集的競賽。競賽將在 Kaggle 舉辦,競賽任務為圖像文本檢索。我們將給定一組圖像和文本說明,而參賽者的任務是為每個圖像檢索適當的文字說明。

為促進該領域的研究,維基百科為大部分訓練和測試數據集提供了 300 像素分辨率的圖像和基于 Resnet-50 的圖像嵌入向量。除 WIT 數據集以外,Kaggle 還將托管所有圖像數據,并提供 Colab notebooks。此外,參賽者屆時可訪問 Kaggle 論壇,以便分享代碼和開展協作。任何對多模態感興趣的人都可以借此輕松開始并運行實驗。我們很高興并且期待各位參賽者可以在 Kaggle 平臺,通過 WIT 數據集和維基百科圖像為我們帶來精彩表現。

結論

我們相信 WIT 數據集將幫助研究人員構建更好的多模態多語言模型,并識別更好的學習和表征技術,最終借助視覺語言數據在現實世界任務中優化機器學習模型。如有任何問題,請聯系 [email protected]。我們非常愿意傾聽您如何使用 WIT 數據集。

責任編輯:haq

-

數據

+關注

關注

8文章

7241瀏覽量

91001 -

模型

+關注

關注

1文章

3486瀏覽量

49990 -

機器學習

+關注

關注

66文章

8492瀏覽量

134087

原文標題:基于維基百科的圖像文本數據集 (WIT)

文章出處:【微信號:tensorflowers,微信公眾號:Tensorflowers】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

淺析:數字經濟時代,高質量數據集對AI產業帶來哪些新的變化

高質量 HarmonyOS 權限管控流程

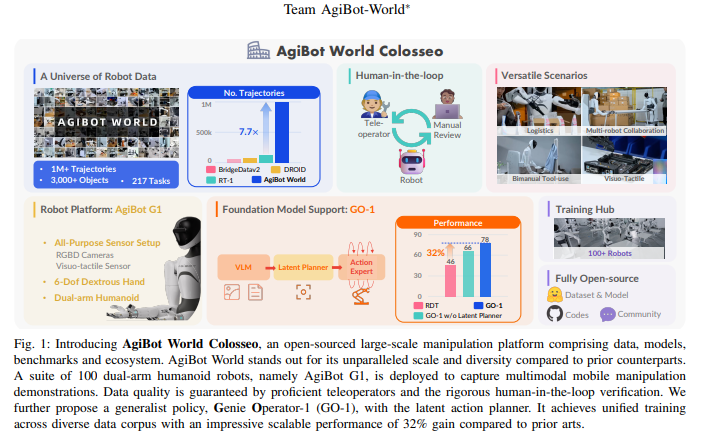

AgiBot World Colosseo:構建通用機器人智能的規模化數據平臺

廣汽集團召開高質量發展大會

微軟Copilot Voice升級,積極拓展多語言支持

借助谷歌Gemini和Imagen模型生成高質量圖像

ChatGPT 的多語言支持特點

科大訊飛發布訊飛星火4.0 Turbo大模型及星火多語言大模型

中興通訊引領5G-A高質量發展新紀元

揭秘高質量點焊機的五大標準:打造焊接性能的基石

如何創建高質量、大規模、多語言的數據集

如何創建高質量、大規模、多語言的數據集

評論