1. 簡介

自注意力網(wǎng)絡(luò)(SANs)在許多自然語言處理任務(wù)中取得顯著的成功,其中包括機器翻譯、自然語言推理以及語義角色標注任務(wù)。相比傳統(tǒng)的循環(huán)神經(jīng)網(wǎng)絡(luò)以及卷積神經(jīng)網(wǎng)絡(luò),自注意力網(wǎng)絡(luò)優(yōu)勢在于其高度的運算并行性以及更加靈活的建模輸入元素的依存關(guān)系能力。傳統(tǒng)的自注意力網(wǎng)絡(luò)模型在計算每個元素的表示的時候,將所有的輸入的元素考慮在內(nèi),而不管其對于當前元素的相關(guān)性。本問題提出通用的基于選擇機制的自注意力網(wǎng)絡(luò)模型(SSANs),其可以針對每個計算表示的元素,動態(tài)地選擇其相關(guān)性的子集,以此作為輸入進行后續(xù)的自注意力網(wǎng)絡(luò)的計算。實驗結(jié)果顯示,SSANs模型在多個典型的自然語言處理任務(wù)上相比傳統(tǒng)的自注意力網(wǎng)絡(luò)模型獲得提升。通過多個探測任務(wù)進行分析,SSANs相比傳統(tǒng)的SANs模型有更強的詞序信息編碼能力以及結(jié)構(gòu)信息建模能力。

2. 模型結(jié)構(gòu)

2.1 傳統(tǒng)的自注意力網(wǎng)絡(luò)

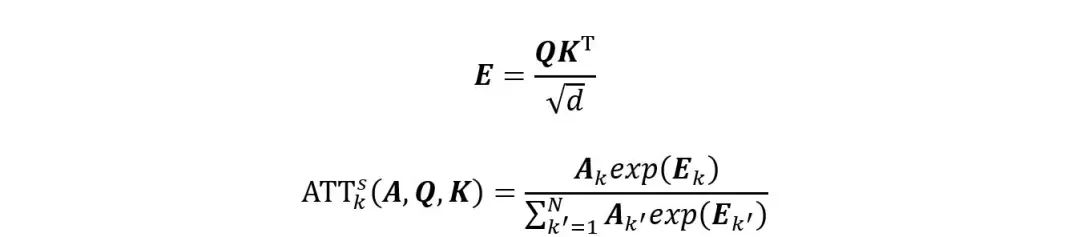

現(xiàn)在的自注意力網(wǎng)絡(luò)是傳統(tǒng)的注意力網(wǎng)路的特例,其計算注意力權(quán)重的兩個元素來源同樣的輸入序列。給定輸入隱層表示,自注意力網(wǎng)絡(luò)SANs首先將H分別線性變換成、以及。自注意力網(wǎng)絡(luò)的輸出O計算過程如下:

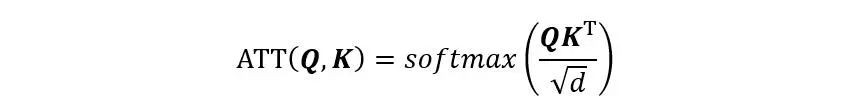

其中是基于點積的注意力機制,其計算過程如下:

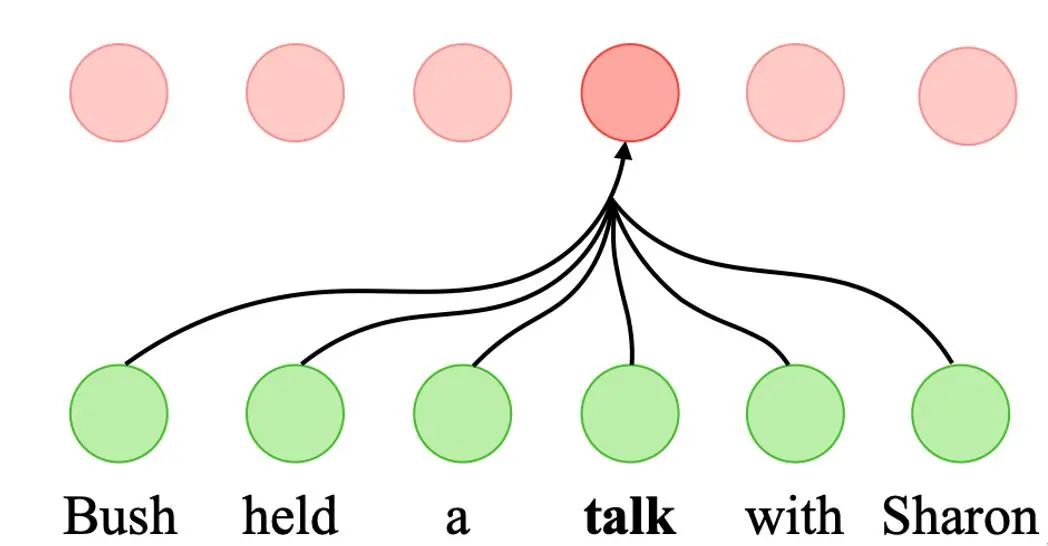

其中√d是縮放因子且d是隱含層狀態(tài)表示的維度。傳統(tǒng)的自注意力網(wǎng)絡(luò)結(jié)構(gòu)如圖 1所示。

圖1 傳統(tǒng)的自注意力網(wǎng)絡(luò)框架

2.2 基于選擇機制的自注意力網(wǎng)絡(luò)

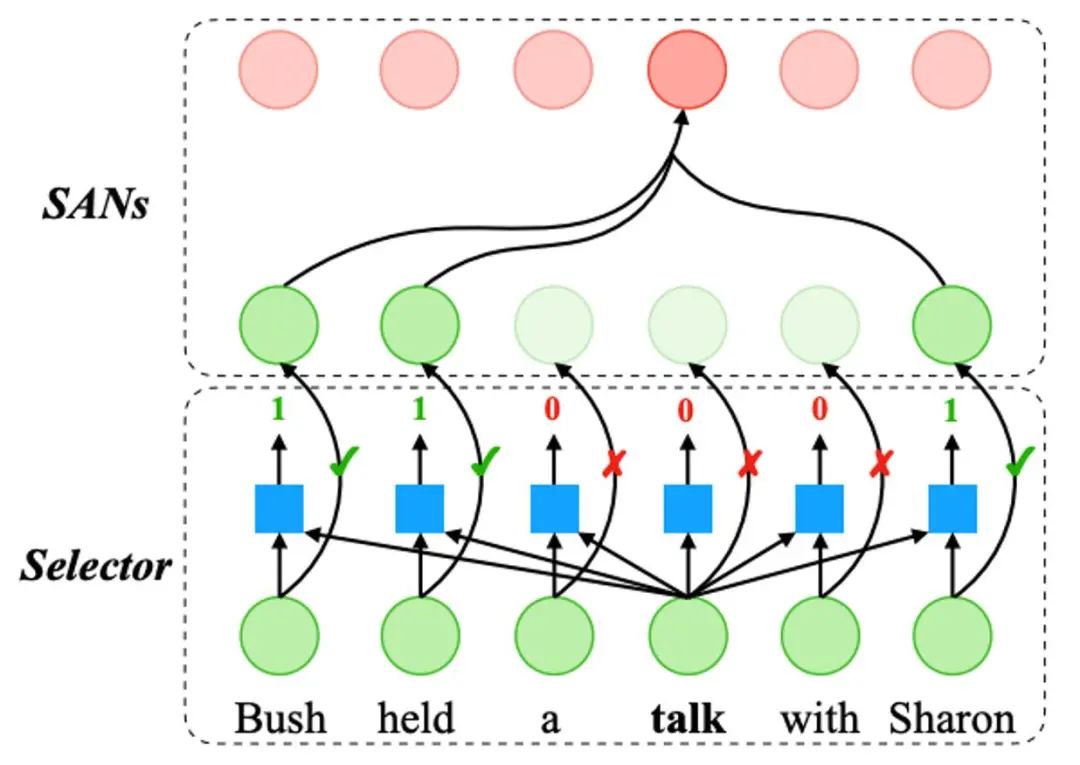

相比傳統(tǒng)的自注意力網(wǎng)絡(luò),本文引入一個選擇器模塊(Selector),其主要針對每個待計算表示的元素,動態(tài)地選擇輸入元素的集合中的一個子集作為其相關(guān)元素集合,基于此集合進行后續(xù)的常規(guī)的自注意力網(wǎng)絡(luò)的計算,其整體的框架如圖 2所示。

圖2 基本自注意力機制的自注意力網(wǎng)絡(luò)框架

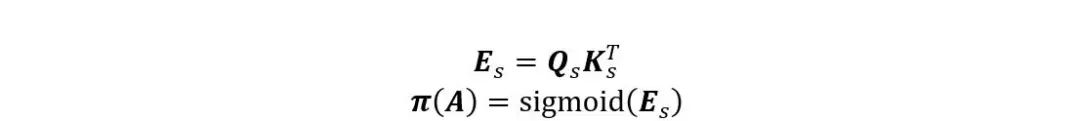

選擇器模塊本文使用額外的策略網(wǎng)絡(luò)參數(shù)化選擇動作,其中表示其對應(yīng)的元素被選擇進行后續(xù)的常規(guī)的自注意力網(wǎng)路的計算,而則代表相應(yīng)的元素未被選中。其輸出動作序列計算過程如下:

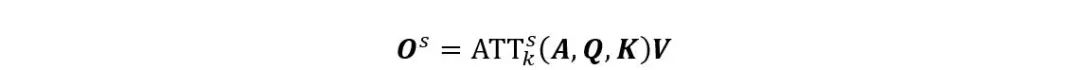

其中以及是線性變換的結(jié)果。本文使用sigmoid作為激活函數(shù)計算策略分布。通過使用額外的選擇器模塊,SSANs的注意力權(quán)重計算過程如下:

最終基于選擇機制的自注意力網(wǎng)絡(luò)的輸出計算過程如下:

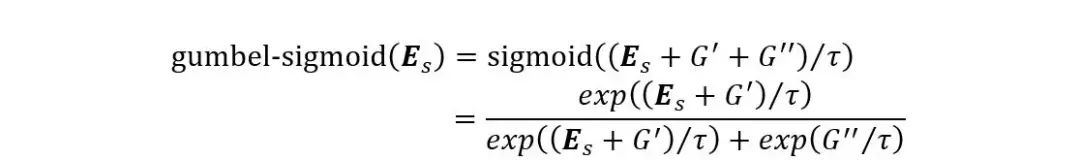

Gumbel-Sigmoid本文使用gumbel-softmax對隱含變量A的梯度進行評估,其主要將離散的采樣過程連續(xù)化,這樣使用正常的BP算法就可以實現(xiàn)對其梯度評估。相比REINFORCE算法,其穩(wěn)定性更高。本文策略網(wǎng)絡(luò)使用sigmoid作為激活函數(shù),其可以看作是softmax的特例,從而依據(jù)gumbel-softmax函數(shù)計算方法,可以推導(dǎo)出gumbel-sigmoid形式如下:

其中G'和G''是gumbel noise。

3 實驗結(jié)果

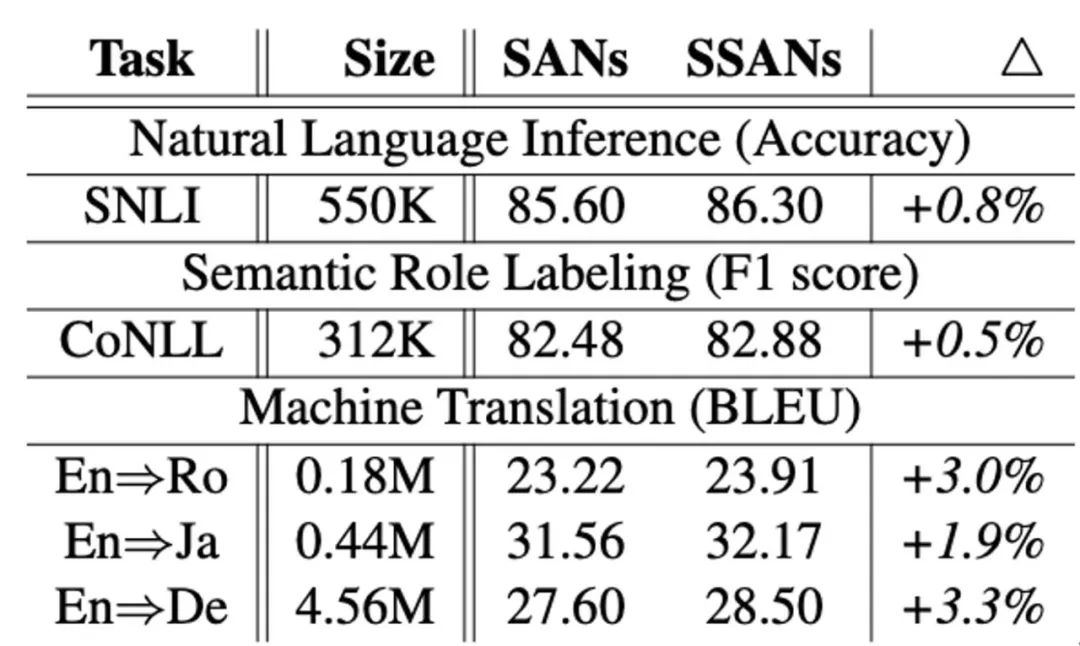

基于選擇機制的自注意力網(wǎng)絡(luò)模型在三個典型的NLP任務(wù)上取得一致的提升。特別的,在機器翻譯任務(wù)上,SSANs在三個英語到其他語言的翻譯上超過傳統(tǒng)的SANs模型。在英語=>羅馬尼亞以及英語=>日語的翻譯任務(wù)上,SSANs分別獲得+0.69和+0.61 BLEU提升。此外,在相對規(guī)模比較大的英=>德翻譯任務(wù)上,SSANs也獲得一致的提升(+0.90 BLEU)。

表1 基于選擇的自注意力網(wǎng)絡(luò)模型在不同任務(wù)上的結(jié)果

4 實驗分析

4.1 詞序信息編碼能力評價

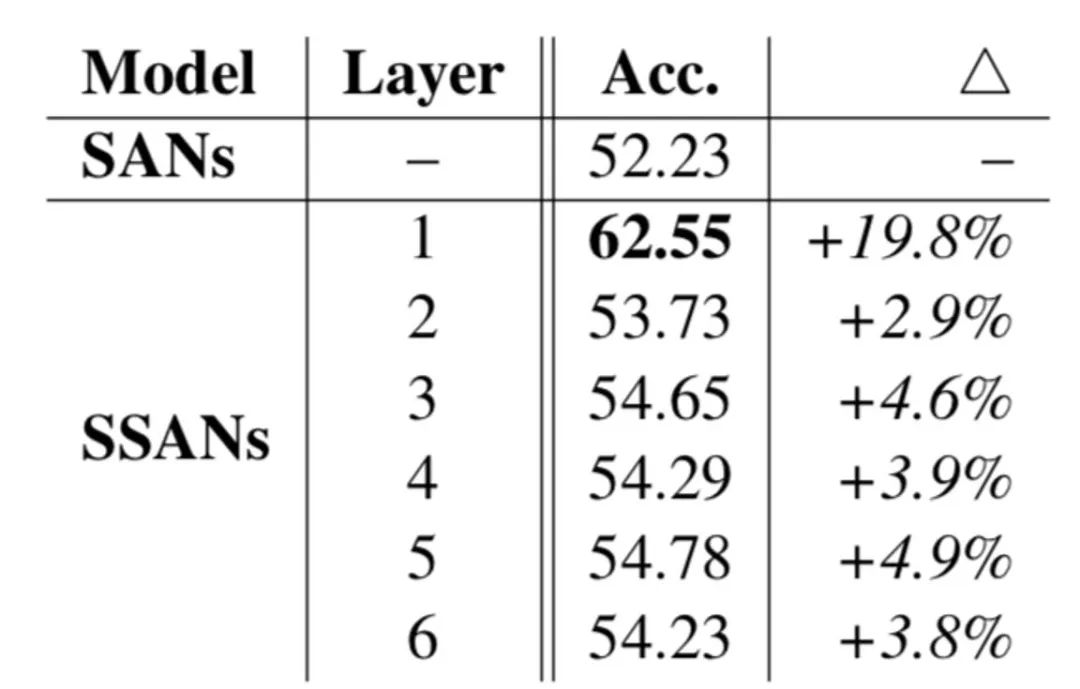

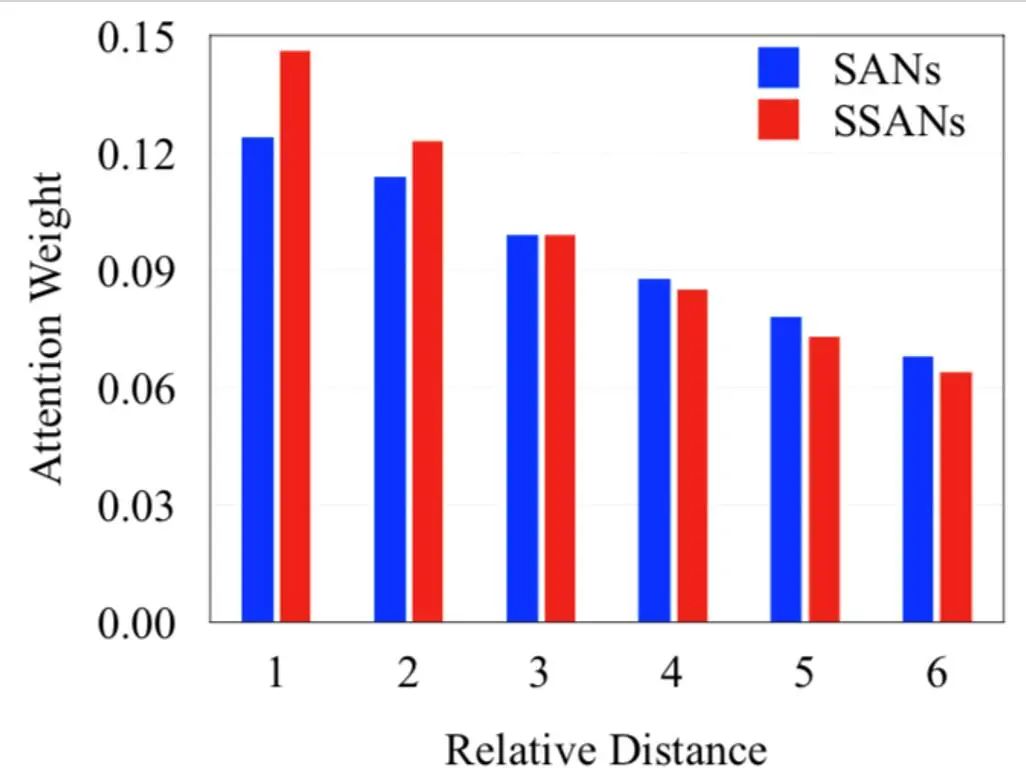

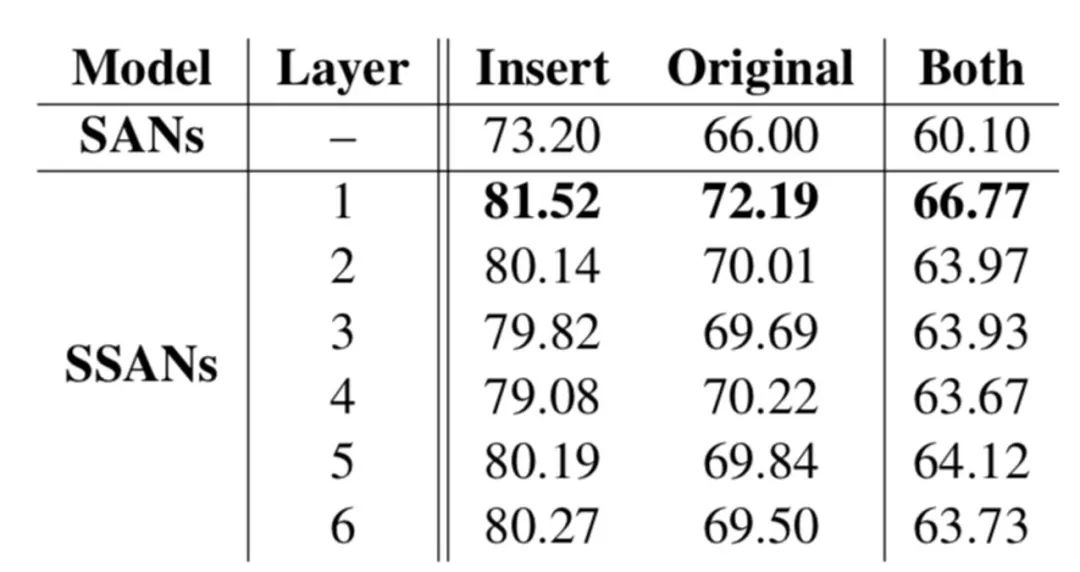

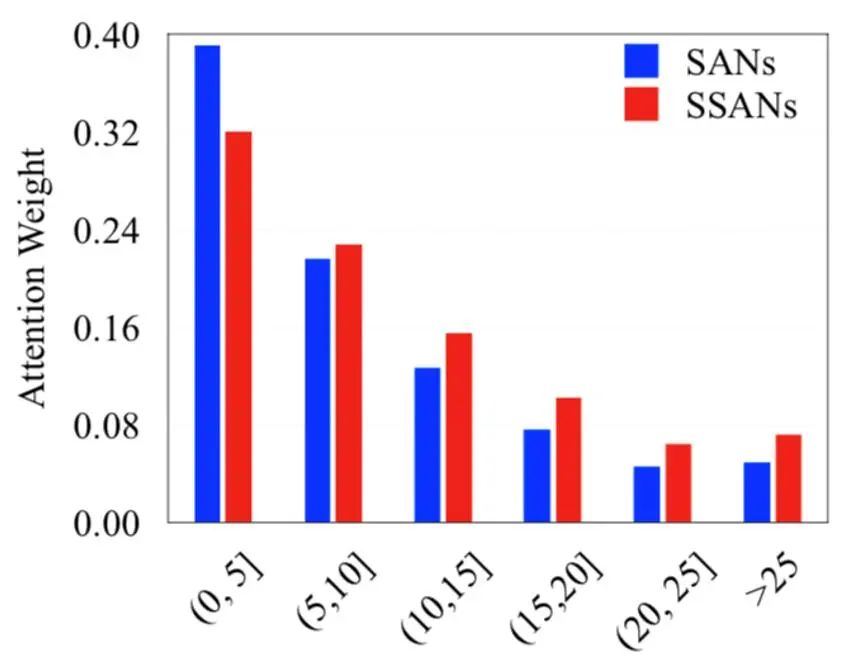

為了評價SSANs的對于局部詞序信息以及全局詞序信息編碼的能力,本文引入兩個特定的檢測任務(wù)分別評價模型對于兩種類型信息編碼的能力。其中,局部詞序信息檢測任務(wù)目標是分類是否句子中存在兩個相鄰詞的進行交換,而全局詞序信息檢測任務(wù)隨機選擇句子中的某個詞語,并將其插入到另一個位置,而任務(wù)的目標就是通過分類找到被插入的詞匯以及其原來所在的位置。實驗結(jié)果顯示,SSANs在兩個任務(wù)上,相比傳統(tǒng)的SANs,均取得較大的提升。通過分析其相應(yīng)的自注意力網(wǎng)絡(luò)權(quán)重發(fā)現(xiàn),SSANs能夠根據(jù)任務(wù)將更多的注意力權(quán)重分配到重要的信息建模上。

表2 局部信息檢測任務(wù)實驗結(jié)果

圖3 局部信息檢測任務(wù)注意力權(quán)重分布 表3 全局信息檢測任務(wù)實驗結(jié)果

圖4 全局信息檢測任務(wù)注意力權(quán)重分布

4.2 結(jié)構(gòu)信息建模能力評價

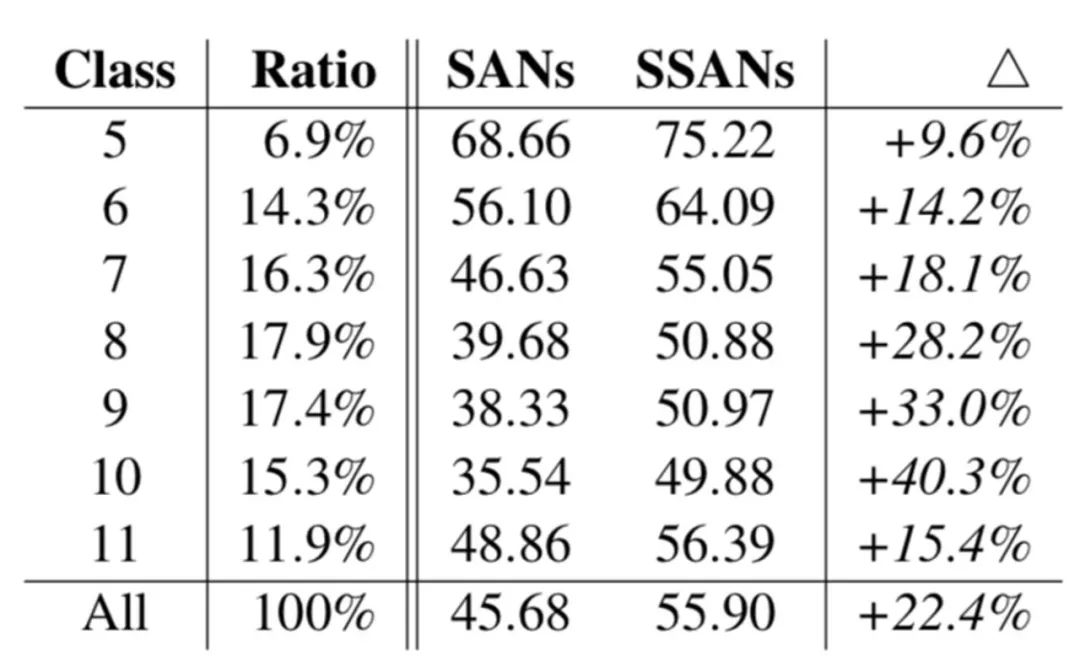

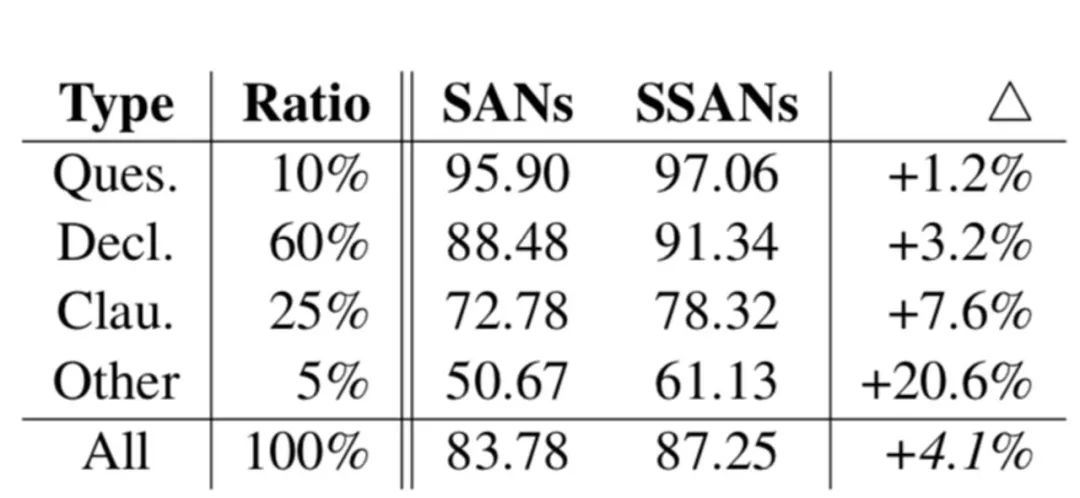

為了評價SSANs對于結(jié)構(gòu)信息的建模能力,本文首先引入兩個檢測任務(wù)評價模型對于結(jié)構(gòu)信息的捕捉能力。其中一個任務(wù)目標是測試模型是否可以根據(jù)組合語法樹的深度對于輸入的句子進行分類,而另一個任務(wù)的目標是對輸入句子按照其組合語法樹根節(jié)點之下的成分類型進行分類。實驗結(jié)果發(fā)現(xiàn),SSANs在兩種類型的任務(wù)上均取得提升,并且對于復(fù)雜的問題有更好處理能力。此外,模型根據(jù)注意力網(wǎng)絡(luò)的權(quán)重構(gòu)建組合語法樹,SSANs構(gòu)建的語法樹質(zhì)量好于SANs模型的結(jié)果。

表4 組合語法樹深度預(yù)測任務(wù)實驗結(jié)果

表5 組合語法樹成分類型預(yù)測任務(wù)實驗結(jié)果

5 結(jié)論

本文提出一種通用的基于選擇機制的自注意力網(wǎng)絡(luò)模型,其可以針對每個計算表示的元素,動態(tài)地選擇其相關(guān)性的子集,以此作為輸入進行后續(xù)的自注意力網(wǎng)絡(luò)的計算。其在多個自然語言任務(wù)上,與傳統(tǒng)的自注意力網(wǎng)絡(luò)相比,取得一致提升。通過實驗分析發(fā)現(xiàn),基于選擇機制的自注意力網(wǎng)絡(luò)可以在一定程度上緩解注意力網(wǎng)絡(luò)存在的詞序信息編碼和結(jié)構(gòu)信息建模能力不足的問題。

-

機器翻譯

+關(guān)注

關(guān)注

0文章

140瀏覽量

15123 -

網(wǎng)絡(luò)模型

+關(guān)注

關(guān)注

0文章

44瀏覽量

8692

原文標題:【工大筆記】ACL20 如何使用選擇機制提升自注意力網(wǎng)路能力?

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

DeepMind為視覺問題回答提出了一種新的硬注意力機制

深度分析NLP中的注意力機制

注意力機制的誕生、方法及幾種常見模型

基于注意力機制的深度興趣網(wǎng)絡(luò)點擊率模型

基于注意力機制的深度學習模型AT-DPCNN

基于異質(zhì)注意力的循環(huán)神經(jīng)網(wǎng)絡(luò)模型

融合雙層多頭自注意力與CNN的回歸模型

基于語音、字形和語義的層次注意力神經(jīng)網(wǎng)絡(luò)模型

基于層次注意力機制的多模態(tài)圍堵情感識別模型

基于多層CNN和注意力機制的文本摘要模型

計算機視覺中的注意力機制

基于選擇機制的自注意力網(wǎng)絡(luò)模型

基于選擇機制的自注意力網(wǎng)絡(luò)模型

評論