完善資料讓更多小伙伴認識你,還能領(lǐng)取20積分哦,立即完善>

標簽 > 智能體

智能體,顧名思義,就是具有智能的實體,英文名是Agent。以云為基礎(chǔ),以AI為核心,構(gòu)建一個立體感知、全域協(xié)同、精準判斷、持續(xù)進化、開放的智能系統(tǒng)。智能體是人工智能領(lǐng)域中一個很重要的概念。任何獨立的能夠思考并可以同環(huán)境交互的實體都可以抽象為智能體。

文章:251個 瀏覽:10937次 帖子:3個

如何讓多個智能體學會一起完成同一個任務(wù),學會彼此合作和相互競爭

多智體強化學習(Multi-agent reinforcement learning, MARL)假設(shè)有一組處在相同環(huán)境下的自主智能體。在MARL中學習...

Atari游戲史上最強通關(guān)算法來了——Go-Explore!

普通的強化學習算法通常無法從蒙特祖瑪?shù)牡谝粋€房間(得分400或更低)中跳出,在Pitfall中得分為0或更低。為了解決這類挑戰(zhàn),研究人員在智能體到達新狀...

在多智能體系統(tǒng)中,每個智能體具有獨立性和自主性,能夠解決給定的子問題,自主地推理和規(guī)劃并選擇適當?shù)牟呗裕⒁蕴囟ǖ姆绞接绊懎h(huán)境。

2019-01-10 標簽:智能體多智能體系統(tǒng) 1.5萬 0

本視頻主要詳細介紹智能體的基本特性,分別是自治性(Autonomy)、反應(yīng)性(Reactive)、主動性(Proactive)、社會性(Social)、進化性。

2019-01-12 標簽:智能體 8831 0

強化學習的經(jīng)典基礎(chǔ)性缺陷可能限制它解決很多復(fù)雜問題

這些都是除了從零學習之外的強化學習方法。特別是元學習和零次學習體現(xiàn)了人在學習一種新技能時更有可能的做法,與純強化學習有差別。一個元學習智能體會利用先驗知...

需要注意的是,這種方法只能應(yīng)用于偶爾發(fā)生的馬爾科夫決策過程。原因是在計算任意返回之前,這一episode就要停止。我們并不在每次動作結(jié)束后就更新,而是在...

DeepMind的“星際2”智能體AlphaStar實際上是演化算法?

在AlphaStar中,用于訓練智能體的基于人口的訓練策略(PBT)是使用拉馬克進化(LE)的模因算法:在內(nèi)環(huán)中,使用反向傳播連續(xù)訓練神經(jīng)網(wǎng)絡(luò),而在外環(huán)...

按照以往的做法,如果研究人員要用強化學習算法對獎勵進行剪枝,以此克服獎勵范圍各不相同的問題,他們首先會把大的獎勵設(shè)為+1,小的獎勵為-1,然后對預(yù)期獎勵...

TRFL庫包含實現(xiàn)經(jīng)典RL算法以及更前沿技術(shù)的許多函數(shù)。這里提供的損失函數(shù)和其他操作是在純TensorFlow中實現(xiàn)的。它們不是完整的算法,而是在構(gòu)建功...

多智體深度強化學習研究中首次將概率遞歸推理引入AI的學習過程

在傳統(tǒng)的多智體學習過程當中,有研究者在對其他智能體建模 (也即“對手建模”, opponent modeling) 時使用了遞歸推理,但由于算法復(fù)雜和計...

基于TensorFlow的開源強化學習框架 Dopamine

對于新的研究人員來說,能夠根據(jù)既定方法快速對其想法進行基準測試非常重要。因此,我們?yōu)?Arcade 學習環(huán)境支持的 60 個游戲提供四個智能體的完整培訓...

2018-08-31 標簽:智能體強化學習TensorFlow 5097 0

整個DeepMimic所需要的input分為三部分:一個被稱為Character的Agent模型;希望Agent學習的參考動作(reference mo...

DeepMind和OpenAI攻克蒙特祖瑪?shù)膹?fù)仇并沒有看上去意義那么重大

在這篇文章中,我想討論的是,這些方法是為了解決蒙特祖瑪?shù)膹?fù)仇游戲的第一個關(guān)卡,以及為什么在游戲環(huán)境以及Deep RL的長期目標中,這些方法并沒有看上去意...

伯克利RISELab推出了多主體強化學習包Ray RLlib 0.6.0

在緩解交通擁堵方面,只需要控制極少量自動駕駛車輛的速度,就能大幅度提高交通流的效率。多主體強化學習就可以用于這樣的場景,在混合駕駛的情況下我們暫時無法通...

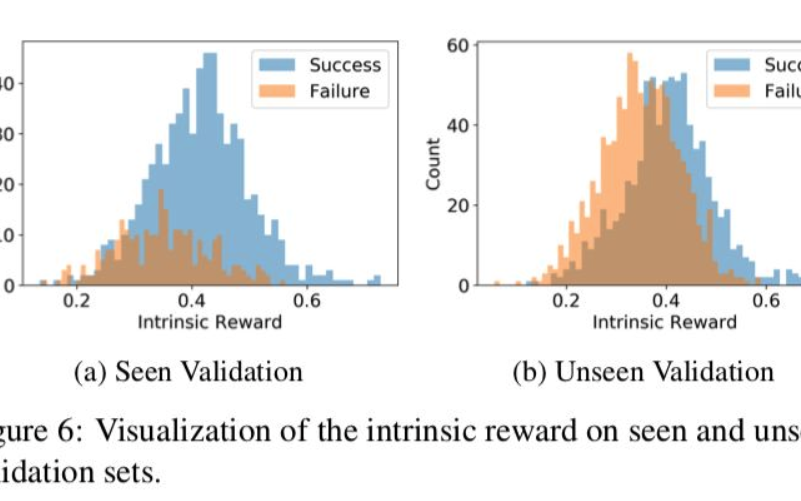

一種在視覺語言導(dǎo)航任務(wù)中提出的新方法,來探索未知環(huán)境

視覺語言導(dǎo)航(vision-language navigation, VLN)任務(wù)指的是引導(dǎo)智能體或機器人在真實三維場景中能理解自然語言命令并準確執(zhí)行。...

如何讓AI符合人類的意圖?如何創(chuàng)建符合用戶意圖的智能體?

近年來,強化學習在許多復(fù)雜游戲環(huán)境中取得了令人矚目的成績,從Atari游戲、圍棋、象棋到Dota 2和星際爭霸II,AI智能體在越來越復(fù)雜的領(lǐng)域迅速超越...

利用視頻游戲語料庫,訓練一個GAN模型為超級馬里奧兄弟生成游戲級別

在視頻游戲中,馬里奧游戲級別有不同的表征Level Corpus (VGLC) 和Mario AI 框架,這兩種都是基于tile的表征形式。具體地說,以...

一種新型的基于情景記憶的模型,能夠讓智能體用“好奇心”探索環(huán)境

當你在超市中搜索時,心里可能會想:現(xiàn)在我在肉類區(qū)域,所以接下來可能到水產(chǎn)品區(qū)。這些都應(yīng)該是相近的。如果你預(yù)測錯了,可能會驚訝:誒?怎么是蔬菜區(qū)?從而得到...

如圖所示。玩家使用左下角轉(zhuǎn)向按鈕來控制移動,而右下角則設(shè)置按鈕來控制技能。可通過主屏幕觀察周圍環(huán)境,還可以通過左上角迷你地圖了解完整的地圖情況,其中可觀...

2018-12-25 標簽:神經(jīng)網(wǎng)絡(luò)AI智能體 3897 0

強化學習作為一種常用的訓練智能體的方法,能夠完成很多復(fù)雜的任務(wù)。在強化學習中,智能體的策略是通過將獎勵函數(shù)最大化訓練的。獎勵在智能體之外,各個環(huán)境中的獎...

換一批

換一批

編輯推薦廠商產(chǎn)品技術(shù)軟件/工具OS/語言教程專題

| 電機控制 | DSP | 氮化鎵 | 功率放大器 | ChatGPT | 自動駕駛 | TI | 瑞薩電子 |

| BLDC | PLC | 碳化硅 | 二極管 | OpenAI | 元宇宙 | 安森美 | ADI |

| 無刷電機 | FOC | IGBT | 逆變器 | 文心一言 | 5G | 英飛凌 | 羅姆 |

| 直流電機 | PID | MOSFET | 傳感器 | 人工智能 | 物聯(lián)網(wǎng) | NXP | 賽靈思 |

| 步進電機 | SPWM | 充電樁 | IPM | 機器視覺 | 無人機 | 三菱電機 | ST |

| 伺服電機 | SVPWM | 光伏發(fā)電 | UPS | AR | 智能電網(wǎng) | 國民技術(shù) | Microchip |

| Arduino | BeagleBone | 樹莓派 | STM32 | MSP430 | EFM32 | ARM mbed | EDA |

| 示波器 | LPC | imx8 | PSoC | Altium Designer | Allegro | Mentor | Pads |

| OrCAD | Cadence | AutoCAD | 華秋DFM | Keil | MATLAB | MPLAB | Quartus |

| C++ | Java | Python | JavaScript | node.js | RISC-V | verilog | Tensorflow |

| Android | iOS | linux | RTOS | FreeRTOS | LiteOS | RT-THread | uCOS |

| DuerOS | Brillo | Windows11 | HarmonyOS |