谷歌最近提出一種新的強(qiáng)化學(xué)習(xí)算法:模擬策略學(xué)習(xí) (SimPLe) ,使用游戲模型來(lái)學(xué)習(xí)選擇動(dòng)作的策略,在兩款A(yù)tari游戲中獲得了最高分?jǐn)?shù),并且效率比以前的最先進(jìn)方法高出2倍以上。

深度強(qiáng)化學(xué)習(xí)(RL)技術(shù)可用于從視覺(jué)輸入中學(xué)習(xí)復(fù)雜任務(wù)的策略,并已成功地應(yīng)用于經(jīng)典的Atari 2600游戲。最近在這一領(lǐng)域的工作表明,即使在具有挑戰(zhàn)性的探索體系中,例如《蒙特祖瑪?shù)膹?fù)仇》游戲,AI也可以獲得超越人類(lèi)的表現(xiàn)。

然而,許多最先進(jìn)的方法都有的一個(gè)限制是,它們需要與游戲環(huán)境進(jìn)行大量的交互,通常比人類(lèi)學(xué)習(xí)如何玩好游戲所需要的交互要多得多。

為什么人類(lèi)能更有效地學(xué)習(xí)這些任務(wù)?一個(gè)可能的假設(shè)是,他們能夠預(yù)測(cè)自己行為的影響,從而隱式地學(xué)習(xí)了一個(gè)關(guān)于哪些動(dòng)作序列將導(dǎo)致理想結(jié)果的模型。

這種一般性的想法——構(gòu)建一個(gè)所謂的游戲模型,并使用它來(lái)學(xué)習(xí)選擇行動(dòng)的良好策略——是基于模型的強(qiáng)化學(xué)習(xí)(model-based reinforcement learning, MBRL)的主要前提。

Google的研究人員最近提出一種新的MBRL算法——模擬策略學(xué)習(xí)(Simulated Policy Learning, SimPLe),使用游戲模型來(lái)學(xué)習(xí)選擇動(dòng)作的質(zhì)量策略。

SimPLe比當(dāng)前最先進(jìn)的技術(shù)更高效,并且僅使用了~100K與游戲的交互即可顯示出有競(jìng)爭(zhēng)力的結(jié)果(相當(dāng)于一個(gè)人約2小時(shí)的實(shí)時(shí)玩游戲)。

研究人員在論文“Model-Based Reinforcement Learning for Atari”中描述了該算法,并已將代碼作為tensor2tensor開(kāi)源庫(kù)的一部分開(kāi)源。該版本包含一個(gè)預(yù)訓(xùn)練的世界模型,可以使用簡(jiǎn)單的命令行運(yùn)行,并且可以使用類(lèi)似于Atari的界面播放。

學(xué)習(xí)一個(gè)SimPLe世界模型

SimPLe背后的想法是在學(xué)習(xí)游戲行為的世界模型和在模擬游戲環(huán)境中使用該模型優(yōu)化策略(使用model-free強(qiáng)化學(xué)習(xí))之間進(jìn)行交替。該算法的基本原理已經(jīng)在Sutton的“Dyna, an integrated architecture for learning, planning, and reacting”中很好地建立起來(lái),并且已經(jīng)應(yīng)用到許多最近的基于模型的強(qiáng)化學(xué)習(xí)方法中。

SimPLe的主循環(huán)。1) agent開(kāi)始與真實(shí)環(huán)境交互。2)收集的觀測(cè)結(jié)果用于更新當(dāng)前的世界模型。3) agent通過(guò)學(xué)習(xí)世界模型更新策略。

為了訓(xùn)練一個(gè)玩Atari游戲的模型,我們首先需要在像素空間中生成合理的未來(lái)版本。換句話(huà)說(shuō),我們通過(guò)將一系列已經(jīng)觀察到的幀和給到游戲的命令(如“左”、“右”等)作為輸入,來(lái)試圖預(yù)測(cè)下一幀會(huì)是什么樣子。在觀察空間中訓(xùn)練一個(gè)世界模型的一個(gè)重要原因在于,它實(shí)際上是一種自我監(jiān)督的形式,在我們的例子中,觀察(像素)形成了一個(gè)密集且豐富的監(jiān)督信號(hào)。

如果成功地訓(xùn)練了這樣一個(gè)模型(如一個(gè)視頻預(yù)測(cè)器),則基本上有了一個(gè)游戲環(huán)境的學(xué)習(xí)模擬器(learned simulator),可用于生成用來(lái)訓(xùn)練良好策略的軌跡,即選擇一系列使智能體的長(zhǎng)期獎(jiǎng)勵(lì)最大化的動(dòng)作。

換句話(huà)說(shuō),我們不是在真實(shí)游戲的操作序列上訓(xùn)練策略,這在實(shí)踐和計(jì)算上都非常密集,而是在來(lái)自世界模型/學(xué)習(xí)模擬器的序列之上訓(xùn)練策略。

我們的世界模型是一個(gè)前饋卷積網(wǎng)絡(luò),它接收4個(gè)幀,并預(yù)測(cè)下一幀以及獎(jiǎng)勵(lì)(見(jiàn)上圖)。然而,在Atari游戲的情況下,只考慮4幀的視界的話(huà),未來(lái)是非確定性的。例如,游戲中的暫停時(shí)間就已經(jīng)超過(guò)四幀,比如在《乒乓球》(Pong)游戲中,當(dāng)球掉出框時(shí),可能會(huì)導(dǎo)致模型無(wú)法成功預(yù)測(cè)后續(xù)的幀。我們使用一種新的視頻模型架構(gòu)來(lái)處理諸如此類(lèi)的隨機(jī)性問(wèn)題,在這種情況下能做得更好。

當(dāng)SimPle模型應(yīng)用于《成龍?zhí)唣^》(Kung Fu Master)游戲時(shí),可以看到一個(gè)由隨機(jī)性引起的問(wèn)題的例子。在動(dòng)畫(huà)中,左邊是模型的輸出,中間是groundtruth,右邊是兩者之間的像素差異。在這里,模型的預(yù)測(cè)由于產(chǎn)生了不同數(shù)量的對(duì)手而偏離了真實(shí)游戲。

在每次迭代中,在訓(xùn)練好世界模型之后,我們使用這個(gè)learned simulator來(lái)生成用于使用近似策略?xún)?yōu)化(PPO)算法改進(jìn)游戲策略的rollouts(即動(dòng)作、觀察和結(jié)果的樣本序列)。

SimPLe工作的一個(gè)重要細(xì)節(jié)是,rollouts的采樣是從實(shí)際數(shù)據(jù)集幀開(kāi)始的。由于預(yù)測(cè)錯(cuò)誤通常會(huì)隨著時(shí)間的推移而增加,使長(zhǎng)期預(yù)測(cè)變得非常困難,因此SimPLe只使用中等長(zhǎng)度的rollouts。幸運(yùn)的是,PPO算法也可以從其內(nèi)部?jī)r(jià)值函數(shù)中學(xué)習(xí)動(dòng)作和獎(jiǎng)勵(lì)之間的長(zhǎng)期影響,因此有限長(zhǎng)度的rollouts對(duì)于像《Freeway》這樣獎(jiǎng)勵(lì)稀疏的游戲來(lái)說(shuō)也是足夠的。

SimPLe的效率:比其他方法高2倍以上

衡量成功的一個(gè)標(biāo)準(zhǔn)是證明該模型是高效的。為此,我們?cè)谂c環(huán)境進(jìn)行了100K次交互之后,評(píng)估了我們的策略輸出,這相當(dāng)于一個(gè)人玩了大約兩個(gè)小時(shí)的實(shí)時(shí)游戲。

我們將SimPLe方法與兩種最先進(jìn)的model-free RL方法:Rainbow和PPO,進(jìn)行了比較。在大多數(shù)情況下,SimPLe方法的采樣效率比其他方法高出兩倍以上。

和我們SimPLe方法取得的得分匹配的話(huà),兩種model-free算法所需的交互次數(shù)(左- Rainbow;右-PPO)。紅線表示我們的方法使用的交互次數(shù)。

SimPLe的成功:2款游戲獲得最高分

SimPLe方法的一個(gè)令人興奮的結(jié)果是,對(duì)于Pong和Freeway這兩款游戲,在模擬環(huán)境中訓(xùn)練的智能體能夠獲得最高分?jǐn)?shù)。下面是智能體使用為Pong游戲?qū)W習(xí)的模型玩游戲的視頻:

對(duì)于Freeway、Pong和Breakout這3款游戲,SimPLe可以生成50步以?xún)?nèi)的近乎完美的像素預(yù)測(cè),如下圖所示。

SimPLe可以在Breakout(上圖)和Freeway(下圖)生成幾乎完美的像素預(yù)測(cè)。在每個(gè)動(dòng)畫(huà)中,左邊是模型的輸出,中間是groundtruth,右邊是兩者之間的像素差異。

SimPLe的局限

SimPLe的預(yù)測(cè)并不總是正確的。最常見(jiàn)的失敗是由于世界模型沒(méi)有準(zhǔn)確地捕獲或預(yù)測(cè)小但高度相關(guān)的對(duì)象。

例如:(1)在《Atlantis》和《Battlezone》游戲中,子彈是如此之小,以至于它們往往會(huì)消失不見(jiàn);(2)《Private Eye》游戲中,agent穿越不同的場(chǎng)景,從一個(gè)場(chǎng)景傳送到另一個(gè)場(chǎng)景。我們發(fā)現(xiàn),我們的模型通常很難捕捉到如此巨大的全局變化。

在《Battlezone》中,我們發(fā)現(xiàn)模型很難預(yù)測(cè)小但高度相關(guān)的部分,比如子彈。

結(jié)論

model-based的強(qiáng)化學(xué)習(xí)方法的主要前景是在交互要么成本高昂、速度緩慢,要么需要人工標(biāo)記的環(huán)境中,比如許多機(jī)器人任務(wù)。在這樣的環(huán)境中,一個(gè)learned simulator能夠更好地理解智能體的環(huán)境,并能夠?yàn)閳?zhí)行多任務(wù)強(qiáng)化學(xué)習(xí)提供新的、更好、更快的方法。

雖然SimPLe還沒(méi)有達(dá)到標(biāo)準(zhǔn)的model-free RL方法的性能,但它的效率要高很多。我們期望未來(lái)的工作能夠進(jìn)一步提高model-based的技術(shù)的性能。

-

谷歌

+關(guān)注

關(guān)注

27文章

6231瀏覽量

108138 -

算法

+關(guān)注

關(guān)注

23文章

4710瀏覽量

95390 -

強(qiáng)化學(xué)習(xí)

+關(guān)注

關(guān)注

4文章

269瀏覽量

11601

原文標(biāo)題:谷歌提出強(qiáng)化學(xué)習(xí)新算法SimPLe,模擬策略學(xué)習(xí)效率提高2倍

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

NVIDIA Isaac Lab可用環(huán)境與強(qiáng)化學(xué)習(xí)腳本使用指南

18個(gè)常用的強(qiáng)化學(xué)習(xí)算法整理:從基礎(chǔ)方法到高級(jí)模型的理論技術(shù)與代碼實(shí)現(xiàn)

永磁同步電機(jī)二階迭代學(xué)習(xí)控制

詳解RAD端到端強(qiáng)化學(xué)習(xí)后訓(xùn)練范式

淺談適用規(guī)模充電站的深度學(xué)習(xí)有序充電策略

華為云 Flexus X 實(shí)例部署安裝 Jupyter Notebook,學(xué)習(xí) AI,機(jī)器學(xué)習(xí)算法

螞蟻集團(tuán)收購(gòu)邊塞科技,吳翼出任強(qiáng)化學(xué)習(xí)實(shí)驗(yàn)室首席科學(xué)家

NPU與機(jī)器學(xué)習(xí)算法的關(guān)系

NPU在深度學(xué)習(xí)中的應(yīng)用

一種基于深度學(xué)習(xí)的二維拉曼光譜算法

如何使用 PyTorch 進(jìn)行強(qiáng)化學(xué)習(xí)

AI大模型與深度學(xué)習(xí)的關(guān)系

【「大模型時(shí)代的基礎(chǔ)架構(gòu)」閱讀體驗(yàn)】+ 第一、二章學(xué)習(xí)感受

谷歌AlphaChip強(qiáng)化學(xué)習(xí)工具發(fā)布,聯(lián)發(fā)科天璣芯片率先采用

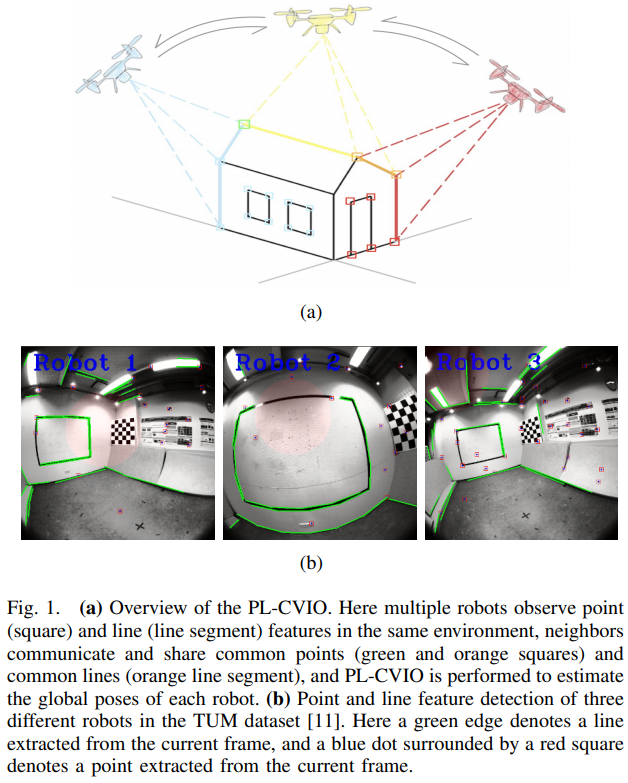

一種完全分布式的點(diǎn)線協(xié)同視覺(jué)慣性導(dǎo)航系統(tǒng)

谷歌最近提出一種新的強(qiáng)化學(xué)習(xí)算法:模擬策略學(xué)習(xí) (SimPLe)

谷歌最近提出一種新的強(qiáng)化學(xué)習(xí)算法:模擬策略學(xué)習(xí) (SimPLe)

評(píng)論