神經(jīng)網(wǎng)絡(luò)(Graph NN)是近來(lái)的一大研究熱點(diǎn),尤其是DeepMind提出的“Graph Networks”,號(hào)稱有望讓深度學(xué)習(xí)實(shí)現(xiàn)因果推理。但這篇論文晦澀難懂,復(fù)星集團(tuán)首席AI科學(xué)家、大數(shù)醫(yī)達(dá)創(chuàng)始人鄧侃博士,在清華俞士綸教授團(tuán)隊(duì)對(duì)GNN綜述清晰分類的基礎(chǔ)上,解析DeepMind“圖網(wǎng)絡(luò)”的意義。

- 1 -

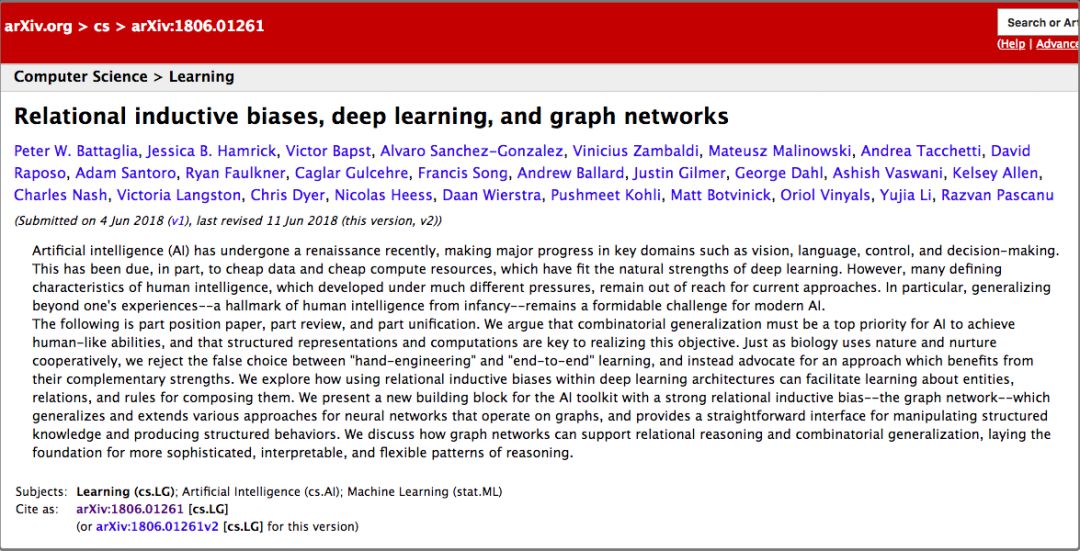

回顧2018年機(jī)器學(xué)習(xí)的進(jìn)展,2018年6月DeepMind團(tuán)隊(duì)發(fā)表的論文“Relational inductive biases, deep learning, and graph networks”,是一篇重要的論文,引起業(yè)界熱議。

隨后,很多學(xué)者沿著他們的思路,繼續(xù)研究,其中包括清華大學(xué)孫茂松團(tuán)隊(duì)。他們于2018年12月,發(fā)表了一篇綜述,題目是“Graph neural networks: A review of methods and applications”。

2019年1月,俞士綸教授團(tuán)隊(duì),也寫了一篇綜述,這篇綜述的覆蓋面更全面,題目是“A Comprehensive Survey on Graph Neural Networks”。

俞士綸教授團(tuán)隊(duì)綜述GNN,來(lái)源:arxiv

DeepMind團(tuán)隊(duì)的這篇論文,引起業(yè)界這么熱烈的關(guān)注,或許有三個(gè)原因:

聲望:自從AlphaGo戰(zhàn)勝李世乭以后,DeepMind享譽(yù)業(yè)界,成為機(jī)器學(xué)習(xí)業(yè)界的領(lǐng)軍團(tuán)隊(duì),DeepMind團(tuán)隊(duì)發(fā)表的論文,受到同行普遍關(guān)注;

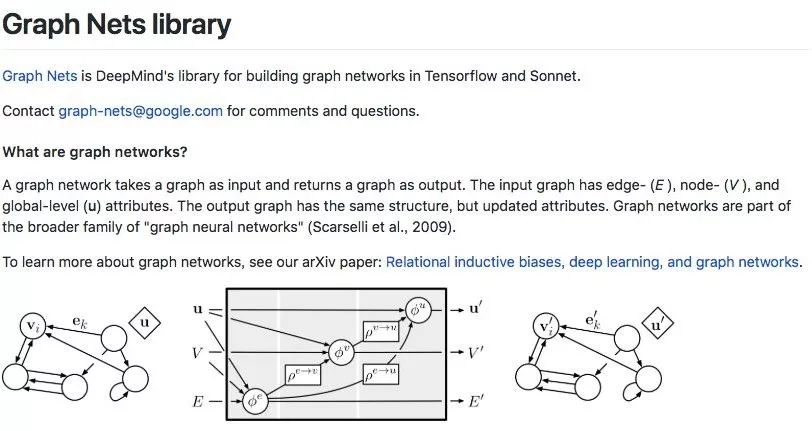

開源:DeepMind團(tuán)隊(duì)發(fā)表論文[1]以后不久,就在Github上開源了他們開發(fā)的軟件系統(tǒng),項(xiàng)目名稱叫Graph Nets[4];

主題:聲望和開源,都很重要,但是并不是被業(yè)界熱議的最主要的原因。最主要的原因是主題,DeepMind團(tuán)隊(duì)研究的主題是,如何用深度學(xué)習(xí)方法處理圖譜。

- 2 -

圖譜(Graph)由點(diǎn)(Node)和邊(Edge)組成。

圖譜是一個(gè)重要的數(shù)學(xué)模型,可以用來(lái)解決很多問(wèn)題。

譬如我們把城市地鐵線路圖當(dāng)成圖譜,每個(gè)地鐵站就是一個(gè)點(diǎn),相鄰的地鐵站之間的連線就是邊,輸入起點(diǎn)到終點(diǎn),我們可以通過(guò)圖譜的計(jì)算,計(jì)算出從起點(diǎn)到終點(diǎn),時(shí)間最短、換乘次數(shù)最少的行程路線。

又譬如Google和百度的搜索引擎,搜索引擎把世界上每個(gè)網(wǎng)站的每個(gè)網(wǎng)頁(yè),都當(dāng)成圖譜中的一個(gè)點(diǎn)。每個(gè)網(wǎng)頁(yè)里,經(jīng)常會(huì)有鏈接,引用其它網(wǎng)站的網(wǎng)頁(yè),每個(gè)鏈接都是圖譜中的一條邊。哪個(gè)網(wǎng)頁(yè)被引用得越多,就說(shuō)明這個(gè)網(wǎng)頁(yè)越靠譜,于是,在搜索結(jié)果的排名也就越靠前。

圖譜的操作,仍然有許多問(wèn)題有待解決。

譬如輸入幾億條滴滴司機(jī)行進(jìn)的路線,每條行進(jìn)路線是按時(shí)間排列的一連串(時(shí)間、GPS經(jīng)緯度)數(shù)組。如何把幾億條行進(jìn)路線,疊加在一起,構(gòu)建城市地圖?

不妨把地圖也當(dāng)成一個(gè)圖譜,每個(gè)交叉路口,都是一個(gè)點(diǎn),連接相鄰的兩個(gè)交叉路口,是一條邊。

貌似很簡(jiǎn)單,但是細(xì)節(jié)很麻煩。

舉個(gè)例子,交叉路口有很多形式,不僅有十字路口,還有五角場(chǎng)、六道口,還有環(huán)形道立交橋——如何從多條路徑中,確定交叉路口的中心位置?

日本大阪天保山立交橋,你能確定這座立交橋的中心位置嗎?

- 3 -

把深度學(xué)習(xí),用來(lái)處理圖譜,能夠擴(kuò)大我們對(duì)圖譜的處理能力。

深度學(xué)習(xí)在圖像和文本的處理方面,已經(jīng)取得了巨大的成功。如何擴(kuò)大深度學(xué)習(xí)的成果,使之應(yīng)用于圖譜處理?

圖像由橫平豎直的像素矩陣組成。如果換一個(gè)角度,把每個(gè)像素視為圖譜中的一個(gè)點(diǎn),每個(gè)像素點(diǎn)與它周邊的8個(gè)相鄰像素之間都有邊,而且每條邊都等長(zhǎng)。通過(guò)這個(gè)視角,重新審視圖像,圖像是廣義圖譜的一個(gè)特例。

處理圖像的諸多深度學(xué)習(xí)手段,都可以改頭換面,應(yīng)用于廣義的圖譜,譬如convolution、residual、dropout、pooling、attention、encoder-decoder等等。這就是深度學(xué)習(xí)圖譜處理的最初想法,很樸實(shí)很簡(jiǎn)單。

雖然最初想法很簡(jiǎn)單,但是深入到細(xì)節(jié),各種挑戰(zhàn)層出不窮。每種挑戰(zhàn),都意味著更強(qiáng)大的技術(shù)能力,都孕育著更有潛力的應(yīng)用場(chǎng)景。

深度學(xué)習(xí)圖譜處理這個(gè)研究方向,業(yè)界沒(méi)有統(tǒng)一的稱謂。

強(qiáng)調(diào)圖譜的數(shù)學(xué)屬性的團(tuán)隊(duì),把這個(gè)研究方向命名為Geometric Deep Learning。孫茂松團(tuán)隊(duì)和俞士綸團(tuán)隊(duì),強(qiáng)調(diào)神經(jīng)網(wǎng)絡(luò)在圖譜處理中的重要性,強(qiáng)調(diào)思想來(lái)源,他們把這個(gè)方向命名為Graph Neural Networks。DeepMind團(tuán)隊(duì)卻反對(duì)綁定特定技術(shù)手段,他們使用更抽象的名稱,Graph Networks。

命名不那么重要,但是用哪種方法去梳理這個(gè)領(lǐng)域的諸多進(jìn)展,卻很重要。把各個(gè)學(xué)派的目標(biāo)定位和技術(shù)方法,梳理清楚,有利于加強(qiáng)同行之間的相互理解,有利于促進(jìn)同行之間的未來(lái)合作。

- 4-

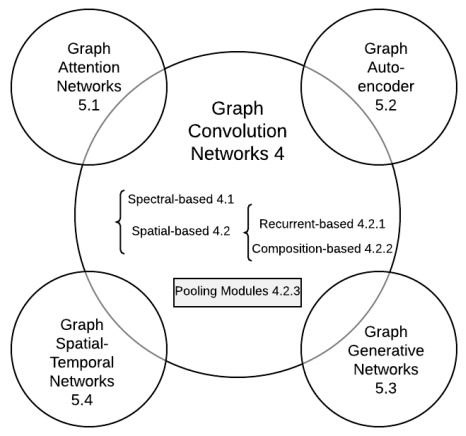

俞士綸團(tuán)隊(duì)把深度學(xué)習(xí)圖譜處理的諸多進(jìn)展,梳理成5個(gè)子方向,非常清晰好懂。

俞士綸團(tuán)隊(duì)把深度學(xué)習(xí)圖譜處理梳理成5個(gè)子方向,來(lái)源:論文 A Comprehensive Survey on Graph Neural Networks

Graph Convolution Networks

Graph Attention Networks

Graph Embedding

Graph Generative Networks

Graph Spatial-temporal Networks

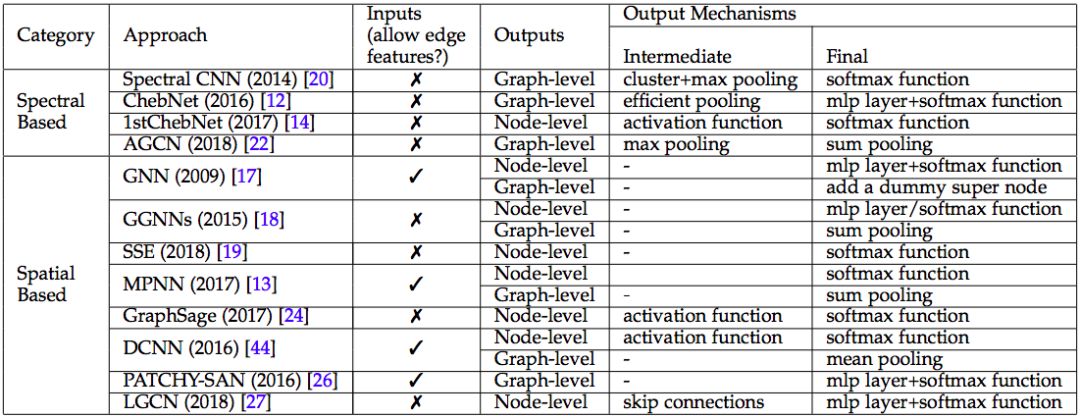

先說(shuō)Graph Convolution Networks (GCNs)。

GCN 類別匯總,來(lái)源:論文 A Comprehensive Survey on Graph Neural Networks

GCN把CNN諸般武器,應(yīng)用于廣義圖譜。CNN主要分為四個(gè)任務(wù),

點(diǎn)與點(diǎn)之間的融合。在圖像領(lǐng)域,點(diǎn)與點(diǎn)之間的融合主要通過(guò)卷積技術(shù)(convolution)來(lái)實(shí)現(xiàn)。在廣義圖譜里,點(diǎn)與點(diǎn)之間的關(guān)系,用邊來(lái)表達(dá)。所以,在廣義圖譜里,點(diǎn)點(diǎn)融合,有比卷積更強(qiáng)大的辦法。Messsage passing [5]就是一種更強(qiáng)大的辦法。

分層抽象。CNN使用convolution的辦法,從原始像素矩陣中,逐層提煉出更精煉更抽象的特征。更高層的點(diǎn),不再是孤立的點(diǎn),而是融合了相鄰區(qū)域中其它點(diǎn)的屬性。融合鄰點(diǎn)的辦法,也可以應(yīng)用于廣義圖譜中。

特征提煉。CNN使用pooling等手段,從相鄰原始像素中,提煉邊緣。從相鄰邊緣中,提煉實(shí)體輪廓。從相鄰實(shí)體中,提煉更高層更抽象的實(shí)體。CNN通常把convolution和pooling交替使用,構(gòu)建結(jié)構(gòu)更復(fù)雜,功能更強(qiáng)大的神經(jīng)網(wǎng)絡(luò)。對(duì)于廣義圖譜,也可以融匯Messsage passing和Pooling,構(gòu)建多層圖譜。

輸出層。CNN通常使用softmax等手段,對(duì)整張圖像進(jìn)行分類,識(shí)別圖譜的語(yǔ)義內(nèi)涵。對(duì)于廣義圖譜來(lái)說(shuō),輸出的結(jié)果更多樣,不僅可以對(duì)于整個(gè)圖譜,輸出分類等等結(jié)果。而且也可以預(yù)測(cè)圖譜中某個(gè)特定的點(diǎn)的值,也可以預(yù)測(cè)某條邊的值。

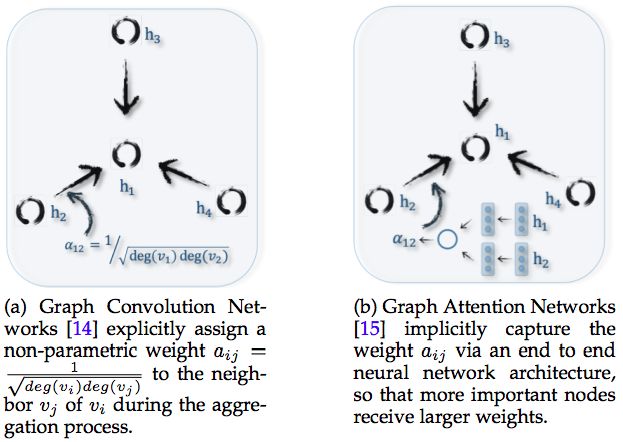

GCN 和Graph Attention Networks 的區(qū)別來(lái)源:論文 A Comprehensive Survey on Graph Neural Networks

Graph Attention Networks要解決的問(wèn)題,與 GCN類似,區(qū)別在于點(diǎn)點(diǎn)融合、多層抽象的方法。

Graph Convolution Networks使用卷積方式,實(shí)現(xiàn)點(diǎn)點(diǎn)融合和分層抽象。Convolution卷積方式僅僅適用于融合相鄰的點(diǎn),而attention聚焦方式卻不限于相鄰的點(diǎn),每個(gè)點(diǎn)可以融合整個(gè)圖譜中所有其它點(diǎn),不管是否相鄰,是否融合如何融合,取決于點(diǎn)與點(diǎn)之間的關(guān)聯(lián)強(qiáng)弱。

Attention能力更強(qiáng)大,但是對(duì)于算力的要求更高,因?yàn)樾枰?jì)算整個(gè)圖譜中任意兩個(gè)點(diǎn)之間的關(guān)聯(lián)強(qiáng)弱。所以Graph Attention Networks研究的重點(diǎn),是如何降低計(jì)算成本,或者通過(guò)并行計(jì)算,提高計(jì)算效率。

- 5-

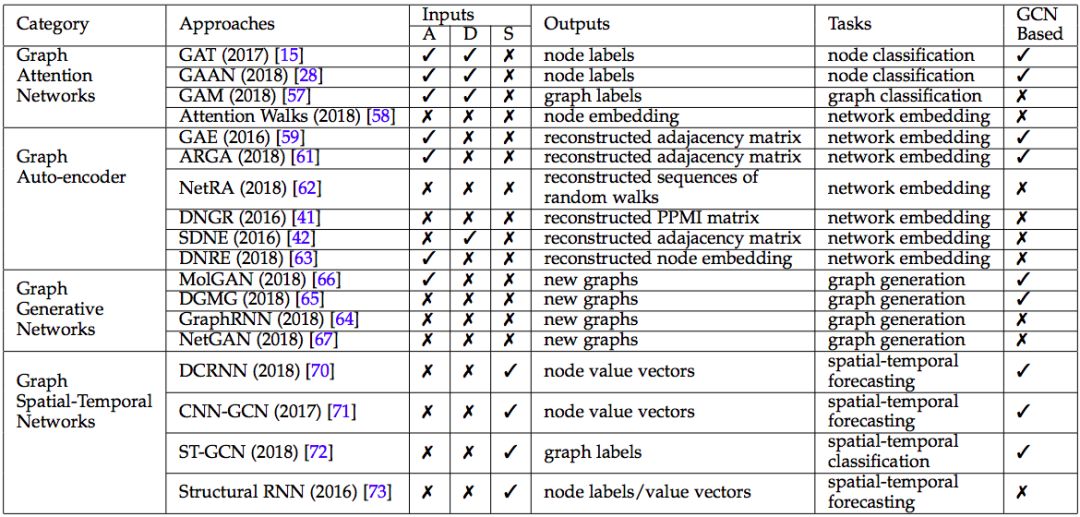

Graph Embedding要解決的問(wèn)題,是給圖譜中每個(gè)點(diǎn)每條邊,賦予一個(gè)數(shù)值張量。圖像不存在這個(gè)問(wèn)題,因?yàn)橄袼靥焐菙?shù)值張量。但是,文本由文字詞匯語(yǔ)句段落構(gòu)成,需要把文字詞匯,轉(zhuǎn)化成數(shù)值張量,才能使用深度學(xué)習(xí)的諸多算法。

如果把文本中的每個(gè)文字或詞匯,當(dāng)成圖譜中的一個(gè)點(diǎn),同時(shí)把詞與詞之間的語(yǔ)法語(yǔ)義關(guān)系,當(dāng)成圖譜中的一條邊,那么語(yǔ)句和段落,就等同于行走在文本圖譜中的一條行進(jìn)路徑。

如果能夠給每個(gè)文字和詞匯,都賦予一個(gè)貼切的數(shù)值張量,那么語(yǔ)句和段落對(duì)應(yīng)的行進(jìn)路徑,多半是最短路徑。

有多種實(shí)現(xiàn)Graph Embedding的辦法,其中效果比較好的辦法是Autoencoder。用GCN的辦法,把圖譜的點(diǎn)和邊轉(zhuǎn)換成數(shù)值張量,這個(gè)過(guò)程稱為編碼(encoding),然后通過(guò)計(jì)算點(diǎn)與點(diǎn)之間的距離,把數(shù)值張量集合,反轉(zhuǎn)為圖譜,這個(gè)過(guò)程稱為解碼(decoding)。通過(guò)不斷地調(diào)參,讓解碼得到的圖譜,越來(lái)越趨近于原始圖譜,這個(gè)過(guò)程稱為訓(xùn)練。

Graph Embedding給圖譜中的每個(gè)點(diǎn)每條邊,賦予貼切的數(shù)值張量,但是它不解決圖譜的結(jié)構(gòu)問(wèn)題。

如果輸入大量的圖譜行進(jìn)路徑,如何從這些行進(jìn)路徑中,識(shí)別哪些點(diǎn)與哪些點(diǎn)之間有連邊?難度更大的問(wèn)題是,如果沒(méi)有行進(jìn)路徑,輸入的訓(xùn)練數(shù)據(jù)是圖譜的局部,以及與之對(duì)應(yīng)的圖譜的特性,如何把局部拼接成圖譜全貌?這些問(wèn)題是Graph Generative Networks要解決的問(wèn)題。

Graph Generative Networks比較有潛力的實(shí)現(xiàn)方法,是使用Generative Adversarial Networks (GAN)。

GAN由生成器(generator)和辨別器(discriminator)兩部分構(gòu)成:1.從訓(xùn)練數(shù)據(jù)中,譬如海量行進(jìn)路徑,生成器猜測(cè)數(shù)據(jù)背后的圖譜應(yīng)該長(zhǎng)什么樣;2.用生成出來(lái)的圖譜,偽造一批行進(jìn)路徑;3.從大量偽造的路徑和真實(shí)的路徑中,挑選幾條路徑,讓辨別器識(shí)別哪幾條路徑是偽造的。

如果辨別器傻傻分不清誰(shuí)是偽造路徑,誰(shuí)是真實(shí)路徑,說(shuō)明生成器生成出的圖譜,很接近于真實(shí)圖譜。

GCN 以外的其他 4 種圖譜神經(jīng)網(wǎng)絡(luò),來(lái)源:論文 A Comprehensive Survey on Graph Neural Networks

- 6-

以上我們討論了針對(duì)靜態(tài)圖譜的若干問(wèn)題,但是圖譜有時(shí)候是動(dòng)態(tài)的,譬如地圖中表現(xiàn)的道路是靜態(tài)的,但是路況是動(dòng)態(tài)的。

如何預(yù)測(cè)春節(jié)期間,北京天安門附近的交通擁堵情況?解決這個(gè)問(wèn)題,不僅要考慮空間spatial的因素,譬如天安門周邊的道路結(jié)構(gòu),也要考慮時(shí)間temporal的因素,譬如往年春節(jié)期間該地區(qū)交通擁堵情況。這就是Graph Spatial-temporal Networks要解決的問(wèn)題之一。

Graph Spatial-temporal Networks還能解決其它問(wèn)題,譬如輸入一段踢球的視頻,如何在每一幀圖像中,識(shí)別足球的位置?這個(gè)問(wèn)題的難點(diǎn)在于,在視頻的某些幀中,足球有可能是看不見的,譬如被球員的腿遮擋了。

解決時(shí)間序列問(wèn)題的通常思路,是RNN,包括LSTM和GRU等等。

DeepMind團(tuán)隊(duì)在RNN基礎(chǔ)上,又添加了編碼和解碼(encoder-decoder)機(jī)制。

- 7 -

在DeepMind團(tuán)隊(duì)的這篇論文里[1],他們聲稱自己的工作,“part position paper, part review, and part unification”,既是提案,又是綜述,又是融合。這話怎么理解?

DeepMind聯(lián)合谷歌大腦、MIT等機(jī)構(gòu)27位作者發(fā)表重磅論文,提出“圖網(wǎng)絡(luò)”(Graph network),將端到端學(xué)習(xí)與歸納推理相結(jié)合,有望解決深度學(xué)習(xí)無(wú)法進(jìn)行關(guān)系推理的問(wèn)題。

前文說(shuō)到,俞士綸團(tuán)隊(duì)把深度學(xué)習(xí)圖譜處理的諸多進(jìn)展,梳理成5個(gè)子方向:1) Graph Convolution Networks、2) Graph Attention Networks、3) Graph Embedding、4) Graph Generative Networks、5) Graph Spatial-temporal Networks。

DeepMind團(tuán)隊(duì)在5個(gè)子方向中著力解決后4個(gè)方向,分別是Graph Attention Networks、Graph Embedding、Graph Generative Networks和Graph Spatial-temporal Networks。他們把這四個(gè)方向的成果,“融合”成統(tǒng)一的框架,命名為Graph Networks。

在他們的論文中,對(duì)這個(gè)四個(gè)子方向沿途的諸多成果,做了“綜述”,但是并沒(méi)有綜述Graph Convolution Networks方向的成果。然后他們從這四個(gè)子方向的諸多成果中,挑選出了他們認(rèn)為最有潛力的方法,形成自己的“提案”,這就是他們開源的代碼[4]。

DeepMind在2018年10月開源的Graph Nets library,用于在TensorFlow中構(gòu)建簡(jiǎn)單而強(qiáng)大的關(guān)系推理網(wǎng)絡(luò)。來(lái)源:github.com/deepmind/graph_nets

雖然論文中,他們聲稱他們的提案解決了四個(gè)子方向的問(wèn)題,但是查看他們開源的代碼,發(fā)現(xiàn)其實(shí)他們著力解決的是后兩個(gè)子方向,Graph Attention Networks和Graph Spatial-temporal Networks。

DeepMind的思路是這樣的:首先,把[5]的message passing點(diǎn)點(diǎn)融合的機(jī)制,與[6]圖譜全局的聚焦機(jī)制相結(jié)合,構(gòu)建通用的graph block模塊;其次,把LSTM要素融進(jìn)encoder-decoder框架,構(gòu)建時(shí)間序列機(jī)制;最后,把graph block模塊融進(jìn)encoder-decoder框架,形成Graph Spatial-temporal Networks通用系統(tǒng)。

- 8-

為什么DeepMind的成果很重要?事關(guān)四件大事。

一、深度學(xué)習(xí)過(guò)程的解釋

從原理上講,深度學(xué)習(xí)譬如CNN的成果,來(lái)自于對(duì)圖像的不斷抽象。也就是,從原始的像素矩陣中,抽象出線段。從首尾相連的相鄰線段中,抽象出實(shí)體的輪廓。從輪廓抽象出實(shí)體,從實(shí)體抽象出語(yǔ)義。

但是,如果窺探CNN每一層的中間結(jié)果,實(shí)際上很難明確,究竟是哪一層的哪些節(jié)點(diǎn),抽象出了輪廓,也不知道哪一層的哪些節(jié)點(diǎn),抽象出了實(shí)體。總而言之,CNN的網(wǎng)絡(luò)結(jié)構(gòu)是個(gè)迷,無(wú)法明確地解釋網(wǎng)絡(luò)結(jié)構(gòu)隱藏的工作過(guò)程的細(xì)節(jié)。

無(wú)法解釋工作過(guò)程的細(xì)節(jié),也就談不上人為干預(yù)。如果CNN出了問(wèn)題,只好重新訓(xùn)練。但重新訓(xùn)練后的結(jié)果,是否能達(dá)到期待的效果,無(wú)法事先語(yǔ)料。往往按下葫蘆浮起瓢,解決了這個(gè)缺陷,卻引發(fā)了其它缺陷。

反過(guò)來(lái)說(shuō),如果能明確地搞清楚CNN工作過(guò)程的細(xì)節(jié),就可以有針對(duì)性地調(diào)整個(gè)別層次的個(gè)別節(jié)點(diǎn)的參數(shù),事先人為精準(zhǔn)干預(yù)。

二、小樣本學(xué)習(xí)

深度學(xué)習(xí)依賴訓(xùn)練數(shù)據(jù),訓(xùn)練數(shù)據(jù)的規(guī)模通常很大,少則幾萬(wàn),多大幾百萬(wàn)。從哪里收集這么多訓(xùn)練數(shù)據(jù),需要組織多少人力去對(duì)訓(xùn)練數(shù)據(jù)進(jìn)行標(biāo)注,都是巨大挑戰(zhàn)。

如果對(duì)深度學(xué)習(xí)的過(guò)程細(xì)節(jié),有更清晰的了解,我們就可以改善卷積這種蠻力的做法,用更少的訓(xùn)練數(shù)據(jù),訓(xùn)練更輕巧的深度學(xué)習(xí)模型。

卷積的過(guò)程,是蠻力的過(guò)程,它對(duì)相鄰的點(diǎn),無(wú)一遺漏地不分青紅皂白地進(jìn)行卷積處理。

如果我們對(duì)點(diǎn)與點(diǎn)之間的關(guān)聯(lián)關(guān)系,有更明確的了解,就不需要對(duì)相鄰的點(diǎn),無(wú)一遺漏地不分青紅皂白地進(jìn)行卷積處理。只需要對(duì)有關(guān)聯(lián)的點(diǎn),進(jìn)行卷積或者其它處理。

根據(jù)點(diǎn)與點(diǎn)之間的關(guān)聯(lián)關(guān)系,構(gòu)建出來(lái)的網(wǎng)絡(luò),就是廣義圖譜。廣義圖譜的結(jié)構(gòu),通常比CNN網(wǎng)絡(luò)更加簡(jiǎn)單,所以,需要的訓(xùn)練數(shù)據(jù)量也更少。

三、遷移學(xué)習(xí)和推理

用當(dāng)今的CNN,可以從大量圖片中,識(shí)別某種實(shí)體,譬如貓。

但是,如果想給識(shí)別貓的CNN擴(kuò)大能力,讓它不僅能識(shí)別貓,還能識(shí)別狗,就需要額外的識(shí)別狗的訓(xùn)練數(shù)據(jù)。這是遷移學(xué)習(xí)的過(guò)程。

能不能不提供額外的識(shí)別狗的訓(xùn)練數(shù)據(jù),而只是用規(guī)則這樣的方式,告訴電腦貓與狗的區(qū)別,然后讓電腦識(shí)別狗?這是推理的目標(biāo)。

如果對(duì)深度學(xué)習(xí)過(guò)程有更精準(zhǔn)的了解,就能把知識(shí)和規(guī)則,融進(jìn)深度學(xué)習(xí)。

從廣義范圍說(shuō),深度學(xué)習(xí)和知識(shí)圖譜,是機(jī)器學(xué)習(xí)陣營(yíng)中諸多學(xué)派的兩大主流學(xué)派。迄今為止,這兩大學(xué)派隔岸叫陣,各有勝負(fù)。如何融合兩大學(xué)派,取長(zhǎng)補(bǔ)短,是困擾學(xué)界很久的難題。把深度學(xué)習(xí)延伸到圖譜處理,給兩大學(xué)派的融合,帶來(lái)了希望。

四、空間和時(shí)間的融合,像素與語(yǔ)義的融合

視頻處理,可以說(shuō)是深度學(xué)習(xí)的最高境界。

視頻處理融合了圖像的空間分割,圖像中實(shí)體的識(shí)別,實(shí)體對(duì)應(yīng)的語(yǔ)義理解。

多幀靜態(tài)圖像串連在一起形成視頻,實(shí)際上是時(shí)間序列。同一個(gè)實(shí)體,在不同幀中所處的位置,蘊(yùn)含著實(shí)體的運(yùn)動(dòng)。運(yùn)動(dòng)的背后,是物理定律和語(yǔ)義關(guān)聯(lián)。

如何從一段視頻,總結(jié)出文本標(biāo)題。或者反過(guò)來(lái),如何根據(jù)一句文本標(biāo)題,找到最貼切的視頻。這是視頻處理的經(jīng)典任務(wù),也是難度超大的任務(wù)。

-

AI

+關(guān)注

關(guān)注

88文章

35093瀏覽量

279490 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5561瀏覽量

122783

原文標(biāo)題:為什么說(shuō)圖網(wǎng)絡(luò)是 AI 的未來(lái)?

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

中軟國(guó)際在能源化工行業(yè)大模型項(xiàng)目取得重大突破

艾為芯強(qiáng)力加持!雷鳥V3 AI拍攝眼鏡,AI 交互、音質(zhì)實(shí)現(xiàn)重大突破

全球首次!民營(yíng)企業(yè)核聚變裝置實(shí)驗(yàn)取得重大突破

中軟國(guó)際在大型銀行AI項(xiàng)目領(lǐng)域?qū)崿F(xiàn)重大突破

車載SerDes重大突破,業(yè)內(nèi)首款雙協(xié)議芯片誕生!

昊衡科技OFDR設(shè)備重大突破:傳感長(zhǎng)度躍升至500米,開啟長(zhǎng)距離精準(zhǔn)監(jiān)測(cè)新時(shí)代

Figure AI宣布終止與OpenAI合作,稱已在AI方面取得重大突破

重大突破!優(yōu)刻得×腦虎科技腦機(jī)接口臨床試驗(yàn)取得新進(jìn)展

面向圖譜的深度學(xué)習(xí)會(huì)迎來(lái)重大突破嗎

面向圖譜的深度學(xué)習(xí)會(huì)迎來(lái)重大突破嗎

評(píng)論