傳統(tǒng)的記憶架構(gòu)做關(guān)系推理時有困難,DeepMind和倫敦大學(xué)學(xué)院的這篇論文提出關(guān)系推理模塊RMC,能夠在序列信息中執(zhí)行關(guān)系推理,在WikiText-103, Project Gutenberg 和 GigaWord 數(shù)據(jù)集上達到了當(dāng)前最佳性能。

基于記憶的神經(jīng)網(wǎng)絡(luò)通過利用長時間記憶信息的能力來建模時序數(shù)據(jù)。然而,目前還不清楚它們是否有能力利用它們記得的信息進行復(fù)雜的關(guān)系推理。

在這篇論文中,DeepMind和倫敦大學(xué)學(xué)院的研究人員首先證實一種直覺想法,即標(biāo)準(zhǔn)的記憶架構(gòu)在一些涉及關(guān)系推理的任務(wù)上很困難。然后,研究者通過使用一個新的記憶模塊——Relational Memory Core(RMC)——來改進這種缺陷,該模塊采用multi-head dot product attention來允許記憶交互。

最后,研究者在一系列任務(wù)上測試RMC,這些任務(wù)可以從跨序列信息的更強大的關(guān)系推理中獲益,并且在RL領(lǐng)域(例如Mini PacMan)、程序評估和語言建模中顯示出巨大的受益,在WikiText-103、Project Gutenberg和GigaWord數(shù)據(jù)集上獲得state-of-the-art的結(jié)果。

關(guān)系記憶核心RMC

人類使用復(fù)雜的記憶系統(tǒng)來訪問和推理重要的信息,不管這些信息最初是什么時候被感知到的。在神經(jīng)網(wǎng)絡(luò)研究中,許多成功的序列數(shù)據(jù)建模方法也使用了記憶系統(tǒng)(memory systems),例如LSTM和記憶增強的神經(jīng)網(wǎng)絡(luò)(memory-augmented neural networks)。通過增強記憶容量、隨時間的有限計算成本以及處理梯度消失的能力,這些網(wǎng)絡(luò)學(xué)會了跨時間關(guān)聯(lián)事件,以便熟練地存儲和檢索信息。

在這里,我們建議在考慮存儲和檢索的同時考慮記憶交互,這是卓有成效的。雖然目前的模型可以學(xué)習(xí)劃分和關(guān)聯(lián)分布式的、矢量化的記憶,但它們并不明顯地傾向于這樣做。我們假設(shè),這樣的偏見可以讓一個模型更好地理解記憶是如何關(guān)聯(lián)的,因此可以讓它更好地進行關(guān)系推理。

首先,我們通過開發(fā)一個演示任務(wù)來強調(diào)順序信息的關(guān)系推理,證明當(dāng)前的模型在這個領(lǐng)域中存在困難。使用新的關(guān)系記憶核心( Relational Memory Core,RMC),利用multi-head dot product attention讓記憶彼此交互,我們解決并分析了這個問題。然后,我們將RMC應(yīng)用到一系列任務(wù)中,這些任務(wù)可能會從更顯式的memory-memory 交互中獲益,因此,可能會增加隨時間推移的的關(guān)系推理能力:在Wikitext-103、Project Gutenberg和GigaWord數(shù)據(jù)集中,部分觀察到的強化學(xué)習(xí)任務(wù)、程序評估和語言建模。

關(guān)系推理(Relational reasoning)

我們認為關(guān)系推理是理解實體連接的方式的過程,并利用這種理解來實現(xiàn)更高階的目標(biāo)。例如,考慮對各種樹與公園長椅之間的距離進行排序:將實體(樹和長椅)之間的關(guān)系(距離)進行比較,以得到解決方案;如果我們單獨考慮每個實體的屬性(位置),則無法得到解決方案。

由于我們通常可以很流暢地定義什么構(gòu)成“實體”(entity)或“關(guān)系”(relation),因此我們可以想象一系列的神經(jīng)網(wǎng)絡(luò)誘導(dǎo)的偏見,可以用關(guān)系推理的語言表達出來。例如,可以用卷積核來計算一個感受野內(nèi)的實體(像素)的關(guān)系(線性組合)。

在時域(temporal domain)中,關(guān)系推理可以包含在不同時間點比較和對比信息的能力。這里,注意力機制隱式地執(zhí)行某種形式的關(guān)系推理;如果先前的隱藏狀態(tài)被解釋為entity,那么使用注意力來計算實體的加權(quán)和有助于消除RNN中存在的局部性偏差。

由于我們當(dāng)前的架構(gòu)解決復(fù)雜的時序任務(wù),因此它們必須具備一些時間關(guān)系推理的能力。然而,目前還不清楚他們的歸納偏差是否受到限制,以及這些限制是否可以暴露在要求特定類型的時間關(guān)系推理的任務(wù)中。

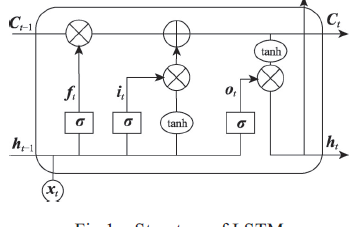

模型

我們的指導(dǎo)設(shè)計原則是提供一個架構(gòu)的主干,在這個基礎(chǔ)上,模型可以學(xué)習(xí)如何劃分信息,以及如何計算劃分的信息之間的交互。為了實現(xiàn)這一點,我們從LSTM、 memory-augmented神經(jīng)網(wǎng)絡(luò)和non-local網(wǎng)絡(luò)(特別是Transformer seq2seq模型)組裝構(gòu)建塊。與記憶增強架構(gòu)相似,我們考慮一組固定的memory slots;但是,我們允許使用注意里機制在memory slots之間進行交互。與之前的工作相反,我們在單個時間步上在記憶之間應(yīng)用注意力,而不是跨過在先前的觀察中計算出來的所有先前的表征。

圖1:Relational Memory Core

圖2:任務(wù)

我們在一組監(jiān)督學(xué)習(xí)和強化學(xué)習(xí)任務(wù)中測試RMC。值得注意的是N?? Farthest的任務(wù)和語言建模。在前者中,解決方案需要顯式的關(guān)系推理,因為模型必須對向量之間的距離關(guān)系進行排序,而不是對向量本身排序。后者在大量自然數(shù)據(jù)上測試模型,并允許我們將性能與經(jīng)過良好調(diào)優(yōu)的模型進行比較。

實驗

這里簡要介紹應(yīng)用RMC的實驗任務(wù),具體每個任務(wù)的詳細信息以及模型的超參數(shù)設(shè)置等請閱讀原論文。

說明性監(jiān)督任務(wù)

N?? Farthest

第N個最遠的任務(wù)是為了強調(diào)跨時間的關(guān)系推理能力。輸入是隨機抽樣的向量序列,目標(biāo)是對形式問題的回答:“距離向量m的第n個最遠的向量是什么?”,其中向量的值、它們的ID、n和m都是每個序列隨機抽樣的。我們強調(diào)模型必須對向量之間的距離關(guān)系進行排序,而不是對向量本身。

程序評估

Learning to Execute(LTE)數(shù)據(jù)集由圖靈完整的偽代碼編程語言中的算法片段組成,可分為三類:添加、控制和完整程序。輸入是表示這些代碼片段的字母數(shù)字詞匯表上的字符序列,目標(biāo)是一個數(shù)字字符序列,它是給定編程輸入的執(zhí)行輸出。考慮到這些片斷涉及變量的符號操作,我們認為它可能會影響模型的關(guān)系推理能力;由于符號運算符可以被解釋為在操作數(shù)上定義一個關(guān)系,成功的學(xué)習(xí)可以反映對這個關(guān)系的理解。為了評估經(jīng)典序列任務(wù)的模型性能,我們還對記憶任務(wù)進行了評估,在這些任務(wù)中,輸出只是輸入的一種排列形式,而不是來自一組操作指令的評估。

強化學(xué)習(xí)

Mini Pacman with viewport

我們遵循文獻[23]中的Mini Pacman的表述。簡而言之, agent在被ghosts追趕時在迷宮中導(dǎo)航以收集食物。我們用一個視圖(viewport)來實現(xiàn)這個任務(wù):圍繞agent的5×5窗口,包含感知輸入。因此,任務(wù)是部分可觀察的。agent必須預(yù)測記憶中g(shù)hosts的動態(tài),并據(jù)此計劃導(dǎo)航,同時也要根據(jù)被拾取的食物的記憶信息。 該任務(wù)要求在記憶空間中進行關(guān)系推理。

語言建模

最后,我們調(diào)查了基于詞匯的語言建模任務(wù)。

結(jié)果

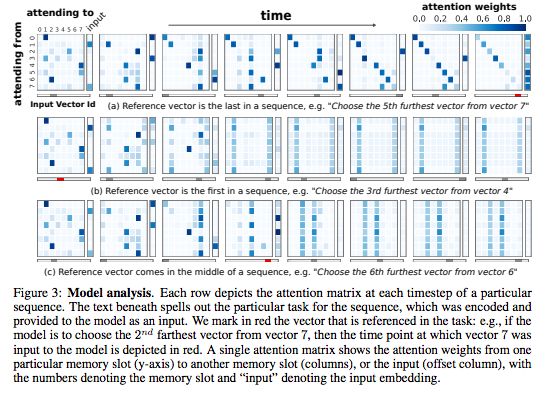

圖3:模型分析

每行描述了特定序列的每個時間步的注意力矩陣。下面的文本闡明了序列的特定任務(wù),該序列被編碼并作為輸入提供給模型。我們用紅色標(biāo)記任務(wù)中引用的矢量。

表1:測試程序評估和記憶任務(wù)的每個字符的準(zhǔn)確性。

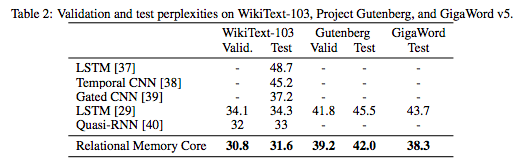

表2:WikiText-103、Project Gutenberg和GigaWord v5數(shù)據(jù)集上的驗證和測試?yán)Щ蠖?/p>

總的來說,我們的結(jié)果顯示,記憶交互的顯式建模還提高強化學(xué)習(xí)任務(wù),以及程序評估、比較推理和語言建模的性能,這表明在遞歸神經(jīng)網(wǎng)絡(luò)中加入關(guān)系推理能力的價值。

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4814瀏覽量

103635 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1224瀏覽量

25449 -

強化學(xué)習(xí)

+關(guān)注

關(guān)注

4文章

269瀏覽量

11604

原文標(biāo)題:DeepMind提出關(guān)系RNN:構(gòu)建關(guān)系推理模塊,強化學(xué)習(xí)利器

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

神經(jīng)網(wǎng)絡(luò)教程(李亞非)

AI知識科普 | 從無人相信到萬人追捧的神經(jīng)網(wǎng)絡(luò)

非局部神經(jīng)網(wǎng)絡(luò),打造未來神經(jīng)網(wǎng)絡(luò)基本組件

與記憶神經(jīng)網(wǎng)絡(luò)的聯(lián)想記憶的實驗演示_英文版

基于記憶神經(jīng)網(wǎng)絡(luò)研究

一種改進的前饋序列記憶神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)

長短時記憶神經(jīng)網(wǎng)絡(luò)的算法

基于雙向長短期記憶神經(jīng)網(wǎng)絡(luò)的交互注意力模型

基于記憶的神經(jīng)網(wǎng)絡(luò)通過利用長時間記憶信息的能力來建模時序數(shù)據(jù)

基于記憶的神經(jīng)網(wǎng)絡(luò)通過利用長時間記憶信息的能力來建模時序數(shù)據(jù)

評論