循環(huán)神經(jīng)網(wǎng)絡(luò)(Recurrent Neural Network,簡(jiǎn)稱RNN)是一種具有短期記憶功能的神經(jīng)網(wǎng)絡(luò),它能夠處理序列數(shù)據(jù),如時(shí)間序列、文本序列等。與傳統(tǒng)的前饋神經(jīng)網(wǎng)絡(luò)不同,RNN的網(wǎng)絡(luò)結(jié)構(gòu)具有循環(huán),能夠?qū)⑶耙粋€(gè)時(shí)間步的信息傳遞到下一個(gè)時(shí)間步,從而實(shí)現(xiàn)對(duì)序列數(shù)據(jù)的建模。本文將介紹循環(huán)神經(jīng)網(wǎng)絡(luò)的基本原理。

- RNN的基本結(jié)構(gòu)

1.1 神經(jīng)元模型

RNN的基本單元是神經(jīng)元,每個(gè)神經(jīng)元接收輸入信號(hào),通過(guò)激活函數(shù)處理后輸出信號(hào)。神經(jīng)元的數(shù)學(xué)模型可以表示為:

y_t = f(W * x_t + U * h_(t-1) + b)

其中,y_t表示第t個(gè)時(shí)間步的輸出,x_t表示第t個(gè)時(shí)間步的輸入,h_(t-1)表示第t-1個(gè)時(shí)間步的隱狀態(tài),W、U、b分別表示神經(jīng)元的權(quán)重矩陣、隱狀態(tài)權(quán)重矩陣和偏置向量,f表示激活函數(shù)。

1.2 循環(huán)結(jié)構(gòu)

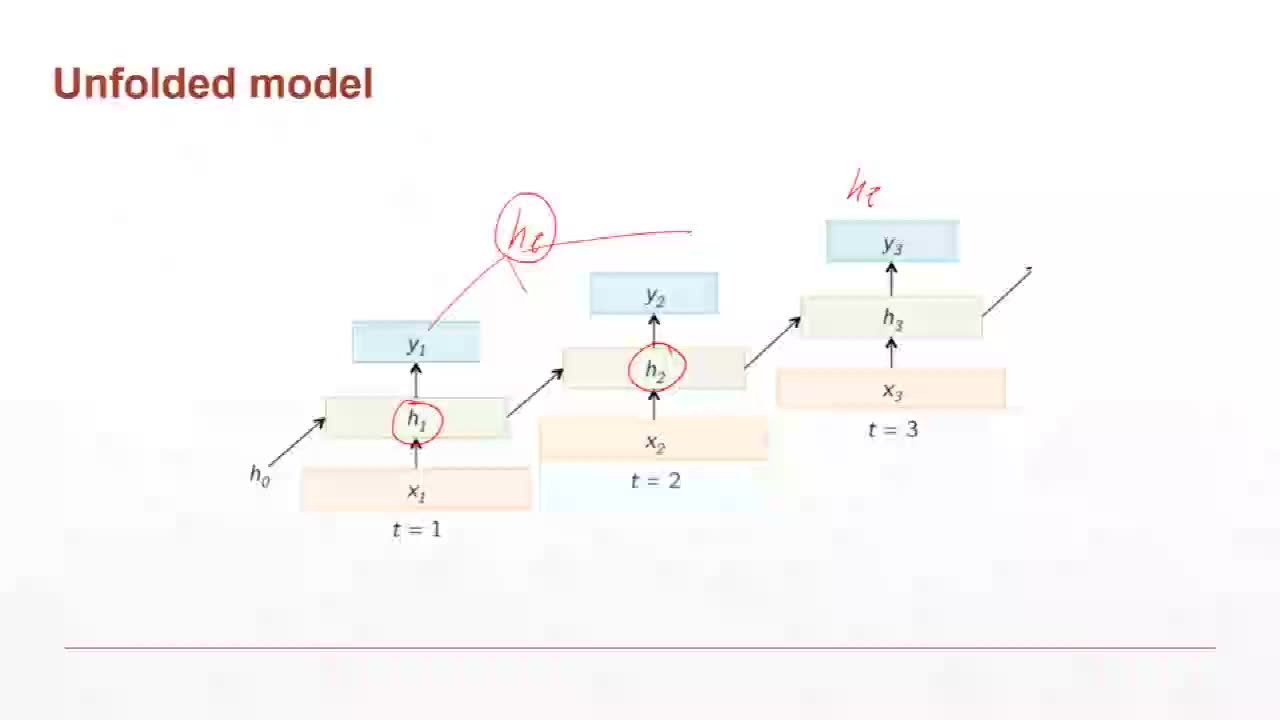

RNN的特點(diǎn)是具有循環(huán)結(jié)構(gòu),即神經(jīng)元的輸出不僅受到當(dāng)前輸入的影響,還受到前一個(gè)時(shí)間步的隱狀態(tài)的影響。這種循環(huán)結(jié)構(gòu)使得RNN能夠捕捉序列數(shù)據(jù)中的動(dòng)態(tài)特征。RNN的循環(huán)結(jié)構(gòu)可以用以下公式表示:

h_t = g(W_h * h_(t-1) + W_x * x_t + b_h)

其中,h_t表示第t個(gè)時(shí)間步的隱狀態(tài),W_h、W_x、b_h分別表示隱狀態(tài)權(quán)重矩陣、輸入權(quán)重矩陣和偏置向量,g表示激活函數(shù)。

1.3 激活函數(shù)

激活函數(shù)是神經(jīng)元中非線性變換的關(guān)鍵部分,它能夠?qū)⒕€性變換后的信號(hào)進(jìn)行非線性映射,從而增加網(wǎng)絡(luò)的表達(dá)能力。常用的激活函數(shù)有Sigmoid、Tanh、ReLU等。Sigmoid函數(shù)的數(shù)學(xué)表達(dá)式為:

f(x) = 1 / (1 + exp(-x))

Tanh函數(shù)的數(shù)學(xué)表達(dá)式為:

f(x) = (exp(x) - exp(-x)) / (exp(x) + exp(-x))

ReLU函數(shù)的數(shù)學(xué)表達(dá)式為:

f(x) = max(0, x)

1.4 損失函數(shù)

RNN的損失函數(shù)通常采用均方誤差(Mean Squared Error,MSE)或者交叉熵(Cross Entropy,CE)等。對(duì)于回歸問(wèn)題,通常使用MSE作為損失函數(shù);對(duì)于分類問(wèn)題,通常使用CE作為損失函數(shù)。

- RNN的訓(xùn)練過(guò)程

2.1 前向傳播

在RNN的訓(xùn)練過(guò)程中,首先進(jìn)行前向傳播。前向傳播的過(guò)程是將輸入序列逐個(gè)時(shí)間步送入網(wǎng)絡(luò),計(jì)算每個(gè)時(shí)間步的隱狀態(tài)和輸出。具體步驟如下:

- 初始化隱狀態(tài)h_0為零向量或隨機(jī)向量。

- 對(duì)于輸入序列中的每個(gè)時(shí)間步x_t,計(jì)算當(dāng)前時(shí)間步的隱狀態(tài)h_t和輸出y_t。

- 將h_t作為下一個(gè)時(shí)間步的輸入。

2.2 反向傳播

在前向傳播完成后,接下來(lái)進(jìn)行反向傳播。反向傳播的目的是計(jì)算損失函數(shù)關(guān)于網(wǎng)絡(luò)參數(shù)的梯度,從而更新網(wǎng)絡(luò)參數(shù)。具體步驟如下:

- 計(jì)算損失函數(shù)L關(guān)于輸出y_t的梯度?L/?y_t。

- 利用鏈?zhǔn)椒▌t,從后向前依次計(jì)算損失函數(shù)關(guān)于隱狀態(tài)h_t、權(quán)重W、偏置b的梯度。

- 更新網(wǎng)絡(luò)參數(shù):W = W - α * ?L/?W,b = b - α * ?L/?b,其中α表示學(xué)習(xí)率。

2.3 梯度消失和梯度爆炸問(wèn)題

在RNN的訓(xùn)練過(guò)程中,由于梯度在時(shí)間維度上不斷乘以權(quán)重矩陣,很容易出現(xiàn)梯度消失或梯度爆炸的問(wèn)題。梯度消失會(huì)導(dǎo)致網(wǎng)絡(luò)無(wú)法學(xué)習(xí)到長(zhǎng)期依賴關(guān)系,而梯度爆炸會(huì)導(dǎo)致訓(xùn)練過(guò)程不穩(wěn)定。為了解決這些問(wèn)題,可以采用一些優(yōu)化方法,如梯度裁剪、門控循環(huán)單元(Gated Recurrent Unit,GRU)和長(zhǎng)短時(shí)記憶網(wǎng)絡(luò)(Long Short-Term Memory,LSTM)等。

-

數(shù)據(jù)

+關(guān)注

關(guān)注

8文章

7241瀏覽量

91013 -

神經(jīng)元

+關(guān)注

關(guān)注

1文章

368瀏覽量

18754 -

輸入信號(hào)

+關(guān)注

關(guān)注

0文章

471瀏覽量

12834 -

循環(huán)神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

0文章

38瀏覽量

3088

發(fā)布評(píng)論請(qǐng)先 登錄

#硬聲創(chuàng)作季 2. 課時(shí)2 循環(huán)神經(jīng)網(wǎng)絡(luò)基本原理-1

循環(huán)神經(jīng)網(wǎng)絡(luò)的基本原理是什么

循環(huán)神經(jīng)網(wǎng)絡(luò)的基本原理是什么

評(píng)論