1. Yolo11簡介

YOLO11 系列是 YOLO 家族中最先進的 (SOTA)、最輕量級、最高效的模型,其表現優于其前輩。它由 Ultralytics 創建,該組織發布了 YOLOv8,這是迄今為止最穩定、使用最廣泛的 YOLO 變體。YOLO11 將延續 YOLO 系列的傳奇。

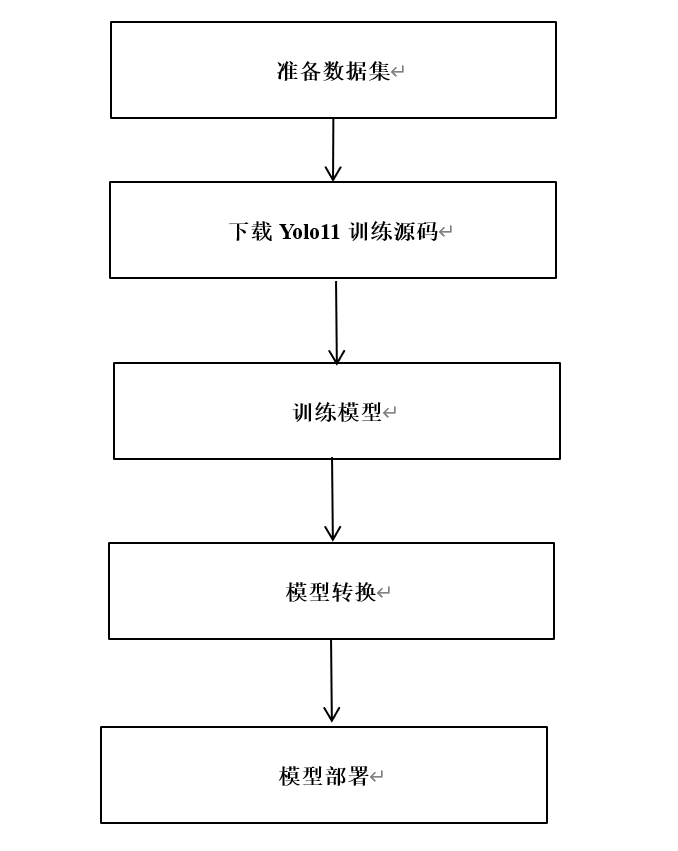

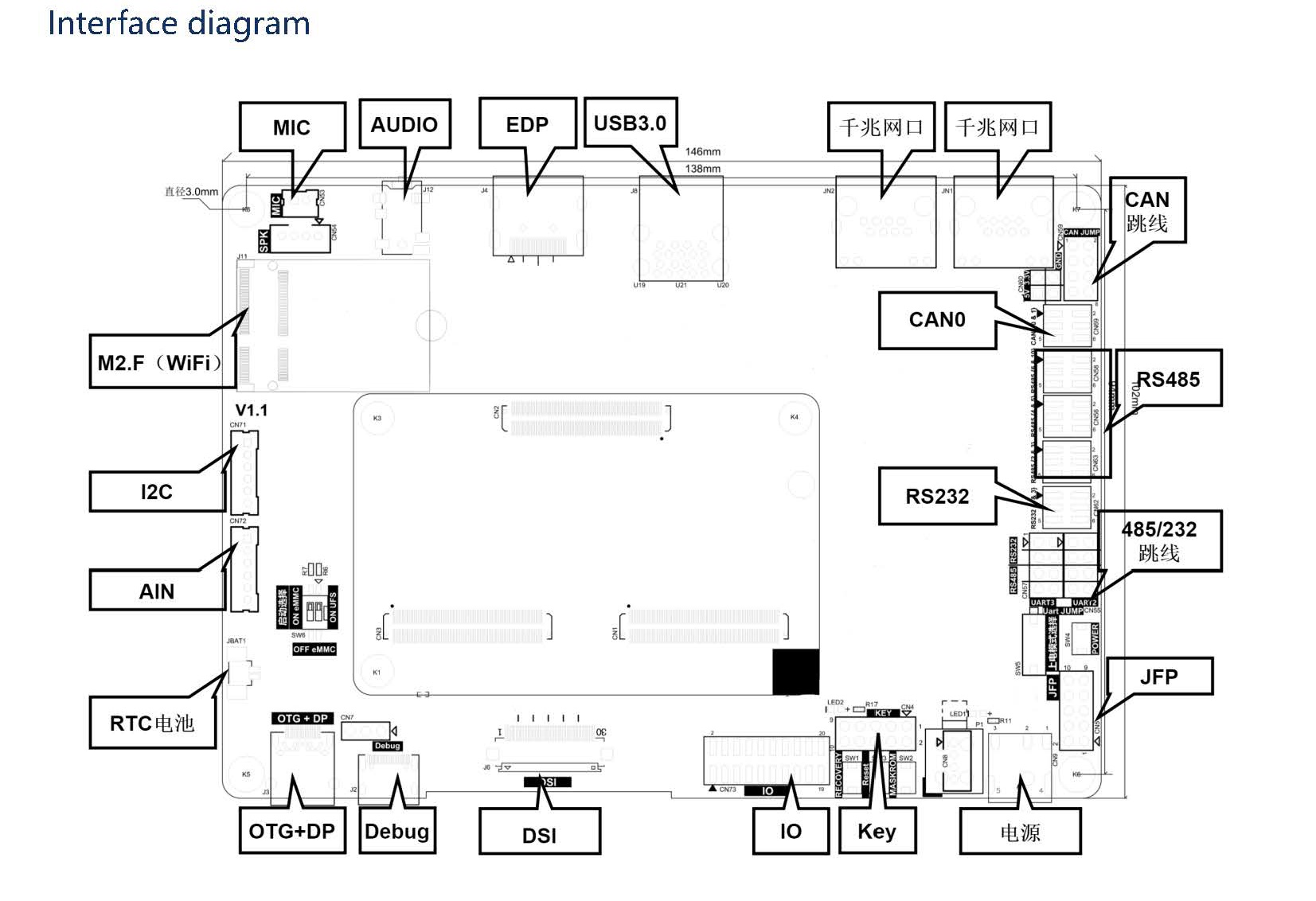

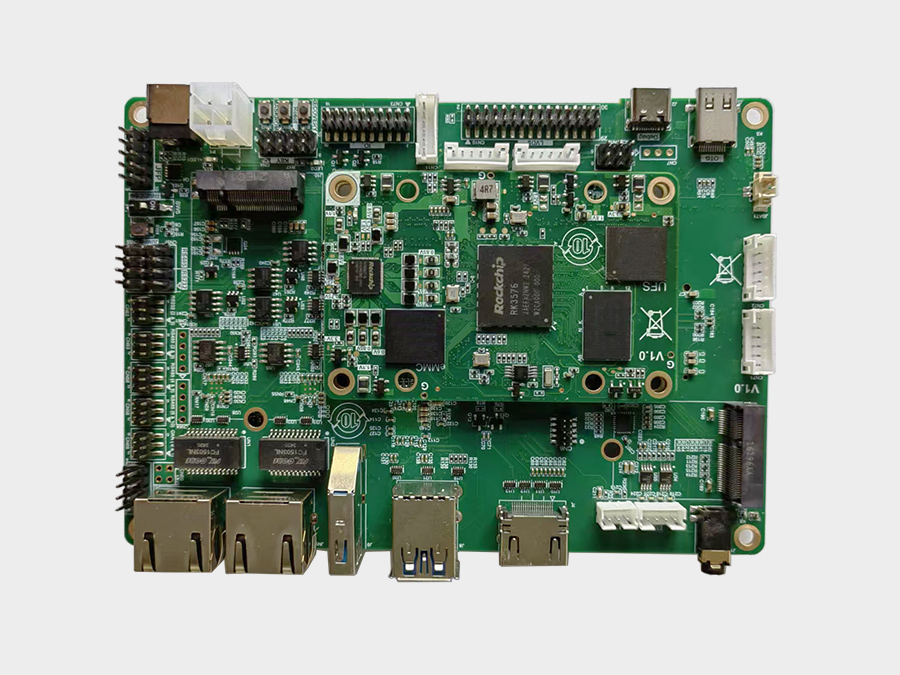

本教程針對目標檢測算法yolo11的訓練和部署到EASY-EAI-Orin-nano(RK3576)進行說明,而數據標注方法可以參考我們往期的文章。

2. Yolo11模型訓練

Yolov11訓練代碼在導出部分對比原版會有一些修改,建議下載我們的訓練代碼。

2.1 數據集準備

在開始yolo11訓練前,先準備好待訓練數據,如VOC2007,下載鏈接:

http://host.robots.ox.ac.uk/pascal/VOC/voc2007/index.html

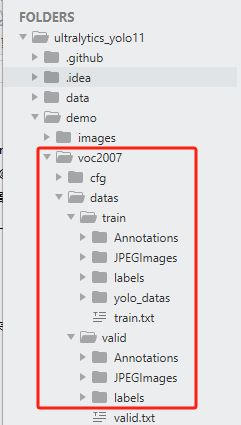

然后將VOC2007數據分成訓練集和測試集兩個目錄,如下圖示意:

2.2 Voc轉Yolo

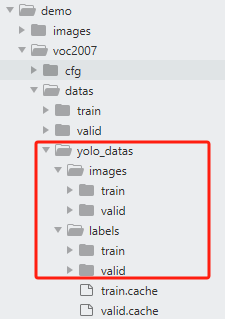

數據準備好后,使用data/voc_2_yolo.py腳本將Voc數據格式轉成Yolo數據格式。轉換完成后的數據存儲在原數據同級目錄的yolo_data下,如下圖示意:

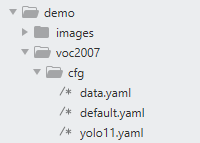

2.3 訓練參數配置

數據轉換完成后,在配置模型的訓練參數:data.yaml,default.yaml,yolo11.yaml.

其中:

data.yaml:為待訓練數據和驗證數據的路徑,以及類別數和類別名稱;

default.yaml:為yolo11訓練參數,可自行調整模型訓練的參數;

Yolo11.yaml:為yolo11模型結構,在模型訓練時,你需要修改類別數。

更多關于yolo11信息可參考:

https://blog.csdn.net/qq_45972324/article/details/143892222

2.4 模型訓練

完成上述步驟后,就可以開始訓練模型了,打開train.py腳本,輸入data.yaml,default.yaml,yolo11.yaml路徑,如下代碼段所示:

fromultralyticsimportYOLO importos os.environ["KMP_DUPLICATE_LIB_OK"] ="TRUE"# 程序報OMP: Hint This means...錯誤時使用 if__name__ =='__main__': cfg ="./demo/voc2007/cfg/default.yaml" data ='./demo/voc2007/cfg/data.yaml' weight ="./demo/voc2007/cfg/yolo11.yaml"# pt 或 yolovx.yaml model = YOLO(weight) results = model.train( data=data, cfg=cfg )

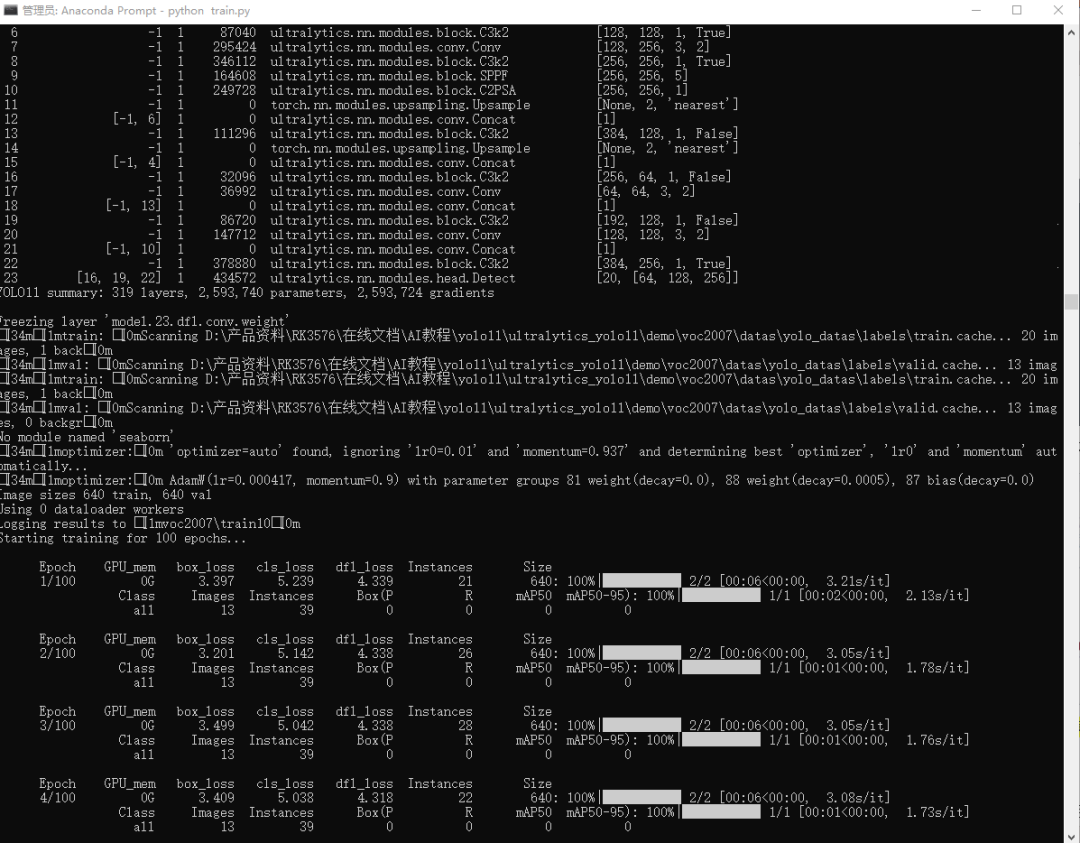

執行train.py訓練腳本,開始模型訓練,如下示意圖:

pythontrain.py

注意:訓練過程僅是為了演示流程,接下來模型預測和模型轉換的都是yolov11默認的80類的模型。

2.5 PC端預測模型預測

訓練完畢后,在default.yaml文件配置的project目錄下保存訓練過程,經驗證集測試的最好結果的模型。同時可以執行模型預測,初步評估模型的效果。打開predict.py腳本,配置好模型地址和待檢測圖片,如下代碼段所示:

if__name__ =='__main__': random.seed(0) device_ ="cpu" imgsz = (640,640) model_path ="./demo/weights/yolo11s.pt" img_path ="./demo/images/bus.jpg" is_dir = os.path.isdir(img_path) device = select_device(device_) model = YOLO(model_path) # 圖片預處理 ifis_dir: filenames = os.listdir(img_path) foridx, fileinenumerate(filenames): img_file = os.path.join(img_path, file) im = cv2.imread(img_file) # uint8 numpy array pre_img, ratio, padding = preprocess(im, device, imgsz) # 模型預測 # pred = model.predict(pre_img, augment=False)[0] # im = draw_result(im, pred, ratio, padding) pred = model.predict(im, augment=False)[0] im = draw_result(im, pred) cv2.imshow("dst", im) cv2.waitKey() else: im = cv2.imread(img_path) # uint8 numpy array pre_img, ratio, padding = preprocess(im, device, imgsz) # 模型預測 # pred = model.predict(pre_img, augment=False)[0] # im = draw_result(im, pred, ratio, padding) pred = model.predict(im, augment=False)[0] im = draw_result(im, pred) cv2.imshow("dst", im) cv2.waitKey()

執行腳本:

pythonpredict.py

運行腳本結果:

2.6 PT模型轉ONNX

在PC端執行export.py將pt模型轉成onnx,如下代碼段所示:

from ultralytics import YOLO if__name__ =='__main__': format ='rknn'#'torchscript','onnx','openvino','engine','coreml','saved_model','pb','tflite','edgetpu','tfjs','paddle','ncnn' weight ="./demo/weights/yolo11s.pt"# pt 或 yolovx.yaml model = YOLO(weight) results = model.export(format = format)

3. rknn-toolkit模型轉換

3.1 rknn-toolkit模型轉換環境搭建

onnx模型需要轉換為rknn模型才能在EASY-EAI-Orin-nano運行,所以需要先搭建rknn-toolkit模型轉換工具的環境。當然tensorflow、tensroflow lite、caffe、darknet等也是通過類似的方法進行模型轉換,只是本教程onnx為例。

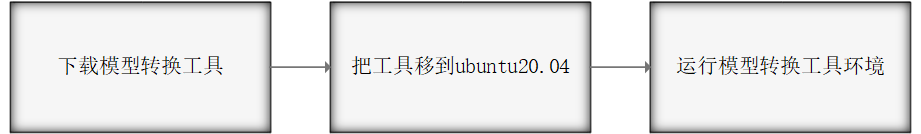

3.1.1 概述

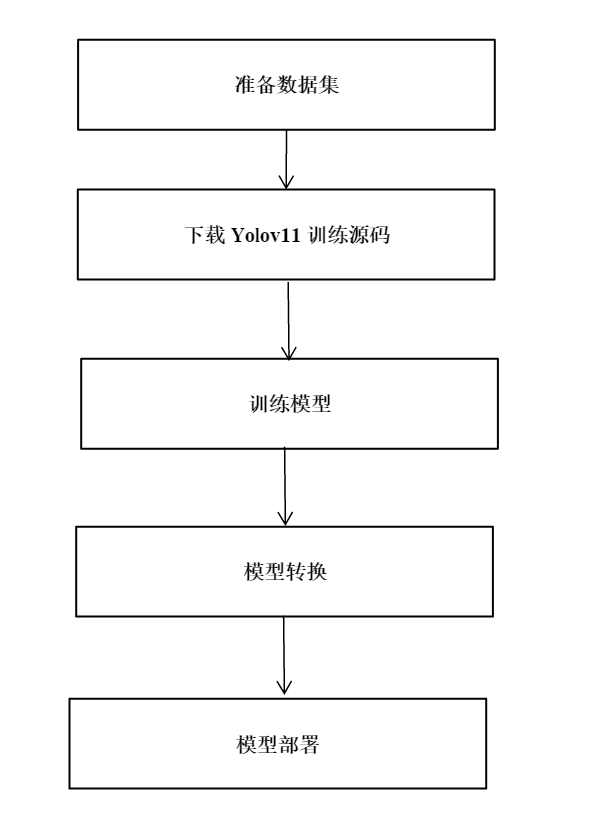

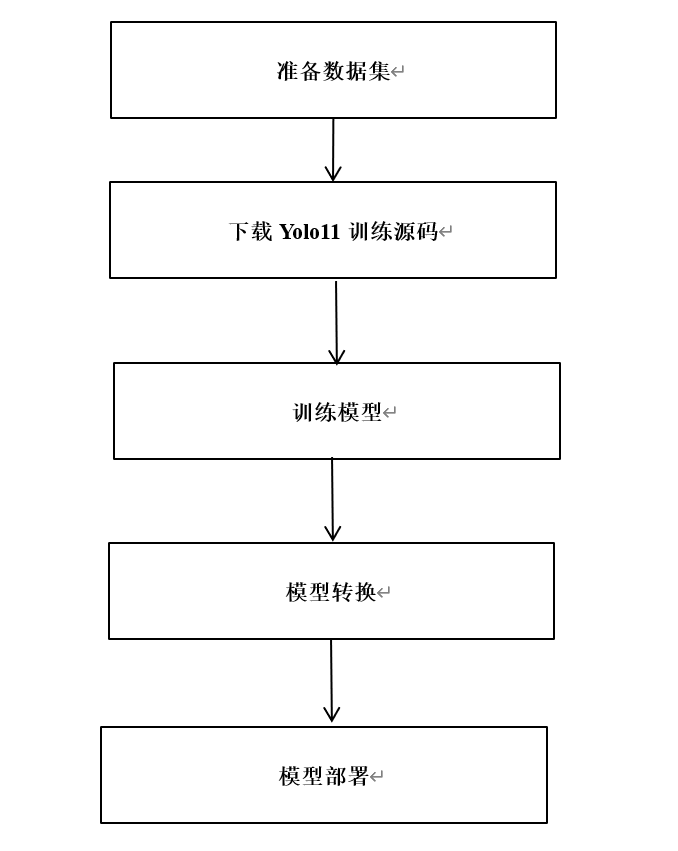

模型轉換環境搭建流程如下所示:

3.1.2 下載模型轉換工具

為了保證模型轉換工具順利運行,請下載網盤里“06.AI算法開發/01.rknn-toolkit2模型轉換工具/rknn-toolkit2-v2.3.0/docker/rknn-toolkit2-v2.3.0-cp38-docker.tar.gz”。

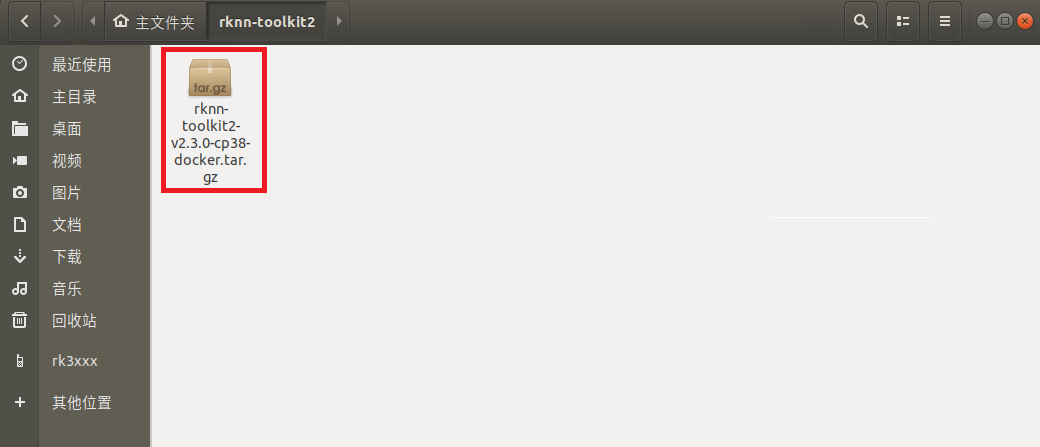

3.1.3 把工具移到ubuntu20.04

把下載完成的docker鏡像移到我司的虛擬機ubuntu20.04的rknn-toolkit2目錄,如下圖所示:

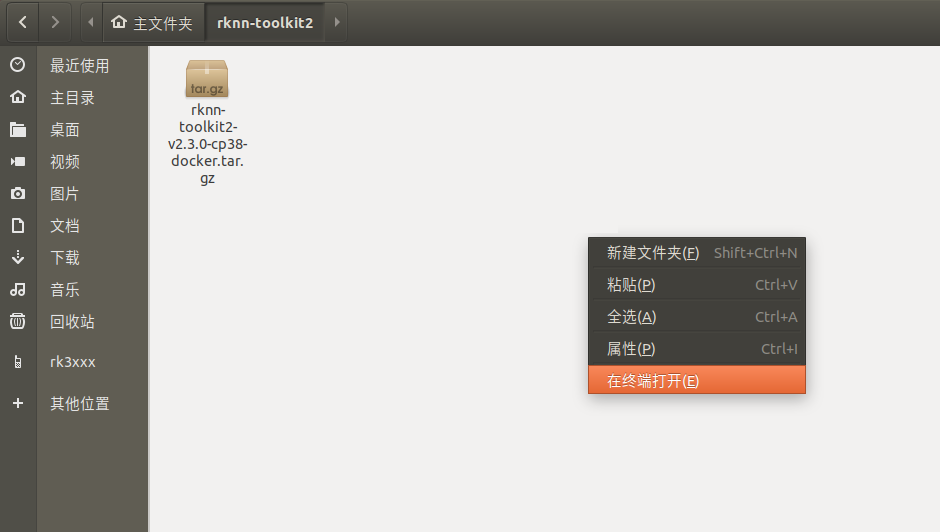

3.1.4 運行模型轉換工具環境

在該目錄打開終端:

執行以下指令加載模型轉換工具docker鏡像:

dockerload --input rknn-toolkit2-v2.3.0-cp38-docker.tar.gz

執行以下指令進入鏡像bash環境:

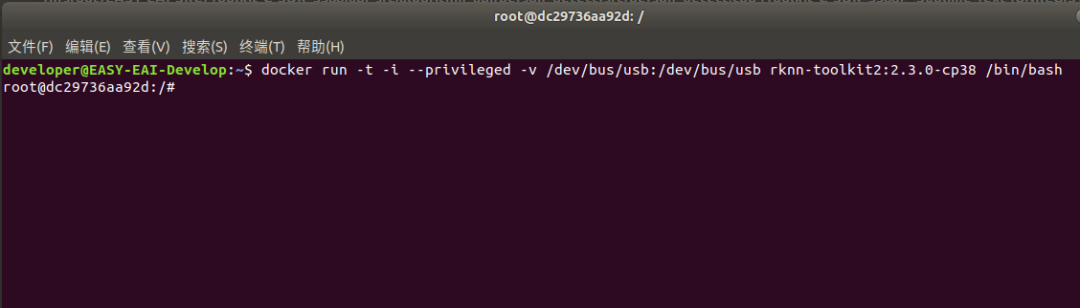

docker run-t-i--privileged-v/dev/bus/usb:/dev/bus/usb rknn-toolkit2:2.3.0-cp38/bin/bash

現象如下圖所示:

輸入“python”加載python相關庫,嘗試加載rknn庫,如下圖環境測試成功:

至此,模型轉換工具環境搭建完成。

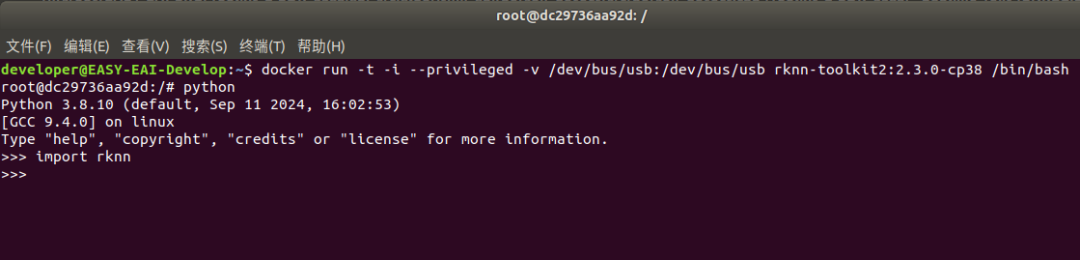

4. 模型轉換為RKNN

EASY EAI Orin-nano支持.rknn后綴的模型的評估及運行,對于常見的tensorflow、tensroflow lite、caffe、darknet、onnx和Pytorch模型都可以通過我們提供的 toolkit 工具將其轉換至 rknn 模型,而對于其他框架訓練出來的模型,也可以先將其轉至 onnx 模型再轉換為 rknn 模型。模型轉換操作流程如下圖所示:

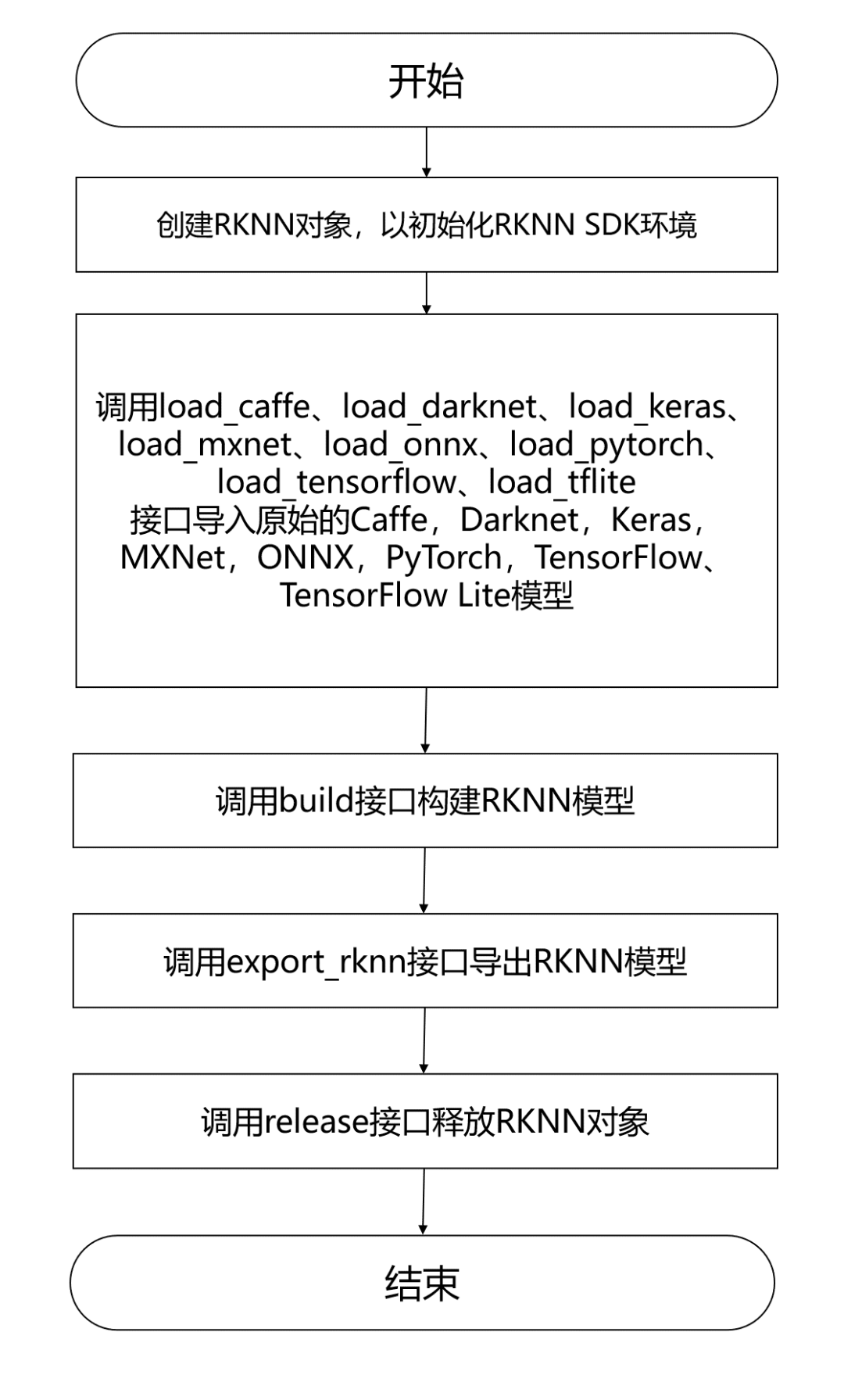

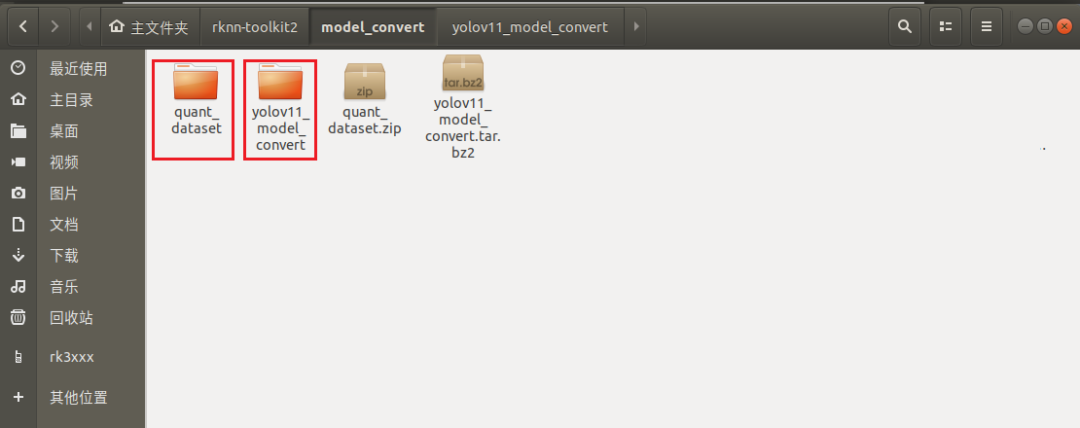

4.1 模型轉換Demo下載

把 yolov11_model_convert.tar.bz2和quant_dataset.zip解壓到虛擬機,如下圖所示:

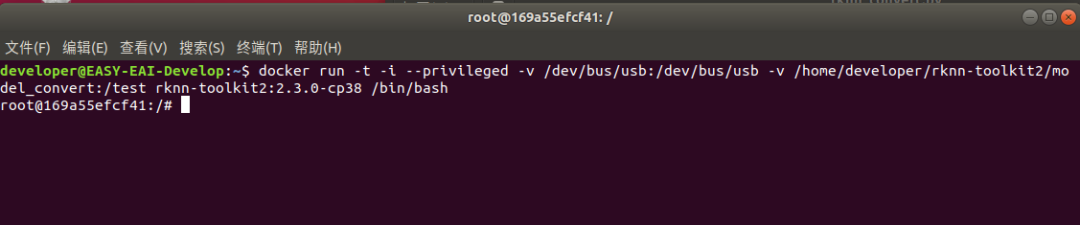

4.2 進入模型轉換工具docker環境

執行以下指令把工作區域映射進docker鏡像,其中/home/developer/rknn-toolkit2/model_convert為工作區域,/test為映射到docker鏡像,/dev/bus/usb:/dev/bus/usb為映射usb到docker鏡像:

docker run -t -i --privileged -v /dev/bus/usb:/dev/bus/usb -v /home/developer/rknn-toolkit2/model_convert:/test rknn-toolkit2:2.3.0-cp38 /bin/bash

執行成功如下圖所示:

4.3 模型轉換操作說明

4.3.1 模型轉換Demo目錄結構

模型轉換測試Demo由yolov11_model_convert和quant_dataset組成。yolov11_model_convert存放軟件腳本,quant_dataset存放量化模型所需的數據。如下圖所示:

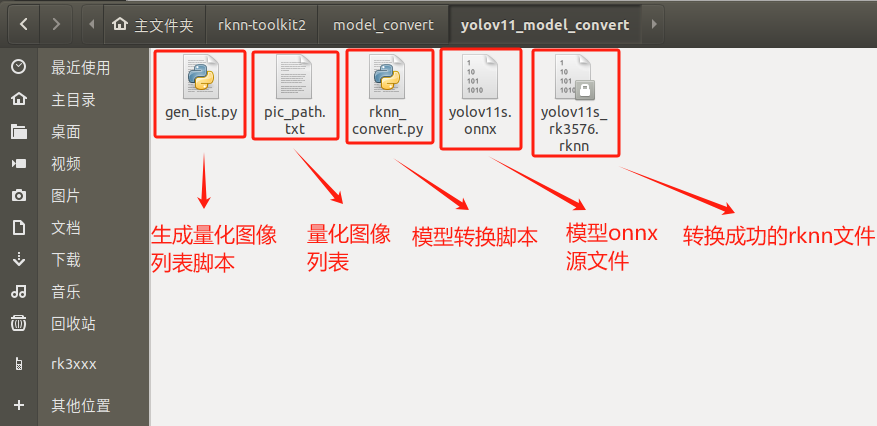

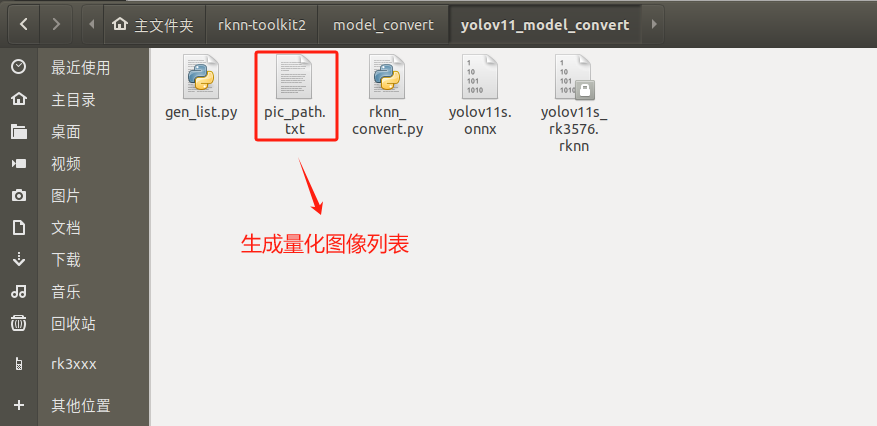

Yolov11_model_convert文件夾存放以下內容,如下圖所示:

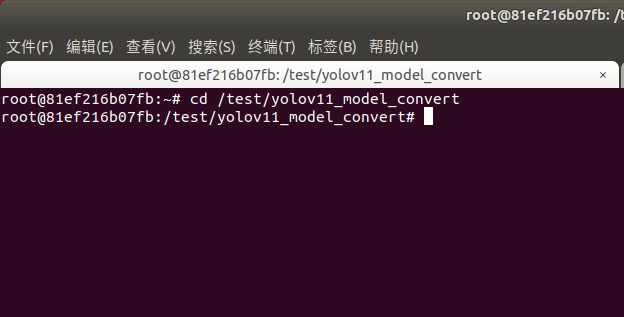

4.3.2 生成量化圖片列表

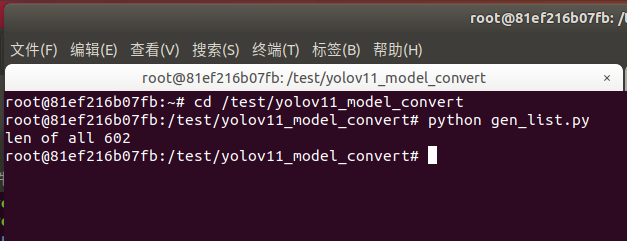

在docker環境切換到模型轉換工作目錄:

cd/test/yolov11_model_convert

如下圖所示:

執行gen_list.py生成量化圖片列表:

pythongen_list.py

命令行現象如下圖所示:

生成“量化圖片列表”如下文件夾所示:

4.3.3 onnx模型轉換為rknn模型

rknn_convert.py腳本默認進行int8量化操作,腳本代碼清單如下所示:

importsys fromrknn.apiimportRKNN ONNX_MODEL ='yolov11s.onnx' DATASET ='./pic_path.txt' RKNN_MODEL ='./yolov11s_rk3576.rknn' QUANTIZE_ON =True if__name__ =='__main__': # Create RKNN object rknn = RKNN(verbose=False) # Pre-process config print('--> Config model') rknn.config(mean_values=[[0,0,0]], std_values=[ [255,255,255]], target_platform='rk3576') print('done') # Load model print('--> Loading model') ret = rknn.load_onnx(model=ONNX_MODEL) ifret !=0: print('Load model failed!') exit(ret) print('done') # Build model print('--> Building model') ret = rknn.build(do_quantization=QUANTIZE_ON, dataset=DATASET) ifret !=0: print('Build model failed!') exit(ret) print('done') # Export rknn model print('--> Export rknn model') ret = rknn.export_rknn(RKNN_MODEL) ifret !=0: print('Export rknn model failed!') exit(ret) print('done') # Release rknn.release()

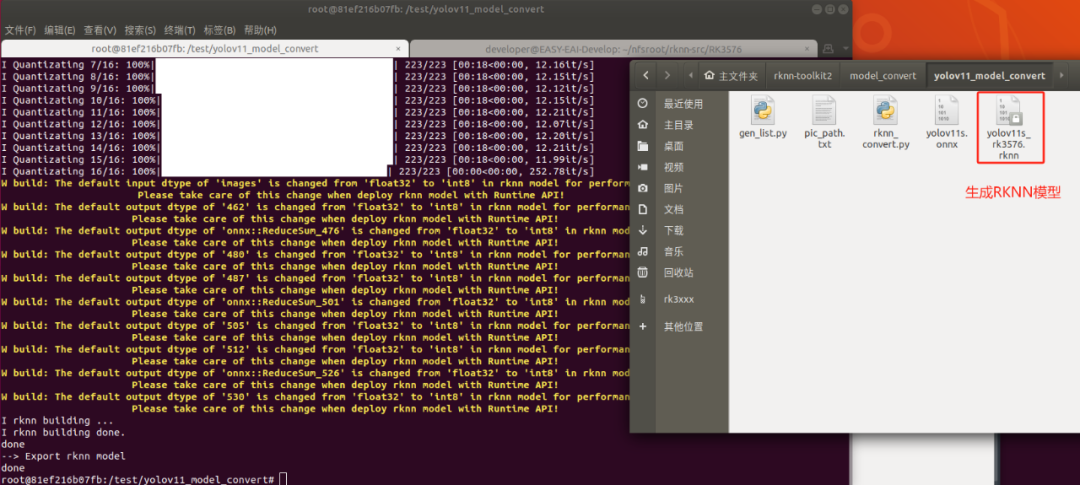

把onnx模型yolov11s.onnx放到yolov11_model_convert目錄(后續用戶使用自己的模型的時候,替換掉對應的onnx即可),并執行rknn_convert.py腳本進行模型轉換:

pythonrknn_convert.py

生成模型如下圖所示,此模型可以在rknn環境和EASY EAI Orin-nano環境運行:

5. 模型部署示例

5.1 模型部署示例介紹

本小節展示yolo11模型的在EASY EAI Orin-nano的部署過程,本章章節使用的yolo11s.rknn模型的是由Ultralytics 官方提供的yolo11s.pt轉換而來。

5.2 源碼下載以及例程編譯

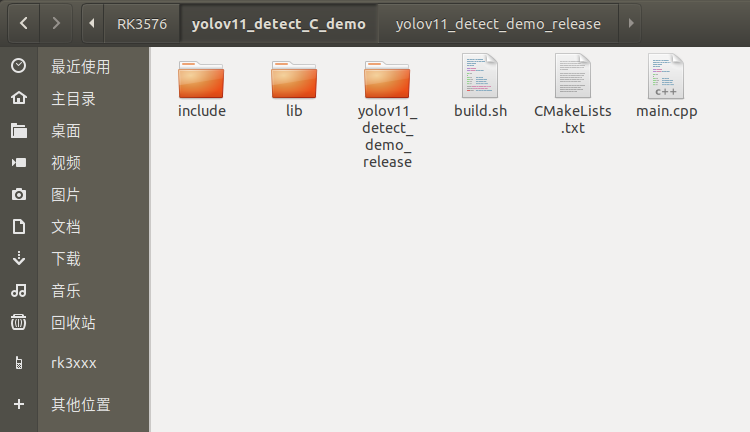

下載yolo11 C Demo示例文件。

下載程序包移至ubuntu環境后,執行以下指令解壓:

tar-xvf yolov11_detect_C_demo.tar.bz2

下載解壓后如下圖所示:

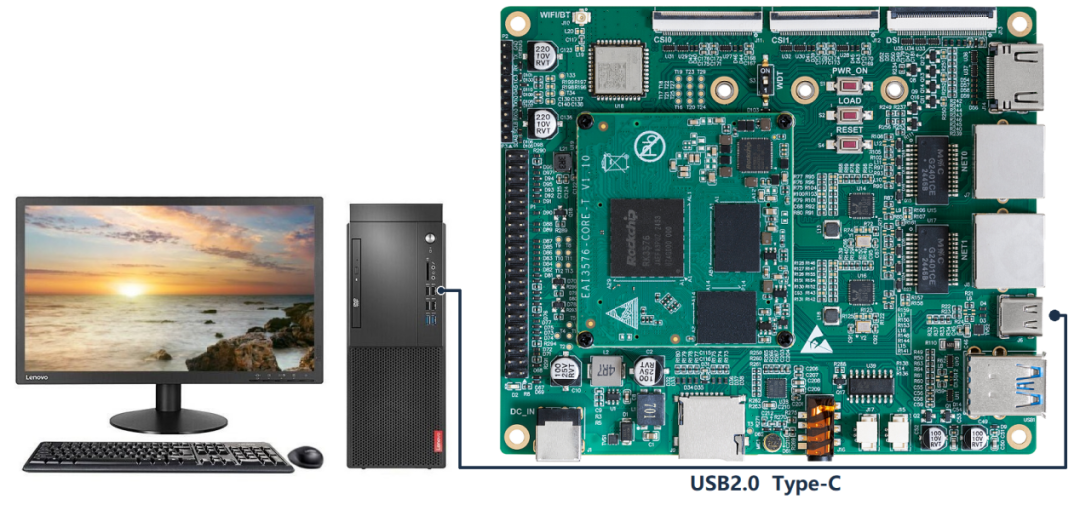

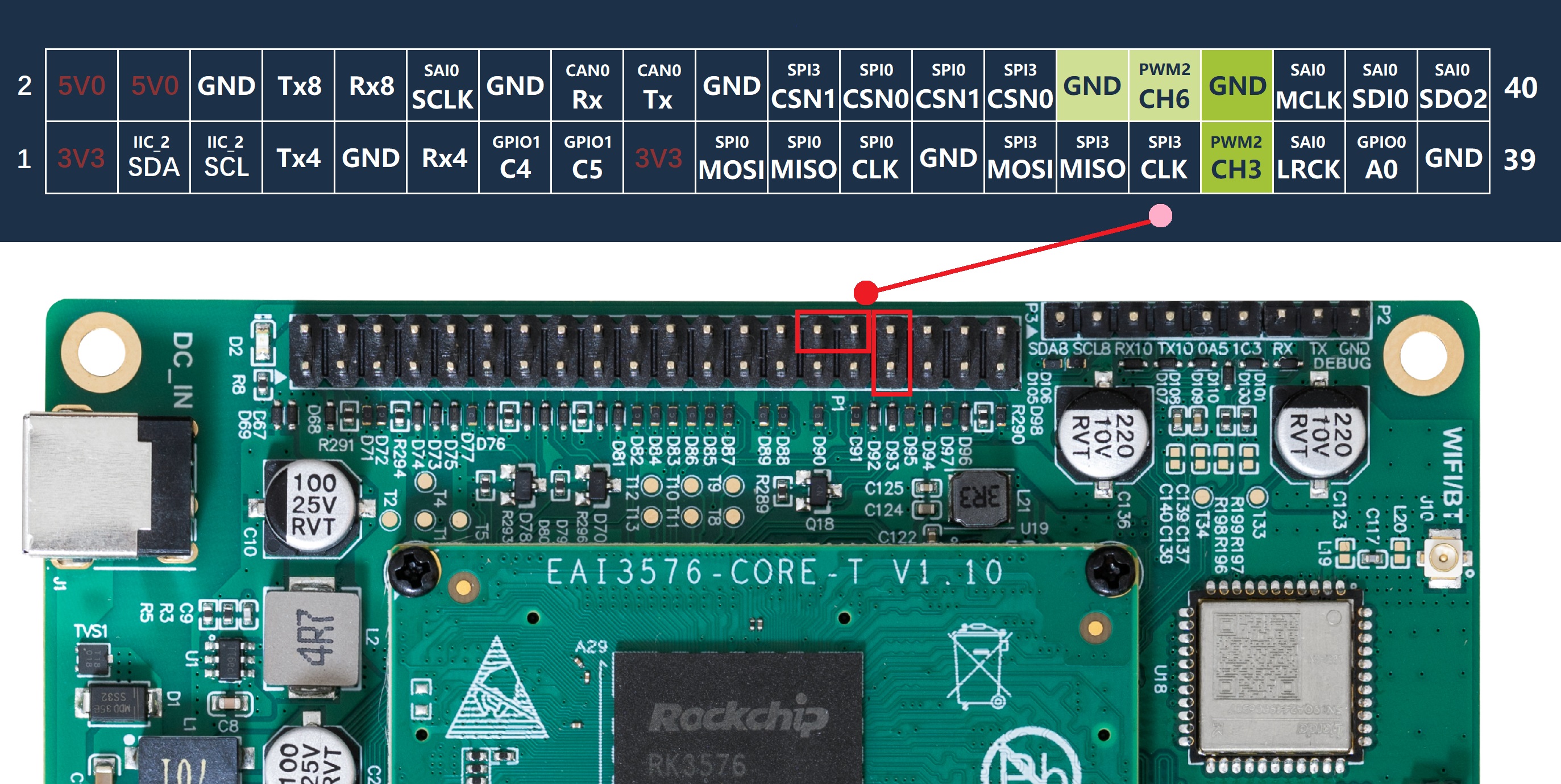

通過adb接口連接EASY-EAI-Orin-nano,,連接方式如下圖所示:

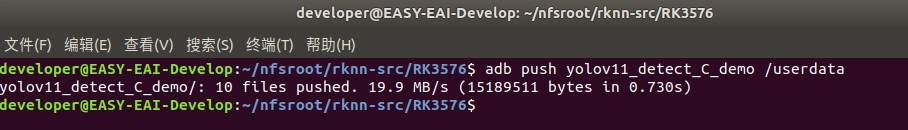

接下來需要通過adb把源碼傳輸到板卡上,先切換目錄然后執行以下指令:

cd~/rknn-toolkit2 adb push yolov11_detect_C_demo/ /userdata

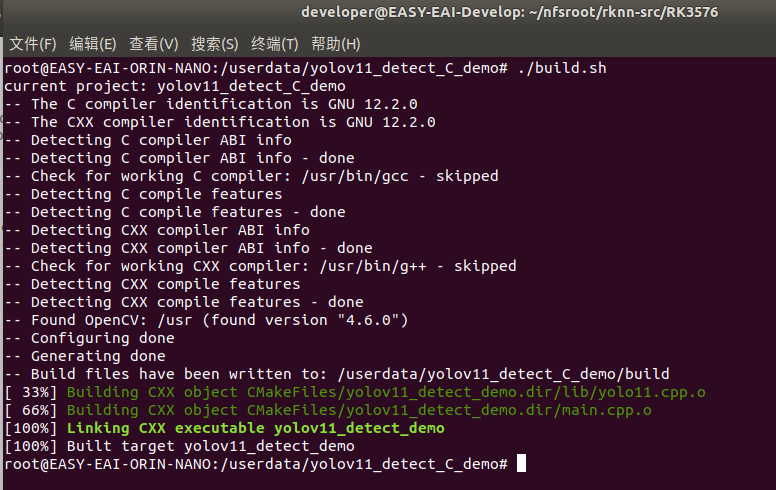

登錄到板子切換到例程目錄執行編譯操作:

adb shell cd/userdata/yolov11_detect_C_demo chmod777 build.sh ./build.sh

5.3 開發板執行yolov11目標檢測算法

編譯成功后切換到可執行程序目錄,如下所示:

cd/userdata/yolov11_detect_C_demo/yolov11_detect_demo_release

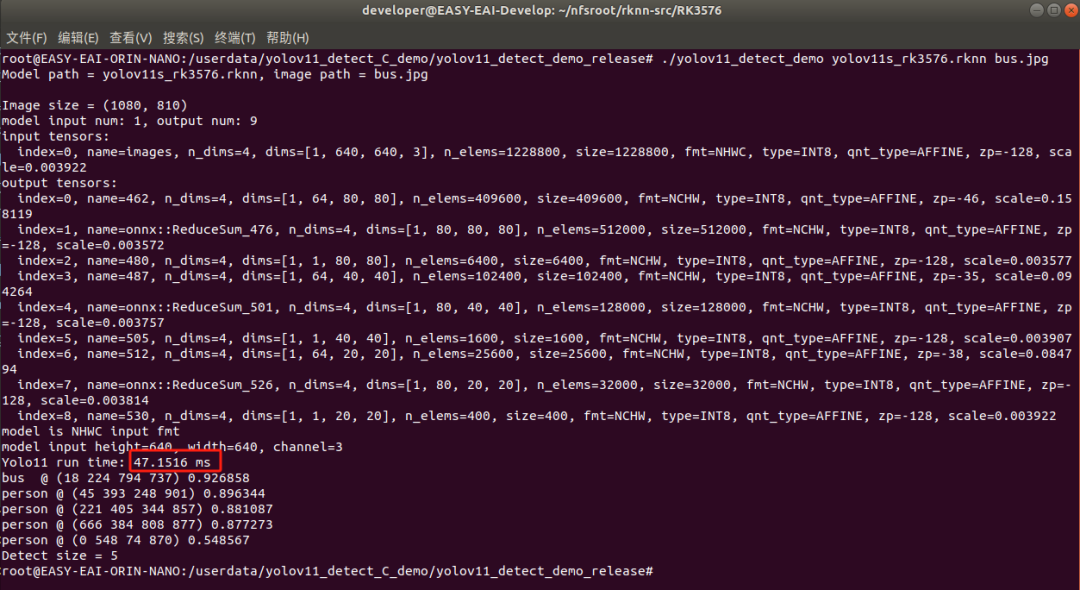

運行例程命令如下所示:

chmod777 yolov11_detect_demo ./yolov11_detect_demo yolov11s_rk3576.rknn bus.jpg

執行結果如下圖所示,yolov11s算法執行時間為47ms:

退出板卡環境,取回測試圖片:

exit adb pull /userdata/yolov11_detect_C_demo/yolov11_detect_demo_release/results.jpg .

至此,yolov11目標檢測例程已成功在板卡運行。

-

算法

+關注

關注

23文章

4705瀏覽量

95087 -

模型

+關注

關注

1文章

3504瀏覽量

50202 -

代碼

+關注

關注

30文章

4894瀏覽量

70449 -

目標檢測

+關注

關注

0文章

223瀏覽量

15958 -

rk3576

+關注

關注

1文章

162瀏覽量

652

原文標題:RK3576 Yolov11訓練部署教程

文章出處:【微信號:easy-eai-AIoT,微信公眾號:EASY EAI靈眸科技】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

米爾RK3576和RK3588怎么選?-看這篇就夠了

【米爾RK3576開發板評測】+項目名稱YOLOV5目標檢測

【米爾RK3576開發板評測】+項目名稱百度飛槳PP-YOLOE

RK3576 vs RK3588:為何越來越多的開發者轉向RK3576?

Mpp支持RK3576么

新品體驗 | RK3576開發板

RK3576單板發布倒計時:RK3399與RK3576對比

RK3588與RK3576區別解析

想學人工智能AI?我建議RK3576!

RK3576 yolov11-seg訓練部署教程

RK3576 Yolov11訓練部署教程

RK3576 Yolov11訓練部署教程

評論