1. yolov11-seg簡介

yolov11-seg 是YOLO(You Only Look Once)系列的最新成員,專為實時實例分割任務設計。它在保持YOLO家族高效推理速度的同時,通過創新的網絡結構和分割頭設計,實現了像素級的精確目標檢測與分割,適用于自動駕駛、醫學影像、工業檢測等對精度和速度要求苛刻的場景。

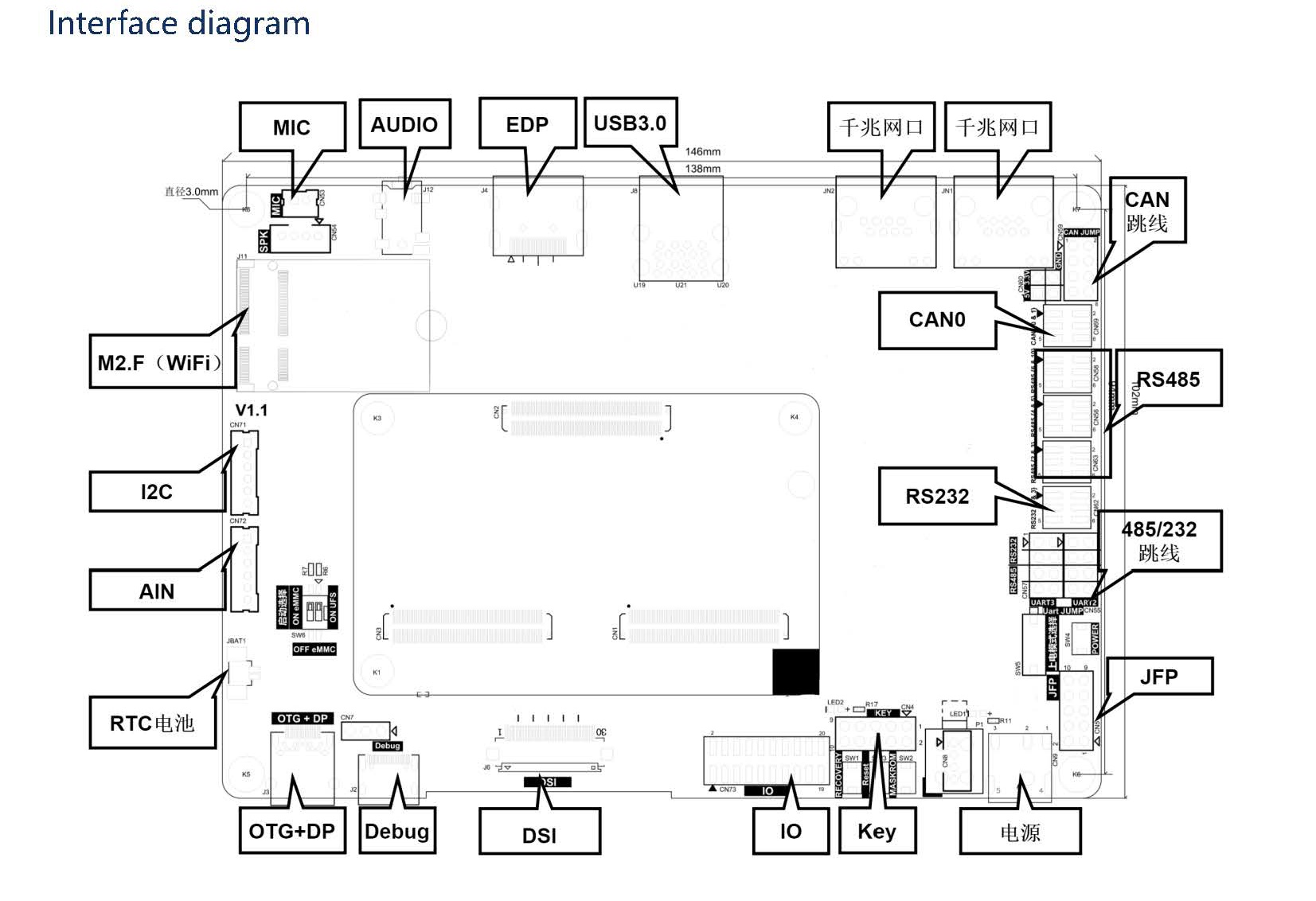

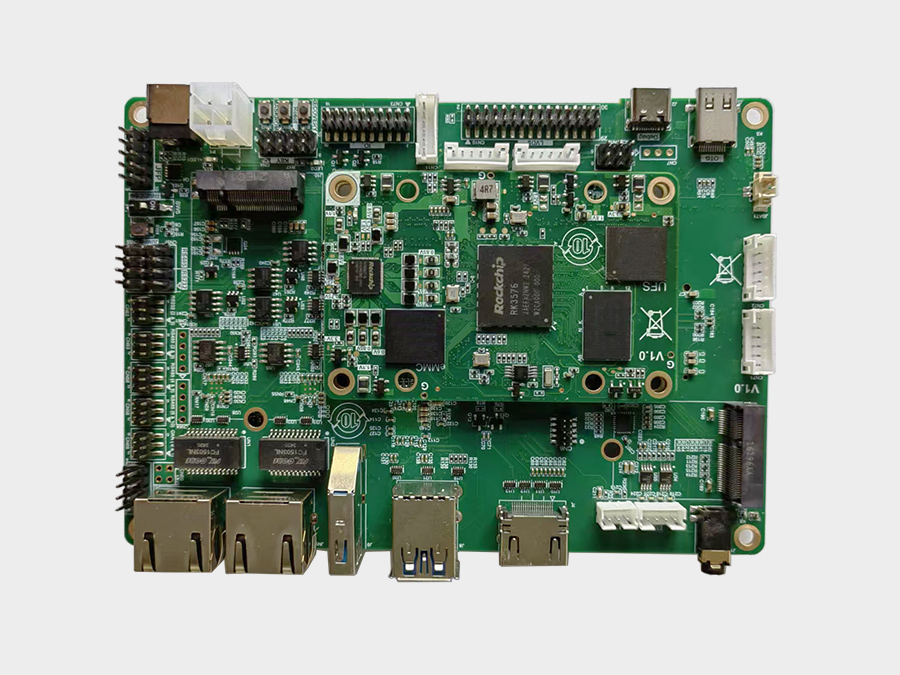

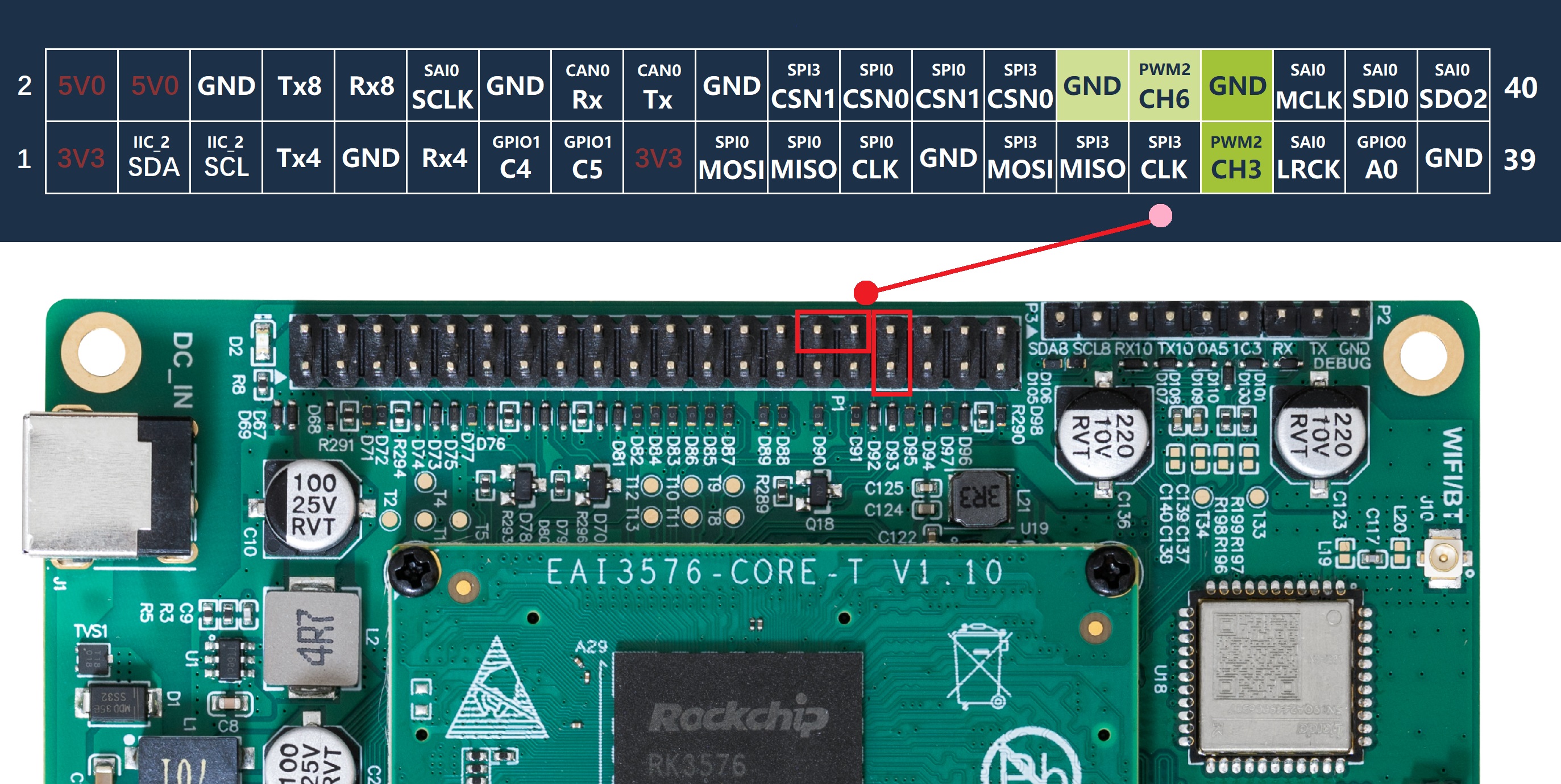

本教程針對目標分割算法yolov11 seg的訓練和部署到EASY-EAI-Orin-nano(RK3576)進行說明,而數據標注方法可以參考我們往期的文章。

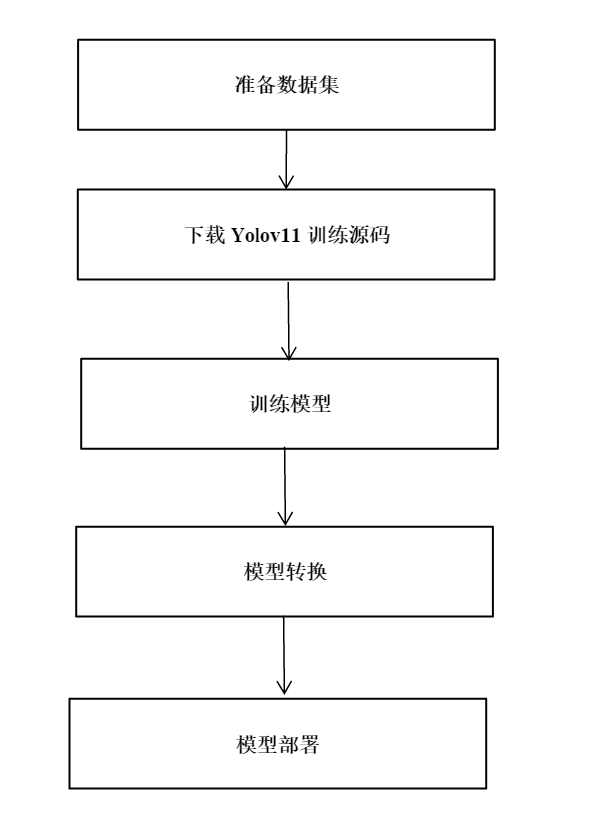

2. yolov11-seg模型訓練

yolov11-seg訓練代碼在導出部分對比原版會有一些修改,建議下載我們的訓練代碼。百度網盤鏈接:https://pan.baidu.com/s/1kPU_t7GaZzi1zot_aI7xPQ?pwd=1234(提取碼:1234)。

2.1 數據集準備

在開始yolov11訓練前,我看先準備好待訓練數據,如crack(裂縫數據集),數據集也在訓練工程的壓縮包里面了。

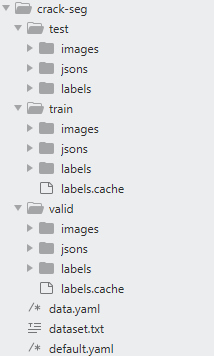

目錄如下圖示意:

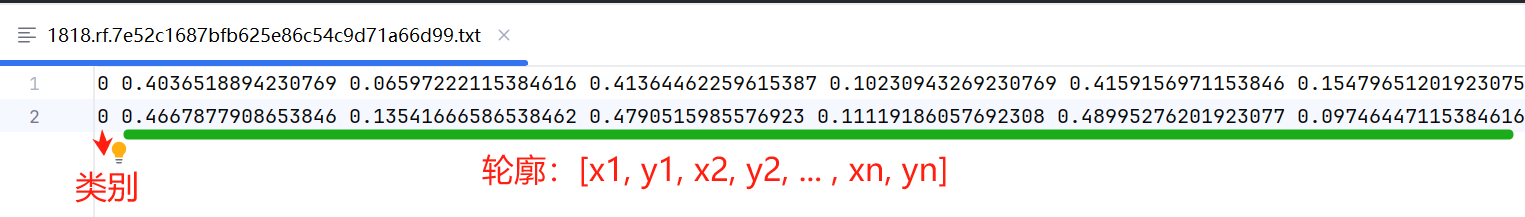

crack-seg標簽數據格式說明如下圖所示:

注:如果你需要將json格式的標注數據轉成label標簽數據,可以使用./data/json_2_yolo.py腳本轉換。

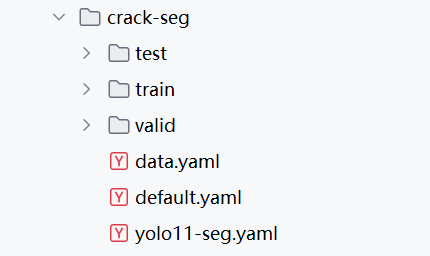

2.2 訓練參數配置

配置模型的訓練參數:data.yaml,default.yaml,yolo11-seg.yaml,以crack-seg為例.

其中:

data.yaml:為待訓練數據和驗證數據的路徑,以及類別數和類別名稱;

default.yaml:為yolov11-seg訓練參數,可自行調整模型訓練的參數;

yolo11-seg.yaml:為yolov11-seg模型結構,在模型訓練時,你需要修改類別數。

更多關于yolov11-seg信息可參考:

https://blog.csdn.net/qq_45972324/article/details/143892222

2.3 模型訓練

完成上述步驟后,就可以開始訓練模型了,打開train.py腳本,輸入data.yaml,default.yaml,yolo11-seg.yaml路徑,如下代碼段所示:

from ultralytics import YOLO

import os

os.environ["KMP_DUPLICATE_LIB_OK"] = "TRUE"

if __name__ == '__main__':

cfg = r"./demo/crack-seg/default.yaml"

data = r'./demo/crack-seg/data.yaml'

#weight = r"./demo/weights/yolo11n-seg.pt" # pt 或 yolovx.yaml

weight = r"./demo/crack-seg/yolo11-seg.yaml"

model = YOLO(weight)

results = model.train(

data=data,

cfg=cfg

)

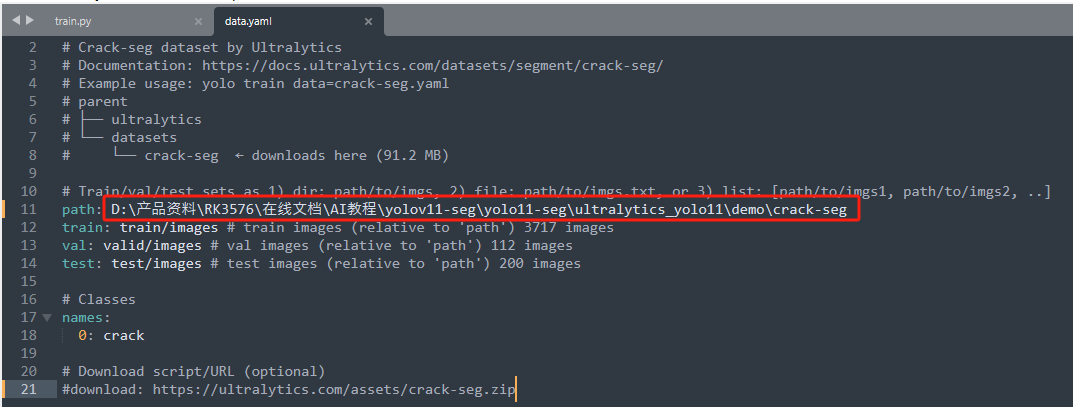

由于大家下載源碼包后解壓路徑都不一樣,所以需要更改data.yaml的數據集路徑才能讓模型訓練的時候找到數據集:

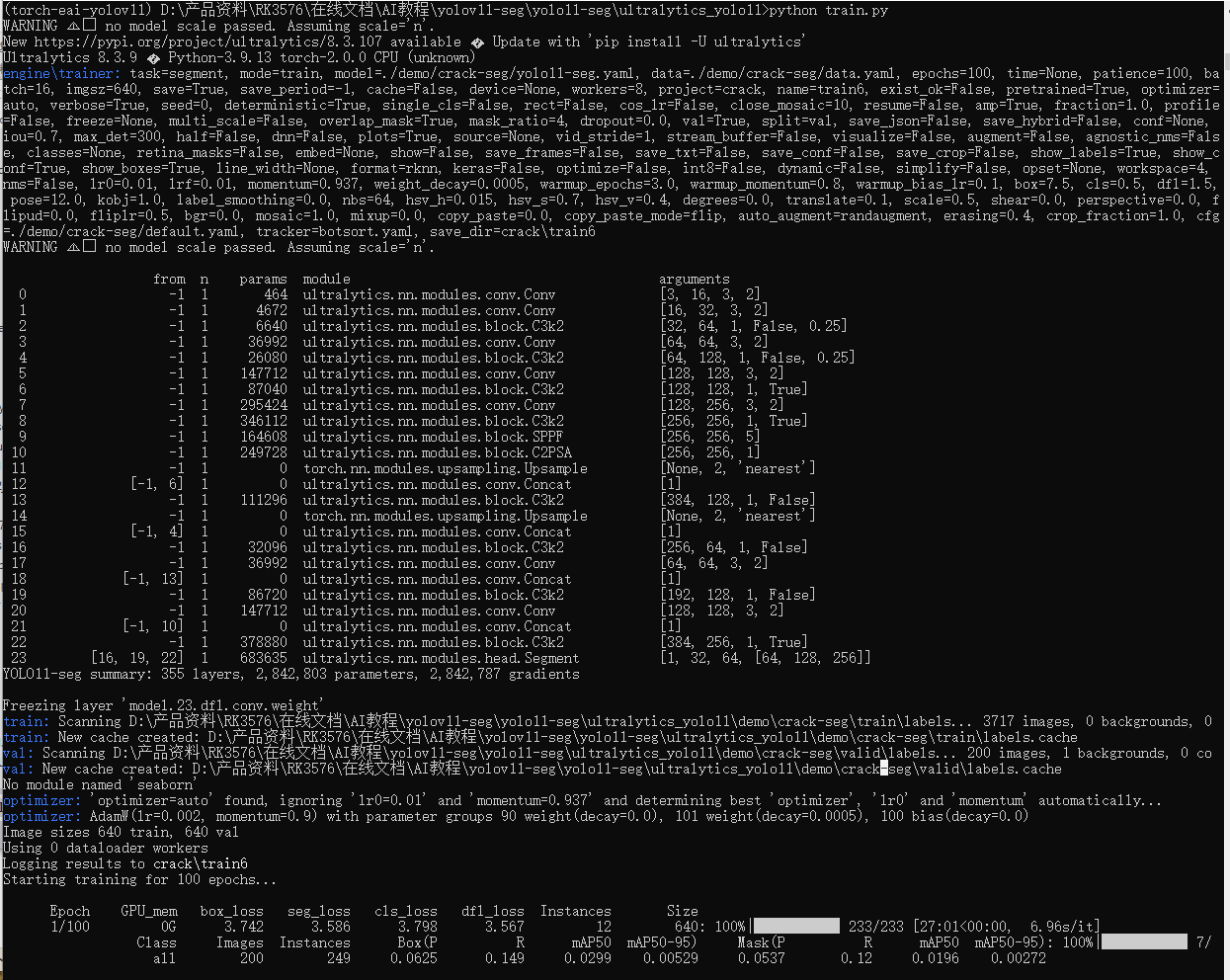

執行train.py訓練腳本,開始模型訓練,如下示意圖:

python train.py

2.4 PC端預測模型預測

訓練完畢后,在default.yaml文件配置的project目錄下保存訓練過程,經驗證集測試的最好結果的模型。同時可以執行模型預測,初步評估模型的效果。打開predict-seg.py腳本,配置好模型路徑和待檢測圖片,如下代碼片段:

from ultralytics import YOLO # Load a model model_path = r"./demo/crack/train/weights/best.pt" image_path = r"./demo/crack-seg/test/images/1616.rf.c868709931a671796794fdbb95352c5a.jpg" model = YOLO(model_path) # load an official model # Predict with the model results = model(image_path) # predict on an image for result in results: boxes = result.boxes # Boxes object for bounding box outputs masks = result.masks # Masks object for segmentation masks outputs keypoints = result.keypoints # Keypoints object for pose outputs probs = result.probs # Probs object for classification outputs obb = result.obb # Oriented boxes object for OBB outputs result.show() # display to screen result.save(filename="result.jpg") # save to disk

執行腳本:

python predict-seg.py

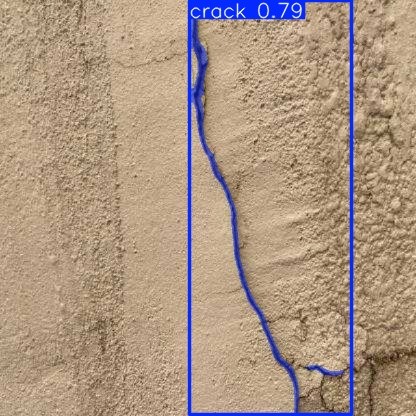

腳本運行結束后,會將圖片結果圖片保存為result.jpg,運行結果如下圖所示:

2.5 PT模型轉ONNX

在PC端執行export.py將pt模型轉成onnx,如下代碼段所示:

from ultralytics import YOLO

if __name__ == '__main__':

format = 'rknn' # 'torchscript', 'onnx', 'openvino', 'engine', 'coreml', 'saved_model', 'pb', 'tflite', 'edgetpu', 'tfjs', 'paddle', 'ncnn'

weight = r"./demo/crack/train/weights/best.pt" # pt 或 yolovx.yaml

model = YOLO(weight)

results = model.export(format = format)

執行腳本:

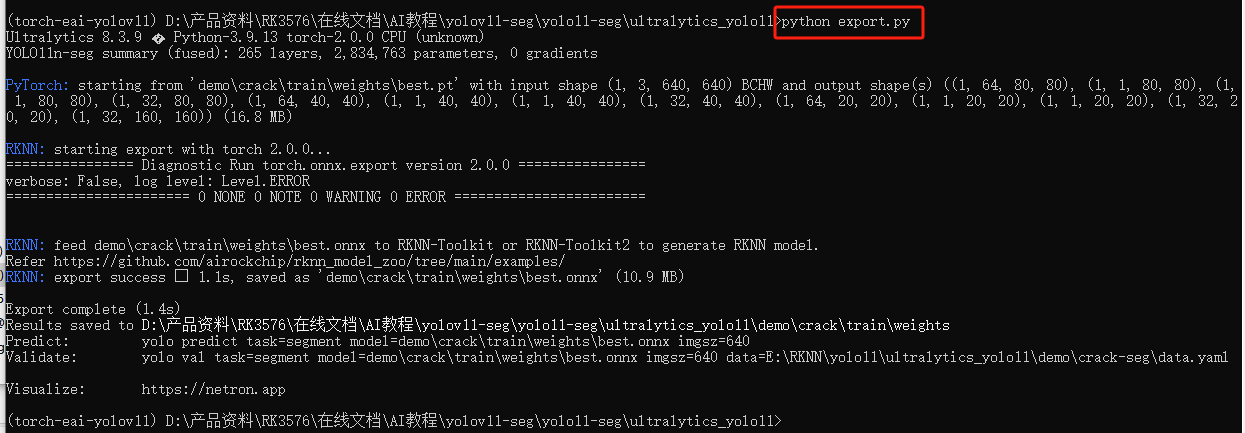

python export.py

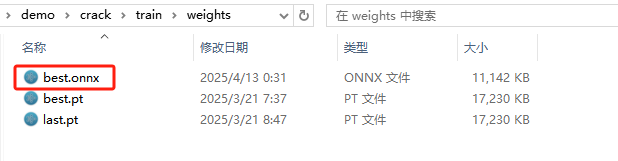

生成best.onnx模型如下所示:

3. rknn-toolkit模型轉換

3.1 rknn-toolkit模型轉換環境搭建

onnx模型需要轉換為rknn模型才能在EASY-EAI-Orin-nano運行,所以需要先搭建rknn-toolkit模型轉換工具的環境。當然tensorflow、tensroflow lite、caffe、darknet等也是通過類似的方法進行模型轉換,只是本教程onnx為例。

3.1.1 概述

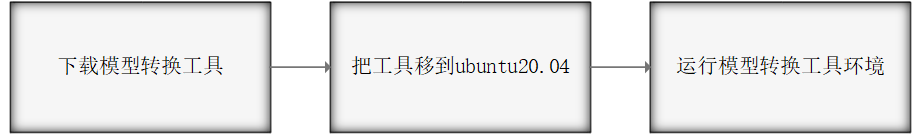

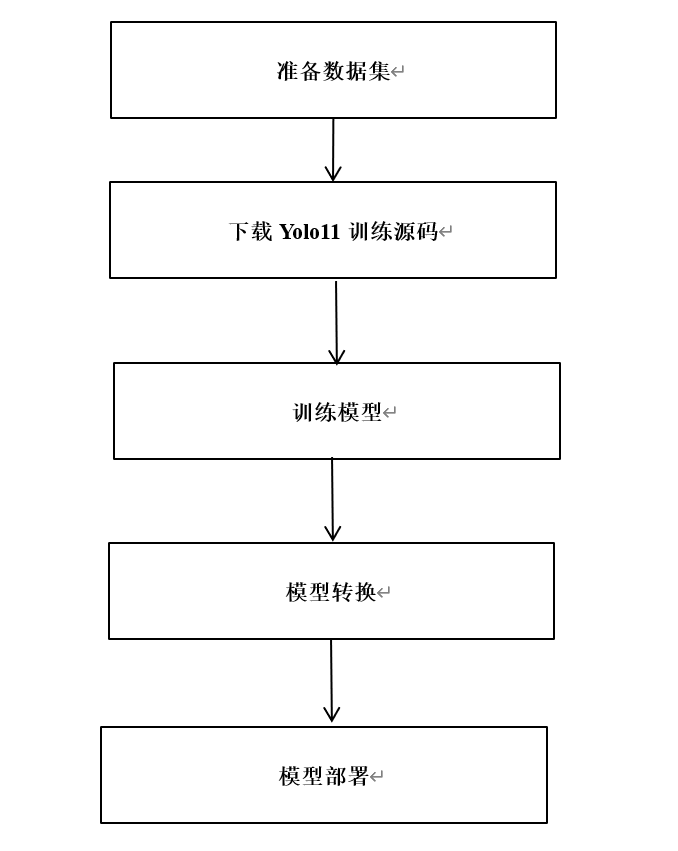

模型轉換環境搭建流程如下所示:

3.1.2 下載模型轉換工具

為了保證模型轉換工具順利運行,請下載網盤里“06.AI算法開發/01.rknn-toolkit2模型轉換工具/rknn-toolkit2-v2.3.0/docker/rknn-toolkit2-v2.3.0-cp38-docker.tar.gz”。

網盤下載鏈接:https://pan.baidu.com/s/1J86chdq1klKFnpCO1RCcEA?pwd=1234(提取碼:1234)。

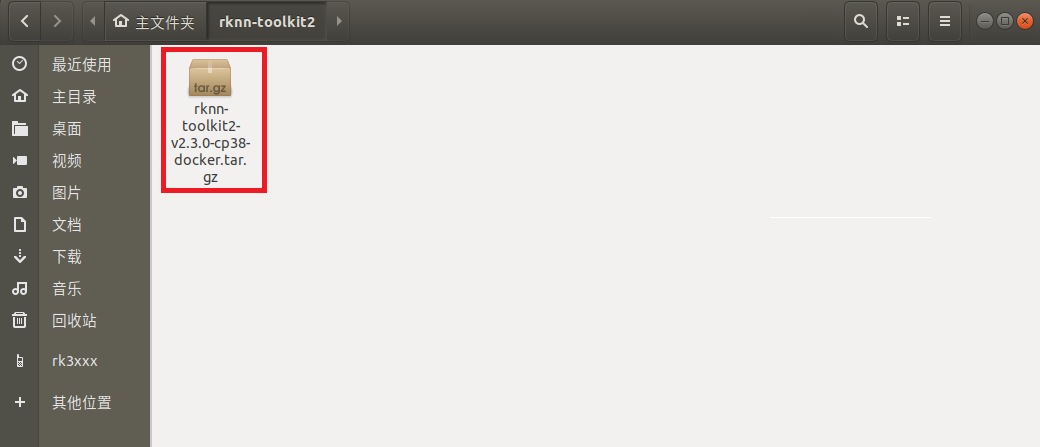

3.1.3 把工具移到ubuntu20.04

把下載完成的docker鏡像移到我司的虛擬機ubuntu20.04的rknn-toolkit2目錄,如下圖所示:

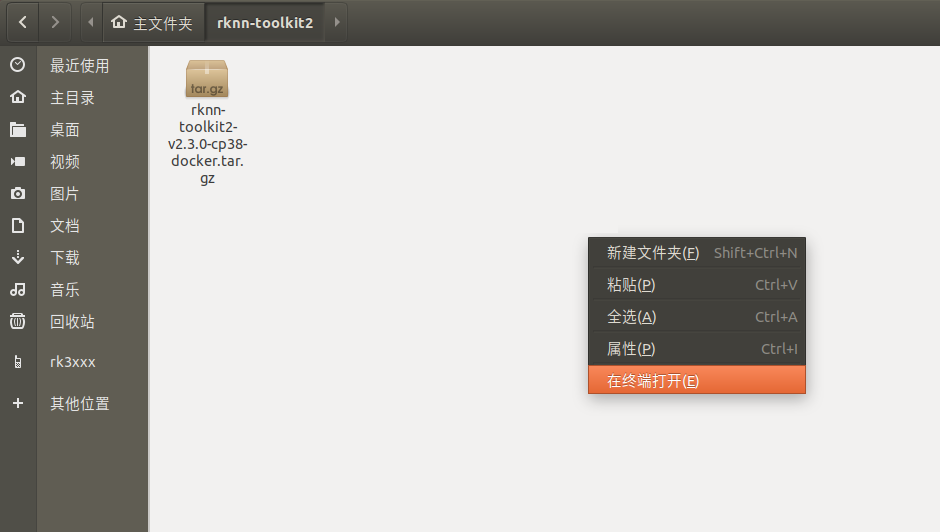

3.1.4 運行模型轉換工具環境

在該目錄打開終端

執行以下指令加載模型轉換工具docker鏡像:

docker load --input rknn-toolkit2-v2.3.0-cp38-docker.tar.gz

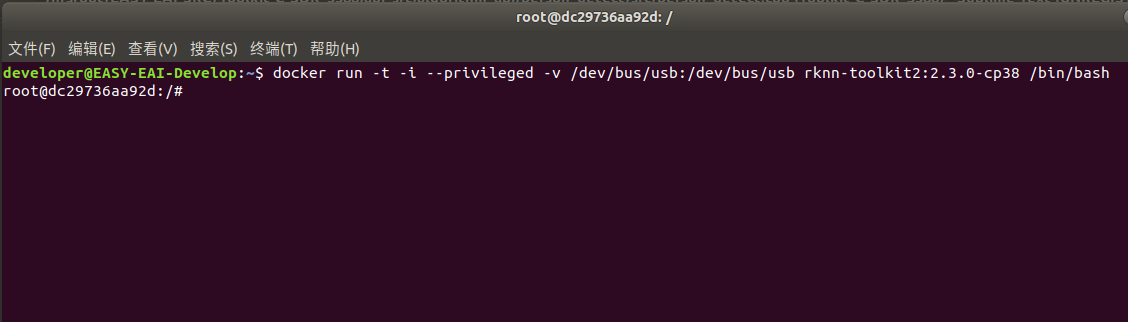

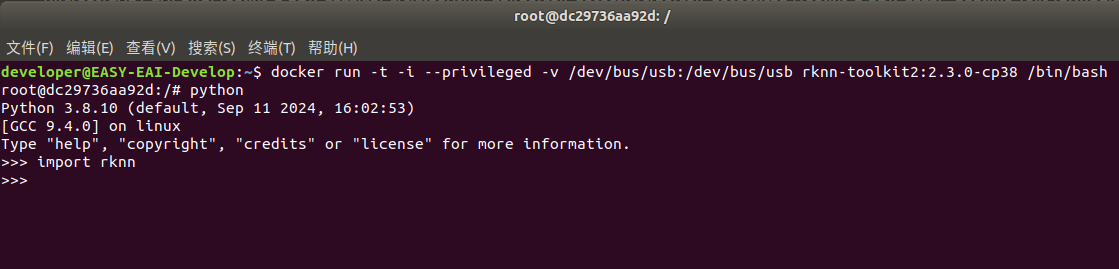

執行以下指令進入鏡像bash環境:

docker run -t -i --privileged -v /dev/bus/usb:/dev/bus/usb rknn-toolkit2:2.3.0-cp38 /bin/bash

現象如下圖所示:

輸入“python”加載python相關庫,嘗試加載rknn庫,如下圖環境測試成功:

至此,模型轉換工具環境搭建完成。

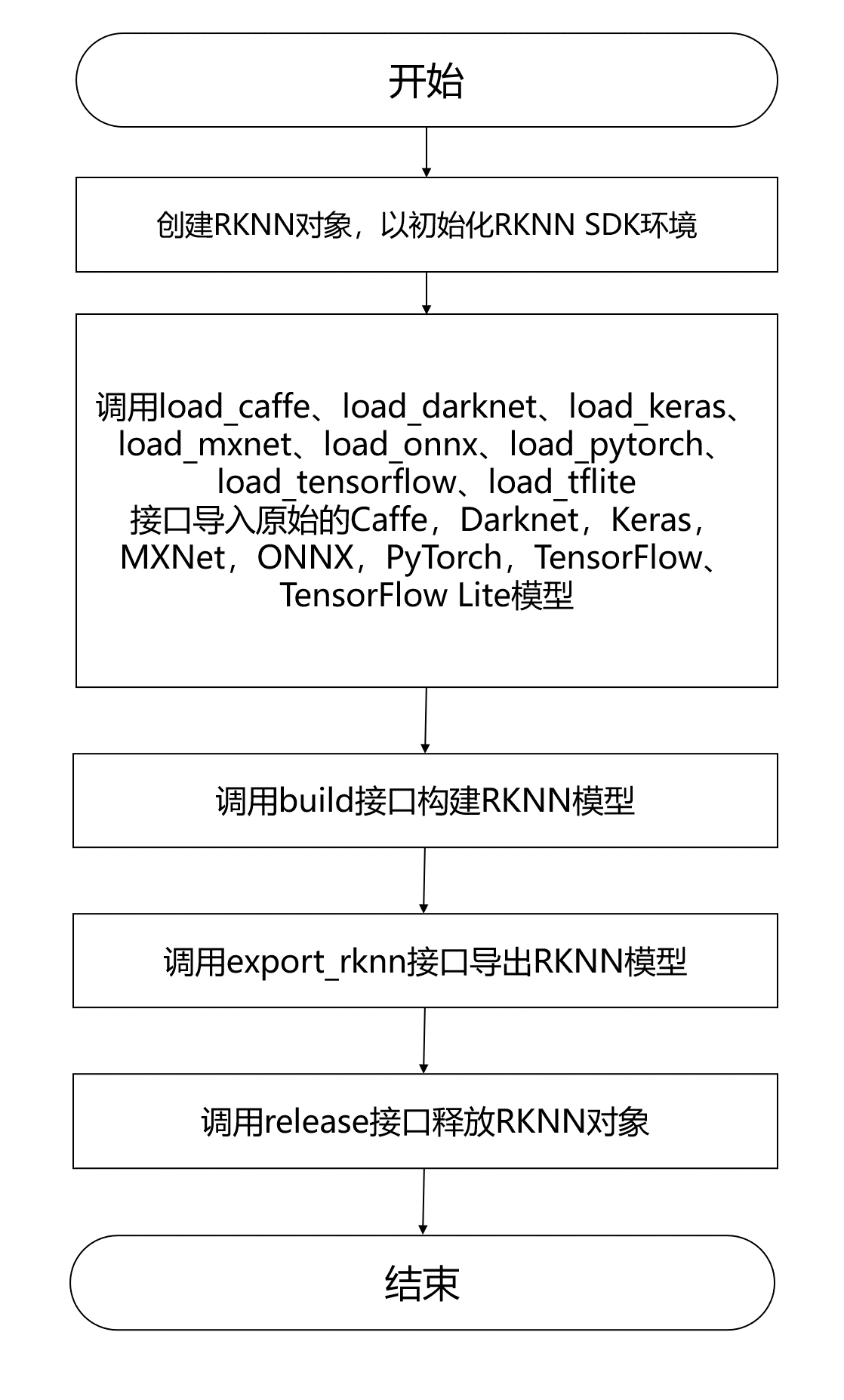

4. 模型轉換為RKNN

EASY EAI Orin-nano支持.rknn后綴的模型的評估及運行,對于常見的tensorflow、tensroflow lite、caffe、darknet、onnx和Pytorch模型都可以通過我們提供的 toolkit 工具將其轉換至 rknn 模型,而對于其他框架訓練出來的模型,也可以先將其轉至 onnx 模型再轉換為 rknn 模型。模型轉換操作流程入下圖所示:

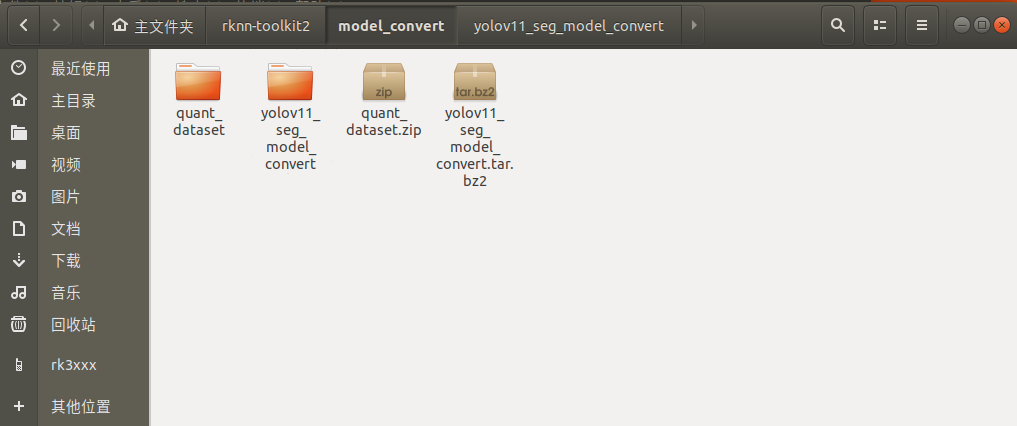

4.1 模型轉換Demo下載

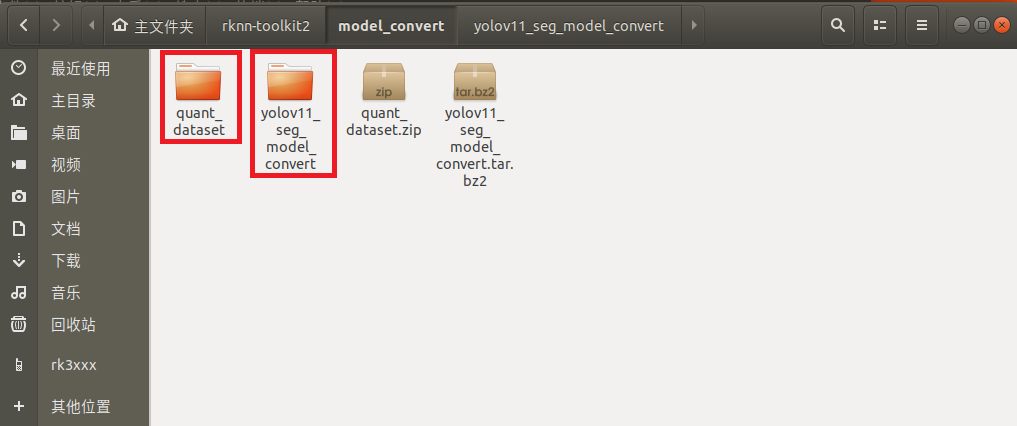

下載百度網盤鏈接:https://pan.baidu.com/s/1jrF2VFZImsBqWQeH4bawaA?pwd=1234(提取碼:1234。)把quant_dataset.zip和yolov11_seg_model_convert.tar.bz2解壓到虛擬機,如下圖所示:

4.2 進入模型轉換工具docker環境

執行以下指令把工作區域映射進docker鏡像,其中/home/developer/rknn-toolkit2/model_convert為工作區域,/test為映射到docker鏡像,/dev/bus/usb:/dev/bus/usb為映射usb到docker鏡像:

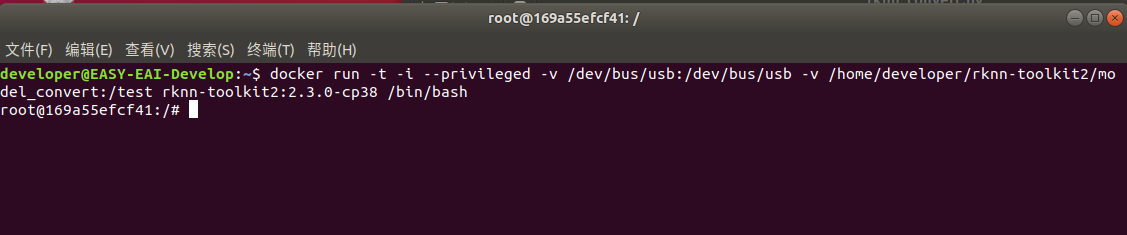

docker run -t -i --privileged -v /dev/bus/usb:/dev/bus/usb -v /home/developer/rknn-toolkit2/model_convert:/test rknn-toolkit2:2.3.0-cp38 /bin/bash

執行成功如下圖所示:

4.3 模型轉換操作說明

4.3.1 模型轉換Demo目錄結構

模型轉換測試Demo由yolov11_seg_model_convert和quant_dataset組成。yolov11_seg_model_convert存放軟件腳本, quant_dataset存放量化模型所需的數據。如下圖所示:

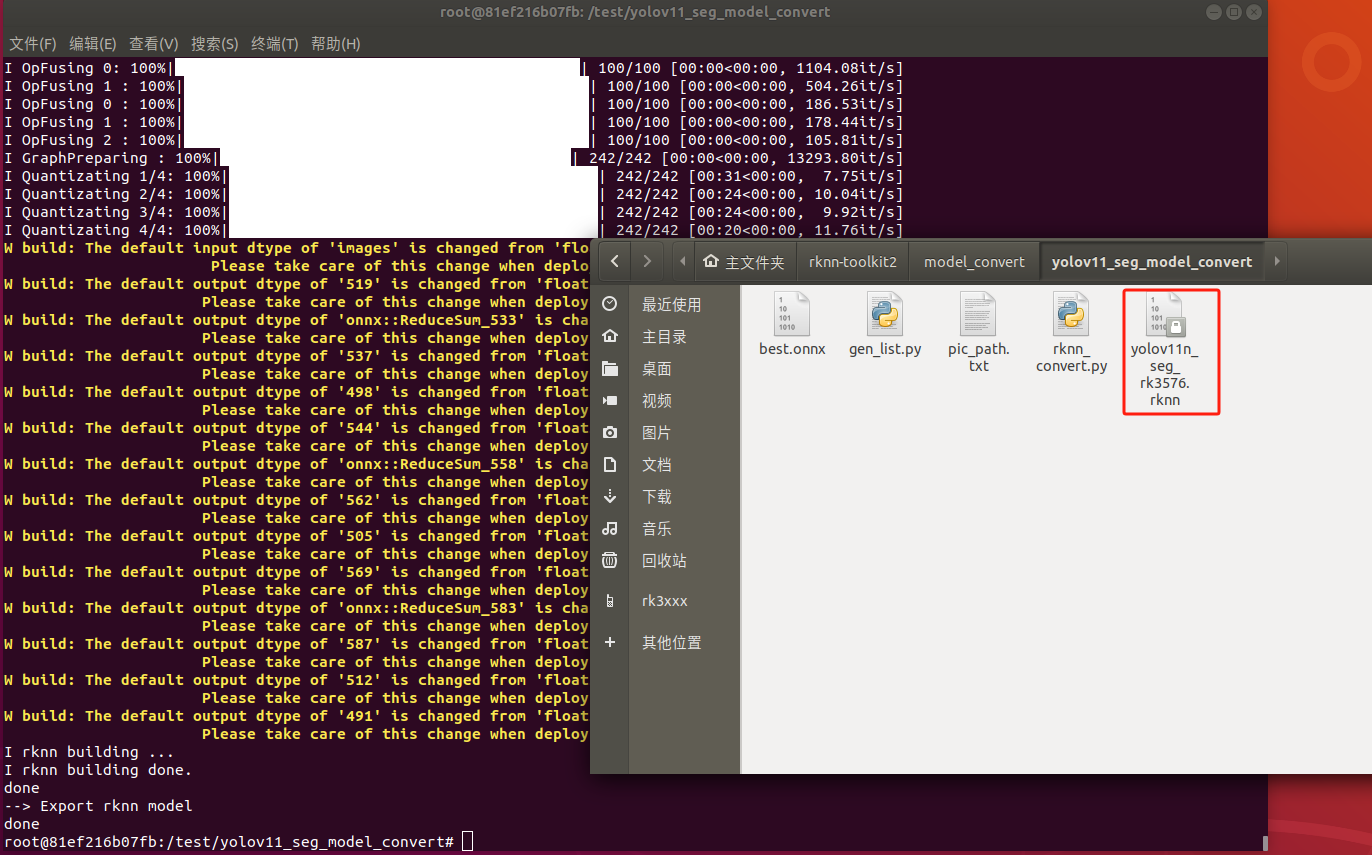

4.3.2 onnx模型轉換為rknn模型

rknn_convert.py腳本默認進行int8量化操作,腳本代碼清單如下所示:

from rknn.api import RKNN import sys from rknn.api import RKNN ONNX_MODEL = 'best.onnx' DATASET = './pic_path.txt' RKNN_MODEL = './yolov11n_seg_rk3576.rknn' QUANTIZE_ON = True if __name__ == '__main__': # Create RKNN object rknn = RKNN(verbose=False) # Pre-process config print('--> Config model') rknn.config(mean_values=[[0, 0, 0]], std_values=[ [255, 255, 255]], target_platform='rk3576') print('done') # Load model print('--> Loading model') ret = rknn.load_onnx(model=ONNX_MODEL) if ret != 0: print('Load model failed!') exit(ret) print('done') # Build model print('--> Building model') ret = rknn.build(do_quantization=QUANTIZE_ON, dataset=DATASET) if ret != 0: print('Build model failed!') exit(ret) print('done') # Export rknn model print('--> Export rknn model') ret = rknn.export_rknn(RKNN_MODEL) if ret != 0: print('Export rknn model failed!') exit(ret) print('done') # Release rknn.release()

并執行如下命令進行模型轉換:

python rknn_convert.py

生成模型如下圖所示,EASY EAI Orin-nano環境運行:

5. 模型部署示例

本小節展示yolov11-seg模型的在EASY EAI Orin-nano的部署過程,本章章節使用的yolov11n_seg_rk3576.rknn是使用crack數據集訓練得到。

5.1 源碼下載以及例程編譯

下載yolov11-seg C Demo示例文件。

百度網盤鏈接: https://pan.baidu.com/s/1GCBkHHWtgXMbDTvEPJHmAw?pwd=1234(提取碼: 1234)。

下載程序包移至ubuntu環境后,執行以下指令解壓:

tar -xvf yolov11_seg_model_convert.tar.bz2

下載解壓后如下圖所示:

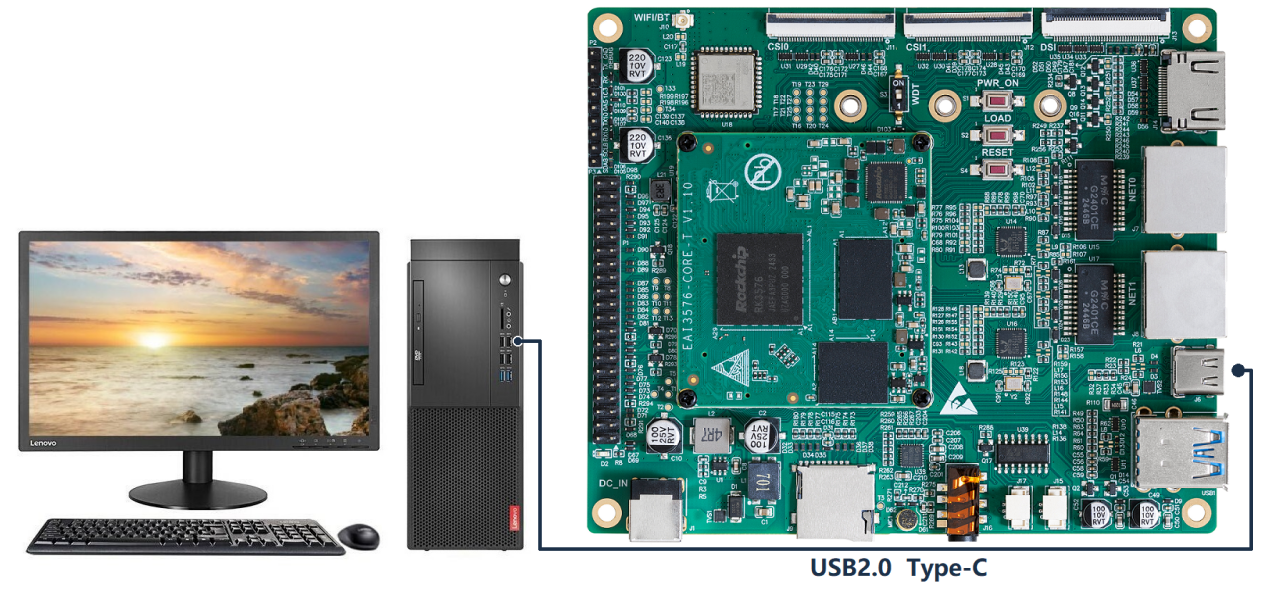

通過adb接口連接EASY-EAI-Orin-nano,,連接方式如下圖所示:

接下來需要通過adb把源碼傳輸到板卡上,先切換目錄然后執行以下指令:

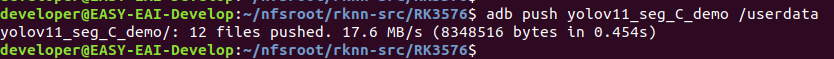

cd ~/rknn-toolkit2 adb push yolov11_seg_C_demo /userdata

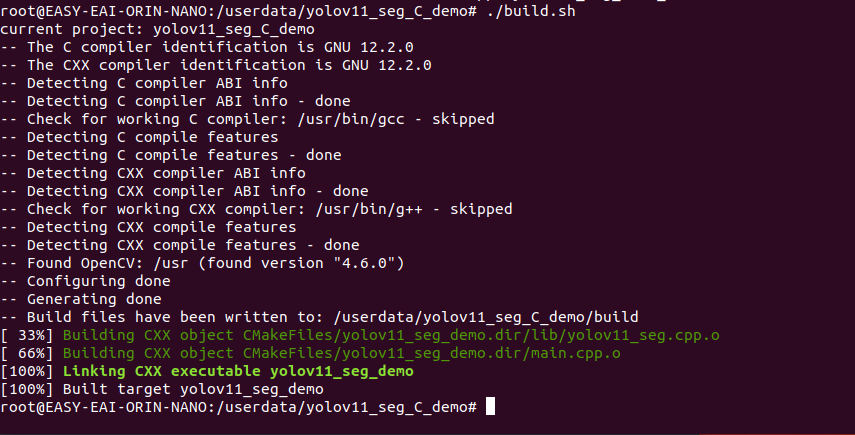

登錄到板子切換到例程目錄執行編譯操作

adb shell cd /userdata/yolov11_seg_C_demo chmod 777 build.sh ./build.sh

5.2 開發板執行yolov11 seg分割算法

編譯成功后切換到可執行程序目錄,如下所示:

cd /userdata/yolov11_seg_C_demo/yolov11_seg_demo_release/

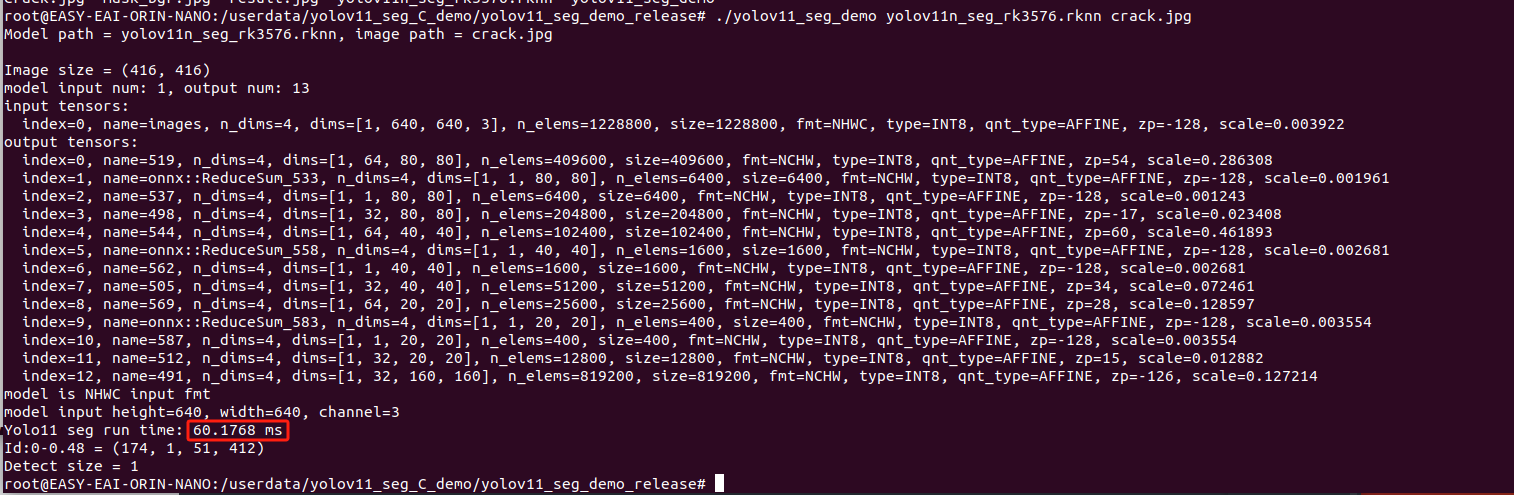

運行例程命令如下所示:

chmod 777 yolov11_seg_demo ./yolov11_seg_demo yolov11n_seg_rk3576.rknn crack.jpg

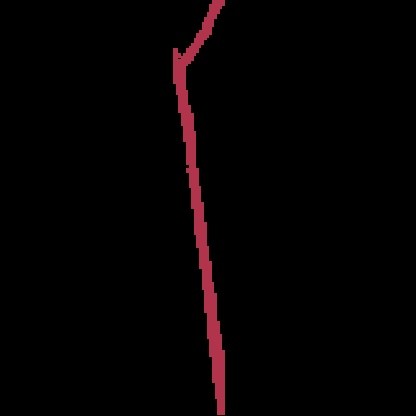

執行結果如下圖所示,算法執行時間為60.1768ms:

退出板卡環境,取回測試圖片:

exit adb pull /userdata/yolov11_seg_C_demo/yolov11_seg_demo_release/result.jpg . adb pull /userdata/yolov11_seg_C_demo/yolov11_seg_demo_release/mask_bgr.jpg .

測試結果如下圖所示:

至此,yolov11-seg實例分割例程已成功在板卡運行。

6. 資料下載

| 資料名稱 | 鏈接 |

| 算法訓練部署教程完整源碼包 |

https://pan.baidu.com/s/1tg1WbzMBeJqmKhxe2DXdMw?pwd=1234 提取碼:1234 |

審核編輯 黃宇

-

rk3576

+關注

關注

1文章

145瀏覽量

550

發布評論請先 登錄

米爾RK3576和RK3588怎么選?-看這篇就夠了

【米爾RK3576開發板評測】+項目名稱YOLOV5目標檢測

【米爾RK3576開發板評測】+項目名稱百度飛槳PP-YOLOE

RK3576 vs RK3588:為何越來越多的開發者轉向RK3576?

低功耗長續航,解鎖RK3576卓越性能

新品體驗 | RK3576開發板

RK3576單板發布倒計時:RK3399與RK3576對比

RK3588與RK3576區別解析

想學人工智能AI?我建議RK3576!

RK3576 Yolov11訓練部署教程

RK3576 yolov11-seg訓練部署教程

RK3576 yolov11-seg訓練部署教程

評論