如果企業希望充分發揮出 AI 的力量,就需要根據其行業需求量身定制的自定義模型。

NVIDIA AI Foundry 是一項使企業能夠使用數據、加速計算和軟件工具創建并部署自定義模型的服務,這些模型將為企業的生成式 AI 項目提供強力支持。

就像臺積電制造其他公司設計的芯片一樣,NVIDIA AI Foundry 為其他公司提供基礎設施和工具,使他們能夠使用 DGX Cloud、基礎模型、NVIDIA NeMo 軟件、NVIDIA 專業知識以及各種生態系統工具和支持,開發和自定義 AI 模型。

關鍵的區別在于產品:臺積電生產實體半導體芯片,而 NVIDIA AI Foundry 則幫助創建自定義模型。兩者都在推動創新,并與龐大的工具和合作伙伴生態系統相連接。

企業可以使用 AI Foundry 自定義 NVIDIA 模型和開放社區模型,包括新推出的 Llama 3.1 系列以及 NVIDIA Nemotron、Google DeepMind 的 CodeGemma、CodeLlama、Google DeepMind 的 Gemma、Mistral、Mixtral、Phi-3 和 StarCoder2 等。

行業領導者推動 AI 創新

行業領導者 Amdocs、Capital One、Getty Images、KT、現代汽車公司、SAP、ServiceNow 和 Snowflake 是 NVIDIA AI Foundry 的首批企業用戶。這些領軍企業正在企業軟件、技術、通信和媒體領域開辟一個由 AI 驅動創新的新時代。

ServiceNow AI 產品副總裁 Jeremy Barnes 表示:“部署 AI 的企業可以通過融合了行業和業務知識的自定義模型獲得競爭優勢。ServiceNow 正在使用 NVIDIA AI Foundry 微調和部署可以輕松集成到客戶現有的工作流中的模型。”

NVIDIA AI Foundry 的關鍵支柱

NVIDIA AI Foundry 的關鍵支柱包括基礎模型、企業軟件、加速計算、專家支持和龐大的合作伙伴生態系統。

這項服務的軟件包括來自 NVIDIA 和 AI 社區的 AI 基礎模型,以及能夠加速模型開發的完整 NVIDIA NeMo 軟件平臺。

NVIDIA AI Foundry 的計算核心是 NVIDIA DGX Cloud,該加速計算資源網絡由 NVIDIA 與全球公有云領軍企業亞馬遜云科技、谷歌云和 Oracle Cloud Infrastructure 共同設計。通過 DGX Cloud,AI Foundry 客戶能夠以前所未有的便捷和效率開發和微調自定義生成式 AI 應用,并根據需要擴展他們的 AI 項目,而無需在前期進行大量硬件方面的投入。這種靈活性對于希望在瞬息萬變的市場中保持靈活性的企業來說至關重要。

NVIDIA AI Enterprise 專家會在 AI Foundry 客戶需要時提供幫助。NVIDIA 專家可以指導客戶完成使用專有數據構建、微調和部署模型所需的各個步驟,確保模型貼合客戶的業務需求。

NVIDIA AI Foundry 客戶可以進入到一個全球合作伙伴生態系統,以獲得全方位的支持。埃森哲、德勤、Infosys、Wipro 等 NVIDIA 合作伙伴將為他們提供 AI Foundry 咨詢服務,涵蓋設計、實施和管理 AI 驅動的數字化轉型項目。埃森哲率先推出了基于 AI Foundry 的自定義模型開發產品——Accenture AI Refinery 框架。

另外,Data Monsters、Quantiphi、Slalom 和 SoftServe 等服務交付合作伙伴幫助企業解決將 AI 集成到現有 IT 環境中所遇到的復雜問題,確保 AI 應用的可擴展性、安全性和與業務目標的吻合性。

Cleanlab、DataDog、Dataiku、Dataloop、DataRobot、Domino Data Lab、Fiddler AI、New Relic、Scale、Weights & Biases 等 NVIDIA 合作伙伴還為客戶提供用于開發生產級 NVIDIA AI Foundry 模型的 AIOps 和 MLOps 平臺。

客戶可以將其 AI Foundry 模型導出為 NVIDIA NIM 推理微服務(包括自定義模型、優化引擎和標準 API),以便在其選擇的加速基礎設施上運行。

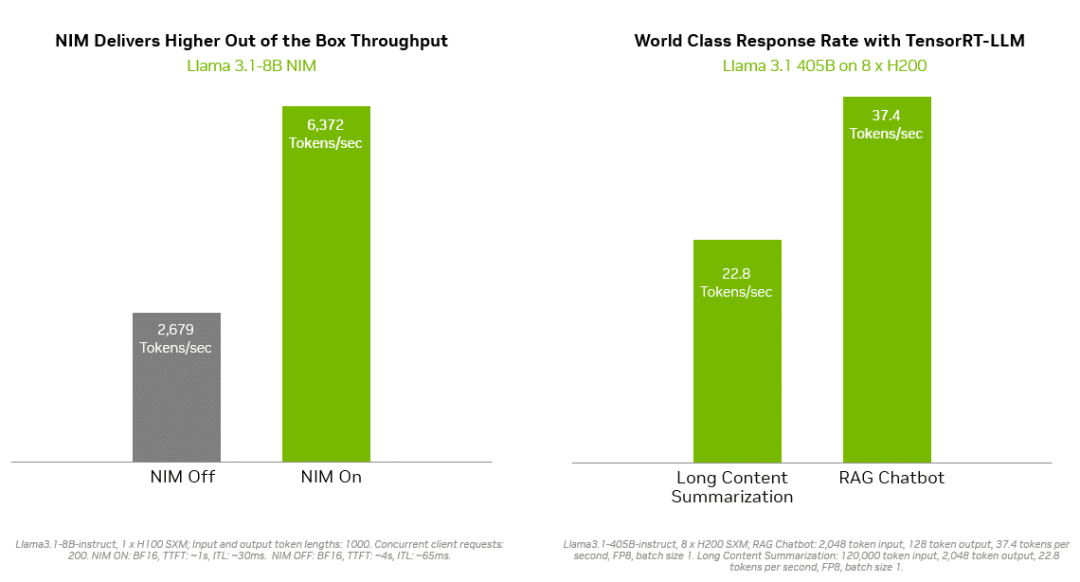

像 NVIDIA TensorRT-LLM 這樣的推理解決方案為 Llama 3.1 模型提供了更高的效率,以最大限度地減少延遲和最大限度地提高吞吐量。這使企業能夠更快地生成 token,同時降低在生產中運行模型的總成本。企業級的支持和安全性由 NVIDIA AI Enterprise 軟件套件提供。

NVIDIA NIM 和 TensorRT-LLM 最大限度地減少了 Llama 3.1 模型的推理延遲并最大限度地提高了吞吐量,從而更快地生成 token。

它們可部署在多種基礎設施上,包括思科、戴爾科技、慧與、聯想、超微等全球服務器制造合作伙伴的 NVIDIA 認證系統以及亞馬遜云科技、谷歌云和 Oracle Cloud 的云實例。

此外,領先的 AI 加速云平臺 Together AI 宣布,將讓其擁有超過 10 萬名開發者和企業的生態系統能夠使用 NVIDIA GPU 加速推理堆棧,在 DGX Cloud 上部署 Llama 3.1 端點和其他開放模型。Together AI 創始人兼首席執行官 Vipul Ved Prakash 表示:“每個運行生成式 AI 應用程序的企業都希望獲得更快的用戶體驗,使效率更高,成本更低。現在,使用 Together Inference Engine 的開發者和企業可以在 NVIDIA DGX Cloud 上最大化其性能、可擴展性和安全性。”

NVIDIA NeMo 加速并簡化

自定義模型開發

通過集成在 AI Foundry 中的 NVIDIA NeMo,開發者可以隨時使用所需的工具來整理數據、自定義基礎模型和評估性能。NeMo 將提供以下技術:

NeMo Curator:一個由 GPU 提供加速的數據管理庫,通過為預訓練和微調準備大規模、高質量的數據集,提高生成式 AI 模型的性能。

NeMo Customizer:一項高性能且可擴展的微服務,可簡化針對特定領域用例的 LLM 微調和對齊。

NeMo Evaluator:可在任何加速云或數據中心上,使用各種學術和自定義基準測試對生成式 AI 模型進行自動評估。

NeMo Guardrails:能夠編排對話管理,通過大語言模型提高智能應用的準確性、適當性和安全性,為生成式 AI 應用提供保障。

借助 NVIDIA AI Foundry 中的 NeMo 平臺,企業能夠創建出精準滿足其需求的自定義 AI 模型。這種定制化與戰略目標更加吻合,提高了決策的準確性以及運營的效率。例如企業可以開發出理解行業術語、符合監管要求并與現有工作流無縫集成的模型。

SAP 首席人工智能官 Philipp Herzig 表示:“作為我們合作的下一步,SAP 計劃使用 NVIDIA 的 NeMo 平臺,來幫助企業去加速由 SAP Business AI 驅動的 AI 生產力。”

企業可以通過 NVIDIA NeMo Retriever NIM 推理微服務將其自定義 AI 模型部署到生產中。它們可以幫助開發者獲取專有數據,然后通過檢索增強生成(RAG)為其 AI 應用生成知識淵博的回答。

Snowflake AI 主管 Baris Gultekin 表示:“安全、可信的 AI 是企業充分利用生成式 AI 的必要前提,而檢索的準確性直接影響到 RAG 系統中生成的回答的相關性和質量。通過 NVIDIA AI Foundry 中的 NeMo Retriever 組件,Snowflake Cortex AI 可以使用企業的自定義數據,進一步為企業提供簡單、高效和可信的回答。”

自定義模型為企業帶來競爭優勢

NVIDIA AI Foundry 的一大優勢是能夠解決企業在采用 AI 時所面臨的獨特挑戰。通用 AI 模型可能無法滿足特定的業務需求和數據安全要求,而自定義 AI 模型則具有出色的靈活性、適應性和性能,是企業獲得競爭優勢的理想途徑。

-

NVIDIA

+關注

關注

14文章

5241瀏覽量

105768 -

AI

+關注

關注

87文章

34198瀏覽量

275357 -

模型

+關注

關注

1文章

3486瀏覽量

49990

原文標題:NVIDIA AI Foundry 如何幫助企業打造自定義生成式 AI 模型

文章出處:【微信號:NVIDIA-Enterprise,微信公眾號:NVIDIA英偉達企業解決方案】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

如何添加自定義單板

為什么無法將自定義EfficientDet模型從TensorFlow 2轉換為中間表示(IR)?

如何快速創建用戶自定義Board和App工程

think-cell:自定義think-cell(四)

think-cell;自定義think-cell(一)

請問multisim怎么自定義元器件?

開發用于將四個ADC通道連接到MCU/MPU的自定義多通道SPI

Mistral AI與NVIDIA推出全新語言模型Mistral NeMo 12B

NVIDIA AI Foundry 為全球企業打造自定義 Llama 3.1 生成式 AI 模型

揭秘NVIDIA AI Workbench 如何助力應用開發

NVIDIA NeMo加速并簡化自定義模型開發

NVIDIA NeMo加速并簡化自定義模型開發

評論