作者:Bob Siller,Achronix半導體產品營銷總監

摘要:本文根據完整的基準測試,將Achronix Semiconductor公司推出的Speedster7t FPGA與GPU解決方案進行比較,在運行同一個Llama2 70B參數模型時,該項基于FPGA的解決方案實現了超越性的LLM推理處理。

采用 FPGA器件來加速LLM性能,在運行 Llama2 70B參數模型時,Speedster7t FPGA如何與 GPU解決方案相媲美?證據是令人信服的——Achronix Speedster7t FPGA通過提供計算能力、內存帶寬和卓越能效的最佳組合,在處理大型語言模型(LLM)方面表現出色,這是當今LLM復雜需求的基本要求。

像 Llama2這樣的 LLM的快速發展正在為自然語言處理(NLP)開辟一條新路線,有望提供比以往任何時候都更像人類的交互和理解。這些復雜的 LLM是創新的催化劑,推動了對先進硬件解決方案的需求,以滿足其密集處理需求。

我們的基準測試突出了 Speedster7t系列處理 Llama2 70B模型復雜性的能力,重點關注 FPGA和 LLM性能。這些測試(可根據要求提供結果)顯示了Achronix FPGA對于希望將LLM的強大功能用于其NLP應用程序的開發人員和企業的潛力。這些基準測試展示了 Speedster7t FPGA如何超越市場,提供無與倫比的性能,同時降低運營成本和環境影響。

Llama2 70B LLM運行在 Speedster7t FPGA上

2023年 7月,Microsoft和 Meta推出了他們的開源 LLM,Llama2開創了 AI驅動語言處理的新先例。Llama2采用多種配置設計,以滿足各種計算需求,包括 700億、130億和 700億個參數,使其處于 LLM創新的最前沿。Achronix和我們的合作伙伴 Myrtle.ai對700億參數的Llama2模型進行了深入的基準分析,展示了使用Speedster7t FPGA進行LLM加速的優勢。

基準測試結果:Speedster7t FPGA與業界領先的 GPU對比

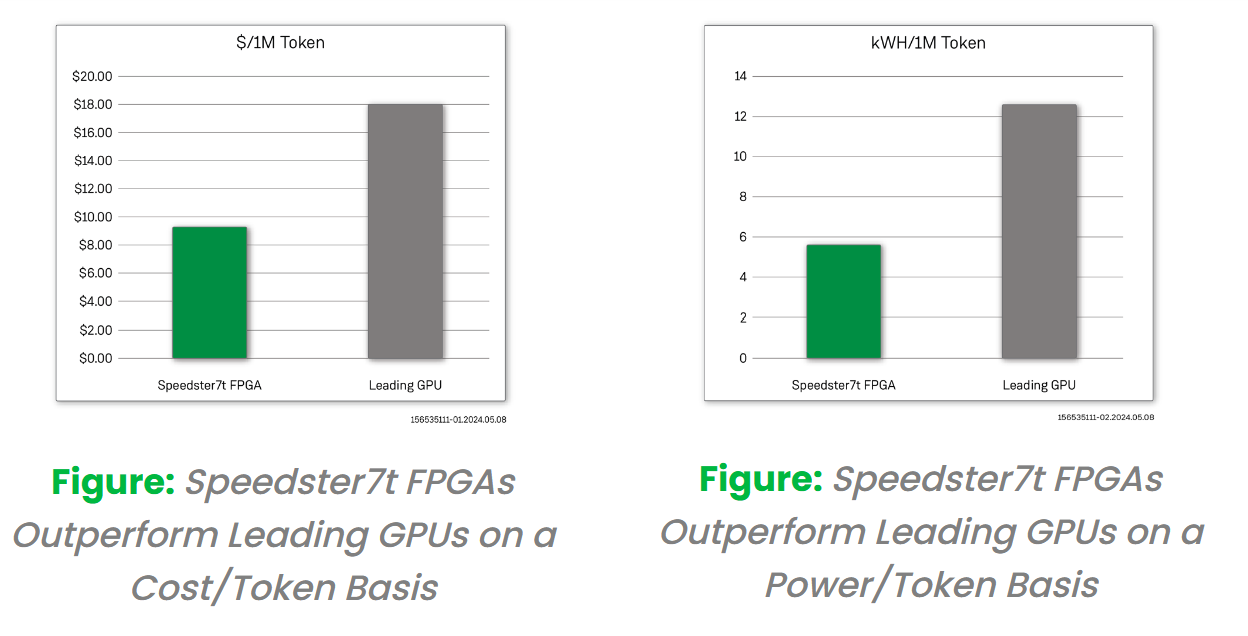

我們在 Speedster7t FPGA上測試了 Llama2 70B模型的推理性能,并將其與領先的 GPU進行了比較。該基準測試是通過對輸入、輸出序列長度(1,128)和批處理大小 =1進行建模來完成的。結果表明,Speedster7t AC7t1500在LLM處理中的有效性。

FPGA成本基于由 Speedster7t FPGA提供支持的 VectorPath加速卡的標價。同樣,我們在此分析中使用了可比GPU卡的標價。使用這些成本信息和每秒產生的輸出令牌數量,我們計算出基于 FPGA的解決方案的 $/token提高了 200%。除了成本優勢外,在比較 FPGA和 GPU卡的相對功耗時,我們觀察到與基于 GPU的解決方案相比,產生的 kWh/token提高了 200%。這些優勢表明 FPGA如何成為一種經濟且能效高效的 LLM解決方案。

面向 LLM的 FPGA:Speedster7t的優勢

Achronix Speedster7t系列FPGA旨在優化LLM操作,平衡LLM硬件的關鍵要求,包括:

高性能計算 –具有高性能計算能力的尖端硬件對于管理 LLM推理核心的復雜矩陣計算至關重要。

高帶寬內存 –高效的 LLM推理依賴于高帶寬內存,通過模型的網絡參數快速饋送數據,而不會出現瓶頸。

擴展和適應能力 –現代 LLM推理需要能夠隨著模型規模的增長而擴展并靈活適應 LLM架構的持續進步的硬件。

高能效處理 –可持續的 LLM推理需要硬件能夠最大限度地提高計算輸出,同時最大限度地降低能耗,從而降低運營成本和環境影響。

Speedster7t FPGA提供以下功能,以應對實施現代 LLM處理解決方案的挑戰:

計算性能–通過其靈活的機器學習處理器(MLP)模塊支持復雜的 LLM任務。

高 GDDR6 DRAM帶寬 –確保以 4 Tbps的內存帶寬快速處理大型 LLM數據集。

大量的 GDDR6 DRAM容量 –可容納 Llama2等擴展的 LLM,每個 FPGA的容量為 32 GB。

用于 LLM的集成 SRAM –提供低延遲、高帶寬的存儲,具有 190 Mb的 SRAM,非常適合存儲激活和模型權重。

多種本機數字格式 –適應 LLM需求,支持塊浮點(BFP)、FP16、bfloat16等。

高效的片上數據傳輸 – 2D NoC超過 20 Tbps,簡化片上數據流量。

擴展橫向擴展帶寬 –支持多達32個112 Gbps SerDes滿足 LLM需求,增強連接性。

自適應邏輯級可編程性 –使用 690K 6輸入 LUT為 LLM的快速發展做好準備。

針對 LLM推理優化的 FPGA

在快速變化的人工智能和自然語言處理領域,使用 FPGA而不是 GPU來加速 LLM是一個相當新的想法。該基準測試展示了設計人員如何從使用Achronix的FPGA技術中受益。Achronix Speedster7t系列FPGA是這一變化的關鍵技術,在高性能、高帶寬存儲器、易于擴展和電源效率之間實現了出色的平衡。

基于詳細的基準分析,將 Speedster7t FPGA與領先的 GPU在處理 Llama2 70B模型方面的能力進行比較,結果表明 Speedster7t FPGA能夠提供高水平的性能,同時大大降低運營成本和環境影響,突出了它在未來 LLM創建和使用中的重要作用。

如果希望進一步了解如何使用FPGA器件來加速您的LLM程序,以及 FPGA加速 LLM解決方案的未來發展機遇。請聯系Achronix,獲取詳細的基準測試結果,并幫助您確定Achronix FPGA技術如何加速您的LLM設計。

審核編輯 黃宇

-

FPG

+關注

關注

1文章

54瀏覽量

80310 -

大模型

+關注

關注

2文章

3135瀏覽量

4056

發布評論請先 登錄

大模型推理顯存和計算量估計方法研究

優化電機控制以提高能效

FPGA+AI王炸組合如何重塑未來世界:看看DeepSeek東方神秘力量如何預測......

安科瑞基站能耗監控解決方案,全面監控、分析和優化基站能效

當我問DeepSeek AI爆發時代的FPGA是否重要?答案是......

摩爾線程宣布成功部署DeepSeek蒸餾模型推理服務

中國電信發布復雜推理大模型TeleAI-t1-preview

新品| LLM630 Compute Kit,AI 大語言模型推理開發平臺

IGBT模塊在頗具挑戰性的逆變器應用中提供更高能效

FPGA和ASIC在大模型推理加速中的應用

解決方案丨EasyGo新能源系統實時仿真應用

AMD助力HyperAccel開發全新AI推理服務器

采用創新的FPGA 器件來實現更經濟且更高能效的大模型推理解決方案

采用創新的FPGA 器件來實現更經濟且更高能效的大模型推理解決方案

評論