據報道,3 月 7 日,AMD 正式宣布用戶可本地運行基于 GPT 的大規模語言模型 (LLM),打造專屬的AI聊天機器人。該動作,適用于采用全新 AMD XDNA NPU的Ryzen 7000及Ryzen 8000系列APU及內嵌AI加速器的Radeon RX 7000系列GPU。

AMD詳述運行步驟,如在搭載70億參數的Mistral機器上,需尋找并下載“TheBloke / OpenHermes-2.5-Mistral-7B-GGUF”;若選擇運行70億參數的LLAMA v2,須檢索并下載“TheBloke / Llama-2-7B-Chat-GGUF”。

值得注意的是,AMD并非首家推行此類舉措的廠商。據了解,近期英偉達(NVIDIA)亦推出了“Chat with RTX”人工智能聊天機器人,利用GeForce RTX 40與RTX 30系列GPU提供TensorRT-LLM功能集服務,根據本地化數據集快速生成AI結果。

-

amd

+關注

關注

25文章

5566瀏覽量

135916 -

語言模型

+關注

關注

0文章

558瀏覽量

10682 -

聊天機器人

+關注

關注

0文章

348瀏覽量

12713

發布評論請先 登錄

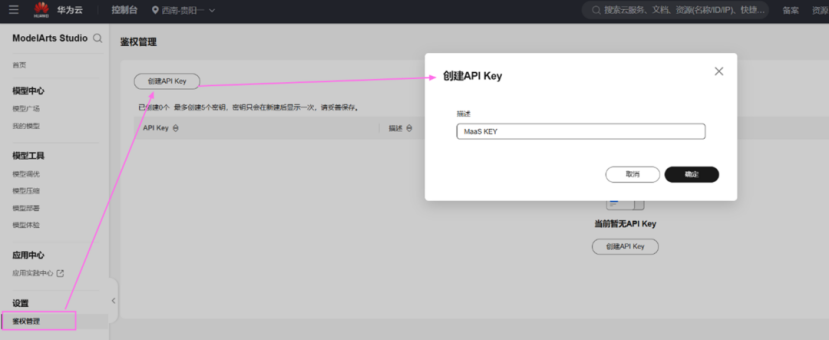

MaaS X Cherry Studio:基于DeepSeek API快速構建個人AI智能助手

首創開源架構,天璣AI開發套件讓端側AI模型接入得心應手

《AI Agent 應用與項目實戰》----- 學習如何開發視頻應用

OpenAI即將發布GPT-4.5與GPT-5

OpenAI即將推出GPT-5模型

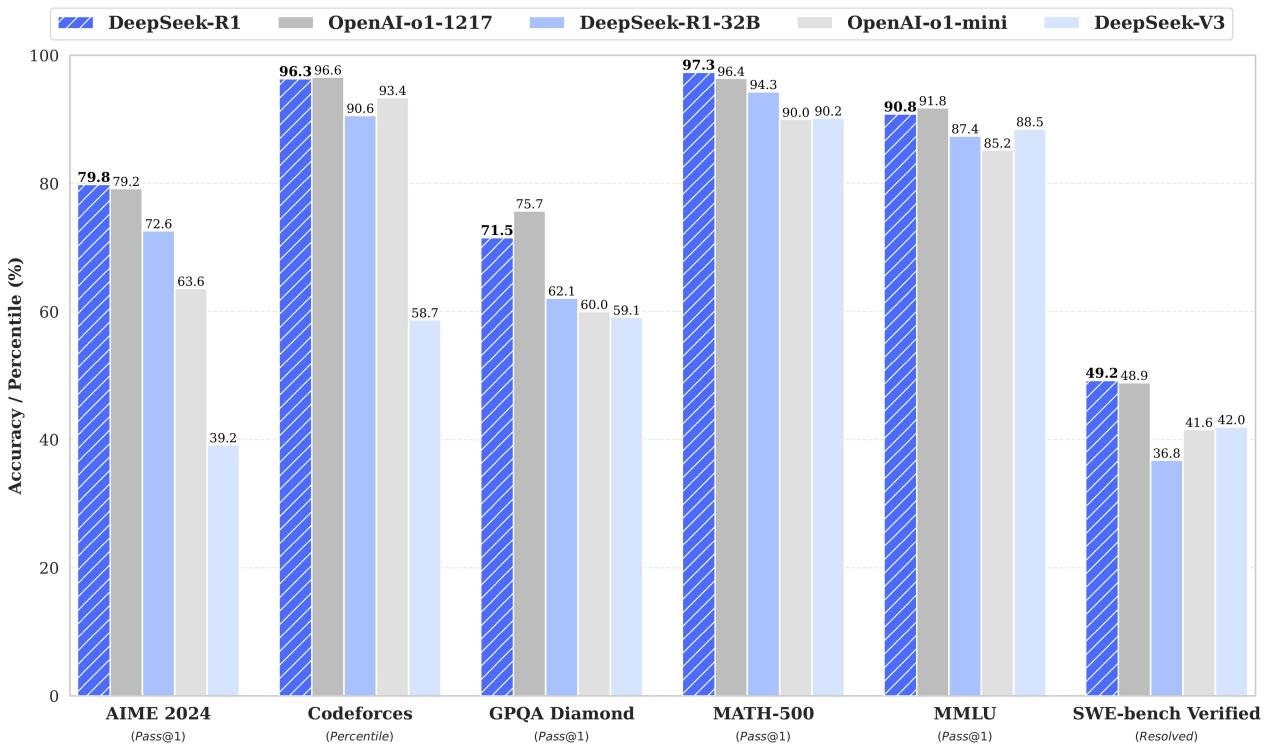

趕緊在本地運行與OpenAI-o1能力近似的DeepSeek-R1模型

AMD發布通知:用戶可本地運行GPT大語言模型,構建個人AI聊天助手

AMD發布通知:用戶可本地運行GPT大語言模型,構建個人AI聊天助手

評論