近日,OpenAI發(fā)布的基于Transformer架構(gòu)的文生視頻Sora,可謂是在AI圈掀起新的熱潮。該模型具有強(qiáng)大的視頻生成能力,可產(chǎn)生高達(dá)一分鐘的高清視頻,并且用戶可以自由指定視頻時(shí)間長度、分辨率和寬高比。據(jù)OpenAI的觀點(diǎn),Sora的誕生可能預(yù)示著物理世界通用模擬器的重大突破。

360集團(tuán)創(chuàng)始人兼董事長周鴻祎在2024年亞布力中國企業(yè)家論壇第二十四屆年會(huì)上分享了其對(duì)Sora模型的觀察。“Sora的推出預(yù)示AI視頻生成能力的突破,不僅推動(dòng)了AI的發(fā)展,而且為企業(yè)的未來指明新的發(fā)展方向。通用人工智能的發(fā)展可能未來兩三年內(nèi)就能實(shí)現(xiàn)。”

他鼓勵(lì)中國企業(yè)全面投身AI應(yīng)用和研究,挖掘AI潛力,以尋找業(yè)務(wù)和工作流程中可能實(shí)現(xiàn)效益提升的機(jī)會(huì)。建議大型互聯(lián)網(wǎng)公司應(yīng)在通用大模型領(lǐng)域持續(xù)加大投入,而企業(yè)家則應(yīng)構(gòu)建企業(yè)級(jí)、產(chǎn)業(yè)級(jí)、場景化的垂直大模型;呼吁所有企業(yè)在AI的發(fā)展過程中積極參與,以適應(yīng)和引領(lǐng)時(shí)代的變革。

周鴻祎對(duì)Sora模型的贊揚(yáng)不僅限于其出色的視頻生成能力,還深入到Sora模型的本質(zhì),強(qiáng)調(diào)其在模型理解世界的特別之處,解決了過去AI只能通過語言表達(dá)的局限,使得AI在認(rèn)知層面有了"眼睛"。

他還以Sora模型為例,總結(jié)了人工智能的五個(gè)發(fā)展階段:傳統(tǒng)AI,人機(jī)交互,機(jī)器對(duì)世界的理解(基本實(shí)現(xiàn)通用AI),強(qiáng)人工智能,以及如果AI能總結(jié)出像愛因斯坦相對(duì)論那樣的公式,就進(jìn)入超級(jí)人工智能階段。對(duì)于AI發(fā)展越來越快速的未來充滿了期待和信心。

本文將深入探討Sora文生視頻技術(shù)的原理,做一個(gè)全面的視頻大模型回顧及Sora與其他 AI 文本視頻模型性能對(duì)比,對(duì)SORA模型的算力空間進(jìn)行測算分析。讓我們一起深入研究這個(gè)令人振奮的主題。

附:Sora賬號(hào)一站式申請(qǐng)注冊(cè)全攻略

關(guān)鍵詞:Transformer;Sora;強(qiáng)人工智能;周鴻祎;AI服務(wù)器;A100;H100;A800;A100;算力空間;文本視頻大模型Sora;Sora大模型;Sora AI

OpenAI 發(fā)布文生視頻大模型 Sora

Sora文生視頻技術(shù)原理

Sora是一款基于文本生成視頻的新產(chǎn)品,被認(rèn)為是首個(gè)達(dá)到基礎(chǔ)模型等級(jí)品質(zhì)的影片生成模型。其高品質(zhì)的生成能力使其在影視娛樂、創(chuàng)作和廣告等領(lǐng)域有著巨大的應(yīng)用潛力。該模型的重要性在于它能夠根據(jù)簡單的文字描述生成各種類型的影片,包括電影預(yù)告片、寫實(shí)影片和虛擬影片,其品質(zhì)令人驚嘆。Sora的發(fā)布標(biāo)志著影片生成領(lǐng)域的一次革命,提供高度可控的模擬器,用于學(xué)習(xí)影片生成的各個(gè)方面,包括3D和4D的生成,以及物理性質(zhì)和材質(zhì)的模擬。技術(shù)上,Sora采用diffusion transformer模型,結(jié)合傳統(tǒng)的Summator和DALL-E模型,并使用recaptioning技術(shù)和大量的合成數(shù)據(jù)進(jìn)行訓(xùn)練。未來,Sora可能會(huì)面臨一些挑戰(zhàn),比如開源和產(chǎn)品端結(jié)合等,但它在影片生成領(lǐng)域的潛力是巨大的,對(duì)AR/VR/MR等領(lǐng)域也有著廣闊的應(yīng)用前景。

通過Sora,我們可以想象到一個(gè)新的世界,一個(gè)充滿無限可能性的世界。Sora的聯(lián)想力越豐富,就能夠產(chǎn)生更多、更豐富的時(shí)空碎塊,這將為影片生成領(lǐng)域帶來更多的創(chuàng)新和可能性。Diffusion作為一個(gè)畫師,根據(jù)關(guān)鍵詞特征值對(duì)應(yīng)的可能性概率,在視頻庫中尋找合適的素材,從而為Sora提供更多的靈感和創(chuàng)意。通過Diffusion和Transformer的共同聯(lián)想,Sora可以從巨大的視頻庫中生拉硬拽,將一張張碎塊拼接成一部完整的影片,每秒播放幾十張,呈現(xiàn)出令人驚嘆的效果。

Sora的超高生成能力與廣告界和娛樂領(lǐng)域的無窮可能性聯(lián)系緊密,不容忽視的是Sora創(chuàng)新融合藝術(shù)與技術(shù),致力于完美的光線追蹤渲染效果,使創(chuàng)意成為藝術(shù)家的畫布。揮灑自如的同時(shí),更要強(qiáng)調(diào)Sora的巨大突破,那就是其"超大的時(shí)長"能力,能夠連續(xù)生成高達(dá)一分鐘的高清視頻。在保持視角和風(fēng)格一致性的同時(shí),呈現(xiàn)的影片如同杰出藝術(shù)家在畫布上精心調(diào)色,呼之欲出。

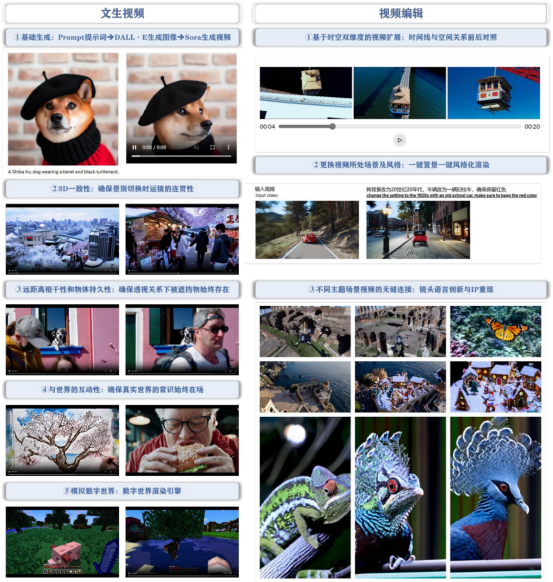

一、功能解讀

OpenAI發(fā)布的Sora視頻大模型主要具有生成視頻、編輯視頻以及從文本生成圖像三項(xiàng)核心功能。其中,從文本生成視頻和視頻編輯是其最主要的AI功能。這些功能通過確保“物理世界常識(shí)”始終存在,以實(shí)現(xiàn)通用模擬工具的作用。換言之,Sora利用其核心AI功能,為用戶提供一個(gè)能夠持續(xù)應(yīng)用物理世界常識(shí)的通用模擬工具。

1、文生視頻

Sora基于DALL·E圖像生成和視頻生成技術(shù),可根據(jù)用戶提示詞在一分鐘以內(nèi)生成各種分辨率和寬高比的視頻。其3D一致性確保每個(gè)連續(xù)鏡頭中,物體間的空間關(guān)系維持一致,符合物理邏輯。遠(yuǎn)距離的相干性和物體的持久性也在其中,即便在視角變化或物體被遮擋的情況下,被遮擋的物體仍能保持其存在。Sora精細(xì)呈現(xiàn)物體與世界的互動(dòng)性,無論是畫布上的筆跡還是食物上的咬痕都不會(huì)被忽視,以此確保與真實(shí)世界的交互始終真實(shí)有效。不僅如此,Sora還能模擬數(shù)字世界,例如像Minecraft這類的虛擬環(huán)境,展現(xiàn)出對(duì)實(shí)際世界和虛擬世界的雙重模擬能力,這讓Sora有望成為通用的世界模擬工具。

2、視頻編輯

Sora擁有時(shí)空視頻擴(kuò)展能力,能夠精準(zhǔn)分析視頻中的時(shí)間線和空間關(guān)系。其具有強(qiáng)大的場景和風(fēng)格改變能力,一鍵設(shè)置和風(fēng)格化渲染使視頻制作更為簡便。Sora甚至可以無縫連接不同主題的場景視頻,展現(xiàn)出創(chuàng)新的鏡頭語言和IP重組。值得一提的是,Sora能通過插值技術(shù),實(shí)現(xiàn)兩個(gè)截然不同主題和場景的視頻之間的平滑過渡,這為視頻創(chuàng)作提供無限可能。

3、掌控三維空間與視頻連貫性的物理引擎

Sora模型的一大亮點(diǎn)是其對(duì)三維空間中物體的運(yùn)動(dòng)和交互的連貫性和邏輯性的掌控。該模型通過直接處理大量訓(xùn)練視頻,無需預(yù)處理或調(diào)整,從而成功地學(xué)習(xí)物理世界建模。該技能使得Sora能生成在數(shù)字世界中的視頻,其中物體和角色在三維空間中的移動(dòng)和互動(dòng)都非常連貫,即使物體被遮擋或離開畫面,也能保持一致性。

從Sora到Lumiere等先進(jìn)的視頻模型,其關(guān)鍵性的轉(zhuǎn)變?cè)谟诓辉龠^度依賴空間關(guān)聯(lián),而是加強(qiáng)對(duì)時(shí)間關(guān)聯(lián)的理解。這些模型通過海量的視頻數(shù)據(jù)學(xué)習(xí)和表征狀態(tài)空間的動(dòng)態(tài)性并處理非馬爾可夫性。

然而,僅通過時(shí)間和空間的碎片往往無法理解底層規(guī)則,我們需要更深入的挖掘。科學(xué)家們可以將他們?cè)谖锢怼⒒瘜W(xué)、生物等領(lǐng)域的長期研究以圖像或視頻的形式輸入到這些視頻生成的大模型中,進(jìn)一步助力發(fā)掘潛在規(guī)律。

Sora的獨(dú)特之處在于將視頻生成模型泛化為物理引擎。如果我們能夠?qū)⑺蚅LM GPT整合并實(shí)時(shí)運(yùn)用,則可以接近或甚至達(dá)到人類感知的水平。然而,感知到概念的轉(zhuǎn)換需要處理好生成過程中的采樣和變分推斷。

Sora 功能一覽:文生視頻+視頻編輯,確保“物理世界常識(shí)”始終在場

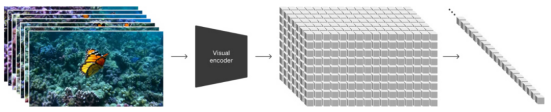

二、Spacetime Latent Patches 潛變量時(shí)空碎片, 建構(gòu)視覺語言系統(tǒng)

對(duì)視覺數(shù)據(jù)建模,Sora采用類似的Token Embedding策略,即通過高效且易于擴(kuò)展的視覺數(shù)據(jù)表示模型碎片(Patch),為各種類型的視頻和圖像提供精準(zhǔn)的表征。在這個(gè)過程中,視頻被壓縮并映射到一個(gè)低維的潛在變量空間,然后拆解成時(shí)空碎片。

在此基礎(chǔ)上,Sora展示了其多樣的能力:

1、理解自然語言

通過將DALLE3生成的視頻文本描述和GPT生成的豐富文本prompts結(jié)合,Sora在訓(xùn)練過程中確立與GPT之間更精準(zhǔn)的語言關(guān)系,使Token和Patch之間的“文字”達(dá)成統(tǒng)一。

2、將圖像和視頻作為prompts

用戶提供圖像或視頻可以被自然地編碼成時(shí)空碎片,以此進(jìn)行各種圖像和視頻編輯任務(wù),如生成動(dòng)態(tài)圖像、視頻生成擴(kuò)展、視頻連接或編輯等。

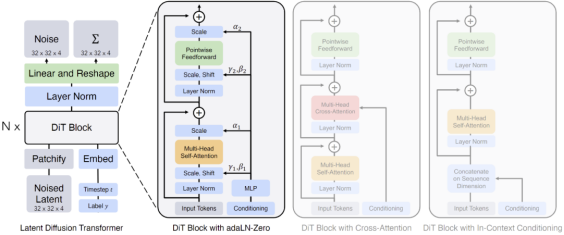

三、基于 Patches 視覺特征標(biāo)記的 Diffusion Transformer 模型

OpenAI將Sora定義為Diffusion Transformer,該概念源自伯克利的研究成果Diffusion Transformer (DiT),并以此作為Sora設(shè)計(jì)架構(gòu)的重要基礎(chǔ)。這項(xiàng)工作名為"采用Transformer的可擴(kuò)展擴(kuò)散模型Scalable diffusion models with transformers",在AI研究領(lǐng)域有著廣泛影響。

擴(kuò)散模型的核心工作原理包括在訓(xùn)練數(shù)據(jù)中添加高斯噪聲,然后學(xué)習(xí)反向去噪過程及恢復(fù)數(shù)據(jù)。當(dāng)訓(xùn)練完成后,模型通過已學(xué)習(xí)的去噪過程將隨機(jī)抽取的噪聲轉(zhuǎn)化為數(shù)據(jù)。在模型工作過程中,通過逐漸添加噪聲,使圖像向純高斯噪聲轉(zhuǎn)化。訓(xùn)練擴(kuò)散模型的目標(biāo)是學(xué)習(xí)逆向過程,進(jìn)而生成新數(shù)據(jù)。從信息熵角度看,原始的結(jié)構(gòu)化信息熵較低,通過多次添加高斯噪聲,信息熵會(huì)提高,逐漸掩蓋原始結(jié)構(gòu)信息。而在非結(jié)構(gòu)化部分,即使只添加少量噪聲也會(huì)使得信息變得混亂。學(xué)習(xí)目標(biāo)就是找到這些原始結(jié)構(gòu)化信息,可以理解為對(duì)“底片”的提取。

基本的擴(kuò)散模型在處理過程中,不進(jìn)行降維或壓縮,保持較高的還原度,其學(xué)習(xí)過程主要參數(shù)化概率分布并用KL散度來衡量概率分布之間的距離。而Diffusion Transformer(DiT)模型則引入Transformer,對(duì)信息進(jìn)行降維和壓縮,并采用多層多頭注意力和歸一化技術(shù),這使得它在擴(kuò)散方式下提取“底片”信息的原理與LLM的重整化保持一致。

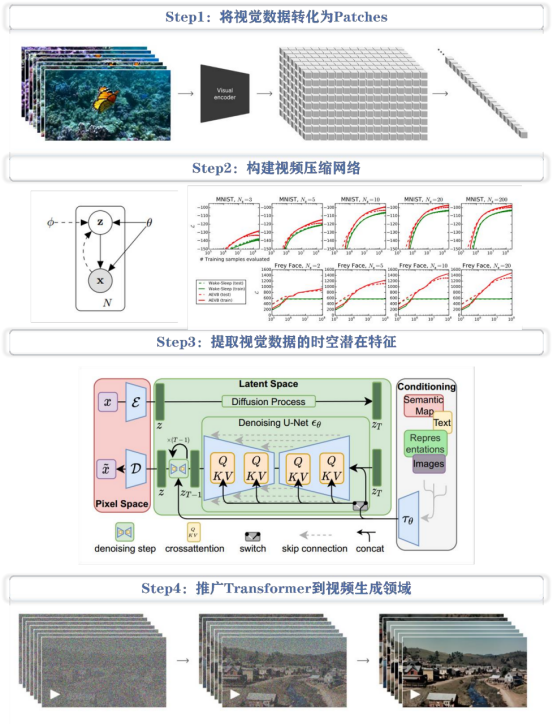

Sora是一個(gè)基于Patches視覺特征標(biāo)記的Diffusion Transformer模型,其靈感源自于有著統(tǒng)一的代碼、數(shù)學(xué)等自然語言文本模式的Tokens文本特征標(biāo)記。其核心包括以下四個(gè)步驟:

1、視覺數(shù)據(jù)轉(zhuǎn)化

將視覺數(shù)據(jù),如視頻和圖像,壓縮到低維潛在空間,并將其分解為帶有時(shí)空特征的Patches。

2、視頻壓縮網(wǎng)絡(luò)構(gòu)建

訓(xùn)練一個(gè)視頻壓縮網(wǎng)絡(luò),將原始視頻壓縮成潛在特征,并在此壓縮空間中進(jìn)行訓(xùn)練生成視頻。同時(shí),訓(xùn)練一個(gè)解碼器模型,將生成的潛在特征映射回像素空間。

3、提取視覺數(shù)據(jù)的時(shí)空潛在特征

從已壓縮的輸入視頻中提取時(shí)空特征Patches。因?yàn)閳D像可以被看做是單幀視頻,所以這個(gè)方案也適用于圖像。基于Patches的表達(dá)使Sora對(duì)不同分辨率、視頻時(shí)間和寬高比的視頻和圖像進(jìn)行訓(xùn)練,且在推理階段,可通過以正確大小的網(wǎng)格來排列隨機(jī)初始化的Patches控制生成視頻的大小。

4、推廣Transformer模型到視頻生成領(lǐng)域

Sora是一個(gè)Diffusion Transformer模型,接受輸入嘈雜Patches,通過訓(xùn)練預(yù)測原始干凈Patches,生成高清視頻。隨著訓(xùn)練計(jì)算量的增加,樣本質(zhì)量也有顯著提高。

Sora 技術(shù)路徑:基于 Patches 視覺特征標(biāo)記的 Diffusion Transformer 模型

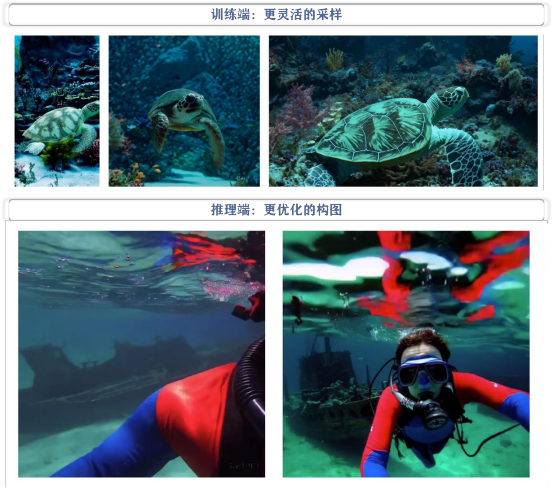

四、Patches 實(shí)現(xiàn)更靈活采樣+更優(yōu)化構(gòu)圖

Patches的使用提供更靈活采樣和更優(yōu)化視頻構(gòu)圖兩大優(yōu)勢。

1、訓(xùn)練角度

利用Patches進(jìn)行原生視頻采樣擴(kuò)大樣本規(guī)模并避免標(biāo)準(zhǔn)化樣本的步驟。在過去,處理不同分辨率和寬高比的視頻通常需要進(jìn)行剪輯或調(diào)整至標(biāo)準(zhǔn)格式。

2、推理角度

根據(jù)原生視頻訓(xùn)練模型在生成新視頻時(shí),其構(gòu)圖和取景更為優(yōu)化。舉例來說,采樣標(biāo)準(zhǔn)化樣本生成視頻在敘事主體部分被硬性分割開,而原生樣本生成視頻則保證敘事主體完整地出現(xiàn)在中間位置。

Why Patches?——更靈活的采樣+更優(yōu)化的構(gòu)圖

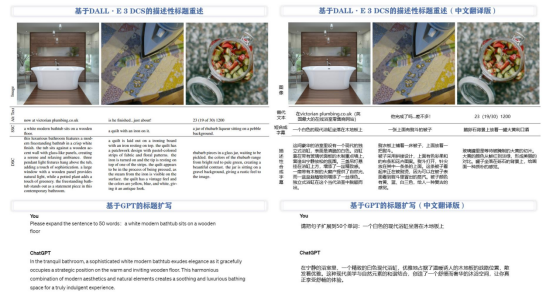

Sora通過結(jié)合DALL·E 3 DCS的描述性標(biāo)題重述和GPT標(biāo)題擴(kuò)寫方法,提高語言理解能力。為了訓(xùn)練文本到視頻的生成系統(tǒng),OpenAI使用DALL·E 3生成描述性的文本字幕,應(yīng)用于訓(xùn)練集中的所有視頻。同時(shí),OpenAI還使用GPT將用戶的短小提示轉(zhuǎn)化為更長、更詳細(xì)字幕,以提高視頻輸出質(zhì)量。簡言之,Sora通過利用DALL·E 3和GPT特性,實(shí)現(xiàn)對(duì)語言的深度理解和高質(zhì)量的視頻輸出。

基于 DALL·E 3 DCS 的描述性標(biāo)題重述與基于 GPT 的標(biāo)題擴(kuò)寫

五、Sora 有局限性,但未來可期

盡管 Sora 在模擬能力方面已經(jīng)取得了顯著的進(jìn)展,但它目前仍然存在許多局限性。例如,它不能準(zhǔn)確 地模擬許多基本相互作用的物理過程,如玻璃破碎等。此外,在某些交互場景中,比如吃東西時(shí),Sora 并不能總是產(chǎn)生正確的對(duì)象狀態(tài)變化,包括在長時(shí)間樣本中發(fā)展的不一致性或某些對(duì)象不受控的出現(xiàn)等。

我們相信隨著技術(shù)的不斷進(jìn)步和創(chuàng)新,Sora 所展現(xiàn)出的能力預(yù)示著視頻模型持續(xù)擴(kuò)展的巨大潛力。未來, 期待看到更加先進(jìn)的視頻生成技術(shù),能夠更準(zhǔn)確地模擬現(xiàn)實(shí)世界中的各種現(xiàn)象和行為,并為人們帶來更加逼真、自然的視覺體驗(yàn)。

現(xiàn)有視頻大模型對(duì)比

一、Runway-Gen2:綜合實(shí)力最強(qiáng)的文生視頻應(yīng)用,內(nèi)部訓(xùn)練數(shù)據(jù)集含2.4億張圖像和640萬個(gè)視頻剪輯

Gen2底層建立在擴(kuò)散模型之上,能夠支持包括文本到視頻、圖片到視頻和圖片+文字到視頻在內(nèi)的多種視頻生成方式。默認(rèn)情況下,Gen2可以生成4秒的視頻,但用戶可以通過輸入已生成的圖片來延長視頻的播放時(shí)長。此外,Gen2提供一系列參數(shù)調(diào)整功能,如基礎(chǔ)設(shè)置、攝像機(jī)運(yùn)動(dòng)以及運(yùn)動(dòng)畫刷,讓用戶可以實(shí)現(xiàn)更多的個(gè)性化配置。其中最亮眼的功能,便是Gen2能精細(xì)控制生成內(nèi)容的運(yùn)動(dòng)狀態(tài),甚至一鍵設(shè)置不同視頻風(fēng)格,為視頻創(chuàng)作提供了極大的便利性。

盡管Gen2具有諸多顯著的優(yōu)點(diǎn),但目前還存在一些不足之處。首先,Gen2的視頻幀率相對(duì)較低,導(dǎo)致其呈現(xiàn)效果更像是連續(xù)的PPT播放。其次,當(dāng)視頻內(nèi)容處在移動(dòng)狀態(tài)時(shí),圖片容易出現(xiàn)掉幀、模糊,甚至扭曲的現(xiàn)象。最后,從理解語義信息的角度來看,Gen2還有較大的提升空間,特別是在處理包含多元素提示詞時(shí),其能力相對(duì)較弱。盡管如此,對(duì)于Gen2來說,這些問題只是暫時(shí)的挑戰(zhàn),讓我們一起期待它未來的表現(xiàn)。

Gen2一鍵生成不同風(fēng)格圖像

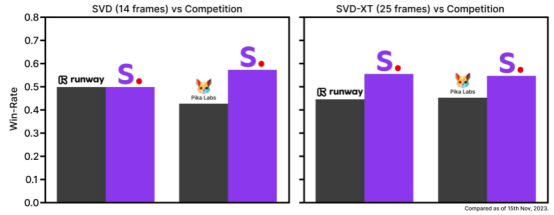

二、Stable Video Diffusion(SVD):開源文生視頻平臺(tái),Stability.AI基于Stable Diffusion的演進(jìn)

SVD模型不僅支持文本、圖像生成視頻,還支持多視角渲染和幀插入提升視頻幀率。用戶可以調(diào)整模型選擇、視頻尺寸、幀率及鏡頭移動(dòng)距離等參數(shù)。其由Stability.AI基于大規(guī)模數(shù)據(jù)集進(jìn)行多層訓(xùn)練,具備開源屬性和優(yōu)秀的圖像生成能力,是Stability.AI產(chǎn)品家族中的一員,形成完整的多模態(tài)解決方案。

SVD的天花板主要由于硬件性能要求較高,限制平常用戶使用。其支持的圖片尺寸較小,限制了它的應(yīng)用場景。此外,相機(jī)視角無法調(diào)節(jié),且生成視頻內(nèi)容的精細(xì)控制能力有待提升。生成的視頻清晰度和幀率也存在一些問題,表現(xiàn)在物體移動(dòng)過程中有明顯掉幀和形變。

盡管SVD與其他商用產(chǎn)品在幀率、分辨率、內(nèi)容控制、風(fēng)格選擇和視頻生成時(shí)長等方面存在差距,但其開源屬性和對(duì)大規(guī)模數(shù)據(jù)的有效利用構(gòu)成其獨(dú)特優(yōu)勢。

SVD與Runway2&Pika的比較

三、Pika:視頻版Mid-journey

Pika支持從文本、圖像和視頻生成視頻,時(shí)長默認(rèn)為3秒,分辨率為24幀。提供用于調(diào)整攝像機(jī)運(yùn)動(dòng)、視頻尺寸、幀數(shù)的參數(shù),并提供會(huì)員特權(quán)如增長視頻時(shí)長、提升分辨率和局部修改視頻等。Pika獨(dú)特之處在于其能產(chǎn)生背景穩(wěn)定的視頻,并能在視頻中添加元素,如為人物添加眼鏡等。

然而該模型在場景泛化和理解語義信息方面表現(xiàn)一般,例如無法正確區(qū)分“熊貓”和“貓”。此外,視頻運(yùn)鏡過程中可能出現(xiàn)掉幀現(xiàn)象,人物的審美展示以及肢體細(xì)節(jié)展現(xiàn)尚有不足。

與Runway Gen2和SVD相比,該模型在卡通風(fēng)格等特定場景下的表現(xiàn)突出,不過需要精準(zhǔn)的提示詞輸入,而且對(duì)泛化場景的處理能力較弱。

通過Pika給視頻中的人像添加墨鏡

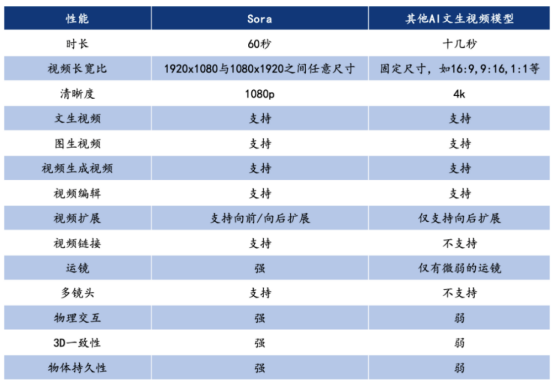

四、Sora 與其他 AI 文本視頻模型性能對(duì)比

Sora 與其他 Al 文生視頻模型性能對(duì)比

1、超長生成時(shí)間

Sora 支持 60s 視頻生成,而且一鏡到底,不僅主人物穩(wěn)定,背景中的人物表現(xiàn)也十分穩(wěn)定,可以從大中景無縫切換到臉部特寫。 在此之前,AI 視頻工具都還在突破幾秒內(nèi)的連貫性,即使是 Runway 和 Pika 這樣的“明星模型”,生成的視頻長度也僅有 3 到 4 秒,Sora 的時(shí)常可以說已經(jīng)達(dá)到了史詩級(jí)的記錄。

2、單視頻多角度鏡頭

Sora 可以在單個(gè)生成的視頻中創(chuàng)建多個(gè)鏡頭,模擬復(fù)雜的攝像機(jī)運(yùn)鏡,同時(shí)準(zhǔn)確地保持角色和視覺風(fēng)格。在 OpenAI 的展示視頻中一只狼對(duì)著月亮嚎叫,感到孤獨(dú),直到它找到狼群,多鏡頭無縫切換都保持了主體的一致。

3、理解物理世界

重要的是,Sora 不僅理解用戶在提示中要求的內(nèi)容,還能自己理解這些事物在現(xiàn)實(shí)世界中的存在方式。比如畫家在畫布上留下筆觸,或者人物在吃食物時(shí)留下痕跡。火車穿過東京郊區(qū),隨著車窗內(nèi)外光線環(huán)境和物體的變化,車窗上倒影的變化也幾乎被按照現(xiàn)實(shí)世界的物理規(guī)律完美還原了出來。而在技術(shù)方面,Sora 打破了此前擴(kuò)散模型局限性。Sora 采用的是 DALL·E3 的重標(biāo)注技術(shù),通過為視 覺訓(xùn)練數(shù)據(jù)生成詳細(xì)描述的標(biāo)題,使模型更加準(zhǔn)確地遵循用戶的文本指令生成視頻,還能夠?yàn)楝F(xiàn)有圖片賦予動(dòng)態(tài)效果或延伸視頻內(nèi)容的長度。

Sora模型算力空間測算

Sora模型性能強(qiáng)大,與其訓(xùn)練數(shù)據(jù)的高質(zhì)量和多樣性密切相關(guān)。通過大量吸取不同長度、分辨率和長寬比的視頻和圖像,Sora模型深度理解復(fù)雜的動(dòng)態(tài)過程,并且有能力生成多種類型的高質(zhì)量內(nèi)容。仿照大語言模型的訓(xùn)練方式,Sora模型將取樣多樣性應(yīng)用于視覺數(shù)據(jù),從而實(shí)現(xiàn)全面的視頻生成能力。

此外,Sora模型通過利用時(shí)空片段技術(shù)將多個(gè)視頻片段打包進(jìn)一個(gè)序列中,極大地提升視頻生成的效率。該方法讓模型更高效地學(xué)習(xí)大型數(shù)據(jù)集,從而提高生成高質(zhì)量視頻的能力,同時(shí)在計(jì)算資源使用上,相比其他模型架構(gòu),節(jié)省相當(dāng)多的資源。

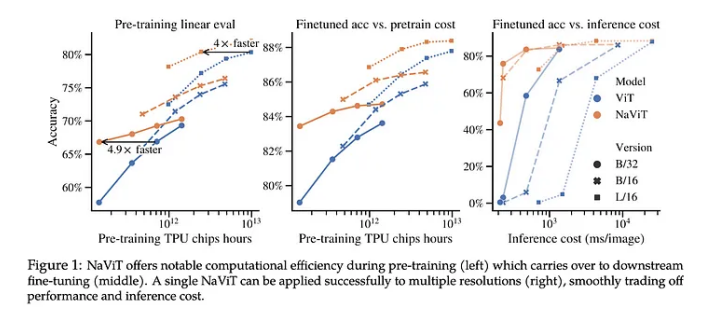

使用可變 patches 的 NaVit vs. 傳統(tǒng)的 Vision Transformers

一、SORA模型訓(xùn)練與傳統(tǒng)大模型的訓(xùn)練相比,為什么需要更多的算力?

SORA架構(gòu)需要處理訓(xùn)練數(shù)據(jù)種類比較多,包括文本、圖像以及視頻,各種類型數(shù)據(jù)都需要單獨(dú)的處理方式,分別進(jìn)行處理之后再進(jìn)行整合。圖像和視頻數(shù)據(jù)量大、復(fù)雜度高,特別消耗計(jì)算資源。例如,在處理圖像數(shù)據(jù)時(shí),每張圖片需要被分解成許多面元(patch),而這個(gè)過程需要大量的計(jì)算資源。

二、ChatGPT-3和SORA模型的訓(xùn)練參數(shù)和數(shù)據(jù)量有什么區(qū)別?

對(duì)比GPT-3與SORA模型,兩者在訓(xùn)練參數(shù)和數(shù)據(jù)量方面有許多不同。

1、訓(xùn)練參數(shù)

GPT-3和SORA的參數(shù)數(shù)量具有顯著差距。GPT-3已經(jīng)非常大,擁有1750億個(gè)參數(shù),而SORA模型對(duì)參數(shù)的需求更高。

2、訓(xùn)練數(shù)據(jù)

兩者存在較大差異。GPT-3主要使用各種網(wǎng)絡(luò)文本作為訓(xùn)練數(shù)據(jù),包括網(wǎng)頁、圖書、文章等等。而SORA模型則需要處理多種類型的訓(xùn)練數(shù)據(jù),包括文本、圖像以及視頻等。這意味著SORA在數(shù)據(jù)預(yù)處理以及訓(xùn)練過程中都需要做更多的工作。

總的來說,SORA模型在訓(xùn)練參數(shù)和數(shù)據(jù)量等方面都要比GPT-3更為復(fù)雜和龐大,需要更多計(jì)算資源。

三、SORA模型算力空間測算

Sora模型的出色性能與其訓(xùn)練數(shù)據(jù)的多樣性與質(zhì)量緊密相關(guān)。它吸納大量不同長度、分辨率及長寬比的影像與圖像,從而提升對(duì)復(fù)雜動(dòng)態(tài)過程的理解,并具備生成多種類型高質(zhì)量內(nèi)容能力。模仿大型語言模型訓(xùn)練方式,Sora模型將取樣多樣性應(yīng)用于視覺數(shù)據(jù),完成全面的視頻生成能力。

在效率方面,通過打包多個(gè)視頻片段進(jìn)一個(gè)序列中,Sora模型利用時(shí)空片段技術(shù)顯著提升視頻生成效率,既能高效學(xué)習(xí)大型數(shù)據(jù)集,又提高生成高質(zhì)量視頻的能力,節(jié)約了相較其他模型更多的計(jì)算資源。

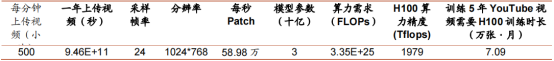

謝賽寧在《Scalable Diffusion Models with Transformers》一文中測算結(jié)果表明,Sora模型參數(shù)量約為30億,訓(xùn)練過去五年的YouTube所有視頻需要約7.09萬張H100運(yùn)算一個(gè)月時(shí)間。當(dāng)考慮到算力消耗,視頻生成目前可能表現(xiàn)為試用狀態(tài)。然而,未來技術(shù)優(yōu)化或降低算力需求,有利于視頻模型在推理應(yīng)用中的廣泛實(shí)施。

一文《An Image is Worth 16x16 Words Transformers for Image Recognition at Scale》中,一張圖片大約等同于256個(gè)詞,1分鐘視頻的生成大約需要超過一次文字問答的1000倍的算力。在預(yù)計(jì)訓(xùn)練期為10天的情況下,可能需要約368張英偉達(dá)H100顯卡才能滿足訓(xùn)練需求,展示訓(xùn)練頂級(jí)AI模型需求巨大的計(jì)算資源。

Sora模型將輸入圖像表示為16x16x3(3表示三原色)的數(shù)據(jù)塊,而每個(gè)數(shù)據(jù)塊實(shí)際上就是一串tokens。假設(shè)每張圖片的分辨率為1920x1080,每個(gè)視頻為30秒30FPS,那么patch的總大小約為3.73x10^16,可轉(zhuǎn)化為約有4.86x10^13個(gè)tokens的數(shù)量。

Transformer模型架構(gòu)參數(shù)量可能增加,假設(shè)SORA Transformer與ChatGPT-3相同,則可能需要約59500張英偉達(dá)H100顯卡才能滿足訓(xùn)練需求。這意味著,相較于目前的大語言模型,SORA的訓(xùn)練可能需要近百倍的算力。

模型訓(xùn)練算力需求測算

四、藍(lán)海大腦AI服務(wù)器:驅(qū)動(dòng)Sora模型訓(xùn)練的強(qiáng)大動(dòng)力

探討Sora等大規(guī)模深度學(xué)習(xí)模型訓(xùn)練,不可避免的話題便是AI服務(wù)器。尤其是在面臨如此龐大和復(fù)雜的訓(xùn)練任務(wù)時(shí),AI服務(wù)器重要性就尤為凸顯。

藍(lán)海大腦AI服務(wù)器是專為訓(xùn)練大規(guī)模深度學(xué)習(xí)模型而設(shè)計(jì)的專用服務(wù)器。平臺(tái)采用A100、H100、A800、H800、B200等GPU顯卡,為用戶提供高度并行化和分布式計(jì)算能力,以應(yīng)對(duì)大型神經(jīng)網(wǎng)絡(luò)的復(fù)雜訓(xùn)練任務(wù)。采用先進(jìn)的硬件加速器,如GPU(圖形處理單元)和TPU(張量處理單元),快速處理大規(guī)模數(shù)據(jù)集和復(fù)雜模型的訓(xùn)練過程。高效的任務(wù)調(diào)度和資源管理功能使用戶能夠輕松提交、監(jiān)控和管理訓(xùn)練作業(yè)。創(chuàng)新的液冷散熱技術(shù),不僅滿足靜音、高效、節(jié)能基礎(chǔ)需求,更在確保機(jī)器穩(wěn)定運(yùn)行的同時(shí),提升服務(wù)器算力,實(shí)現(xiàn)了高算力和高效散熱之間的完美結(jié)合。廣泛應(yīng)用于人工智能、自然語言處理、計(jì)算機(jī)視覺等領(lǐng)域。

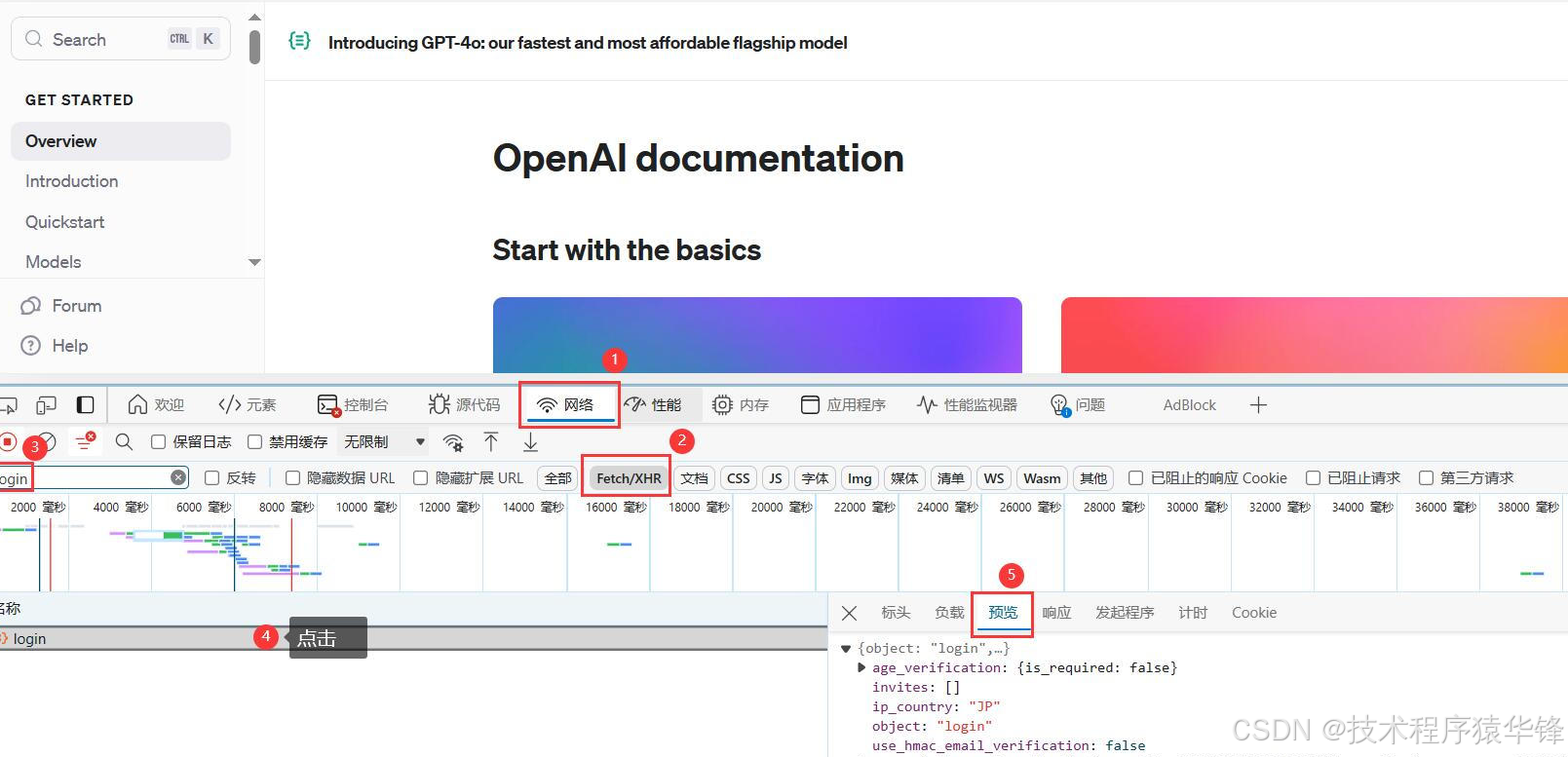

Sora一站式申請(qǐng)注冊(cè)流程

要想使用Sora,首先要確保您已經(jīng)注冊(cè)O(shè)penAI賬戶并升級(jí)到ChatGPT Plus,Sora目前仍處于早期訪問或測試階段,還沒有進(jìn)入公測階段,請(qǐng)耐心關(guān)注和等待。但是,據(jù)官方透露的消息,OpenAI近期大概率會(huì)宣布將Sora首批開放給Chatgpt Plus用戶申請(qǐng)使用。所以,請(qǐng)務(wù)必提前準(zhǔn)備好Chatgpt Plus。

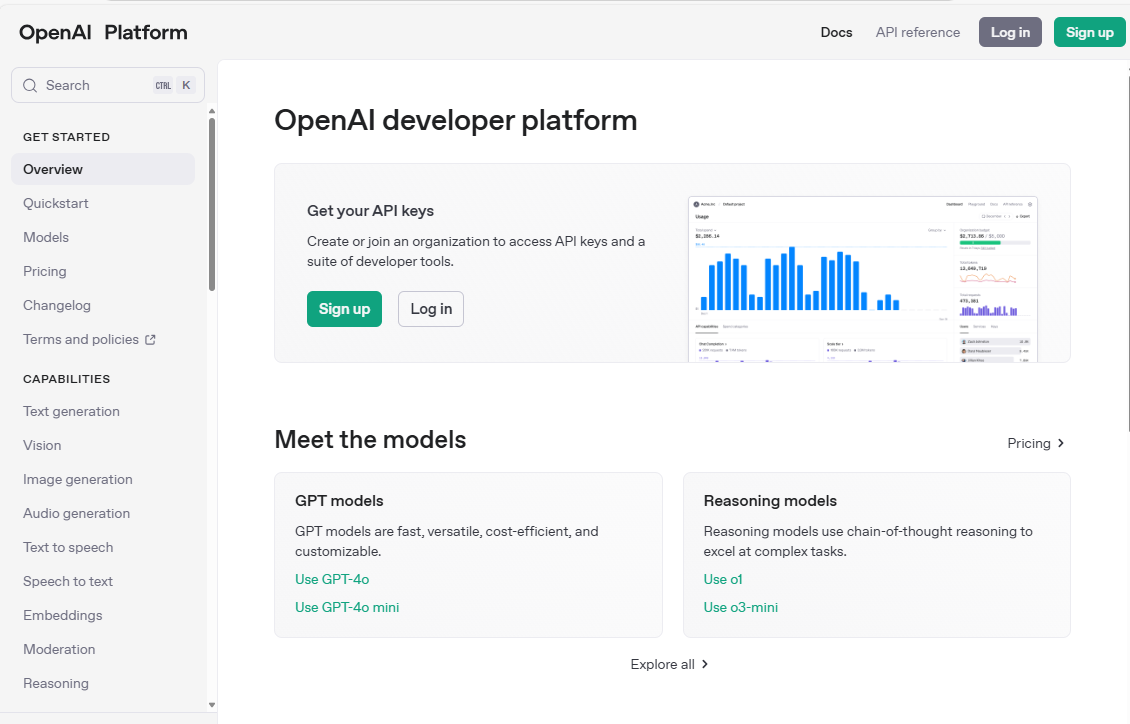

一、打開openAI的官網(wǎng):https://openai.com

二、點(diǎn)擊官網(wǎng)search按鈕:

三、輸入apply,點(diǎn)擊搜索

四、點(diǎn)擊Pages,選擇Red Teaming

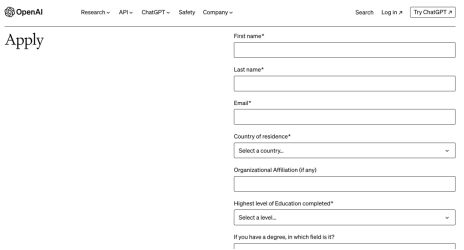

五、填寫表單

1.建議用英文填寫資料。

2.帶*是必填,如果自己不會(huì)寫,可以參考案例,注意輸入框有字?jǐn)?shù)限制,別超過,否則會(huì)顯示不全,影響申請(qǐng)。

3.參考下圖表單填寫:

4.整個(gè)頁面全是是英文,如果看不懂,用瀏覽器自帶的翻譯軟件即可,但回答不能是中文。

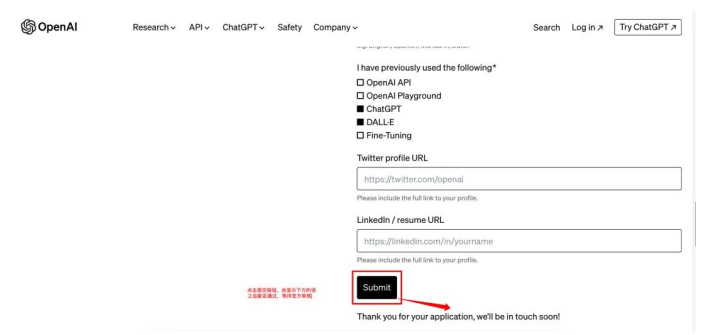

5.回答問題不知道選擇哪個(gè)答案,或者寫什么,用谷歌翻譯、百度翻譯,甚至可以直接問chatGPT得到答案。

6.回答“Why are you interested in joining the OpenAl Red TeamingNetwork?”參考示例:

Dear OpenAI Team,

I am reaching out with great enthusiasm for the opportunity to join OpenAI's Red Team. The idea of contributing to a group dedicated to rigorously testing and challenging AI models across various domains sparks immense excitement within me. My passion for joining OpenAI is driven by multiple facets, and I am confident in the value I can add to the team.

My conviction in the transformative power of AI fuels my desire to be part of this journey. I am deeply invested in exploring how AI can tackle challenges of inequality, aiming to foster a more just and equitable society. This ambition resonates with my core values and propels me to leverage my skills in this revolutionary field.

My interest in AI technology is not just a passing curiosity but a devoted pursuit. I've invested considerable time in understanding its fundamentals, which boosts my confidence in critiquing and evaluating AI models with clarity and depth.

Moreover, I am eager to bring a fresh perspective to OpenAI. My insights into the needs and concerns of my community equip me to contribute to the development of AI solutions that are not only innovative but also profoundly impactful.

Thank you for considering my application. I am eager to contribute to OpenAI's mission and be part of a team that stands at the forefront of AI research and application.

Best regards,

xxx xxx

7.回答“What do you think is an important area for OpenAl to be redteaming?”的參考示例:

I am convinced that a critical focus for OpenAI's red teaming efforts should be the exploration of the ethical and societal dimensions of AI technology. As AI becomes more pervasive and integral to different facets of daily life, it's imperative to conduct deep analyses of its impacts on individuals and entire communities. This scrutiny should cover the examination of biases and fairness within AI algorithms, address privacy issues, and consider the implications of job automation. Through meticulous red teaming in these domains, OpenAI has the opportunity to guide the development and implementation of AI technologies in a manner that is both ethical and responsible. Achieving this would not only cultivate trust and acceptance among the wider population but also ensure OpenAI's pioneering role in an era increasingly influenced by AI. Such proactive measures are crucial for navigating the evolving landscape where AI's influence on society is profound and far-reaching.

六、點(diǎn)擊submit按鈕

高性能計(jì)算群,聚焦算法、開發(fā)、科研及求職等話題。群里大咖云集,歡迎添加小助手微信18911232010,快快加入吧~

審核編輯 黃宇

-

AI

+關(guān)注

關(guān)注

87文章

34223瀏覽量

275369 -

OpenAI

+關(guān)注

關(guān)注

9文章

1201瀏覽量

8637 -

Sora

+關(guān)注

關(guān)注

0文章

83瀏覽量

425

發(fā)布評(píng)論請(qǐng)先 登錄

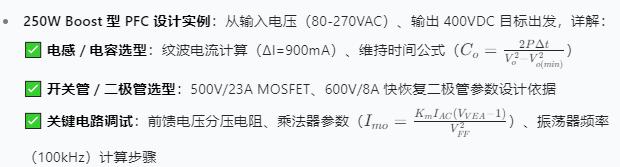

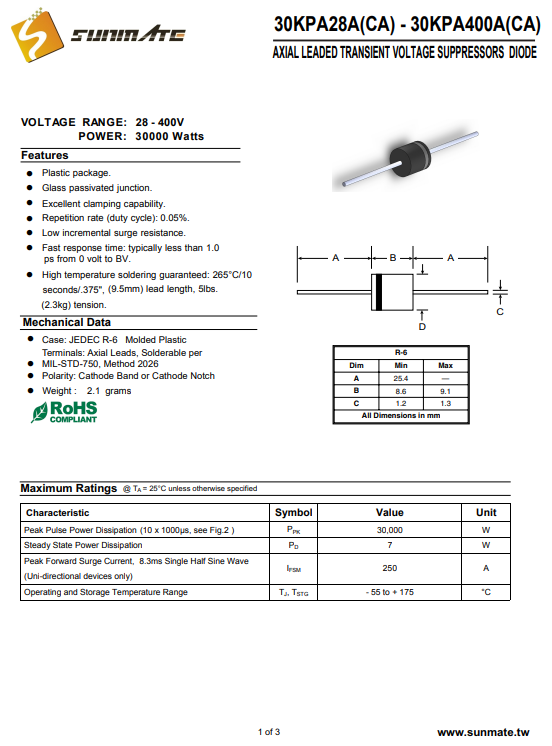

UC3854 功率因數(shù)校正設(shè)計(jì)全攻略:從理論到實(shí)戰(zhàn)

無感無刷直流電機(jī)驅(qū)動(dòng)全攻略

openai api key獲取的三種方案(有一種可以白嫖到 api key)

OpenAI API Key 獲取全攻略:入門、精通與詳解教程(國內(nèi)開發(fā)者優(yōu)化版)

7萬張H100打造的OpenAI文生視頻Sora功能原理詳解|Sora注冊(cè)全攻略

7萬張H100打造的OpenAI文生視頻Sora功能原理詳解|Sora注冊(cè)全攻略

評(píng)論