【新智元導(dǎo)讀】剛剛,我們經(jīng)歷了LLM劃時代的一夜。Gemini Ultra發(fā)布還沒幾天,Gemini 1.5就來了。卯足勁和OpenAI微軟一較高下的谷歌,開始進入了高產(chǎn)模式。

自家最強的Gemini 1.0 Ultra才發(fā)布沒幾天,谷歌又放大招了。

就在剛剛,谷歌DeepMind首席科學(xué)家Jeff Dean,以及聯(lián)創(chuàng)兼CEO的Demis Hassabis激動地宣布了最新一代多模態(tài)大模型——Gemini 1.5系列的誕生。

其中,最高可支持10,000K token超長上下文的Gemini 1.5 Pro,也是谷歌最強的MoE大模型。

不難想象,在百萬級token上下文的加持下,我們可以更加輕易地與數(shù)十萬字的超長文檔、擁有數(shù)百個文件的數(shù)十萬行代碼庫、一部完整的電影等等進行交互。

同時,為了介紹這款劃時代的模型,谷歌還發(fā)布了達58頁的技術(shù)報告。

毫不夸張地說,大語言模型領(lǐng)域從此將進入一個全新的時代!

1,000,000 token超超超長上下文,全面碾壓GPT-4 Turbo

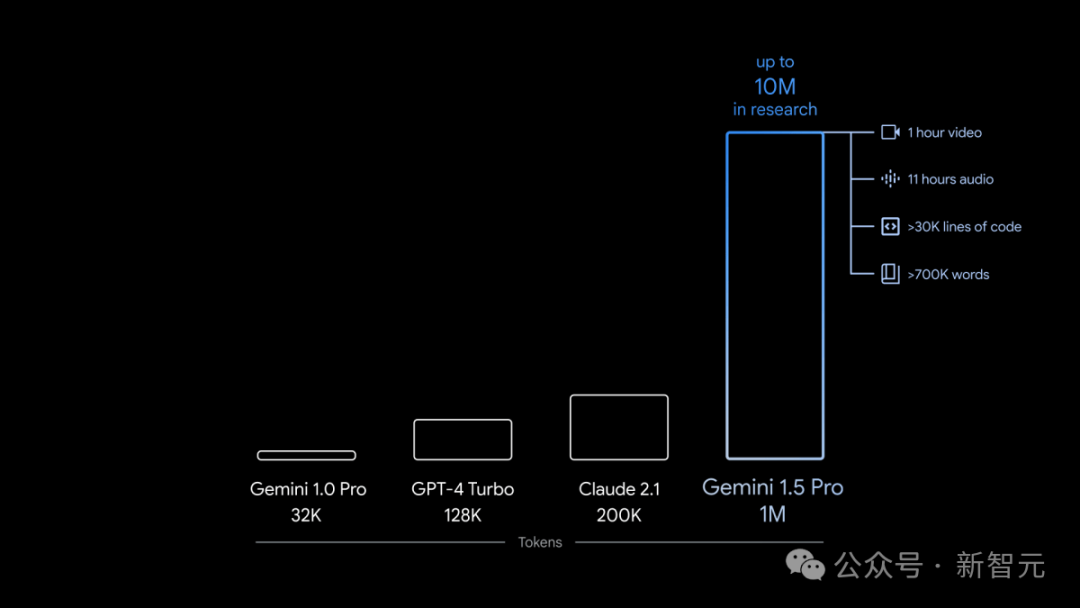

在上下文窗口方面,此前的SOTA模型已經(jīng)「卷」到了200K token(20萬)。

如今,谷歌成功將這個數(shù)字大幅提升——能夠穩(wěn)定處理高達100萬token(極限為1000萬token),創(chuàng)下了最長上下文窗口的紀錄。

1000萬token極限海底撈針幾乎全綠

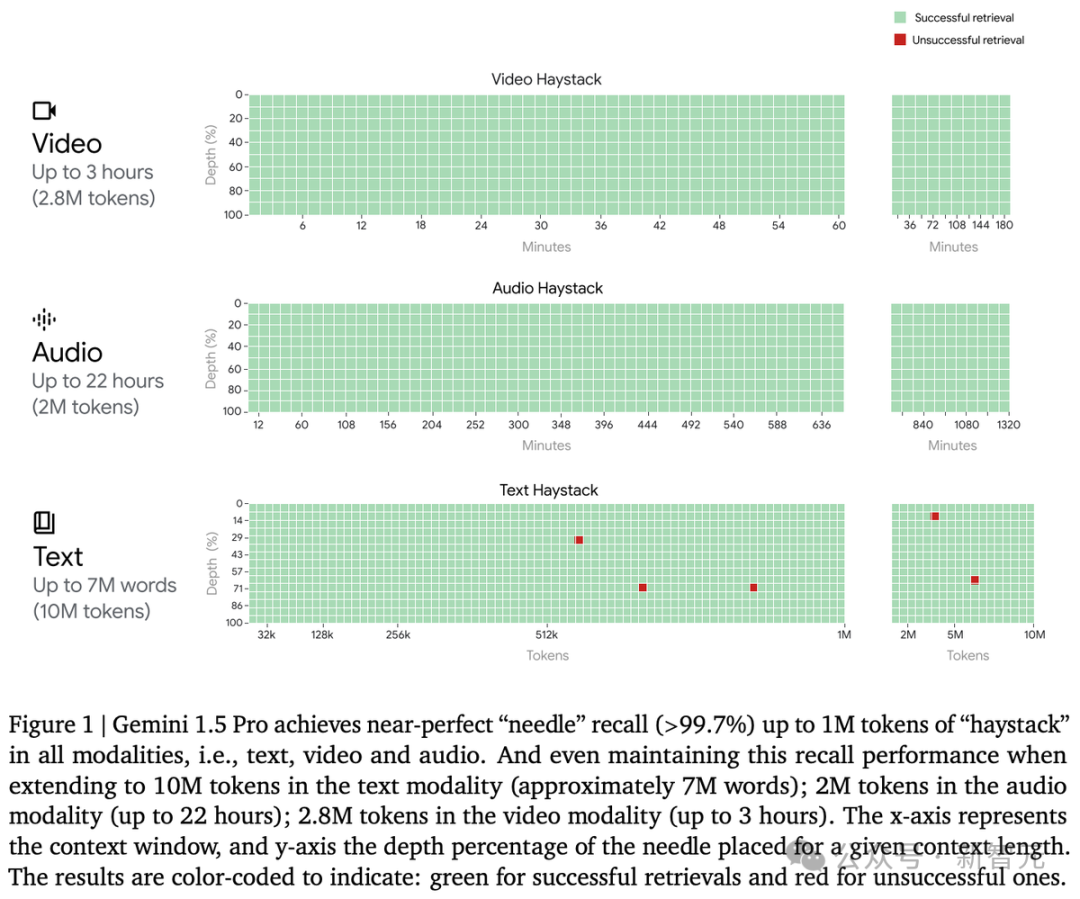

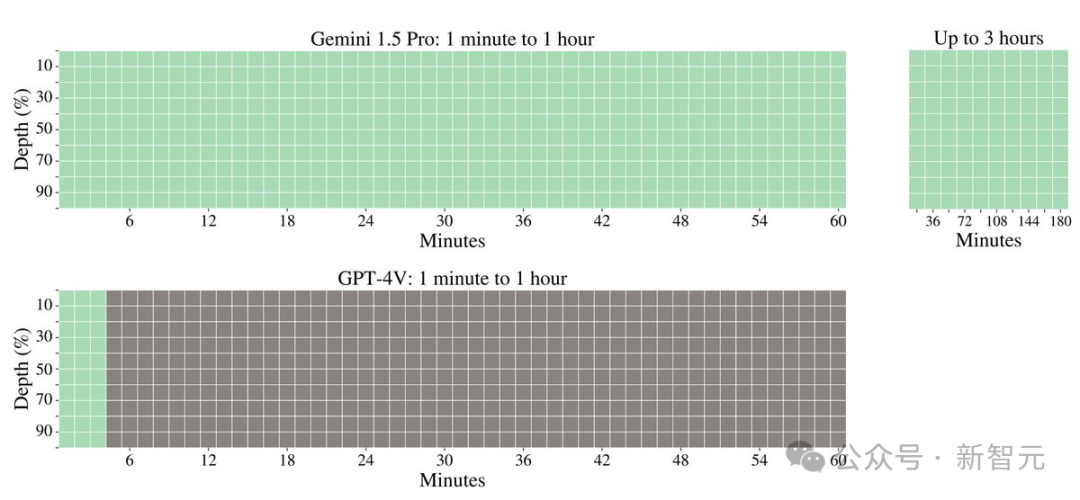

首先,我們看看Gemini 1.5 Pro在多模態(tài)海底撈針測試中的成績。

對于文本處理,Gemini 1.5 Pro在處理高達530,000 token的文本時,能夠?qū)崿F(xiàn)100%的檢索完整性,在處理1,000,000 token的文本時達到99.7%的檢索完整性。

甚至在處理高達10,000,000 token的文本時,檢索準(zhǔn)確性仍然高達99.2%。

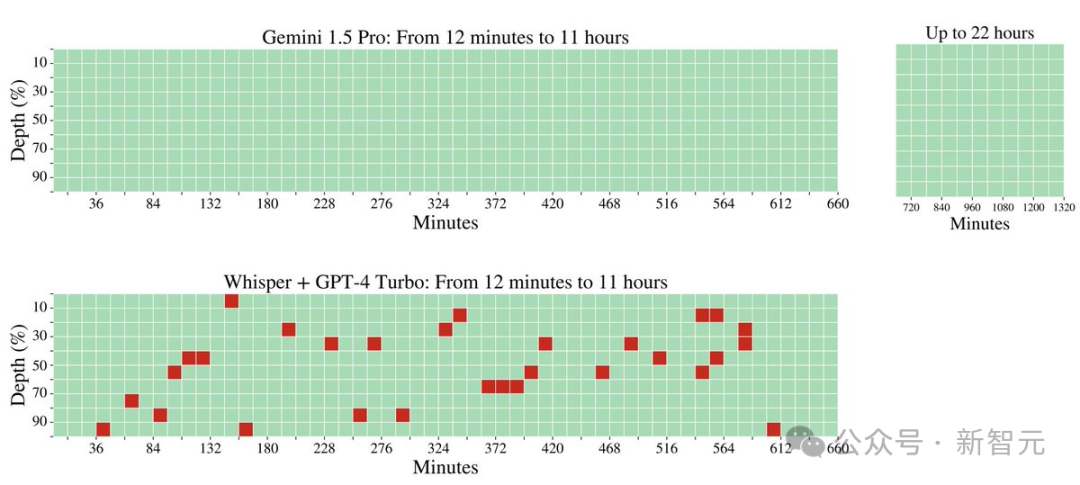

在音頻處理方面,Gemini 1.5 Pro能夠在大約11小時的音頻資料中,100%成功檢索到各種隱藏的音頻片段。

在視頻處理方面,Gemini 1.5 Pro能夠在大約3小時的視頻內(nèi)容中,100%成功檢索到各種隱藏的視覺元素。

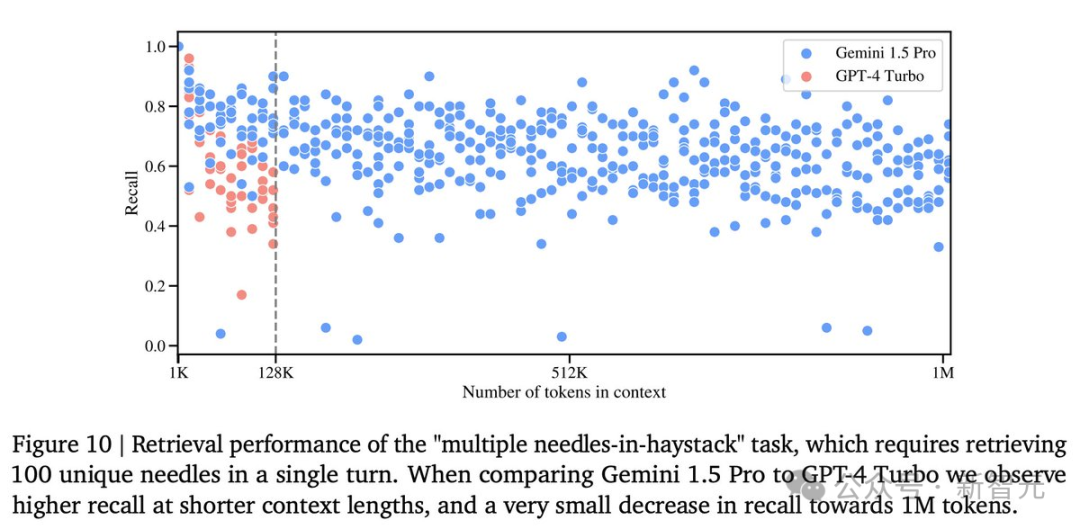

此外,谷歌研究人員還開發(fā)了一個更通用的版本的「大海撈針」測試。

在這個測試中,模型需要在一定的文本范圍內(nèi)檢索到100個不同的特定信息片段。

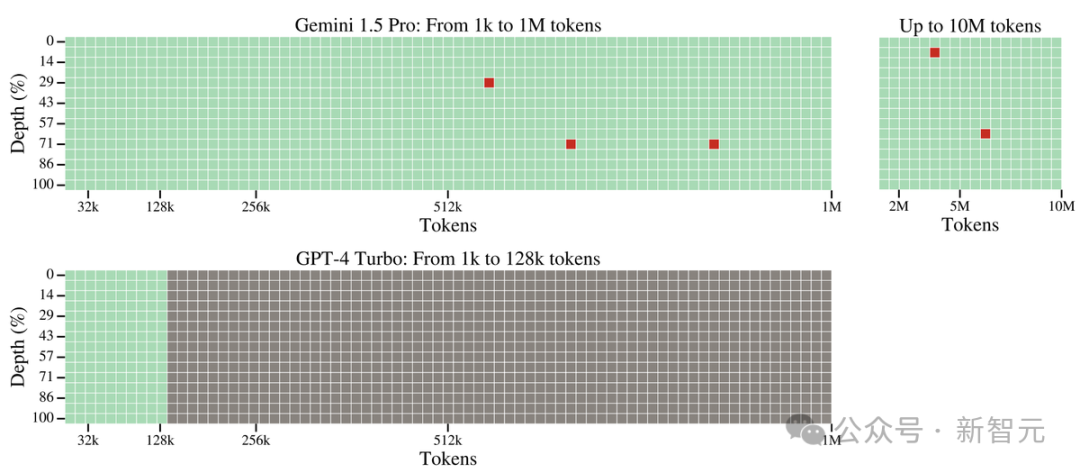

在這個測試中,Gemini 1.5 Pro在較短的文本長度上的性能超過了GPT-4-Turbo,并且在整個100萬token的范圍內(nèi)保持了相對穩(wěn)定的表現(xiàn)。

與之對比鮮明的是,GPT-4 Turbo的性能則飛速下降,且無法處理超過128,000 token的文本,表現(xiàn)慘烈。

大模型視野,被「史詩級」拓寬

LLM發(fā)展到這個階段,模型的上下文窗口已經(jīng)成為了關(guān)鍵的掣肘。

模型的上下文窗口由許多token組成,它們是處理單詞、圖像、視頻、音頻、代碼這些信息的基礎(chǔ)構(gòu)建。

模型的上下文窗口越大,它處理給定提示時能夠接納的信息就越多——這就使得它的輸出更加連貫、相關(guān)和實用。

而這次,谷歌通過一系列機器學(xué)習(xí)的創(chuàng)新,大幅提升了1.5 Pro的上下文窗口容量,從Gemini 1.0的原始32,000 token,直接提升到了驚人的1,000,000 token。

這就意味著,1.5 Pro能夠一次性處理海量信息——比如1小時的視頻、11小時的音頻、超過30,000行的代碼庫,或是超過700,000個單詞。

甚至,谷歌曾經(jīng)一度成功測試了高達10,000,000的token。

深入理解海量信息

脫胎換骨的Gemini 1.5 Pro,已經(jīng)可以輕松地分析給定提示中的海量內(nèi)容!

它能夠洞察文檔中的對話、事件和細節(jié),展現(xiàn)出對復(fù)雜信息的深刻理解。

我們甩給它一份阿波羅11號任務(wù)到月球的402頁飛行記錄,它對于多復(fù)雜的信息,都能表現(xiàn)出深刻的理解。

讓它從文件中列舉出3個喜劇性的時刻,接下來,就是見證奇跡的時刻——

才過了30秒出頭,答案就已經(jīng)生成了!

接下來,看看它的多模態(tài)功能。

把這張圖輸入進去,問它:這是什么時刻?

它會回答,這是阿姆斯特朗邁上月球的一小步,也是人類的一大步。

這次,谷歌還新增了一個功能,允許開發(fā)者上傳多個文件(比如PDF),并提出問題。

更大的上下文窗口,就讓模型能夠處理更多信息,從而讓輸出結(jié)果更加一致、相關(guān)且實用。

橫跨各種不同媒介

與此同時,Gemini 1.5 Pro還能夠在視頻中展現(xiàn)出深度的理解和推理能力!

得益于Gemini的多模態(tài)能力,上傳的視頻會被拆分成數(shù)千個畫面(不包括音頻),以便執(zhí)行復(fù)雜的推理和問題解決任務(wù)。

比如,輸入這部44分鐘的無聲電影——Buster Keaton主演的經(jīng)典之作《小神探夏洛克》。

模型不僅能夠精準(zhǔn)地捕捉到電影的各個情節(jié)和發(fā)展,還能洞察到極易被忽略的細微之處。

我們可以問它:找到一張紙從主角口袋中被拿出的瞬間,然后告訴我關(guān)于這個細節(jié)的信息。

令人驚喜的是,模型大約用了60秒左右就準(zhǔn)確地找出,這個鏡頭是在電影的12:01,還描述出了相關(guān)細節(jié)。

果然,模型精準(zhǔn)找出了這個鏡頭的時間點,所述細節(jié)也完全準(zhǔn)確!

輸入一張粗略的涂鴉,要求模型找到電影中的對應(yīng)場景,模型也在一分鐘內(nèi)找到了答案。

高效處理更長代碼

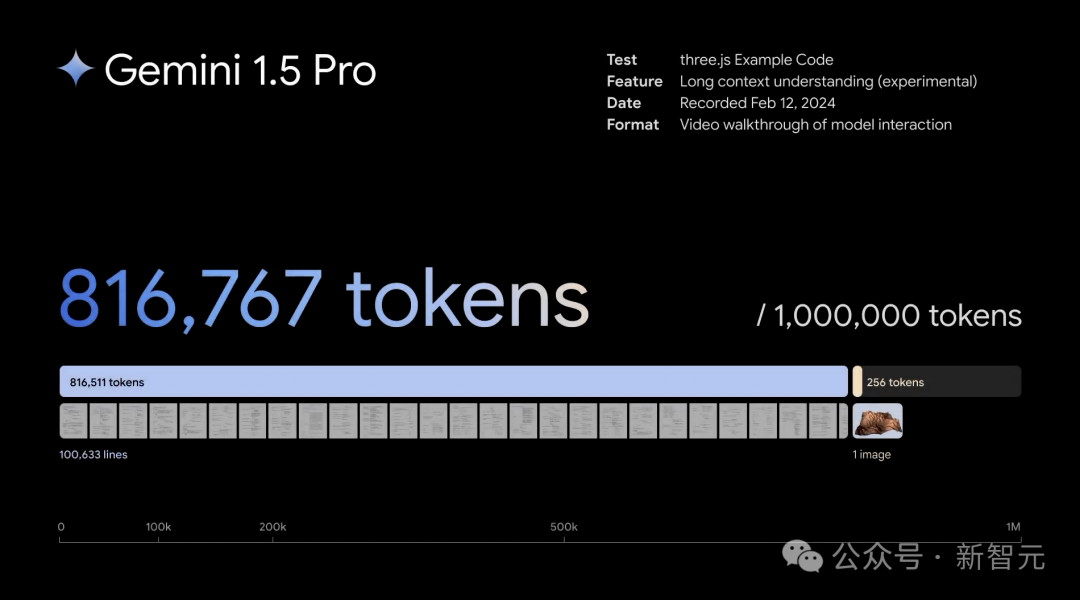

不僅如此,Gemini 1.5 Pro在處理長達超過100,000行的代碼時,還具備極強的問題解決能力。

面對如此龐大的代碼量,它不僅能夠深入分析各個示例,提出實用的修改建議,還能詳細解釋代碼的各個部分是如何協(xié)同工作的。

?

開發(fā)者可以直接上傳新的代碼庫,利用這個模型快速熟悉、理解代碼結(jié)構(gòu)。

?

高效架構(gòu)的秘密:MoE

Gemini 1.5的設(shè)計,基于的是谷歌在Transformer和混合專家(MoE)架構(gòu)方面的前沿研究。

不同于傳統(tǒng)的作為一個龐大的神經(jīng)網(wǎng)絡(luò)運行的Transformer,MoE模型由眾多小型的「專家」神經(jīng)網(wǎng)絡(luò)組成。

這些模型可以根據(jù)不同的輸入類型,學(xué)會僅激活最相關(guān)的專家網(wǎng)絡(luò)路徑。

這樣的專門化,就使得模型效率大幅提升。

而谷歌通過Sparsely-Gated MoE、GShard-Transformer、Switch-Transformer、M4研究,早已成為深度學(xué)習(xí)領(lǐng)域中MoE技術(shù)的領(lǐng)航者。

Gemini 1.5的架構(gòu)創(chuàng)新帶來的,不僅僅是更迅速地掌握復(fù)雜任務(wù)、保持高質(zhì)量輸出,在訓(xùn)練和部署上也變得更加高效。

因此,團隊才能以驚人的速度,不斷迭代和推出更先進的Gemini版本。

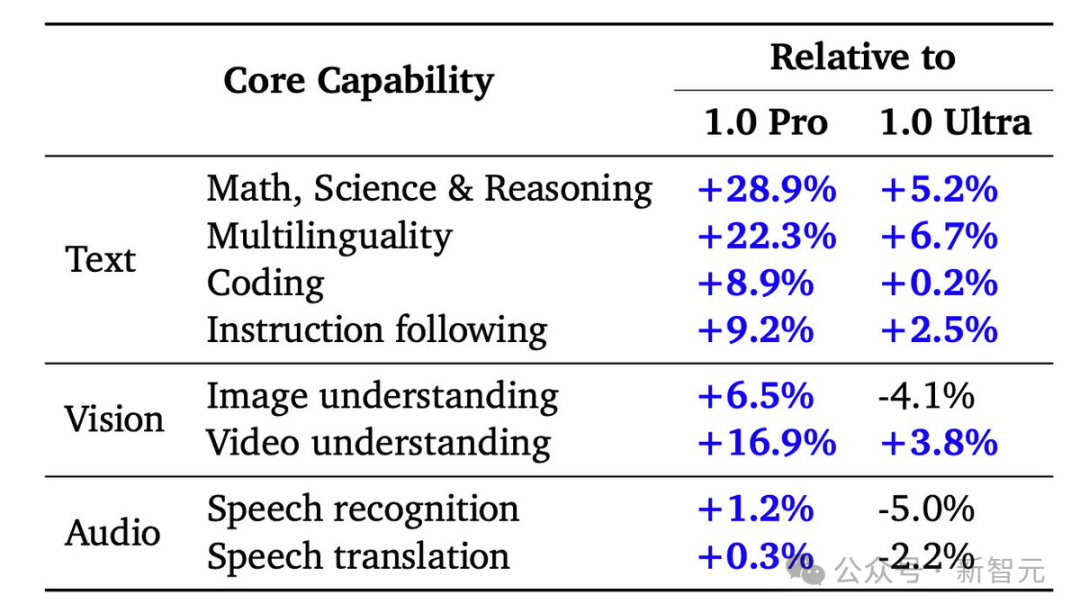

性能比肩Ultra,大幅超越1.0 Pro

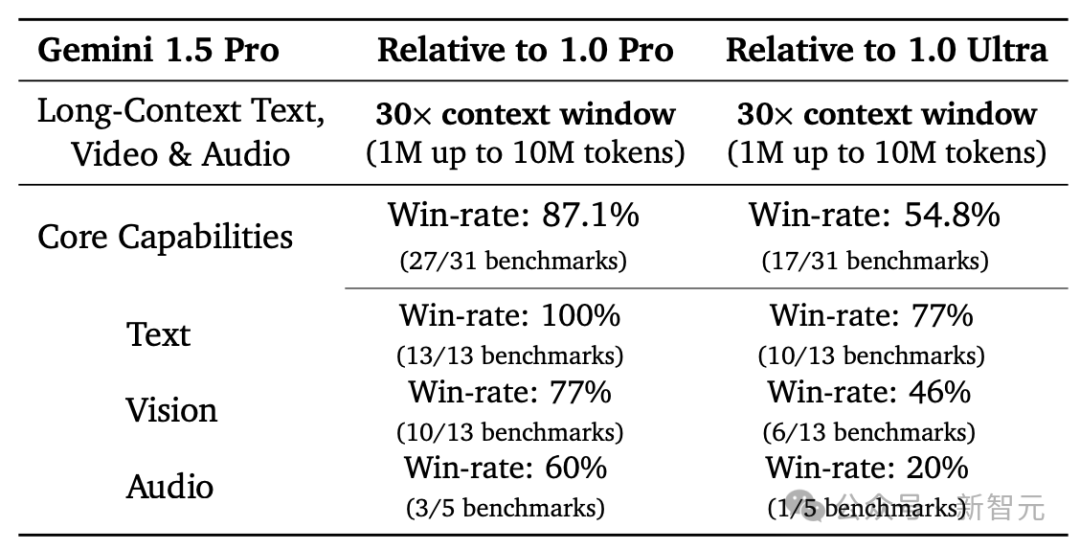

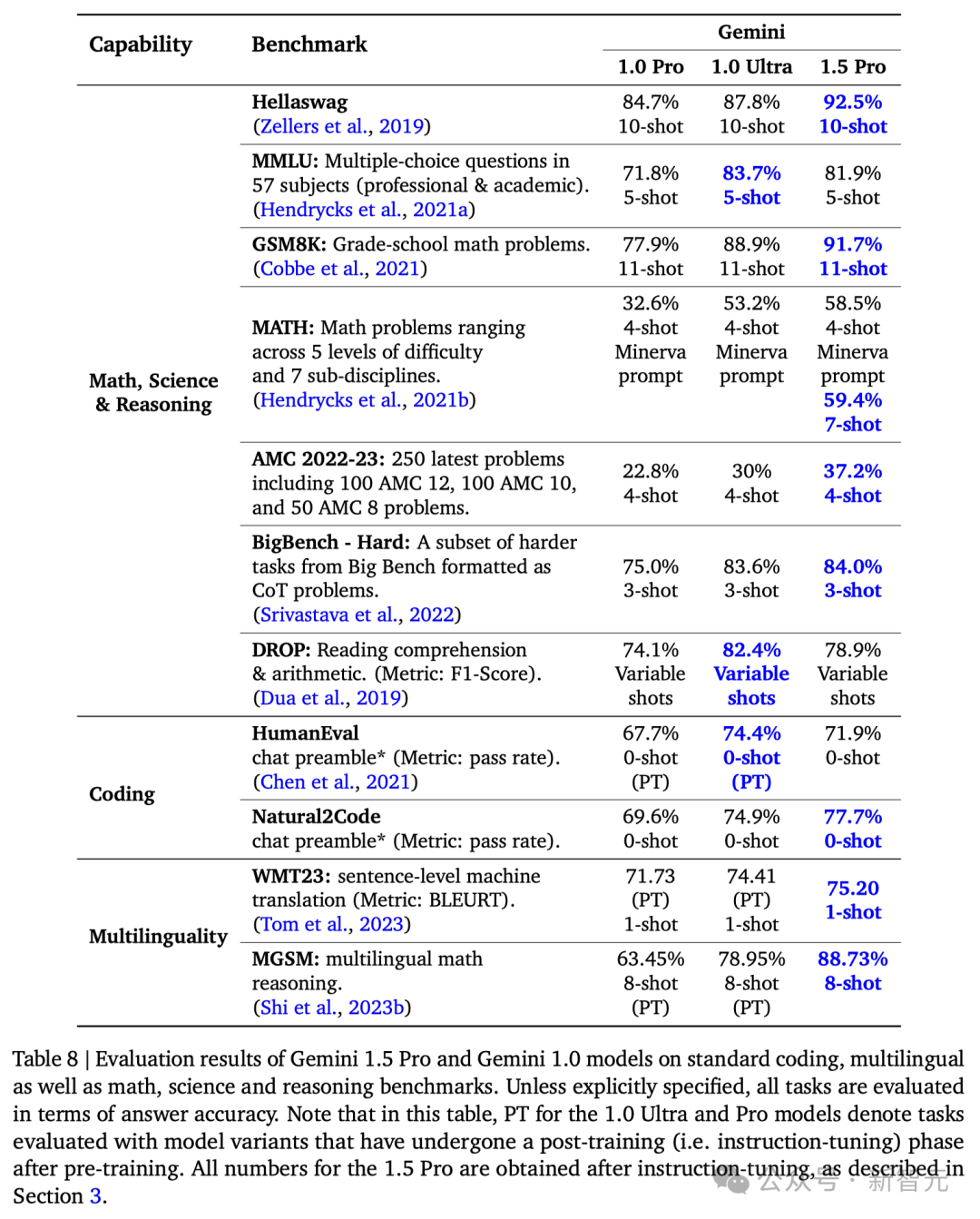

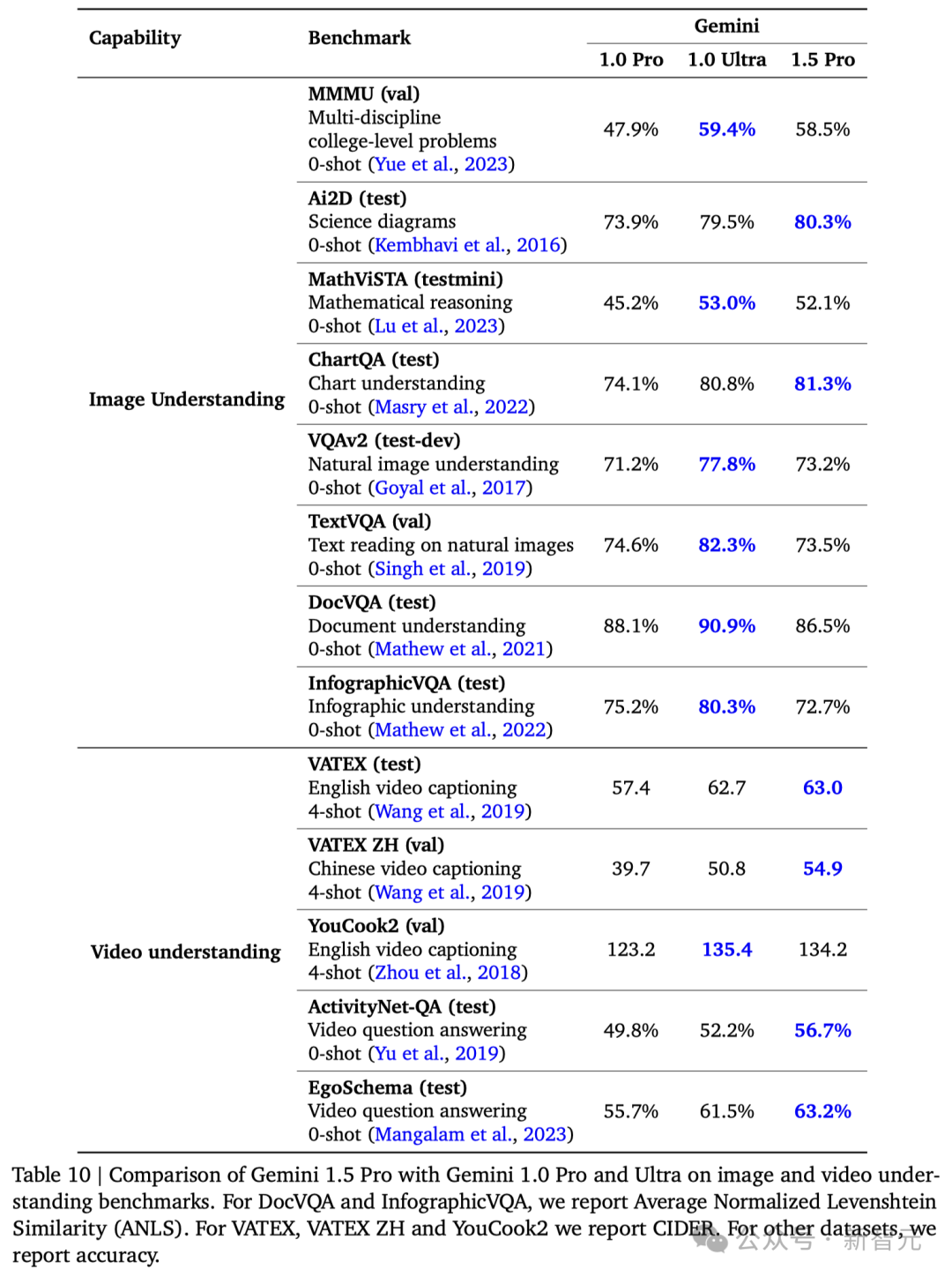

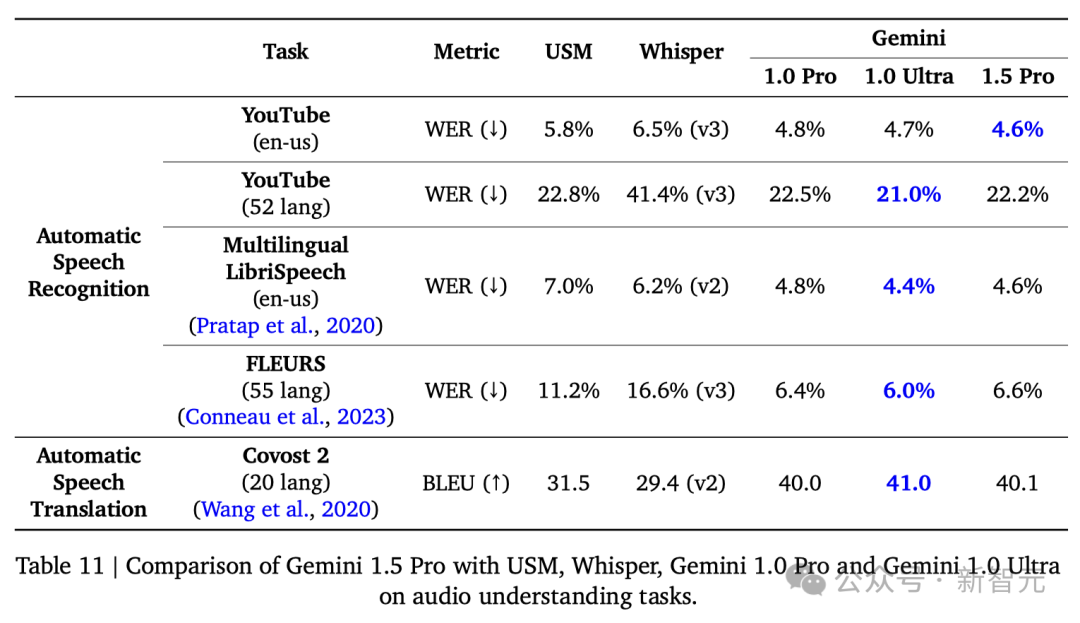

在涵蓋文本、代碼、圖像、音頻和視頻的綜合性測試中,1.5 Pro在87%的基準(zhǔn)測試上超越了1.0 Pro。

與1.0 Ultra在相同基準(zhǔn)測試的比較中,1.5 Pro的表現(xiàn)也相差無幾。

Gemini 1.5 Pro在擴大上下文窗口后,依然保持了高水平的性能。在「大海撈針(NIAH)」測試中,它能夠在長達100萬token的文本塊中,在99%的情況下,準(zhǔn)確找出隱藏有特定信息的文本片段。

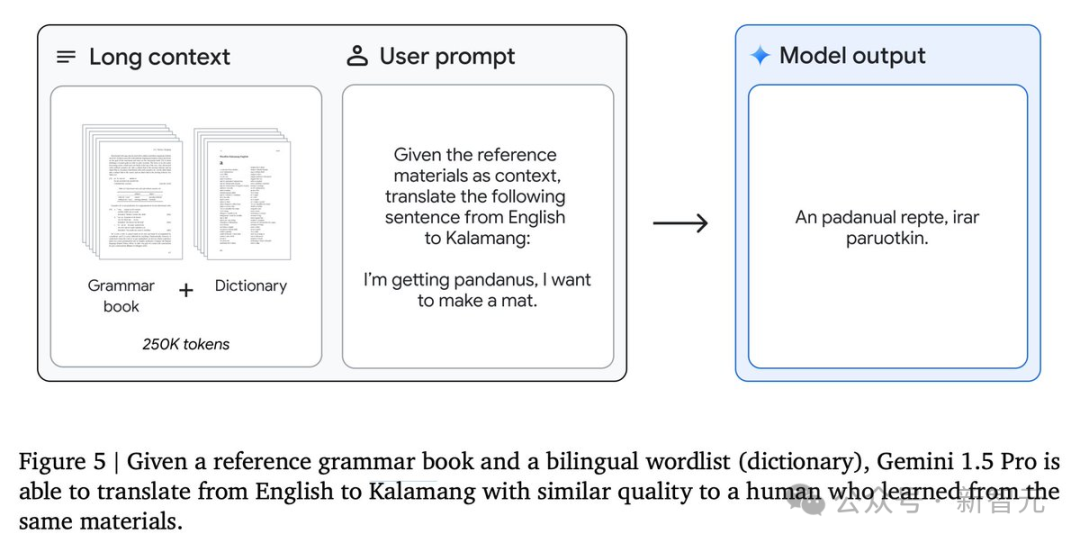

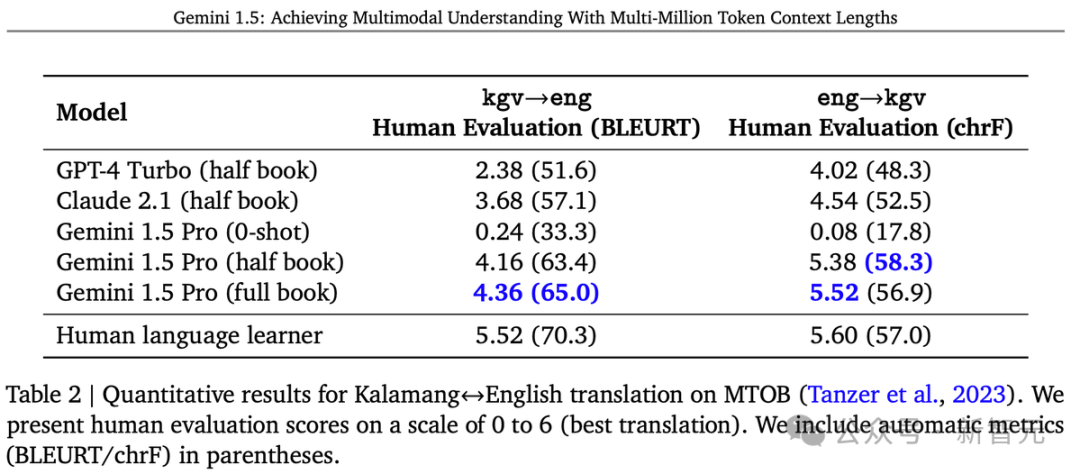

此外,Gemini 1.5 Pro展現(xiàn)了卓越的「上下文學(xué)習(xí)」能力,能夠僅憑長提示中提供的信息掌握新技能,無需進一步細化調(diào)整。

這一能力在「從一本書學(xué)習(xí)機器翻譯 (MTOB)」基準(zhǔn)測試中得到了驗證,該測試檢驗了模型學(xué)習(xí)從未接觸過的信息的能力。

對于一本關(guān)于全球不足200人使用的Kalamang語的語法手冊,模型能夠?qū)W會將英語翻譯成Kalamang,學(xué)習(xí)效果與人類學(xué)習(xí)相似。

谷歌的研究者成功地增強了模型處理長文本的能力,而且這種增強并沒有影響到模型的其他功能。

雖然這項改進只用了Gemini 1.0 Ultra模型訓(xùn)練時間的一小部分,但1.5 Pro模型在31項性能測試中的17項上超過了1.0 Ultra模型。

與1.0 Pro模型相比,1.5 Pro在31項測試中的27項上,表現(xiàn)更佳。

具體結(jié)果如下:

細節(jié)表現(xiàn)如何?

分析和掌握復(fù)雜代碼庫

這款模型能夠迅速吸收大型代碼庫,并解答復(fù)雜的問題,這一點非常引人注目。

例如,three.js是一個包含約10萬行代碼、示例和文檔等的3D Javascript庫。

借助這個代碼庫作為背景,系統(tǒng)能夠幫助用戶深入理解代碼,并能夠根據(jù)人們提出的高層次要求來修改復(fù)雜的示例。

比如:「展示一些代碼,用于添加一個滑塊控制動畫速度。采用和其他演示相同的GUI風(fēng)格。」

或者精確地指出需要修改的代碼部分,以改變另一個示例中生成的地形的高度。

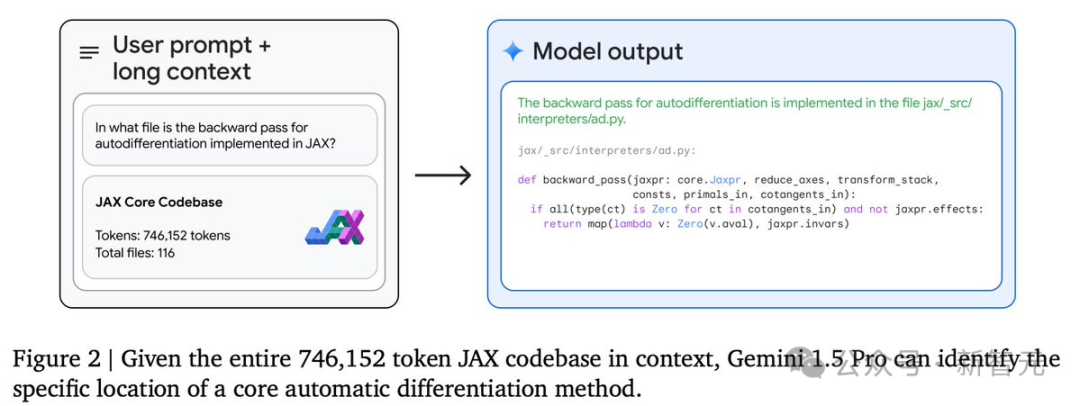

瀏覽龐大而陌生的代碼庫

并且,模型能夠幫我們理解代碼,或定位某個特定功能的實現(xiàn)位置。

在這個例子中,模型能夠處理整個包含116個文件的JAX代碼庫(746k token),并協(xié)助用戶找到實現(xiàn)自動微分反向傳播的確切代碼位置。

顯然,在深入了解一個陌生的代碼庫或日常工作中使用的代碼庫時,長上下文處理能力的價值不言而喻。

許多Gemini團隊成員已經(jīng)發(fā)現(xiàn),Gemini 1.5 Pro的長上下文處理功能,對于Gemini 代碼庫大有裨益。

長篇復(fù)雜文檔的推理

同時,模型在分析長篇、復(fù)雜的文本文檔方面也非常出色,例如雨果的五卷本小說《悲慘世界》(共1382頁,含732,000個token)。

下面這個簡單的實驗,就展示了模型的多模態(tài)能力:粗略地畫出一個場景,并詢問「請看這幅圖畫中的事件發(fā)生在書的哪一頁?」

模型就能給出準(zhǔn)確的答案——1099頁!

Kalamang語翻譯

報告中一個特別引人注目的例子是關(guān)于Kalamang語的翻譯。

卡拉曼語是新幾內(nèi)亞西部、印度尼西亞巴布亞東部不足200人使用的語言,幾乎未在互聯(lián)網(wǎng)上留下足跡。

Gemini Pro 1.5通過上下文學(xué)習(xí)掌握了Kalamang語的知識,其翻譯質(zhì)量可與使用相同材料學(xué)習(xí)的人相媲美。

在英語到卡拉曼語的翻譯中,Gemini Pro 1.5的ChrF達到了58.3,大幅超過了以往最好的模型得分45.8 ChrF,并略高于MTOB論文報告的57.0 ChrF人類基準(zhǔn)。

這一成就無疑帶來了令人激動的可能性,提升稀有語言的翻譯質(zhì)量。

Gemini 1.5的誕生,意味著性能的階段飛躍,標(biāo)志著谷歌在研究和工程創(chuàng)新上,又邁出了登月般的一步。

接下來能跟Gemini 1.5硬剛的,大概就是GPT-5了。

-

谷歌

+關(guān)注

關(guān)注

27文章

6223瀏覽量

107544 -

AI

+關(guān)注

關(guān)注

87文章

34274瀏覽量

275453

發(fā)布評論請先 登錄

谷歌Gemini 1.5深夜爆炸上線,史詩級多模態(tài)硬剛GPT-5!最強MoE首破100萬極限上下文紀錄

谷歌Gemini 1.5深夜爆炸上線,史詩級多模態(tài)硬剛GPT-5!最強MoE首破100萬極限上下文紀錄

評論