同時(shí),書生·浦語面向大模型研發(fā)與應(yīng)用的全鏈條工具鏈全線升級(jí),與InternLM-20B一同繼續(xù)全面開放,向企業(yè)和開發(fā)者提供免費(fèi)商用授權(quán)。

今年6月首次發(fā)布以來,書生·浦語歷多輪升級(jí),在開源社區(qū)和產(chǎn)業(yè)界產(chǎn)生廣泛影響。InternLM-20B模型性能先進(jìn)且應(yīng)用便捷,以不足三分之一的參數(shù)量,達(dá)到當(dāng)前被視為開源模型標(biāo)桿的Llama2-70B的能力水平。

代碼庫

https://github.com/InternLM/InternLM

魔搭社區(qū)

https://modelscope.cn/organization/Shanghai_AI_Laboratory

?

?書生·浦語“增強(qiáng)版”

增的不只是量

相比國(guó)內(nèi)社區(qū)之前陸續(xù)開源的7B和13B規(guī)格模型,20B量級(jí)模型具備更強(qiáng)大的綜合能力,在復(fù)雜推理和反思能力上尤為突出,因此對(duì)于實(shí)際應(yīng)用能夠帶來更有力的性能支持。

另一方面,20B量級(jí)模型可以在單卡上進(jìn)行推理,經(jīng)過低比特量化后,可以運(yùn)行在單塊消費(fèi)級(jí)GPU上,給實(shí)際使用帶來很大的便利。

InternLM-20B是基于2.3T Tokens預(yù)訓(xùn)練語料從頭訓(xùn)練的中量級(jí)語言大模型。相較于InternLM-7B,訓(xùn)練語料經(jīng)過更高水平的多層次清洗,補(bǔ)充了高知識(shí)密度和用于強(qiáng)化理解及推理能力的訓(xùn)練數(shù)據(jù)。

在理解能力、推理能力、數(shù)學(xué)能力、編程能力等考驗(yàn)語言模型技術(shù)水平方面,InternLM-20B與此前已開源模型相比,性能顯著增強(qiáng):優(yōu)異的綜合性能,通過更高水平的數(shù)據(jù)清洗和高知識(shí)密度的數(shù)據(jù)補(bǔ)充,以及更優(yōu)的模型架構(gòu)設(shè)計(jì)和訓(xùn)練,顯著提升了模型的理解、推理、數(shù)學(xué)與編程能力。

InternLM-20B全面領(lǐng)先量級(jí)相近的開源模型,使之以不足三分之一的參數(shù)量,評(píng)測(cè)成績(jī)達(dá)到了被視為開源模型的標(biāo)桿Llama2-70B水平。

-

擁有強(qiáng)大的工具調(diào)用能力,實(shí)現(xiàn)大模型與現(xiàn)實(shí)場(chǎng)景的有效連接,并具備代碼解釋和反思修正能力,為智能體(Agent)的構(gòu)建提供了良好的技術(shù)基礎(chǔ)。

-

支持更長(zhǎng)語境,支持長(zhǎng)度達(dá)16K的語境窗口,更有效地支撐長(zhǎng)文理解、長(zhǎng)文生成和超長(zhǎng)對(duì)話,長(zhǎng)語境同時(shí)成為支撐在InternLM-20B之上打造智能體(Agent)的關(guān)鍵技術(shù)基礎(chǔ)。

-

具備更安全的價(jià)值對(duì)齊,書生·浦語團(tuán)隊(duì)對(duì)InternLM-20B進(jìn)行了基于SFT(監(jiān)督微調(diào))和RLHF(基于人類反饋的強(qiáng)化學(xué)習(xí)方式)兩階段價(jià)值對(duì)齊以及專家紅隊(duì)的對(duì)抗訓(xùn)練,當(dāng)面對(duì)帶有偏見的提問時(shí),它能夠給出正確引導(dǎo)。

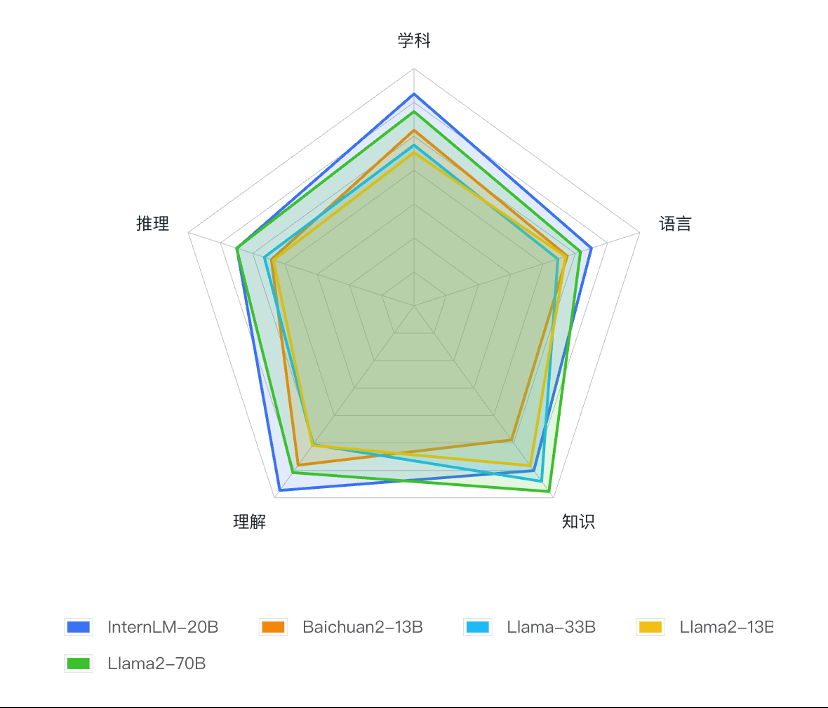

基于OpenCompass的InternLM-20B及相近量級(jí)開源模型測(cè)評(píng)結(jié)果

基于OpenCompass的InternLM-20B及相近量級(jí)開源模型測(cè)評(píng)結(jié)果

全鏈條工具體系再鞏固

各環(huán)節(jié)全面升級(jí)

今年7月,商湯科技與上海AI實(shí)驗(yàn)室聯(lián)合發(fā)布書生·浦語的同時(shí),在業(yè)內(nèi)率先開源了覆蓋數(shù)據(jù)、預(yù)訓(xùn)練、微調(diào)、部署和評(píng)測(cè)的全鏈條工具體系。

歷經(jīng)數(shù)月升級(jí),書生·浦語全鏈條開源工具體系鞏固升級(jí),并向全社會(huì)提供免費(fèi)商用。

全面升級(jí)的全鏈條工具體系

數(shù)據(jù)-OpenDataLab開源“書生·萬卷”預(yù)訓(xùn)練語料

書生·萬卷是開源的多模態(tài)語料庫,包含文本數(shù)據(jù)集、圖文數(shù)據(jù)集、視頻數(shù)據(jù)集三部分,數(shù)據(jù)總量超過2TB。

目前,書生·萬卷1.0已被應(yīng)用于書生·多模態(tài)、書生·浦語的訓(xùn)練,為模型性能提升起到重要作用。

預(yù)訓(xùn)練-InternLM高效預(yù)訓(xùn)練框架

除了大模型外,InternLM倉庫也開源了預(yù)訓(xùn)練框架InternLM-Train。深度整合了Transformer模型算子,使訓(xùn)練效率得到提升,并提出了獨(dú)特的Hybrid Zero技術(shù),使訓(xùn)練過程中的通信效率顯著提升,實(shí)現(xiàn)了高效率千卡并行,訓(xùn)練性能達(dá)行業(yè)領(lǐng)先水平。

微調(diào)-InternLM全參數(shù)微調(diào)、XTuner輕量級(jí)微調(diào)

InternLM支持對(duì)模型進(jìn)行全參數(shù)微調(diào),支持豐富的下游應(yīng)用。同時(shí),低成本大模型微調(diào)工具箱XTuner也在近期開源,支持多種大模型及LoRA、QLoRA等微調(diào)算法。

通過XTuner,最低僅需 8GB 顯存即可對(duì)7B模型進(jìn)行低成本微調(diào),在24G顯存的消費(fèi)級(jí)顯卡上就能完成20B模型的微調(diào)。

部署-LMDeploy支持十億到千億參數(shù)語言模型的高效推理

LMDeploy涵蓋了大模型的全套輕量化、推理部署和服務(wù)解決方案,支持了從十億到千億級(jí)參數(shù)的高效模型推理,在吞吐量等性能上超過FasterTransformer、vLLM和Deepspeed等社區(qū)主流開源項(xiàng)目。

評(píng)測(cè)-OpenCompass一站式、全方位大模型評(píng)測(cè)平臺(tái)

OpenCompass大模型評(píng)測(cè)平臺(tái)構(gòu)建了包含學(xué)科、語言、知識(shí)、理解、推理五大維度的評(píng)測(cè)體系,支持超過50個(gè)評(píng)測(cè)數(shù)據(jù)集和30萬道評(píng)測(cè)題目,支持零樣本、小樣本及思維鏈評(píng)測(cè),是目前最全面的開源評(píng)測(cè)平臺(tái)。

自7月發(fā)布以來,受到學(xué)術(shù)界和產(chǎn)業(yè)界廣泛關(guān)注,目前已為阿里巴巴、騰訊、清華大學(xué)等數(shù)十所企業(yè)及科研機(jī)構(gòu)廣泛應(yīng)用于大模型研發(fā)。

應(yīng)用-Lagent輕量靈活的智能體框架

書生·浦語團(tuán)隊(duì)同時(shí)開源了智能體框架,支持用戶快速將一個(gè)大語言模型轉(zhuǎn)變?yōu)槎喾N類型的智能體,并提供典型工具為大語言模型賦能。

Lagent集合了ReAct、AutoGPT 及ReWoo等多種類型的智能體能力,支持智能體調(diào)用大語言模型進(jìn)行規(guī)劃推理和工具調(diào)用,并可在執(zhí)行中及時(shí)進(jìn)行反思和自我修正。

基于書生·浦語大模型,目前已經(jīng)發(fā)展出更豐富的下游應(yīng)用,將于近期陸續(xù)向?qū)W術(shù)及產(chǎn)業(yè)界分享。

面向大模型掀起的新一輪創(chuàng)新浪潮,商湯科技堅(jiān)持原創(chuàng)技術(shù)研究,通過前瞻性打造新型人工智能基礎(chǔ)設(shè)施,建立大模型及研發(fā)體系,持續(xù)推動(dòng)AI創(chuàng)新和落地,引領(lǐng)人工智能進(jìn)入工業(yè)化發(fā)展階段,同時(shí)賦能整個(gè)AI社區(qū)生態(tài)的繁榮發(fā)展。全鏈條工具體系開源鏈接

“書生·萬卷”預(yù)訓(xùn)練語料

https://github.com/opendatalab/WanJuan1.0

InternLM預(yù)訓(xùn)練框架

https://github.com/InternLM/InternLM

XTuner微調(diào)工具箱

https://github.com/InternLM/xtuner

LMDeploy推理工具鏈

https://github.com/InternLM/lmdeploy

OpenCompas大模型評(píng)測(cè)平臺(tái)

https://github.com/open-compass/opencompass

Lagent智能體框架

https://github.com/InternLM/lagent

相關(guān)閱讀,戳這里

《AI考生今日抵達(dá),商湯與上海AI實(shí)驗(yàn)室等發(fā)布“書生·浦語”大模型》

《大語言模型“書生·浦語”多項(xiàng)專業(yè)評(píng)測(cè)拔頭籌》

原文標(biāo)題:性能超越開源模型標(biāo)桿Llama2-70B,書生·浦語大模型InternLM-20B開源發(fā)布

文章出處:【微信公眾號(hào):商湯科技SenseTime】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

-

商湯科技

+關(guān)注

關(guān)注

8文章

552瀏覽量

36653

原文標(biāo)題:性能超越開源模型標(biāo)桿Llama2-70B,書生·浦語大模型InternLM-20B開源發(fā)布

文章出處:【微信號(hào):SenseTime2017,微信公眾號(hào):商湯科技SenseTime】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

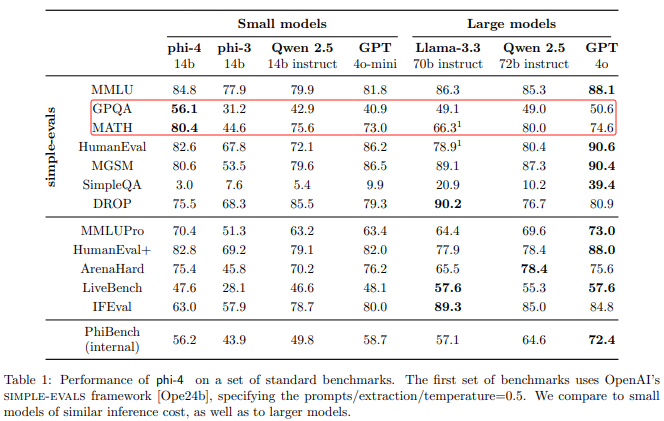

在算力魔方上本地部署Phi-4模型

阿里云發(fā)布開源多模態(tài)推理模型QVQ-72B-Preview

Meta重磅發(fā)布Llama 3.3 70B:開源AI模型的新里程碑

Meta推出Llama 3.3 70B,AI大模型競(jìng)爭(zhēng)白熱化

用Ollama輕松搞定Llama 3.2 Vision模型本地部署

阿里通義千問代碼模型全系列開源

Meta發(fā)布Llama 3.2量化版模型

Llama 3 與開源AI模型的關(guān)系

英偉達(dá)發(fā)布AI模型 Llama-3.1-Nemotron-51B AI模型

源2.0-M32大模型發(fā)布量化版 運(yùn)行顯存僅需23GB 性能可媲美LLaMA3

性能超越開源模型標(biāo)桿Llama2-70B,書生·浦語大模型InternLM-20B開源發(fā)布

性能超越開源模型標(biāo)桿Llama2-70B,書生·浦語大模型InternLM-20B開源發(fā)布

評(píng)論