繼 8 月初阿里云開源通義千問 70 億參數(shù)通用模型 Qwen-7B 和對(duì)話模型 Qwen-7B-Chat 后,又一大模型實(shí)現(xiàn)了開源。 阿里云開源通義千問多模態(tài)大模型 Qwen-VL

InfoQ 獲悉,8 月 25 日,阿里云開源通義千問多模態(tài)大模型 Qwen-VL。這是繼 8 月初阿里云開源通義千問 70 億參數(shù)通用模型 Qwen-7B 和對(duì)話模型 Qwen-7B-Chat 后,又開源的一大模型。

據(jù)介紹,Qwen-VL 是支持中英文等多種語言的視覺語言(Vision Language,VL)模型。相較于此前的 VL 模型,Qwen-VL 除了具備基本的圖文識(shí)別、描述、問答及對(duì)話能力之外,還新增了視覺定位、圖像中文字理解等能力。

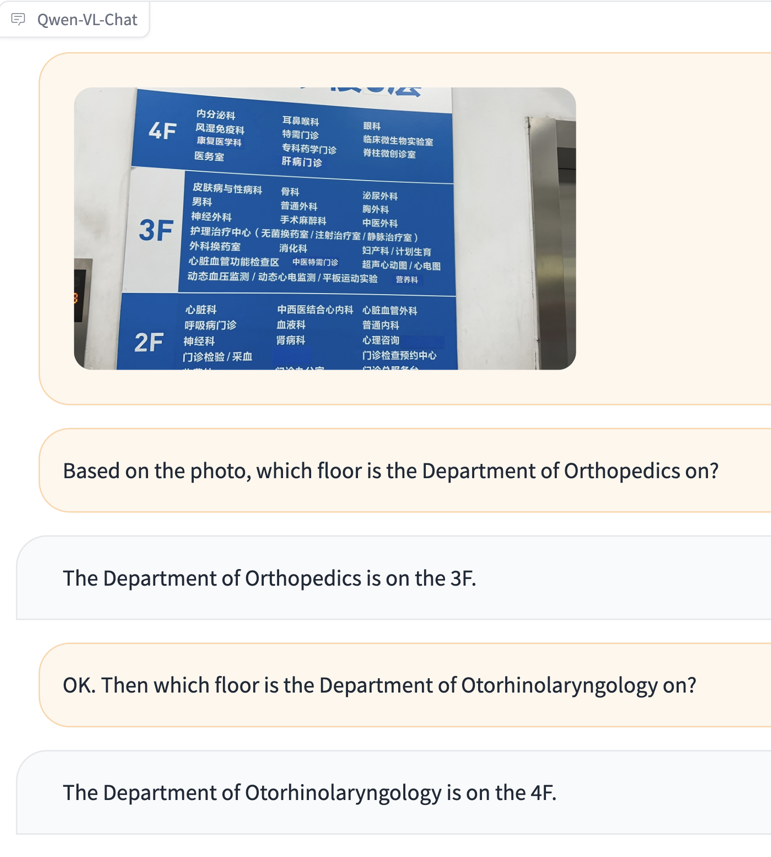

具體來說,Qwen-VL 可以以圖像、文本、檢測框作為輸入,并以文本和檢測框作為輸出,可用于知識(shí)問答、圖像標(biāo)題生成、圖像問答、文檔問答、細(xì)粒度視覺定位等多種場景。比如,一位不懂中文的外國游客到醫(yī)院看病,不知道怎么去往對(duì)應(yīng)科室,他拍下樓層導(dǎo)覽圖問 Qwen-VL“骨科在哪層”“耳鼻喉科去哪層”,Qwen-VL 會(huì)根據(jù)圖片信息給出文字回復(fù)。

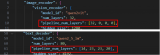

此外,Qwen-VL 還是業(yè)界首個(gè)支持中文開放域定位的通用模型,可以通過中文開放域語言表達(dá)進(jìn)行檢測框標(biāo)注。開放域視覺定位能力決定了大模型“視力”的精準(zhǔn)度,這意味著具備該能力的大模型能在畫面中精準(zhǔn)地找出想找的事物。比如,輸入一張上海外灘的照片,讓 Qwen-VL 找出東方明珠,Qwen-VL 能用檢測框準(zhǔn)確圈出對(duì)應(yīng)建筑。

據(jù)了解,Qwen-VL 以 Qwen-7B 為基座語言模型研發(fā),在模型架構(gòu)上引入視覺編碼器,使得模型支持視覺信號(hào)輸入,并通過設(shè)計(jì)訓(xùn)練過程,讓模型具備對(duì)視覺信號(hào)的細(xì)粒度感知和理解能力。更高分辨率可以提升細(xì)粒度的文字識(shí)別、文檔問答和檢測框標(biāo)注,相比于目前其它開源 LVLM 使用的 224 分辨率,Qwen-VL 是首個(gè)開源的 448 分辨率的 LVLM 模型。

阿里云通義千問團(tuán)隊(duì)算法專家、Qwen-VL 開源模型負(fù)責(zé)人白金澤在接受 InfoQ 采訪時(shí)表示,Qwen-VL 模型的訓(xùn)練分為三個(gè)階段:

在預(yù)訓(xùn)練階段,團(tuán)隊(duì)主要利用大規(guī)模、弱標(biāo)注的圖像 - 文本樣本對(duì)進(jìn)行訓(xùn)練;

在多任務(wù)訓(xùn)練階段,團(tuán)隊(duì)整理了大量高質(zhì)量多任務(wù)的細(xì)粒度圖文標(biāo)注數(shù)據(jù)進(jìn)行混合訓(xùn)練,并升高了圖像的輸入分辨率,降低圖像縮放引起的信息損失,增強(qiáng)模型對(duì)圖像細(xì)節(jié)的感知能力,得到 Qwen-VL 預(yù)訓(xùn)練模型;

在指令微調(diào)階段,團(tuán)隊(duì)使用合成標(biāo)注的對(duì)話數(shù)據(jù)進(jìn)行指令微調(diào),激發(fā)模型的指令跟隨和對(duì)話能力,得到具有交互能力的 Qwen-VL-Chat 對(duì)話模型。

白金澤表示,Qwen-VL 模型的研發(fā)難點(diǎn)主要體現(xiàn)在數(shù)據(jù)、訓(xùn)練、框架三個(gè)層面。“數(shù)據(jù)方面,多模態(tài)的數(shù)據(jù)整理和清洗是個(gè)難點(diǎn),有效的數(shù)據(jù)清洗可以提高訓(xùn)練效率以及提升最終收斂后的效果。訓(xùn)練方面,在多模態(tài)大模型的訓(xùn)練中,一般認(rèn)為大 batch 和較大學(xué)習(xí)率可以提升訓(xùn)練收斂效率和最終結(jié)果,但其訓(xùn)練過程可能更加不穩(wěn)定。我們通過一些訓(xùn)練技巧有效提升了訓(xùn)練穩(wěn)定性,具體細(xì)節(jié)將在相關(guān)論文中公布。框架方面,目前多模態(tài)大模型的并行訓(xùn)練框架支持并不完善,我們對(duì)多模態(tài)大模型的 3D 并行技術(shù)進(jìn)行了優(yōu)化,可穩(wěn)定訓(xùn)練更大規(guī)模的多模態(tài)模型。”

除了 Qwen-VL,本次阿里云還開源了 Qwen-VL-Chat。Qwen-VL-Chat 是在 Qwen-VL 的基礎(chǔ)上,使用對(duì)齊機(jī)制打造的基于大語言模型的視覺 AI 助手,可讓開發(fā)者快速搭建具備多模態(tài)能力的對(duì)話應(yīng)用。

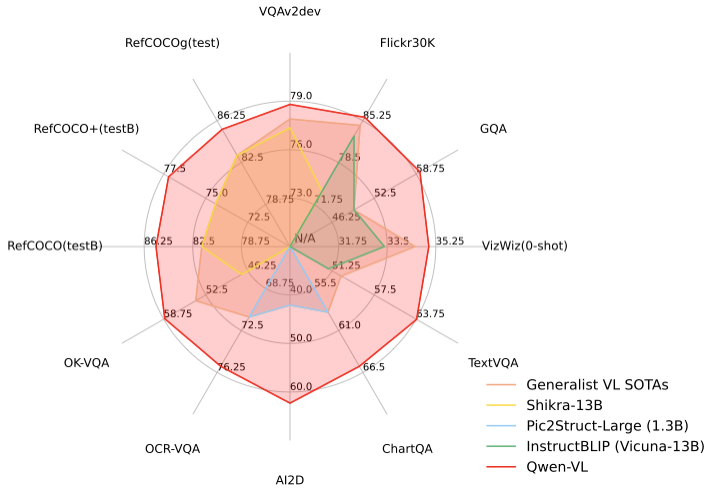

白金澤補(bǔ)充說,團(tuán)隊(duì)主要通過兩類方式評(píng)估了多模態(tài)大模型的效果。其一是使用標(biāo)準(zhǔn)基準(zhǔn)數(shù)據(jù)集來評(píng)測每個(gè)多模態(tài)子任務(wù)的效果。例如評(píng)測圖片描述(Image Captioning)、圖片問答(Visual Question Answering, VQA)、文檔問答(Document VQA)、圖表問答(Chart VQA)、少樣本問答(Few-shot VQA)、參照物標(biāo)注(Referring Expression Comprehension)等。其二是使用人工或借助 GPT-4 打分來評(píng)測多模態(tài)大模型的整體對(duì)話能力和對(duì)齊水平。通義千問團(tuán)隊(duì)構(gòu)建了一套基于 GPT-4 打分機(jī)制的基準(zhǔn)“試金石”( TouchStone),總計(jì)涵蓋 300+ 張圖片、800+ 道題目、27 個(gè)題目類別。

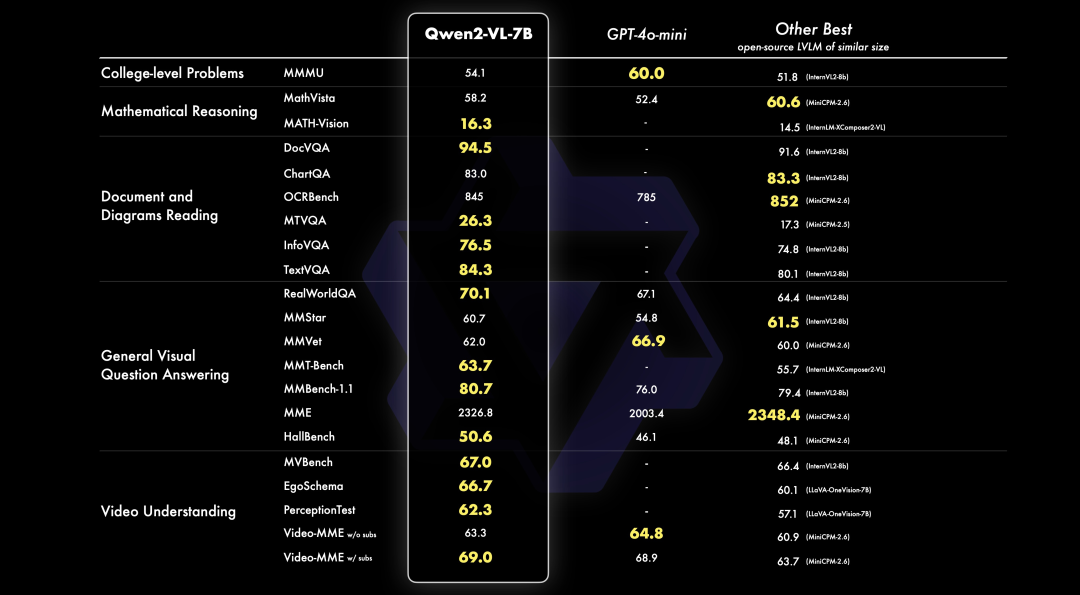

在四大類多模態(tài)任務(wù)(Zero-shot Caption/VQA/DocVQA/Grounding)的標(biāo)準(zhǔn)英文測評(píng)中,Qwen-VL 取得了同等尺寸開源 LVLM 的最好效果。為了測試模型的多模態(tài)對(duì)話能力,通義千問團(tuán)隊(duì)構(gòu)建了一套基于 GPT-4 打分機(jī)制的測試集“試金石”,對(duì) Qwen-VL-Chat 及其他模型進(jìn)行對(duì)比測試,Qwen-VL-Chat 在中英文的對(duì)齊評(píng)測中均取得了開源 LVLM 最好結(jié)果。

目前,Qwen-VL 及其視覺 AI 助手 Qwen-VL-Chat 均已上線 ModelScope 魔搭社區(qū),開源、免費(fèi)、可商用。用戶可從魔搭社區(qū)直接下載模型,也可通過阿里云靈積平臺(tái)訪問調(diào)用 Qwen-VL 和 Qwen-VL-Chat,阿里云為用戶提供包括模型訓(xùn)練、推理、部署、精調(diào)等在內(nèi)的全方位服務(wù)。

大模型發(fā)展的下一站:多模態(tài)大模型

多模態(tài)大模型是指能夠理解文字、圖像、視頻、音頻等多種模態(tài)信息的大模型,與僅能理解單一文本模態(tài)的語言模型相比,多模態(tài)大模型的優(yōu)勢就在于可以充分利用語言模型的指令理解能力,來做圖像、語音、視頻等各種模態(tài)中的開放域任務(wù),從而具備處理不同模態(tài)信息的通用能力。而單一模態(tài)大模型的任務(wù)形式通常都是預(yù)先定義好的,比如圖像 / 視頻 / 語音分類任務(wù),需要提前知道這些類別,然后針對(duì)性的找訓(xùn)練數(shù)據(jù)去訓(xùn)練模型。

有觀點(diǎn)認(rèn)為,多模態(tài)是預(yù)訓(xùn)練大模型最重要的技術(shù)演進(jìn)方向之一。

業(yè)界普遍認(rèn)為,從單一感官的、僅支持文本輸入的語言模型,到“五官全開”的,支持文本、圖像、音頻等多種信息輸入的多模態(tài)模型,蘊(yùn)含著大模型智能躍升的巨大可能。多模態(tài)能夠提升大模型對(duì)世界的理解程度,充分拓展大模型的使用場景。比如,以 GPT-4、PaLM-E 為代表的一批模型,通過賦予大語言模型感知、理解視覺信號(hào)的能力,展現(xiàn)出大規(guī)模視覺語言模型在解決以視覺為中心的實(shí)際問題的前景,并顯示出進(jìn)一步拓展到具身智能、通向通用人工智能的廣闊前景。

其中,視覺作為人類的第一感官能力,也是研究者首先希望賦予大模型的多模態(tài)能力。因此,繼此前推出 M6、OFA 系列多模態(tài)模型之后,阿里云通義千問團(tuán)隊(duì)又開源了基于 Qwen-7B 的大規(guī)模視覺語言模型 Qwen-VL。

不過,多模態(tài)大模型的開發(fā)并非易事,白金澤表示,多模態(tài)大模型的開發(fā)難度包括但不限于以下幾點(diǎn):

模態(tài)間表征差異大:大規(guī)模純語言模型的輸入輸出一般是離散表征,而圖像、語音等內(nèi)容通常是連續(xù)表征,其模態(tài)間的信息密度、表征空間、輸入輸出方式等都存在巨大差異,這導(dǎo)致了設(shè)計(jì)的復(fù)雜性。

多模態(tài)大模型收斂不穩(wěn)定:由于模態(tài)間表征差異大、各模態(tài)網(wǎng)絡(luò)異構(gòu)等因素,相比純文本大模型,多模態(tài)大模型的訓(xùn)練具有更多的挑戰(zhàn),更有可能出現(xiàn)訓(xùn)練不穩(wěn)定的情況。

缺乏穩(wěn)定開源框架支持:目前常見的開源大模型訓(xùn)練框架,都只對(duì)純語言模型的訓(xùn)練效率進(jìn)行了極致的優(yōu)化。為了處理多模態(tài)輸入輸出,多模態(tài)模型通常有非對(duì)稱的網(wǎng)絡(luò)結(jié)構(gòu),導(dǎo)致無法直接用常見開源訓(xùn)練框架擴(kuò)展到超大參數(shù)量。通義千問團(tuán)隊(duì)對(duì)多模態(tài)的并行訓(xùn)練框架進(jìn)行了多重優(yōu)化,可穩(wěn)定訓(xùn)練更大規(guī)模的多模態(tài)模型。

“多模態(tài)是我們很看好的技術(shù)方向,這個(gè)領(lǐng)域還有很多技術(shù)難題有待解決,未來我們也會(huì)持續(xù)研究。就 Qwen-VL 來說,接下來的工作包括支持更高分辨率的圖像輸入,無監(jiān)督地從圖像中學(xué)習(xí)更多的世界知識(shí),擴(kuò)展更多模態(tài),加深對(duì)多模態(tài)數(shù)據(jù)的理解,等等。”白金澤說道。

-

語言模型

+關(guān)注

關(guān)注

0文章

558瀏覽量

10664 -

阿里云

+關(guān)注

關(guān)注

3文章

1002瀏覽量

43858 -

大模型

+關(guān)注

關(guān)注

2文章

3020瀏覽量

3809

原文標(biāo)題:通義千問能看圖了!阿里云開源視覺語言大模型Qwen-VL ,支持圖文雙模態(tài)輸入

文章出處:【微信號(hào):AI前線,微信公眾號(hào):AI前線】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評(píng)論請先 登錄

寒武紀(jì)率先支持Qwen3全系列模型

壁仞科技完成阿里巴巴通義千問Qwen3全系列模型支持

愛芯通元NPU適配Qwen2.5-VL-3B視覺多模態(tài)大模型

基于MindSpeed MM玩轉(zhuǎn)Qwen2.5VL多模態(tài)理解模型

利用英特爾OpenVINO在本地運(yùn)行Qwen2.5-VL系列模型

阿里云通義Qwen2.5-Max模型全新升級(jí)

阿里云通義開源長文本新模型Qwen2.5-1M

阿里云發(fā)布開源多模態(tài)推理模型QVQ-72B-Preview

阿里云開源推理大模型QwQ

阿里云開源Qwen2.5-Coder代碼模型系列

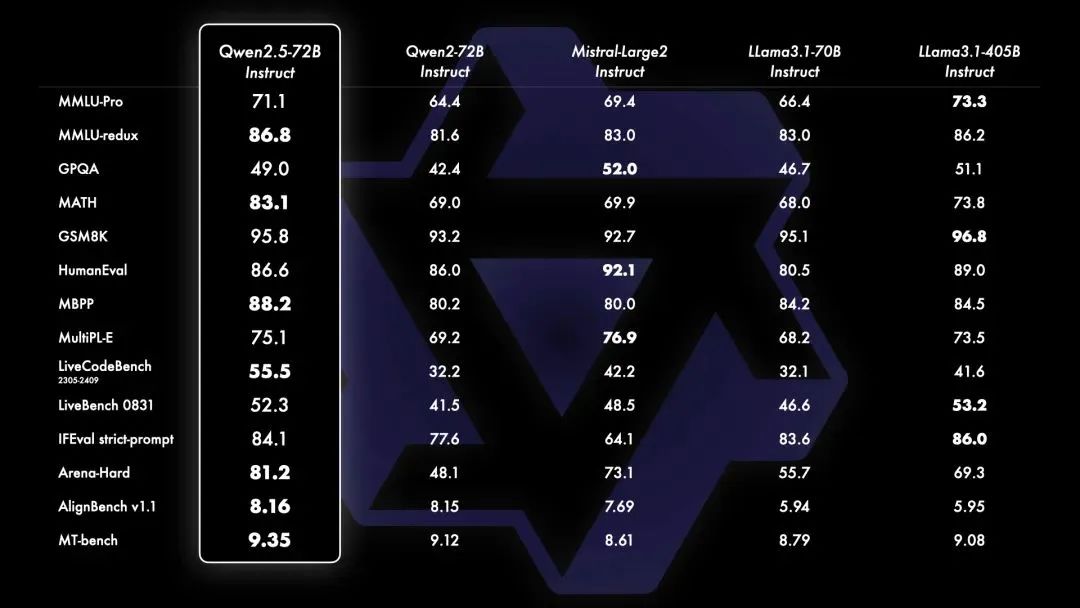

PerfXCloud重磅升級(jí) 阿里開源最強(qiáng)視覺語言模型Qwen2-VL-7B強(qiáng)勢上線!

號(hào)稱全球最強(qiáng)開源模型 ——Qwen2.5 系列震撼來襲!PerfXCloud同步上線,快來體驗(yàn)!

阿里云開源視覺語言大模型Qwen-VL ,支持圖文雙模態(tài)輸入

阿里云開源視覺語言大模型Qwen-VL ,支持圖文雙模態(tài)輸入

評(píng)論