電子發燒友網報道(文/周凱揚)雖說最近靠著GPT大語言模型的熱度,英偉達之類的主流GPU公司賺得盆滿缽滿,但要說仗著GPU的高性能就能高枕無憂的話,也就未免有些癡人說夢了。未來隨著LLM的繼續發展,訓練與推理如果要花費同樣的硬件成本,那么即便是大廠也難以負擔。

所以不少廠商都在追求如何削減TCO(總擁有成本)的辦法,有的從網絡結構出發,有的從自研ASIC出發的,但收效甚微,到最后還是得花大價錢購置更多的GPU。而來自華盛頓大學和悉尼大學的幾位研究人員,在近期鼓搗出的Chiplet Cloud架構,卻有可能顛覆這一現狀。

TCO居高不下的因素

對于大部分廠商來說,純粹的TCO并不是他們考慮的首要因素,他們更關注的是同一性能下如何實現更低的TCO。當下,限制GPU在LLM推理性能上的主要因素之一,不是Tensor核心的利用率,而是內存帶寬。

比如在更小的batch size和普通的推理序列長度下,內存帶寬就會限制對模型參數的讀取,比如把參數從HBM加載到片上寄存器,因為全連接層中的GeMM(通用矩陣乘)計算強度不高,幾乎每次計算都需要加載新的參數。

而Chiplet Cloud為了獲得更好的TCO與性能比,選擇了片上SRAM而不是HBM的外部內存方案,將所有模型參數和中間數據(比如K和V向量等)緩存到片上內存中去,從而實現了比傳統的DDR、HBM2e更好的單Token TCO表現,同時也獲得了更大的內存帶寬。

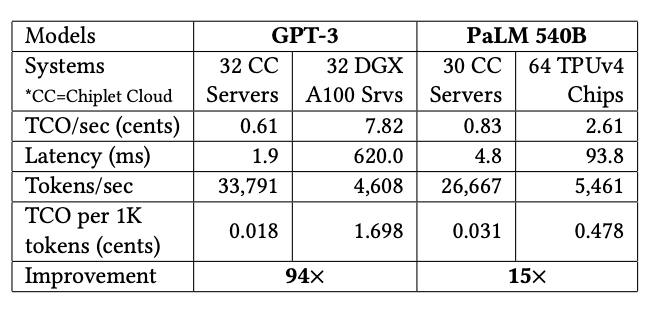

Chiplet Cloud,作為基于chiplet的ASIC AI超算架構,正是專為LLM減少生成單個Token所需的TCO成本設計的。從他們給出的評估數據對比來看,與目前主流的GPU和TPU對比,只有Chiplet Cloud對于TCO/Token做了極致的優化。比如在GPT-3上,32個Chiplet Cloud服務器相較32個DGX A100服務器的TCO成本改善了94倍,在PaLM 540B上,30個Chiplet Cloud服務器相較64個TPUv4芯片將TCO改善了15倍。

更靈活的Chiplet方案

為什么選擇Chiplet呢?我們先來看一個極端的堆片上內存的例子,也就是直接選擇晶圓級的“巨芯”,比如Cerebras Systems打造的WSE-2芯片。該芯片基于7nm工藝下的一整片12英寸晶圓打造,集成了2.6萬億個晶體管,面積達到46255mm2,片上內存更是達到了40GB。

但這樣的巨芯設計意味著高昂的制造成本,所以Chiplet Cloud的研究人員認為更大的SRAM應該與相對較小的芯片對應,這樣才能減少制造成本,所以他們選擇了chiplet的設計方式。近來流行的Chiplet方案提高了制造良率,也減少了制造成本,允許在不同的系統層級上進行設計的重復利用。

以臺積電7nm工藝為例,要想做到0.1/cm2的缺陷密度,一個750mm2芯片的單價是一個150mm2芯片單價的兩倍,所以Chiplet的小芯片設計成本更低。重復利用的設計也可以進一步降低成本,加快設計周期,為ASIC芯片提供更高的靈活性。

Chiplet Cloud更適合哪些廠商

雖然論文中提到了不少Chiplet Cloud的優點,但這依然是一個尚未得到實際產品驗證的架構,擁有驗證實力的公司往往也只有微軟、谷歌、亞馬遜以及阿里巴巴這類具備芯片設計實力的公司。況且ASIC終究是一種特化的方案,最清楚云平臺計算負載需要哪些優化,還得是云服務廠商自己。

-

芯片

+關注

關注

459文章

52201瀏覽量

436410 -

asic

+關注

關注

34文章

1243瀏覽量

122003 -

chiplet

+關注

關注

6文章

453瀏覽量

12872 -

LLM

+關注

關注

1文章

320瀏覽量

686

發布評論請先 登錄

無法在OVMS上運行來自Meta的大型語言模型 (LLM),為什么?

Neuchips展示大模型推理ASIC芯片

NVIDIA TensorRT-LLM Roadmap現已在GitHub上公開發布

Chiplet技術有哪些優勢

什么是LLM?LLM在自然語言處理中的應用

LLM技術對人工智能發展的影響

LLM和傳統機器學習的區別

IMEC組建汽車Chiplet聯盟

創新型Chiplet異構集成模式,為不同場景提供低成本、高靈活解決方案

將ASIC IP核移植到FPGA上——更新概念并推動改變以完成充滿挑戰的任務!

用Chiplet解決ASIC在LLM上的成本問題

用Chiplet解決ASIC在LLM上的成本問題

評論